Heim >Technologie-Peripheriegeräte >KI >Um die Mängel von Stanfords 7-Milliarden-Parameter „Alpaca' auszugleichen, gibt es hier ein großes Modell, das Chinesisch beherrscht und Open Source ist

Um die Mängel von Stanfords 7-Milliarden-Parameter „Alpaca' auszugleichen, gibt es hier ein großes Modell, das Chinesisch beherrscht und Open Source ist

- PHPznach vorne

- 2023-03-31 22:39:141851Durchsuche

BELLE basiert auf Stanford Alpaca und ist für die Modelloptimierung optimiert. Es werden nur von ChatGPT erstellte Daten verwendet (enthält keine anderen Daten).

Seit der ersten Veröffentlichung von ChatGPT sind fast vier Monate vergangen. Als GPT-4 letzte Woche veröffentlicht wurde, veröffentlichte ChatGPT sofort die neue Version. Ein bekanntes Geheimnis ist jedoch, dass weder ChatGPT noch GPT-4 Open Source sein dürften. In Verbindung mit den enormen Investitionen in Rechenleistung und umfangreichen Trainingsdaten gibt es für die Forschungsgemeinschaft viele Hürden, ihren Implementierungsprozess zu reproduzieren.

Angesichts des Ansturms großer Modelle wie ChatGPT ist der Open-Source-Ersatz eine gute Wahl. Anfang dieses Monats hat Meta eine neue große Modellreihe „Open Source“ bereitgestellt – LLaMA (Large Language Model Meta AI) mit Parametern zwischen 7 und 65 Milliarden. Das LLaMA-Modell mit 13 Milliarden Parametern übertrifft das GPT-3 mit 175 Milliarden Parametern „bei den meisten Benchmarks“ und kann auf einer einzelnen V100-GPU ausgeführt werden.

Ein paar Tage später verfeinerte Stanford ein neues Modell Alpaca mit 7 Milliarden Parametern basierend auf LLaMA 7B. Sie nutzten die im Self-Instruct-Papier eingeführte Technologie, um 52K-Anweisungsdaten zu generieren, und nahmen im vorläufigen In einige Änderungen vor Bei der Bewertung durch den Menschen verhält sich das Modell Alpaca 7B bei der Bewertung von Selbstanweisungsanweisungen ähnlich wie das Modell text-davinci-003 (GPT-3.5).

Aber leider sind die Seed-Aufgaben von Alpaca alle auf Englisch und die gesammelten Daten sind auch auf Englisch, sodass das trainierte Modell nicht für Chinesisch optimiert ist. Gibt es einen besseren Weg, um die Wirksamkeit des Dialogmodells auf Chinesisch zu verbessern? Keine Sorge, das als nächstes vorgestellte Projekt kann dieses Problem sehr gut lösen.

Open-Source-Großmodell für chinesischen DialogBELLE (Bloom-Enhanced Large Language Model Engine) mit 7 Milliarden Parametern ist da. Es basiert auf Stanfords Alpaca, jedoch mit „chinesischer Optimierung“ und einigen Änderungen am generierten Code. Darüber hinaus verwendet die Modelloptimierung nur von ChatGPT erzeugte Daten (enthält keine anderen Daten). In Bezug auf die Daten stellte das Projekt den auf Alpaca basierenden Datenerfassungscode zur Verfügung. Basierend auf diesem Code wurden etwa 1 Million chinesische Daten in Kombination mit 50.000 englischen Daten von BLOOMZ generiert. Das 7B-Modelltraining wurde auf Hugging Face hochgeladen.

Hugging Face-Adresse: https://huggingface.co/BelleGroup

Der Projektautor erklärte: Dieses Projekt zielt darauf ab, die Entwicklung der großen Open-Source-Community für den chinesischen Dialog zu fördern.

Projektadresse: https://github.com/LianjiaTech/BELLE

Projektadresse: https://github.com/LianjiaTech/BELLE

Projekteinführung

Das Projekt besteht hauptsächlich aus den folgenden vier Teilen:

175 chinesische Seed-Aufgaben- Code zum Generieren von Daten

- 0,5 M generierte Daten

- Basierend auf dem optimierten BLOOMZ-7B1-mt-Modell

1. zh_seed_tasks.jsonl: Enthält 175 Seed-Aufgaben, das Beispiel lautet wie folgt

{"id": "seed_task_20", „name“: „horror_movie_opening“, „instruction“: „Sie müssen eine kreative Eröffnungsszene für einen Horrorfilm schreiben“, „instances“: [{“input“: „“, „output“: „So. Die Berge haben Der Wind weht durch die leeren Straßen und lässt jeden, der sich nach draußen begibt, erschaudern. Plötzlich ist das einzige Geräusch das leise Rascheln der Blätter, die der Wind weht, und das anschließende Geräusch Das Geräusch von zersplitterndem Glas war zu hören, und als die Gestalt näher kam, sah ich, dass es sich um eine junge Frau mit Blut am ganzen Körper handelte . "}],"is_classification": false}

2. prompt_cn.txt: Eingabeaufforderung zur Generierung

3. 0,5 Mio. generierte Daten

. DatengenerierungFolgen Sie der Methode von Alpaca:

pip install -r Anforderungen.txt

export OPENAI_API_KEY=YOUR_API_KEYpython generic_instruction.py generic_instruction_following_data

Standardmäßig die Completion API verwenden, Modell text-davinci-003. Wenn Sie die Chat-API verwenden und das gpt-3.5-turbo-Modell verwenden möchten, können Sie es über Parameter steuern:

python generic_instruction.py generic_instruction_following_data

--api=chat --model_name=gpt-3.5-turbo

The Die Ausgabedatei befindet sich in Belle.train json und kann vor der Verwendung manuell gefiltert werden.

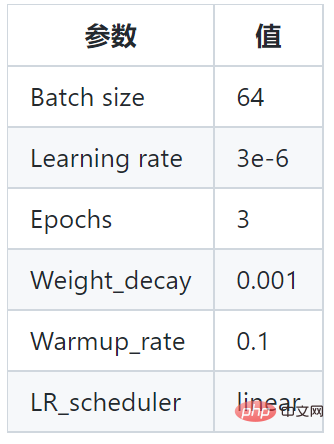

Dieses Projekt basiert auf dem BLOOMZ-7B1-mt-Modell und dem Belle.train.json-Trainingsmodell. Die spezifischen Parameter sind wie folgt:

Darüber hinaus übernimmt das Projekt auch verschiedene Maßstäbe (200.000, 600.000, 1.000.000 und 2.000.000 Proben) und die verschiedenen Modellversionen werden wie folgt erhalten:

Darüber hinaus übernimmt das Projekt auch verschiedene Maßstäbe (200.000, 600.000, 1.000.000 und 2.000.000 Proben) und die verschiedenen Modellversionen werden wie folgt erhalten:

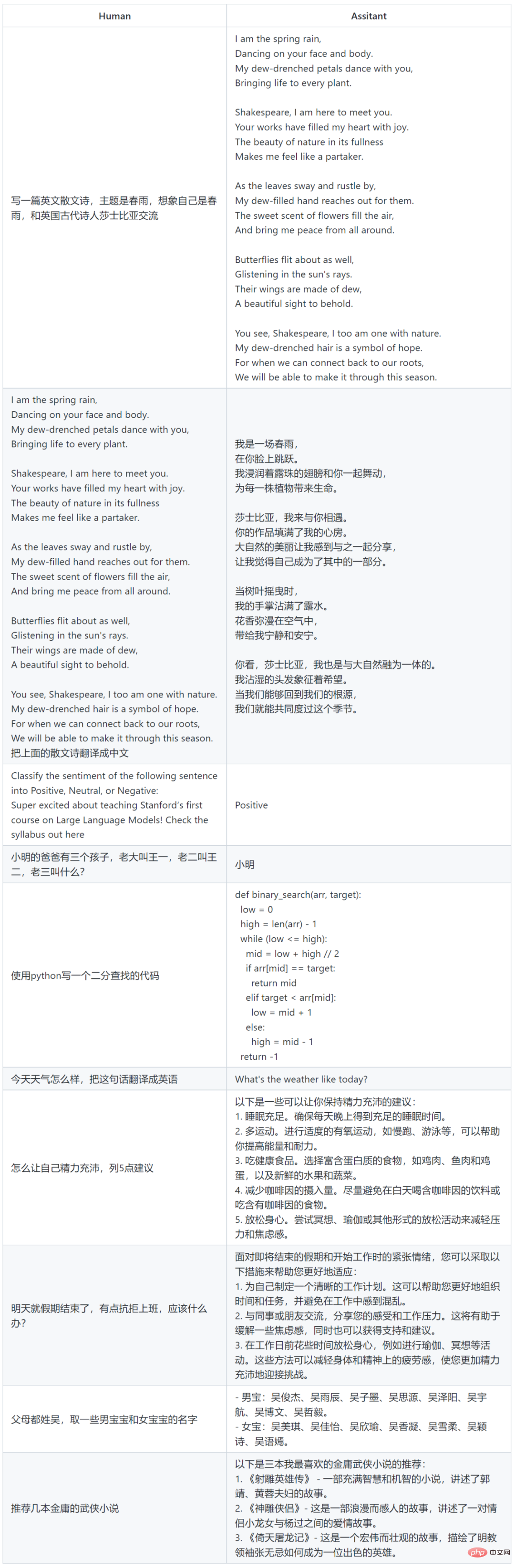

Beispiele für die Modellverwendung

Einschränkungen und Nutzungsbeschränkungen

Das auf den aktuellen Daten und dem Basismodell trainierte SFT-Modell weist hinsichtlich der Wirkung immer noch die folgenden Probleme auf:

- Wenn es Kommt zu den Tatsachen Anweisungen geben möglicherweise falsche Antworten, die den Tatsachen widersprechen.

- Gefährliche Anweisungen können nicht eindeutig identifiziert werden, was zu schädlichen Bemerkungen führt.

- Die Fähigkeiten des Modells müssen in einigen Szenarien, die Argumentation, Codierung usw. betreffen, noch verbessert werden.

- Basierend auf den Einschränkungen des oben genannten Modells verlangt dieses Projekt von Entwicklern, dass sie von diesem Projekt generierte Open-Source-Codes, Daten, Modelle und Folgeableitungen nur für Forschungszwecke verwenden und nicht für kommerzielle Zwecke oder andere Zwecke, die der Gesellschaft Schaden zufügen. verwenden.

Das obige ist der detaillierte Inhalt vonUm die Mängel von Stanfords 7-Milliarden-Parameter „Alpaca' auszugleichen, gibt es hier ein großes Modell, das Chinesisch beherrscht und Open Source ist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr