Heim >Backend-Entwicklung >Python-Tutorial >Wie schreibe ich einen Python-Crawler?

Wie schreibe ich einen Python-Crawler?

- 藏色散人Original

- 2019-06-29 09:13:323373Durchsuche

Heutzutage geben sich viele Freunde mit Programmierkenntnissen nicht mehr mit der manuellen Suche nach Inhalten zufrieden und hoffen, durch das Schreiben einer Crawler-Software schnell an die erforderlichen Inhalte zu gelangen Crawler? Der Redakteur unten erklärt Ihnen die Ideen

Die Methoden/Schritte zum Schreiben eines Python-Crawlers

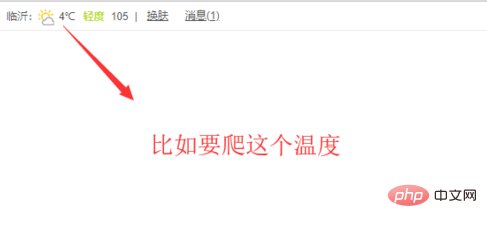

Zuerst müssen wir den Inhalt der Zielseite bestimmen gecrawlt werden, wie in der Abbildung unten gezeigt, zum Beispiel Um den Temperaturwert

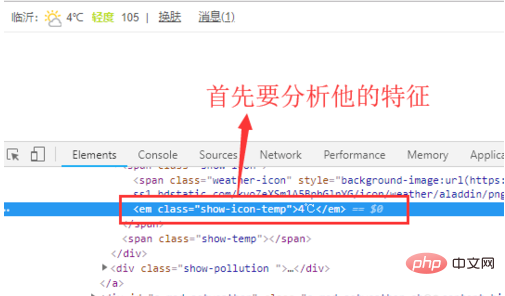

zu erhalten, müssen wir F12 des Browsers öffnen und die Eigenschaften des Inhalts finden, den wir haben B. welche Stil-Tags oder ID-Attribute es hat

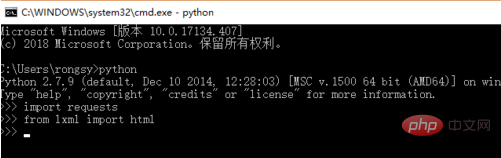

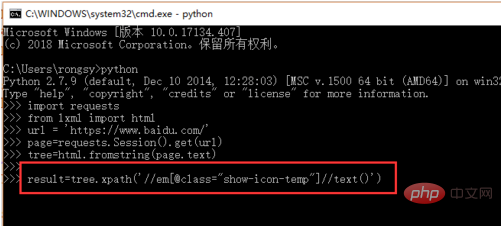

Als nächstes öffnen wir die cmd-Befehlszeilenschnittstelle und importieren die Anforderungsbibliothek und die HTML-Bibliothek, wie im gezeigt Abbildung unten. Diese lxml muss selbst heruntergeladen und installiert werden

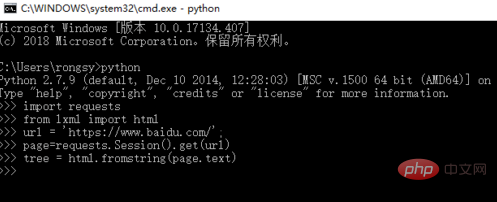

Der nächste Schritt besteht darin, den Seiteninhalt über die Anforderungsbibliothek abzurufen und dann den HTML-Code unter lxml zu verwenden Konvertieren Sie es in Text, wie in der Abbildung unten gezeigt

Der nächste Schritt besteht darin, die xpath-Syntax zu verwenden, um nach dem Inhalt eines bestimmten Elements, dem Namen der Klasse oder der ID zu suchen wird hier im Allgemeinen verwendet, wie in der folgenden Abbildung gezeigt

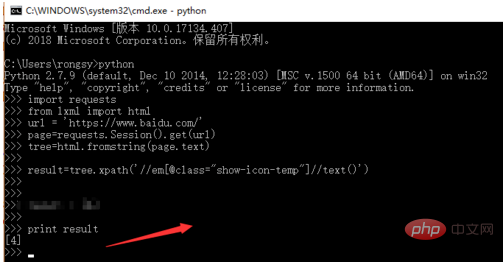

Führen Sie abschließend das Programm aus, um den erforderlichen Inhalt wie folgt abzurufen Wie in der Abbildung gezeigt

Zusammenfassend lässt sich sagen, dass die Verwendung von Python zum Erstellen eines Crawlers hauptsächlich Anforderungen zum Abrufen von Inhalten verwendet und dann basierend auf dem Inhalt nach bestimmten Elementen sucht. Dies ist jedoch nur der einfachste Prozess in komplexen Crawlern.

Verwandte Empfehlungen: „Python-Tutorial“

Das obige ist der detaillierte Inhalt vonWie schreibe ich einen Python-Crawler?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!