Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-Modell

Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-ModellDie Entwicklung von KI -Sprachmodellen hat neue Standards festgelegt, insbesondere in der Codierungs- und Programmierlandschaft. Die Ladung führt zu Deepseek-V3 , GPT-4O und lama 3.3 70b , wobei jeweils einzigartige Vorteile bietet. In diesem Blog werden wir einen KI-Sprachmodellvergleich durchführen und sich auf die Architekturen, Parameter, Codierungsfunktionen und praktische Anwendungsfälle von GPT-4O und seinen beiden Alternativen konzentrieren. Durch eine detaillierte Analyse von Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b werde ich aufdecken, welches Modell für Programmieraufgaben am besten geeignet ist und wie diese Fortschritte die Zukunft von AI im Jahr 2025 prägen.

Inhaltsverzeichnis

- Modellarchitekturen und Design

- Deepseek-V3

- GPT-4O

- llama 3.3 70b

- TEEKSEEK-V3 VSG-4O VSS LLAMA 3 3.3 70B. Bewertung

- 1. Modellübersicht

- 2. Preisvergleich

- 3. Benchmark-Vergleich

- Vergleichserkenntnisse

- Deepseek-V3 gegen GPT-4O gegen LLAMA 3.3 70B: Codierungsfunktionen

- Aufgabe 1: Das Finden der Faktorial einer großen Zahl

- Aufgabe 2: Wenn ein String ein String ist, ist ein String a String a a Palindrome

- Schlussfolgerung

- Häufig gestellte Fragen

Modellarchitekturen und Design

Deepseek-V3 ist ein Open-Source-AI-Modell, das sich in großer Sprachmodellbenchmarks mit seiner effizienten Architektur der Experten (Experten) auszeichnet. Lama 3.3 70b ist mit seiner Skalierbarkeit und Anpassungsfähigkeit beeindruckend und macht es zu einem starken Anwärter auf den Vergleich des AI -Modellparameters. In der Zwischenzeit fällt GPT-4O mit seinen umfangreichen Ressourcen auf und gibt seinen Konkurrenten einen Lauf für ihr Geld.

Beginnen wir unseren Vergleich, indem wir das Design und die Architekturen der drei Modelle verstehen.

Deepseek-V3

Deepseek -v3 ist ein Open-Source-Mischungsmischung (MOE) mit 671 Milliarden Parametern, wodurch 37 Milliarden Parameter pro Token aktiviert werden. Es nutzt modernste Lastausgleich und Multi-Token-Vorhersagemethoden, die auf 14,8 Billionen Token trainiert wurden. Das Modell bei der Erreichung der höchsten Leistung in mehreren Benchmarks hält die Schulungseffizienz mit nur 2,788 Millionen H800-GPU-Stunden.

Deepseek-V3 enthält Argumentationsfähigkeiten aus Deepseek-R1 Lite und bietet ein 128K-Kontextfenster. Darüber hinaus kann es eine Vielzahl von Eingabetypen verarbeiten, einschließlich Text, strukturierten Daten und komplexen multimodalen Eingängen, wodurch es für verschiedene Anwendungsfälle vielseitig ist.

Lesen Sie auch: Erstellen der AI-Anwendung mit Deepseek-V3

gpt-4o

GPT-4O ist ein von OpenAI entwickeltes fortschrittliches Sprachmodell mit hochmodernen Architekturverbesserungen. Es wird über einen riesigen Datensatz von Eingabetechnik geschult, was es bei einer beeindruckenden Genauigkeit bei verschiedenen Aufgaben sehr fähig macht.

Das Modell unterstützt multimodale Eingaben und verfügt über verbesserte Argumentationsfähigkeiten, wodurch zahlreiche Anwendungen vielseitig sind. Mit einem Kontextfenster von 128.000 Token kann es bis zu 16.384 Token pro Anfrage erzeugen und rund 77,4 Token pro Sekunde verarbeitet. Das im August 2024 veröffentlichte Wissen erstreckt sich bis zum Oktober 2023 und macht es zu einem der mächtigsten und anpassungsfähigsten Modelle auf dem Markt.

lama 3.3 70b

Das Meta Lama 3.3 70 B mehrsprachig großes Sprachmodell (LLM) ist ein offenes, vorgebildetes, mit Anweisungen abgestimmter Generativmodell mit 70 Milliarden Parametern. Es ist so konzipiert, dass es für Effizienz und Skalierbarkeit optimiert werden soll. Es verwendet hochmoderne Techniken, um eine breite Palette von Aufgaben zu erledigen, die auf über 15 Billionen Token ausgebildet sind.

llama 3.3 70b ist ein automatisch tergressives Sprachmodell, das eine optimierte Transformatorarchitektur verwendet. Das Modell erzielt eine bemerkenswerte Leistung bei mehreren Benchmarks und hält die Schulungskosten mit optimierter Ressourcenzuweisung minimal.

llama 3.3 70b unterstützt ein breites Kontextfenster und umfasst erweiterte Argumentationsfunktionen für nuancierte und präzise Aufgabenbearbeitung. Es ist so konzipiert, dass es textbasierte Eingaben verarbeitet, aber auch strukturierte Daten verarbeiten kann und Flexibilität in verschiedenen Anwendungen bietet.

Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Modellbewertung

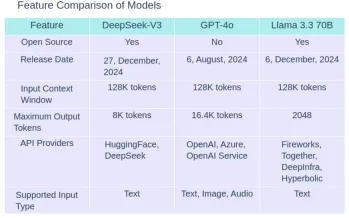

1. Modellübersicht

2. Preisvergleich

3. Benchmark -Vergleich

| Benchmark | Description | DeepSeek-V3 | GPT-4o | Llama 3.3 70B |

| MMLU | Massive Multitask Language Understanding- Test knowledge across 57 subjects including maths, history, law and more | 88.5% | 88.7% | 88.5% |

| MMLU-Pro | A more robust MMLU benchmark with more complex reasoning focused questions and reduced prompt sensitivity | 75.9% | 74.68% | 75.9% |

| MMMU | Massive Multitask Multimodal Understanding: Text understanding across text, audio,images and videos | Not available | 69.1% | Not available |

| HellaSwag | A challenging sentence completion benchmark | 88.9% | Not available | Not available |

| HumanEval | Evaluates code generation and problem solving capabilities | 82.6% | 90.2% | 88.4% |

| MATH | Tests Mathematical problem solving abilities across various difficulty levels | 61.6% | 75.9% | 77% |

| GPQA | Test PhD-level knowledge in physics, chemistry and biology that require domain expertise | 59.1% | 53.6% | 50.5% |

| IFEval | Test model’s ability to accurately follow explicit formatting instructions, generate appropriate outputs and maintain consistent instructions | 86.1% | Not available | 92.1% |

finden Sie hier die Ergebnisse ihrer individuellen Benchmark -Tests:

- gpt-4o: https://github.com/openai/simple-evals?tab=readme-ov-file#benchmark-result

- llama 3.3 70b: https://build.nvidia.com/meta/llama-3_3-70b-instruct/modelcard

- Deepseek-v3: https://github.com/deepseek-ai/deepseek-v3

Vergleichserkenntnisse

Apropos Preise, GPT-4O ist ungefähr 30x teurer als Deepseek-V3 für Eingangs- und Ausgangs-Token. In der Zwischenzeit ist Lama 3.3 70b-Anweisungen ungefähr 1,5x teurer als Deepseek-V3 für Eingangs- und Ausgangs-Token.

Deepseek-V3 zeichnet sich in Benchmarks aus, die eine strukturierte Aufgabenabschlusses erfordern, wie z. Es steht jedoch vor Herausforderungen bei Benchmarks wie Mathematik (mathematische Problemlösung), bei denen seine Leistung nicht so wettbewerbsfähig ist. Es führt auch in GPQA (verallgemeinerte Passage -Beantwortung) und übertrifft die anderen Modelle in dieser Domäne.

GPT-4O funktioniert besonders gut in Humaner- und MMLU, wo es mit seiner Fähigkeit auffällt, qualitativ hochwertige Reaktionen über verschiedene Themen hinweg zu erzeugen. Während es in argumentationsbasierten Aufgaben scheint, kämpft es in spezialisierten Bereichen wie Math und GPQA, in denen andere Modelle besser abschneiden.

lama 3.3 70b zeigt seine Stärken in Benchmarks wie Math und IfeVal (Anweisung nach der Bewertung). Es zeigt überlegene Fähigkeiten zur Problemlösung und folgt komplexer Anweisungen effektiver als die anderen Modelle. Die Leistung in anderen Benchmarks wie Humaneval und GPQA ist weniger beeindruckend als Deepseek-V3 und GPT-4O.

Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Codierungsfunktionen

Jetzt werden wir die Codes-Schreibfunktionen von Deepseek-V3, GPT-4O und Lama 3.3 70b vergleichen. Dafür geben wir allen drei Modellen die gleiche Aufforderung und bewerten ihre Antworten auf die folgenden Metriken:

- Effizienz

- Lesbarkeit

- Kommentar und Dokumentation

- Fehlerbehandlung

Aufgabe 1: Finden Sie die Faktorial für eine große Zahl

Eingabeaufforderung: „Hallo, Sie sind ein ausgezeichneter Code -Lehrer. Helfen Sie mir also bei dieser Frage.

q. Schreiben Sie den Python -Code, um das Faktor für eine große Zahl zu finden. ”

Antwort durch GPT-4O

Um das Faktor für eine große Zahl mit einem Array (um die Multiplikation manuell zu behandeln und Operationen zu tragen), finden Sie hier eine Python -Implementierung:

def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4 id="Ausgabe-des-generierten-Codes"> Ausgabe des generierten Codes </h4>

<p> <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148243588610.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-Modell" > </p>

<h4 id="Antwort-durch-Lama-b"> Antwort durch Lama 3.3 70b </h4>

<p> <em> Hier ist ein Python -Code -Snippet, das das Faktor einer großen Zahl mit einem Array berechnet, um die Ziffern zu speichern. </em> </p><pre class="brush:php;toolbar:false">def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4 id="Ausgabe-des-generierten-Codes"> Ausgabe des generierten Codes </h4>

<p> <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148243891998.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-Modell" > </p>

<h4 id="Antwort-von-Deepseek-V"> Antwort von Deepseek-V3 </h4>

<p> <em> Um das Faktor einer großen Zahl mit einem Array in Python zu berechnen, können wir das Ergebnis in einem Array (oder einer Liste) speichern, um sehr große Zahlen zu verarbeiten, die die Grenze der Standard -Datentypen überschreiten. So können Sie es implementieren: </em> </p>

<pre class="brush:php;toolbar:false">def multiply(x, res, res_size):

"""Multiplies x with the number represented by res[]"""

carry = 0

for i in range(res_size):

prod = res[i] * x + carry

res[i] = prod % 10

carry = prod // 10

while carry:

res.append(carry % 10)

carry = carry // 10

def factorial(n):

""" Calculates the factorial of a number n"""

res = [1]

res_size = 1

for i in range(2, n + 1):

multiply(i, res, res_size)

res_size = len(res)

return res

def print_factorial(n):

""" Prints the factorial of a number n"""

res = factorial(n)

print("Factorial of", n, "is:")

for digit in reversed(res):

print(digit, end="")

# Example usage:

n = 55

print_factorial(n)

Ausgabe des generierten Codes

Vergleichsergebnisse

Die Reaktion vonGPT-4O ist die vollständigste, ausbalancierende Effizienz, Lesbarkeit und robuste Fehlerbehandlung. Es enthält detaillierte Kommentare und klare Variablennamen und behandelt ungültige Eingaben anmutig, wodurch es für die praktische Verwendung oder die kollaborative Entwicklung gut geeignet ist.

Die Reaktion vonLama 3.3 70b ist funktional, es fehlt jedoch die richtige Fehlerbehandlung und eine detaillierte Dokumentation. Seine Struktur ist weniger intuitiv und die Verwendung redundanter Variablen wirkt sich auf die Effizienz aus. Dies macht es zum schwächsten der drei.

Die Reaktion vonDeepseek-V3 ist effizient und sauber strukturiert, fehlt jedoch eine robuste Fehlerbehandlung und eine ausreichende Dokumentation. Es ist ein starker Anwärter, ist jedoch in Klarheit, dass die Menschen leicht folgen oder sich anpassen können.

Empfehlungen:

- Für die praktische Verwendung: GPT-4O ist die beste Wahl aufgrund seiner robusten Fehlerbehandlung, der klaren Dokumentation und der starken Lesbarkeit.

- Für Bildungszwecke: GPT-4O wäre aufgrund der detaillierten Dokstrings und Kommentare in seiner Antwort wieder die bevorzugte Option, die den Lernenden helfen können, die Dinge logisch zu verstehen.

Aufgabe 2: Überprüfen Sie, ob eine Zeichenfolge ein Palindrom ist

Eingabeaufforderung: „Hallo, Sie sind ein ausgezeichneter Code -Lehrer. Helfen Sie mir also bei dieser Frage.

q. Bei einer String S zurückgeben, wenn der s nach dem Löschen von höchstens einem Zeichen von S palindrome sein kann.

Antwort durch GPT-4O

Um dieses Problem zu lösen, können wir einen Zwei-Zeiger-Ansatz verwenden, um zu überprüfen, ob die Zeichenfolge ein Palindrom sein kann, nachdem es höchstens einen Charakter entfernt hat. Hier ist die Python -Implementierung

Ausgabe des generierten Codes

def factorial(n):

# Initialize the result as a list with 1

result = [1]

# Multiply the result list with numbers from 2 to n

for x in range(2, n + 1):

carry = 0

# Multiply each digit in the result list with x

for i in range(len(result)):

product = result[i] * x + carry

result[i] = product % 10 # Store the last digit

carry = product // 10 # Carry over the remaining digits

# Add the remaining carry to the result list

while carry > 0:

result.append(carry % 10)

carry = carry // 10

# Reverse the result list to get the correct order

result.reverse()

return result

# Input: Number to find factorial of

n = int(input("Enter a number: "))

# Compute factorial

factorial_result = factorial(n)

# Convert the list of digits to a string for display

factorial_str = ''.join(map(str, factorial_result))

# Output the result

print(f"Factorial of {n} is: {factorial_str}")

Antwort durch Lama 3.3 70b

Antwort durch Lama 3.3 70b

Hier ist eine Python -Lösung, die überprüft, ob eine Zeichenfolge ein Palindrom sein kann, nachdem es höchstens einen Zeichen gelöscht hat.

Ausgabe des generierten Codes

def valid_palindrome(s):

"""

Check if the string can become a palindrome by removing at most one character.

: param s: The input string.

:return: True if the string can become a palindrome, otherwise False.

"""

def is_palindrome_range(left, right):

# Helper function to check if a substring is a palindrome

while left

<h4> </h4> <p></p><h4 id="Antwort-von-Deepseek-V"> Antwort von Deepseek-V3 </h4>

<p> <em> Um dieses Problem zu lösen, müssen wir überprüfen, ob eine Zeichenfolge ein Palindrom werden kann, indem Sie höchstens einen Charakter löschen. Ein Palindrom liest die gleichen Stürmer und rückwärts. So können wir uns dem angehen: </em> </p>

<pre class="brush:php;toolbar:false">def multiply(arr, x):

"""

Multiplies an array representation of a number with an integer x.

: param arr: List of integers representing the digits of the number.

: param x: Integer to multiply with.

:return: Updated array with the result.

"""

carry = 0 # Initialize carry

for i in range(len(arr)):

prod = arr[i] * x + carry

arr[i] = prod % 10 # Store last digit of the product in the array

carry = prod // 10 # Update the carry

# Process carry, add digits to the array

while carry > 0:

arr.append(carry % 10)

carry //= 10

return arr

def factorial_large_number_array(n):

"""

Calculate the factorial of a large number using array representation.

: param n: Integer for which the factorial is to be computed.

:return: Factorial of n as a string.

"""

if n

<h4 id="Ausgabe-des-generierten-Codes"> Ausgabe des generierten Codes </h4>

<p> <img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174148245021735.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="Deepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-Modell" > </p>

<h4 id="Vergleichserkenntnisse"> Vergleichserkenntnisse </h4>

Die Reaktion von <p> GPT-4O ist die vollständigste und am besten dokumentierte. Es übernimmt die Kernfunktionalität mit Klarheit und erleichtert zukünftigen Entwicklern den Code, den Code zu ändern oder zu erweitern. Die Kombination aus Effizienz und klarer Dokumentation macht es ideal für Produktionsumgebungen. </p>

Die Reaktion von <p> Lama 3.3 70b ist eine funktionale Lösung, aber es fehlt die klare variable Benennung und eingehende Dokumentation in GPT-4O. Das Fehlen von Kommentaren innerhalb der Hauptlogik macht es schwieriger, zu folgen, und es gibt Raum für Verbesserungen in Bezug auf die Lesbarkeit. Es ist jedoch effizient genug für kleine Aufgaben, bei denen eine schnelle Implementierung Priorität ist. </p>

Die Reaktion von <p> Deepseek-V3 ist ein gutes Gleichgewicht zwischen Effizienz und Einfachheit, ist jedoch in der Dokumentation gerecht. Es ist prägnant und schnell, aber es fehlt genügend Details, damit andere den Code problemlos folgen können. Sein Ansatz kann in Szenarien, in denen Zeit und Ressourcen begrenzt sind, von Vorteil sein, aber es müsste eine gründlichere Erklärungen und Fehlerbehandlungen erforderlich sein, um die Codeproduktion zu erledigen. </p>

<h4 id="Empfehlungen"> Empfehlungen: </h4>

- für die praktische Verwendung: GPT-4O-Antwort ist aufgrund seiner gründlichen Dokumentation, der klaren Struktur und der Lesbarkeit die beste.

- für Bildungszwecke: GPT-4O ist am besten geeignet und liefert umfassende Einblicke in jeden Schritt des Prozesses.

Schlussfolgerung

GPT-4O übertrifft sowohl Lama 3.3 70b als auch Deepseek-V3 in Bezug auf Effizienz, Klarheit, Fehlermanagement und umfassende Dokumentation. Dies macht es sowohl für praktische Anwendungen als auch für Bildungszwecke zur Top -Wahl. Während Lama 3.3 70b und Deepseek-V3 funktionsfähig sind, fallen sie aufgrund des Mangels an robuster Fehlerbehebung und einer klaren Dokumentation ab. Das Hinzufügen einer ordnungsgemäßen Fehlermanagement, die Verbesserung der variablen Benennung und die Einbeziehung detaillierter Kommentare würde ihre Benutzerfreundlichkeit erhöhen, um den Standard von GPT-4O zu entsprechen.

Entsperren Sie die Kraft von Deepseek! Melden Sie sich heute für unseren Kurs „Erste Schritte with Deek“ an und erfahren Sie, wie Sie dieses modernste KI-Modell für Ihre Projekte nutzen können. Verpassen Sie es nicht - join jetzt und erhöhen Sie Ihre KI -Fähigkeiten!

Lesen Sie auch:

- Deepseek R1 gegen OpenAI O1: Welches ist besser?

- Deepseek R1 gegen OpenAI O1 gegen Sonnet 3.5

- Chinesische Giganten Faceoff: Deepseek-V3 gegen Qwen2.5

- Deepseek v3 gegen Claude -Sonnet 3.5

- Deepseek v3 gegen gpt-4o

häufig gestellte Fragen

Q1. Welches Modell liefert die höchste Codequalität für reale Anwendungen?a. GPT-4O zeichnet sich aufgrund der effizienten Fehlerbehandlung, der klaren Dokumentation und der gut organisierten Codestruktur in der realen Codierung aus. Damit ist es die beste Wahl für den praktischen Gebrauch.

Q2. Wie vergleichen sich diese Modelle in Bezug auf die Code -Lesbarkeit und das einfache Verständnis?a. GPT-4O zeichnet sich durch seine Lesbarkeit aus und bietet klare Variablennamen und gründliche Kommentare an. Im Vergleich: Welches Modell ist für Bildungszwecke am besten geeignet?

a. GPT-4O ist die ideale Wahl für die Bildung und bietet eingehende Dokumentation und detaillierte Erklärungen, die den Lernenden helfen, die zugrunde liegende Logik des Codes zu erfassen.Q4. Welche Schritte können unternommen werden, um Deepseek-V3 und Lama 3.3 70b zu verbessern, um die Qualität von GPT-4o zu entsprechen?

a. Um ihre Leistung zu erhöhen, sollten sich beide Modelle auf die Implementierung einer robusten Fehlerbehandlung konzentrieren, wobei beschreibendere Variablennamen verwendet werden und detaillierte Kommentare und Dokumentationen hinzugefügt werden, um ihre Lesbarkeit und allgemeine Benutzerfreundlichkeit zu verbessern.Das obige ist der detaillierte Inhalt vonDeepseek-V3 gegen GPT-4O vs Lama 3.3 70b: Finden Sie das beste KI-Modell. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Werkzeuganruf in LLMsApr 14, 2025 am 11:28 AM

Werkzeuganruf in LLMsApr 14, 2025 am 11:28 AMGroße Sprachmodelle (LLMs) sind immer beliebter, wobei die Tool-Calling-Funktion ihre Fähigkeiten über die einfache Textgenerierung hinaus erweitert hat. Jetzt können LLMs komplexe Automatisierungsaufgaben wie dynamische UI -Erstellung und autonomes A erledigen

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändernApr 14, 2025 am 11:27 AM

Wie ADHS -Spiele, Gesundheitstools und KI -Chatbots die globale Gesundheit verändernApr 14, 2025 am 11:27 AMKann ein Videospiel Angst erleichtern, Fokus aufbauen oder ein Kind mit ADHS unterstützen? Da die Herausforderungen im Gesundheitswesen weltweit steigen - insbesondere bei Jugendlichen - wenden sich Innovatoren einem unwahrscheinlichen Tool zu: Videospiele. Jetzt einer der größten Unterhaltungsindus der Welt

UN -Input zu KI: Gewinner, Verlierer und MöglichkeitenApr 14, 2025 am 11:25 AM

UN -Input zu KI: Gewinner, Verlierer und MöglichkeitenApr 14, 2025 am 11:25 AM„Die Geschichte hat gezeigt, dass der technologische Fortschritt das Wirtschaftswachstum zwar nicht selbstverträglich macht, aber nicht eine gerechte Einkommensverteilung sicherstellt oder integrative menschliche Entwicklung fördert“, schreibt Rebeca Grynspan, Generalsekretärin von UNCTAD, in der Präambel.

Lernverhandlungsfähigkeiten über generative KIApr 14, 2025 am 11:23 AM

Lernverhandlungsfähigkeiten über generative KIApr 14, 2025 am 11:23 AMEasy-Peasy, verwenden Sie generative KI als Ihren Verhandlungslehrer und Sparringspartner. Reden wir darüber. Diese Analyse eines innovativen KI -Durchbruch

Ted enthüllt von Openai, Google, Meta geht vor Gericht, Selfie mit mir selbstApr 14, 2025 am 11:22 AM

Ted enthüllt von Openai, Google, Meta geht vor Gericht, Selfie mit mir selbstApr 14, 2025 am 11:22 AMDie TED2025 -Konferenz, die in Vancouver stattfand, beendete gestern, dem 11. April, ihre 36. Ausgabe. Es enthielt 80 Redner aus mehr als 60 Ländern, darunter Sam Altman, Eric Schmidt und Palmer Luckey. Teds Thema "Humanity Ranagined" wurde maßgeschneidert gemacht

Joseph Stiglitz warnt vor der drohenden Ungleichheit inmitten der Monopolmacht der AIApr 14, 2025 am 11:21 AM

Joseph Stiglitz warnt vor der drohenden Ungleichheit inmitten der Monopolmacht der AIApr 14, 2025 am 11:21 AMJoseph Stiglitz ist der renommierte Ökonom und Empfänger des Nobelpreises in Wirtschaftswissenschaften im Jahr 2001. Stiglitz setzt, dass KI bestehende Ungleichheiten und konsolidierte Macht in den Händen einiger dominanter Unternehmen verschlimmern kann, was letztendlich die Wirtschaft untergräbt

Was ist eine Graphendatenbank?Apr 14, 2025 am 11:19 AM

Was ist eine Graphendatenbank?Apr 14, 2025 am 11:19 AMGrafikdatenbanken: Datenmanagement durch Beziehungen revolutionieren Wenn sich die Daten erweitern und sich ihre Eigenschaften über verschiedene Bereiche hinweg entwickeln, entstehen Diagrammdatenbanken als transformative Lösungen für die Verwaltung miteinander verbundener Daten. Im Gegensatz zu traditioneller

LLM Routing: Strategien, Techniken und Python -ImplementierungApr 14, 2025 am 11:14 AM

LLM Routing: Strategien, Techniken und Python -ImplementierungApr 14, 2025 am 11:14 AMLLM -Routing von großer Sprachmodell (LLM): Optimierung der Leistung durch intelligente Aufgabenverteilung Die sich schnell entwickelnde Landschaft von LLMs zeigt eine Vielzahl von Modellen mit jeweils einzigartigen Stärken und Schwächen. Einige zeichnen sich über kreative Inhalte aus

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software