Heim >Technologie-Peripheriegeräte >KI >Kimi K1.5 gegen OpenAI O1: Welches Modell für besseres Argument?

Kimi K1.5 gegen OpenAI O1: Welches Modell für besseres Argument?

- Joseph Gordon-LevittOriginal

- 2025-03-07 09:26:09646Durchsuche

Openai war der erste, der Argumentationsmodelle wie O1 und O1-Mini einführte, aber ist es der einzige Spieler im Spiel? Nicht durch einen langen Schuss! Chinesische LLMs wie Deepseek, Qwen und jetzt treten Kimi auf, um Openai herauszufordern, indem sie ähnliche Fähigkeiten zu viel günstigeren Preisen bieten. Nach Deepseeks beeindruckendes Debüt ist es Kimi Ai an der Reihe, mit seinem neuen Kimi K1.5 -Modell zu glänzen. In diesem Artikel werden wir Kimi K1.5 gegen OpenAI O1 auf die gleichen Aufgaben testen und sehen, welches besser ist!

Inhaltsverzeichnis

- Was ist Kimi K1.5? Websuche

- Aufgabe 5: Bildanalyse

- Endergebnis: Kimi K1.5 gegen OpenAI O1

- Schlussfolgerung

- Bitte beachten Sie: Bitte beachten Sie: Kimi K1.5 ist kostenlos, während er auf ChatGPT plus für O1 und O1-Mini zugreift, kostet 20 US-Dollar. Vergleichen wir vor dem Tauchen in die Aufgaben die beiden Modelle.

- Was ist Kimi K1.5?

- kimi k1.5 ist ein multi-modales LLM von Moonshot AI, das mit Verstärkungslernen (RL) trainiert wird und in verschiedenen Argumentationsaufgaben über Text, Sehvermögen und Codierung ausgestattet ist. Kimi K1.5 wurde kürzlich eingeführt und hat schnell die Aufmerksamkeit für seine beeindruckende Leistung erlangt und die Fähigkeiten des O1 -Modells von OpenAI ohne Vorschau oder Mini -Suffixe entspricht.

- Schlüsselfunktionen

völlig kostenlos mit unbegrenzter Verwendung

Echtzeit-Websuche auf 100 WebsitesAnalysieren Sie bis zu 50 Dateien (PDFs, Dokumente, PPTs, Bilder) mit Leichtigkeit

Advanced COT -Argumentation, kostenlos verfügbar

Verbessertes Bildverständnis, über die grundlegende Textextraktion hinaus

- Lesen Sie auch:

- OpenAI O1: OpenAIS neue Modellreihe

- o1-mini: Ein bahnbrechendes Modell für STEM- und Argumentation

- kimi k1.5 gegen openai o1 und o1-mini

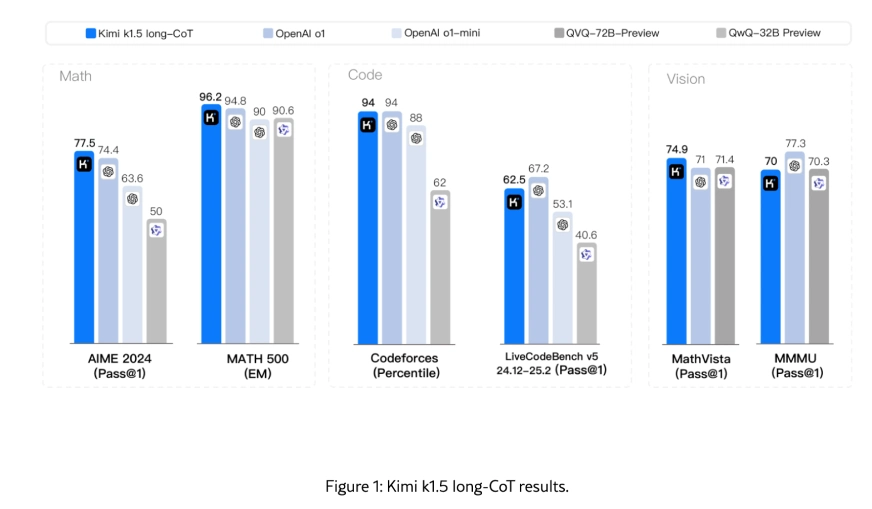

Kimi K1.5 entspricht den O1- und O1-Mini von OpenA und übertrifft Langstrecken-Aufgaben und übertrifft GPT-4O- und Claude-Sonnet 3.5 in Kurzschlüsselaufgaben. Die multimodalen Fähigkeiten, insbesondere im visuellen Denken, positionieren es als starker Konkurrent für OpenAI-Modelle. Die Verwendung von RL-Trainingstechniken, multimodalen Datenrezepten und der Infrastrukturoptimierung war bei der Erreichung dieser Ergebnisse entscheidend.

K1.5 Langzeitmodell: Multi-Modal-Argumentation

vorantreibenDas Kimi K1.5-Langzeitmodell erzielt die Leistung der modernsten (SOTA) durch eine Kombination aus langkontexter Skalierung, verbesserten Methoden zur Politikoptimierung und der Verstärkung des Vision-Textes (RL). Im Gegensatz zu herkömmlichem Sprachmodell-Vorbau, das sich auf die nächsten Vorhersage stützt und durch verfügbare Trainingsdaten begrenzt ist, nutzt Kimi K1.5 RL, um seine Trainingsdaten zu skalieren, indem er lernt, mit Belohnungen zu untersuchen. Dieser Ansatz legt ein simpeles, aber effektives RL -Framework fest, wodurch komplexe Techniken wie Monte -Carlo -Baumsuche oder Wertfunktionen vermieden werden.

Schlüsselbenchmarks unterstreichen die außergewöhnliche Leistung des Modells:

- mathematisches Denken : Punktzahlen von 96,2 auf Math-500 und 77,5 auf Aime 2024, die OpenAs O1- und O1-Mini-Modelle entspricht.

- Programmierung : 94. Perzentil bei Codeforces, hervorragende Leistungen in der Wettbewerbsprogrammierung.

- visuelles Denken : 74.9 auf Mathvista, die eine starke multimodale Integration zeigt.

Die Fähigkeit des Modells, Langkontextaufgaben wie Planung, Reflexion und Korrektur zu erledigen, wird durch teilweise Einführung während des Trainings, die Verbesserung der Effizienz und Leistung verbessert.

K1.5 Kurzschlitzmodell: Effizienz und Leistung

Das Kurzschlüsselmodell baut auf dem Erfolg des Langzeitmodells auf, wobei effektive LONG2Short-Methoden verwendet werden, um langfarbige Techniken in ein effizienteres Framework zu zerstören. Dieser Ansatz kombiniert Feinabstimmungen, Verstärkungslernen und lang zu kurze Destillation und liefert schnelle und genaue Begründung für Kurzkontextaufgaben.

bemerkenswerte Erfolge umfassen:

- mathematisches Denken : Punktzahlen von 94,6 auf Math-500 und 60,8 auf Aime 2024, die vorhandene Kurzschlüsselmodelle wie GPT-4O und Claude Sonnet 3.5 um bis zu 550%übertreffen.

- Programmierung : 47.3 auf LiveCodebench, Excelling in Codegenerierung und Debugging -Aufgaben.

- Verständnis für natürliche Sprache : Effektiv für Echtzeitanwendungen wie Chatbots und virtuelle Assistenten.

Die lang zu kurzen Destillationstechniken, einschließlich Modellverarbeitung und kürzester Abstoßungsabtastung, sorgen Sie für eine hohe Leistung mit reduzierten Rechenkosten, wodurch das Kurzschlussmodell hocheffizient ist.

Um mehr zu erfahren, können Sie hier ihr Forschungsarbeit überprüfen!

Bewerten wir nun Kimi K1.5 und Openai O1 auf denselben Eingabeaufforderungen!

Aufgabe 1: Zebra -Puzzle

Eingabeaufforderung: Lösen Sie dieses Zebra -Puzzle richtig.

OpenAI O1 -Antwort:

| Collector Position | Nationality | Lot | Amount Spent | Shirt Color |

|---|---|---|---|---|

| Collector #1 | Portuguese | Toy | Unknown | Blue |

| Collector #2 | Japanese | Lot 40 | 0,000 | Purple |

| Collector #3 | Italian | Lot 30 | 0,000 | Pink |

| Collector #4 | Canadian | Unknown | 0,000 | Yellow |

| Collector #5 | Unknown | Unknown | 0,000 | Unknown |

Kimi K1.5 Antwort:

| Collector # | Nationality | Lot | Item | Amount | Shirt Color |

|---|---|---|---|---|---|

| 1 | Italian | 30 | Clock | 0,000 | Blue |

| 2 | Japanese | 40 | Painting | 0,000 | Purple |

| 3 | Canadian | 10 | Vase | 0,000 | Pink |

| 4 | Portuguese | 34 | Toy | 0,000 | Yellow |

| 5 | (Unknown) |

Beobachtung:

Die von OpenAI O1 bereitgestellte Antwort ist erheblich ungenau. Die resultierende Tabelle entspricht nicht dem in der Frage angegebenen Format, so dass die Antwort unzuverlässig ist. Auf der anderen Seite lieferte Kimi K1.5 eine Antwort im richtigen Format gemäß der Frage, aber der Inhalt der Antwort selbst ist falsch.

Urteil:

openai o1: ❌ | Kimi K1.5: ❌

Aufgabe 2: Logisches Denken

Eingabeaufforderung: Sie gehen in ein Zimmer und sehen ein Bett. Auf dem Bett befinden sich zwei Hunde, vier Katzen, eine Giraffe, fünf Kühe und eine Ente. Es gibt auch drei Stühle und einen Tisch. Wie viele Beine sind auf dem Boden?

OpenAI O1 -Antwort:

Kimi K1.5 Antwort:

Beobachtung:

richtige Antwort: 22 (2 (menschlich) 4 (Tabelle) 4 (Bett) 12 (3 Stühle))

OpenAI O1 dauerte zu lange, um die Antwort zu generieren. Während die Berechnungen korrekt waren und eine detaillierte Erklärung enthielten, konnte sie die menschlichen Beine auf dem Boden nicht berücksichtigen, was seine Antwort falsch machte. Im Gegensatz dazu hat Kimi K1.5 die richtige Antwort in kürzerer Zeit.

Urteil:

openai o1: ❌ | Kimi K1.5: ✅

Aufgabe 3: Erstellen Sie eine HTML -Site

Eingabeaufforderung: Erstellen Sie eine einfache HTML -Seite mit einer Schaltfläche, die die Hintergrundfarbe auf Pink ändert, wenn Sie mit einigen Konfetti klicken.

OpenAI O1 -Antwort:

Kimi K1.5 Antwort:

Beobachtung:

Beide Modelle hielten an der Eingabeaufforderung fest und lieferten korrekte Antworten. In Bezug auf Aussehen und Funktionalität der Webseite macht Kimi K1.5 einen viel besseren Job!

Urteil:

openai o1: ❌ | Kimi K1.5: ✅

Aufgabe 4: Websuche

Eingabeaufforderung: Lesen Sie den Artikel-https://www.analyticsvidhya.com/blog/2024/07/building-agentic-rag-systems-with-langgraph/, um den Prozess der Erstellung einer Vektordatenbank für Wikipedia-Daten zu verstehen. Fassen Sie die wichtigsten Schritte präzise zusammen.

OpenAI O1 -Antwort:

Schlüsselpunkte, um den Prozess des Erstellens einer Vektordatenbank für Wikipedia -Daten zusammenzufassen:

- Daten sammeln : Wikipedia -Artikel von Dumps oder APIs erhalten.

- Vorverarbeitungstext : Reinigen Sie den Text und teilen Sie ihn in kleinere, kohärente „Stücke“ auf.

- Wählen Sie ein Einbettungsmodell : Verwenden Sie ein Sprachmodell (z. B. OpenAI -Einbettung), um Textbrocken in numerische Vektoren umzuwandeln.

- Erzeugen Sie Einbettung : Erstellen Sie für jeden Stück seine semantische Vektordarstellung.

- Richten Sie eine Vektordatenbank ein : Wählen Sie einen Vektorspeicher (z. B. Pnecone, Weaviate, Faiss, Chroma), um die Einbettungsdings zu speichern und zu indizieren.

- Einfügen von Vektoren : Laden Sie alle Stücke und zugehörigen Metadaten (z. B. Originalartikelreferenzen) in die Datenbank.

- Abruf von Test : Abfragen Sie die Datenbank mit einer vektorisierten Frage ab, um sicherzustellen, dass relevante Wikipedia -Stücke zurückgegeben werden.

- Optimieren und integrieren : Verwenden Sie die Indexierung und Integration mit einer RAB-Pipeline (Abrufen-ausgereihter Generation) für ein effizientes und genaues Abrufen von Informationen.

Kimi K1.5 Antwort:

Der Artikel „Ein umfassender Leitfaden zum Aufbau von Agentenlag -Systemen mit Langgraph“ beschreibt den Prozess der Erstellung einer Vektordatenbank für Wikipedia -Daten als Teil der Erstellung eines Agentenlagersystems. Hier sind die wichtigsten Schritte zusammengefasst:

- Installieren Sie Abhängigkeiten : Installieren Sie die erforderlichen Bibliotheken wie Langchain, Langchain-Openai, Langchain-Community, Langgraph und Langchain-Chroma.

- Geben Sie API -Schlüssel ein : Eingeben Sie API -Schlüssel für OpenAI sicher und suchen

- Umgebungsvariablen : Umgebungsvariablen für die OpenAI- und Tavily -Such -API -Tasten festlegen.

- laden Sie Wikipedia -Daten :

- Wikipedia -Daten von einem bereitgestellten Google Drive -Link herunterladen oder eine lokale Archivdatei verwenden.

- extrahieren und laden Sie die Daten in eine Liste von Dokumenten.

- Chunk -Dokumente :

- Verwenden Sie einen Textsplitter, um die Dokumente in kleinere, überschaubare Stücke zu teilen.

- Der Artikel verwendet recursivecharactertextSplitter, um die Dokumente in Stücke von ungefähr 2000 Zeichen mit einer Überlappung von 300 Zeichen aufzuteilen.

- Erstellen Sie die Vektordatenbank :

- Initialisieren Sie einen Chroma -Vektor -Datenbankclient.

- Verwenden Sie das Einbettungsmodell von OpenAIs (Text-Embedding-3-Small), um Dokumentbrocken in Einbettungsdings umzuwandeln.

- Speichern Sie die Dokumentbrocken und ihre Einbettungen im Vektor -Datenbankindex und geben Sie die Ähnlichkeit der Cosinus als Distanzfunktion an.

- .

- Setup Vector Database Retriever :

- Konfigurieren Sie einen Retriever, um die drei ähnlichen Dokumente basierend auf Cosinus -Ähnlichkeit abzurufen.

- Stellen Sie einen Ähnlichkeitsschwellenwert (z. B. 0,3) fest, um Dokumente herauszufiltern, die der Abfrage nicht ausreichend ähnlich sind.

- Testen Sie den Retriever :

- testen Sie den Retriever mit Beispielabfragen, um sicherzustellen, dass er relevante Dokumente zurückgibt.

- Für Abfragen ohne relevante Dokumente in der Vektor -Datenbank sollte der Retriever eine leere Liste zurückgeben.

Beobachtung:

Kimi K1.5s Ausgabe ist exzentiert, indem detaillierte, umsetzbare Implementierungsschritte mit spezifischen technischen Parametern und Bibliotheksanforderungen bereitgestellt werden. Es gleicht eine umfassende Tiefe mit der klaren Organisation aus, erklärt die Argumentation hinter jedem Schritt und verbindet den technischen Prozess effektiv mit dem breiteren Ziel, ein Agentenlag -System aufzubauen.

Urteil:

openai o1: ❌ | Kimi K1.5: ✅

Aufgabe 5: Bildanalyse

Eingabeaufforderung: Das Bild zeigt ein stark vereinfachtes Schema eines Datencenter im Raum, wobei einige vereinfachte Annahmen, die Rechtfertigung erfordern.

Aufgaben :

Schätzen Sie die untere Grenze der erforderlichen Kühleroberfläche für den Datencenter.

Eingabebild:

OpenAI O1 -Antwort:

unten finden Sie einen Schritt-für-Schritt-Argumentationsprozess mit klar festgelegten Annahmen, Begründungen und der Anwendung des ersten Thermodynamikgesetzes. Das Endergebnis ist eine untere Grenze für den Kühlerbereich, der erforderlich ist, um 1 GW Wärme zu leiten, das von einem raumbasierten Rechenzentrum erzeugt wird.

Schlüsselannahmen und Vereinfachungen

1. Leistungseingang und Wärmeerzeugung:

Angenommen, das Rechenzentrum wird von einer 1 GW Solar -Stromquelle angetrieben. Nahezu der gesamte von GPUs verbrauchte elektrische Strom wird in Wärme umgewandelt (die Umwandlung von elektrischer zu thermischer Energie ist im stationären Zustand im Wesentlichen 100%, da die gesamte nicht gespeicherte elektrische Energie schließlich als Wärme auflösen muss). Somit beträgt die zu entfernende Abwärme ungefähr 1 GW = 1 × 10^9 W.

2. Nur Strahlungswärmeübertragung:

Im Weltraum gibt es keine konvektive oder leitende Kühlung in der Umwelt - nur Strahlungswärmeübertragung. Daher ist die primäre Art der Wärmeabstoßung die thermische Strahlung von einer Kühleroberfläche in den tiefen Raum.

3. Emissionsgröße und Absorptionsvermögen:

Angenommen, der Kühler ist mit einer hohen Emissive-Oberfläche, Sayε = 0,9 ε = 0,9, konstruiert. Dies ist plausibel für Oberflächen, die mit bestimmten hochemissiven Farben oder Materialien beschichtet sind. Für eine untere Grenze für den erforderlichen Bereich nehmen wir ideale Bedingungen an:

- Der Kühler ist hauptsächlich von der Sonne weg, um die Sonnenabsorption zu minimieren.

Kimi K1.5 Antwort:

Um die untere Grenze der erforderlichen Kühleroberfläche für das Rechenzentrum im Weltraum abzuschätzen, beginne ich zunächst das Stefan-Boltzmann-Gesetz, das die durch eine Oberfläche strahlte Leistung beschreibt:

Um mit der Sonne und dem tiefgreifenden Raum im thermischen Management umzugehen, sollte das Rechenzentrum mit einem Sonnenschutz vor direktem Sonnenlicht abgeschirmt werden oder an einem Ort positioniert sein, an dem es nicht der Sonne ausgesetzt ist, wie der dunklen Seite eines Planeten oder des Mondes. Der Kühler muss so ausgelegt sein, dass er die Wärme effizient in das Vakuum des Raums ausstrahlt, was extrem kalt ist.

Das erste Gesetz der Thermodynamik gilt für dieses Szenario, indem sichergestellt wird, dass die vom Rechenzentrum erzeugte Wärme der vom Kühler abgestrahlten Wärme entspricht. Dieses Gesetz garantiert, dass die Gesamtenergie im System konstant bleibt, wobei die Wärme im Design des Kühlers vollständig berücksichtigt wird.

Die untere Grenze der erforderlichen Kühleroberfläche beträgt ungefähr 766 Quadratmeter . Das Rechenzentrum sollte vor direktem Sonnenlicht abgeschirmt sein und der Kühler sollte für die Wärmeabteilung im Vakuum des Raums optimiert werden, um das thermische Gleichgewicht aufrechtzuerhalten.

Beobachtung:

Die Reaktion vonKimi K1.5 ist aus mehreren Gründen überlegen. Es zeigt ein klares mathematisches Denken durch einen Schritt-für-Schritt-Ansatz, beginnend mit der grundlegenden Stefan-Boltzmann-Rechtsgleichung. Kimi definiert deutlich alle Variablen und ihre Werte, zeigt den mathematischen Prozess der Lösung des Kühlerbereichs und liefert ein konkretes numerisches Ergebnis von 766 Quadratmetern. Die Erklärung enthält klare Rechtfertigungen für thermische Managementstrategien, praktische Überlegungen wie die Positionierung des Kühlers auf der dunklen Seite eines Planeten und eine direkte Verbindung zum ersten Gesetz der Thermodynamik mit realer Anwendung. Die Antwort schließt mit bestimmten Zahlen und umsetzbaren Empfehlungen.

Im Gegensatz dazu bleibt die Reaktion von OpenAI O1 theoretischer und konzentriert sich auf allgemeine Annahmen und die Einrichtung, anstatt die tatsächliche Berechnung zu vervollständigen. Es fehlt eine konkrete numerische Lösung und es geht nicht um den Aspekt des thermischen Managements vollständig an, was ihn im Vergleich zu den detaillierten und lösungsorientierten Ansatz von Kimi K1.5 weniger praktisch und umsetzbar macht.Urteil:

openai o1: ❌ | Kimi K1.5: ✅

Endergebnis: Kimi K1.5 gegen OpenAI O1

Aufgabenergebnisse

| Task | Winner |

|---|---|

| Zebra Puzzle | Neither |

| Logical Reasoning | Kimi k1.5 |

| Create an HTML Site | Kimi k1.5 |

| Web Search | Kimi k1.5 |

| Image Analysis | Kimi k1.5 |

Schlussfolgerung

Freie Modelle wie Kimi K1.5 und Deepseek R1 fordern die Dominanz von OpenAI O1 in Frage und bieten die überlegene Leistung in Bezug auf Argumentation, Codierung und multimodale Aufgaben kostenlos. Wenn Kimi K1.5 OpenAI in wichtigen Benchmarks und Deepseek R1 übertroffen wird, zahlt er für OpenAI O1 noch 20 US -Dollar pro Monat, immer noch gerechtfertigt? Lassen Sie uns im Kommentarbereich unten wissen!

Bleiben Sie auf dem Analytics Vidhya -Blog für weitere großartige Inhalte!

Das obige ist der detaillierte Inhalt vonKimi K1.5 gegen OpenAI O1: Welches Modell für besseres Argument?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr