Heim >Technologie-Peripheriegeräte >KI >6 Common LLM -Anpassungsstrategien erklärt kurz kurz

6 Common LLM -Anpassungsstrategien erklärt kurz kurz

- 王林Original

- 2025-02-25 16:01:08619Durchsuche

In diesem Artikel werden sechs Schlüsselstrategien zum Anpassen von Großsprachenmodellen (LLMs) untersucht, die von einfachen Techniken bis hin zu ressourcenintersiveren Methoden reichen. Die Auswahl des richtigen Ansatzes hängt von Ihren spezifischen Bedürfnissen, Ressourcen und Ihrem technischen Know -how ab.

Warum LLMs anpassen?

Vorgeborene LLMs, während sie leistungsstark sind, sind jedoch häufig auf bestimmte Geschäfts- oder Domänenanforderungen hinaus. Durch das Anpassen eines LLM können Sie seine Funktionen auf Ihre genauen Bedürfnisse anpassen, ohne die unerschwinglichen Kosten für das Training eines Modells von Grund auf neu. Dies ist besonders wichtig für kleinere Teams, denen umfangreiche Ressourcen fehlen.

Auswählen des richtigen LLM:

Vor der Anpassung ist die Auswahl des entsprechenden Basismodells kritisch. Zu den zu berücksichtigenden Faktoren gehören:

- Open-Source vs. Proprietary: Open-Source-Modelle bieten Flexibilität und Kontrolle, erfordern jedoch technische Fähigkeiten, während proprietäre Modelle einen einfachen Zugang und häufig überlegene Leistung zu einem Preis bieten.

- Aufgabe und Metriken: Verschiedene Modelle exzellieren bei verschiedenen Aufgaben (Fragenbeantwortung, Zusammenfassung, Codegenerierung). Benchmark-Metriken und domänenspezifische Tests sind unerlässlich.

- Architektur: -Decoder-Modelle (wie GPT) sind bei der Textgenerierung stark, während Encoder-Decoder-Modelle (wie T5) besser für die Übersetzung geeignet sind. Aufstrebende Architekturen wie Mischung aus Experten (MOE) sind vielversprechend.

- Modellgröße: Größere Modelle erfordern im Allgemeinen besser, erfordern jedoch mehr Rechenressourcen.

Sechs LLM -Anpassungsstrategien (nach Ressourcenintensität eingestuft):

Die folgenden Strategien werden in aufsteigender Reihenfolge des Ressourcenverbrauchs dargestellt:

1. Eingabeaufforderung in Engineering

Umkämpfungstechnik beinhaltet sorgfältig das Erstellen des Eingabentextes (Eingabeaufforderung), um die Antwort des LLM zu leiten. Dies umfasst Anweisungen, Kontext, Eingabedaten und Ausgabeindikatoren. Techniken wie Zero-Shot, One-Shot und Few-Shot-Aufforderung sowie fortschrittlichere Methoden wie Denkenkette (COT), Baumbaum, automatisches Denken und Werkzeuggebrauch (ART) und React können die Leistung erheblich verbessern . Schnelltechnik ist effizient und leicht implementiert.

2. Decodierungs- und Stichprobenstrategien

Steuerungsstrategien (gierige Suche, Strahlsuche, Abtastung) und Abtastparameter (Temperatur, Top-K, Top-P) zur Inferenzzeit kontrollieren Sie die Zufälligkeit und Vielfalt der Ausgabe des LLM. Dies ist eine kostengünstige Methode zur Beeinflussung des Modellverhaltens.

3. Abrufener Augmented Generation (RAG)

RAG verbessert die LLM -Reaktionen, indem es externes Wissen einbezieht. Dazu gehört es, relevante Informationen von einer Wissensbasis abzurufen und sie zusammen mit der Abfrage des Benutzers an die LLM zu füttern. Dies reduziert Halluzinationen und verbessert die Genauigkeit, insbesondere für domänenspezifische Aufgaben. RAG ist relativ ressourceneffizient, da das LLM nicht umhergestellt werden muss.

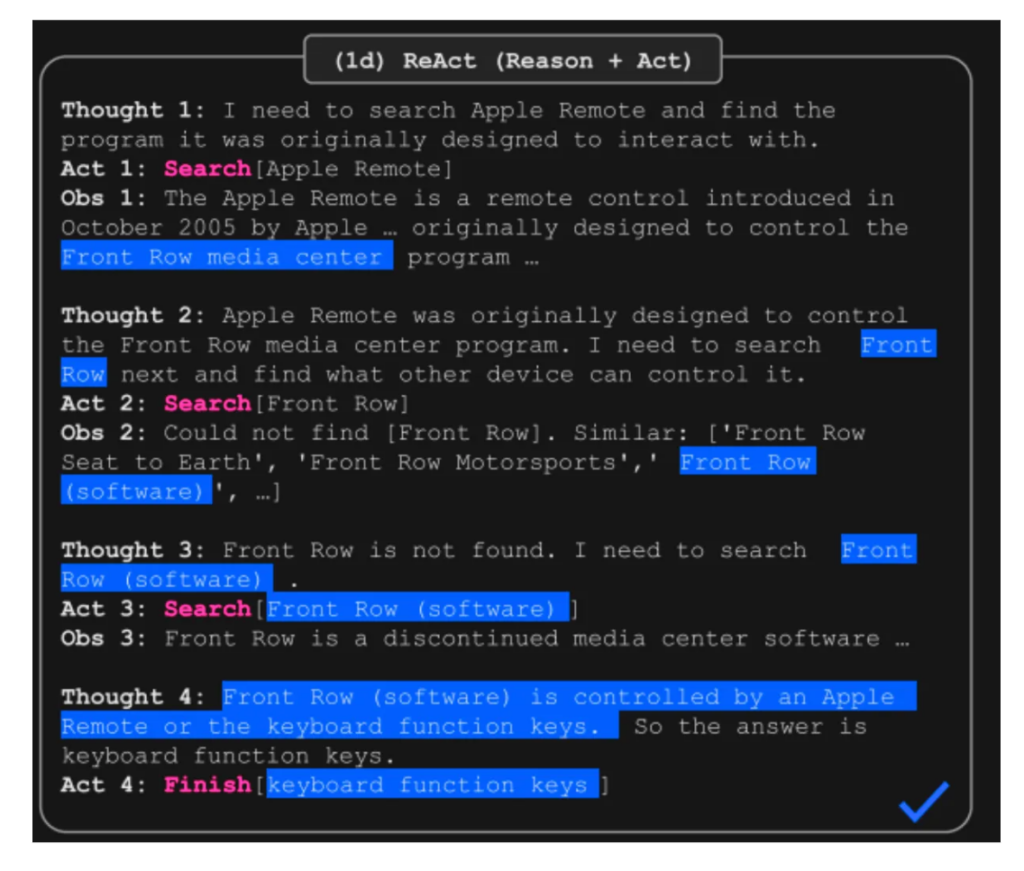

4. Agentenbasierte Systeme

Agentenbasierte Systeme ermöglichen es LLMs, mit der Umgebung zu interagieren, Tools zu verwenden und den Speicher zu erhalten. Frameworks wie React (Synergisierung von Denken und Handeln) kombinieren das Denken mit Aktionen und Beobachtungen und verbessern die Leistung bei komplexen Aufgaben. Agenten bieten erhebliche Vorteile bei der Verwaltung komplexer Workflows und Tool -Nutzung.

5. Feinabstimmung

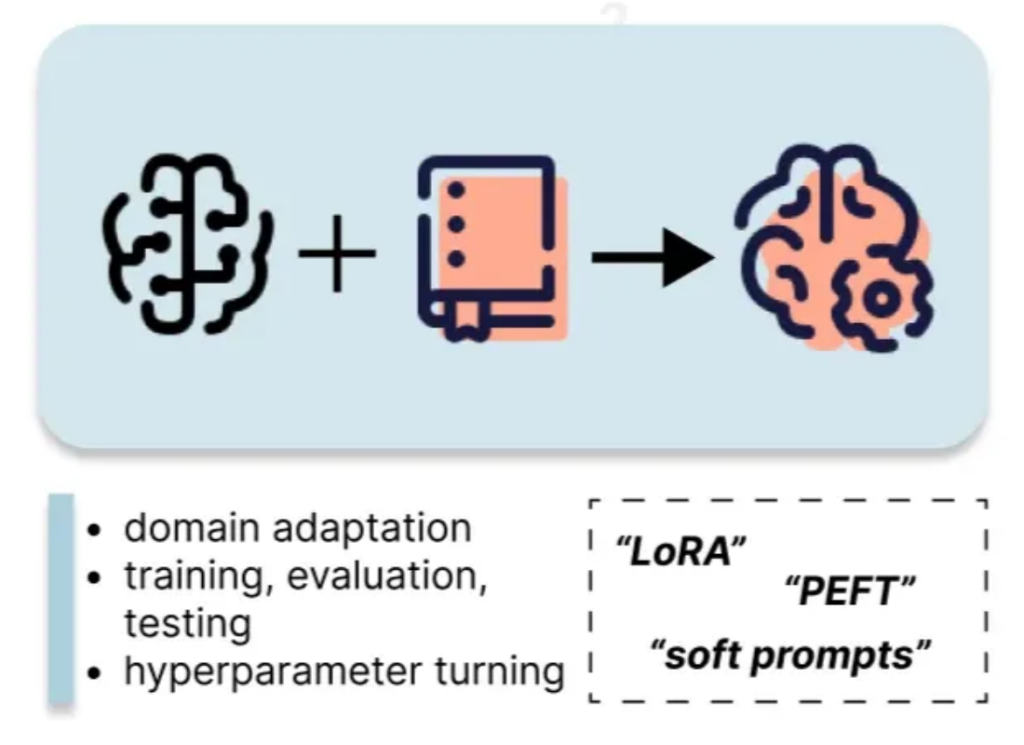

Feinabstimmung beinhaltet die Aktualisierung der Parameter des LLM mithilfe eines benutzerdefinierten Datensatzes. PEFT-Methoden (parametereffiziente Feinabstimmungen) wie LORA reduzieren die Rechenkosten im Vergleich zur vollständigen Feinabstimmung signifikant. Dieser Ansatz erfordert mehr Ressourcen als die vorherigen Methoden, bietet jedoch bessere Leistungssteigerungen.

6. Verstärkungslernen aus menschlichem Feedback (RLHF)

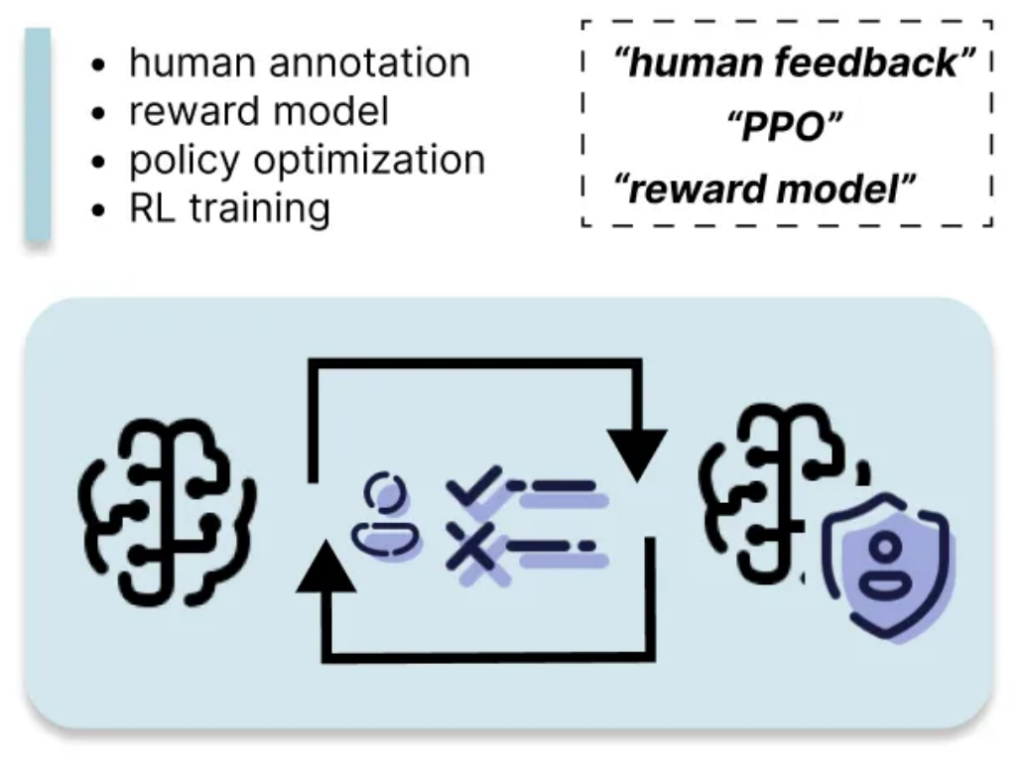

RLHF richtet die Ausgabe des LLM mit menschlichen Vorlieben durch, indem ein Belohnungsmodell basierend auf menschlichem Feedback basiert. Dies ist die ressourcenintensivste Methode, die eine signifikante menschliche Annotation und Rechenleistung erfordert, kann jedoch zu erheblichen Verbesserungen bei der Reaktionsqualität und der Ausrichtung mit dem gewünschten Verhalten führen.

Diese Übersicht bietet ein umfassendes Verständnis der verschiedenen LLM -Anpassungstechniken, mit der Sie die am besten geeignete Strategie basierend auf Ihren spezifischen Anforderungen und Ressourcen auswählen können. Denken Sie daran, die Kompromisse zwischen Ressourcenverbrauch und Leistungsgewinnen bei Ihrer Auswahl zu berücksichtigen.

Das obige ist der detaillierte Inhalt von6 Common LLM -Anpassungsstrategien erklärt kurz kurz. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr