Heim >Technologie-Peripheriegeräte >KI >Llama 3 vs. GPT-4: Was ist besser?

Llama 3 vs. GPT-4: Was ist besser?

- William ShakespeareOriginal

- 2024-12-13 16:24:00847Durchsuche

Quick Links

Llama 3 und GPT-4 sind zwei der fortschrittlichsten großen Sprachmodelle (LLMs), die der Öffentlichkeit zugänglich sind. Schauen wir uns an, welches LLM besser ist, indem wir beide Modelle im Hinblick auf Multimodalität, Kontextlänge, Leistung und Kosten vergleichen.

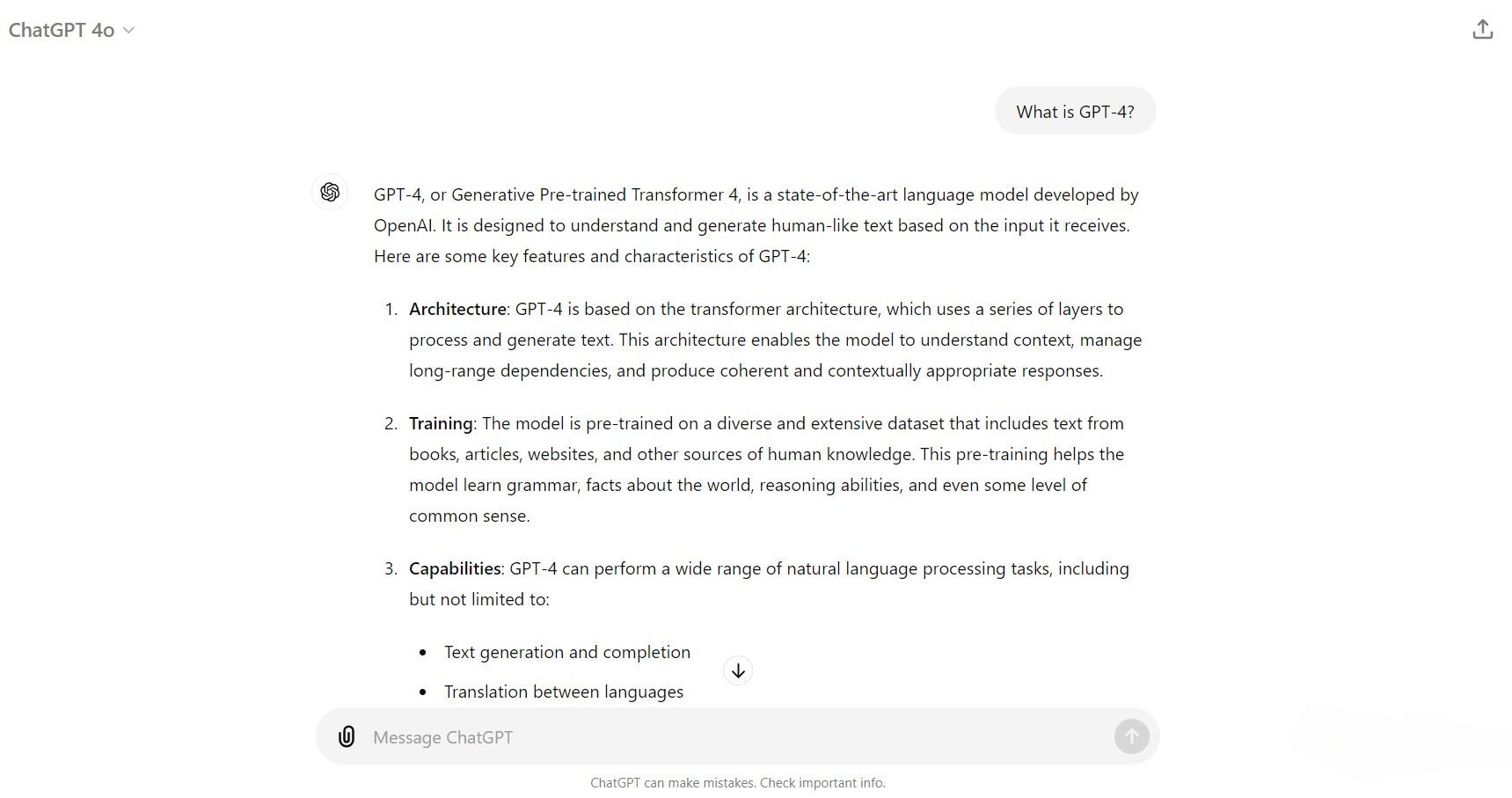

Was ist GPT-4?

GPT-4 ist das neueste von OpenAI entwickelte Large Language Model (LLM). Es baut auf den Grundlagen der älteren GPT-3-Modelle auf und verwendet gleichzeitig verschiedene Trainingstechniken und Optimierungen unter Verwendung eines viel größeren Datensatzes. Dadurch erhöhte sich die Parametergröße von GPT-4 erheblich, das Gerüchten zufolge insgesamt über 1,7 Billionen Parameter aus seinen kleineren Expertenmodellen verfügt. Mit dem neuen Training, Optimierungen und einer größeren Anzahl von Parametern bietet GPT-4 Verbesserungen beim Denken, bei der Problemlösung, beim Kontextverständnis und bei der besseren Handhabung nuancierter Anweisungen.

Derzeit gibt es drei Varianten des Modells:

- GPT-4: Eine Weiterentwicklung von GPT-3 mit erheblichen Verbesserungen in Geschwindigkeit, Genauigkeit und Wissen Basis.

- GPT-4 Turbo: Eine optimierte Version von GPT-4, die für eine schnellere Leistung bei gleichzeitig geringeren Betriebskosten entwickelt wurde.

- GPT-4o (Omni): Erweitert die Fähigkeiten von GPT-4 durch die Integration multimodaler Ein- und Ausgänge, einschließlich Text, Bild und Audio.

Sie können jetzt auf alle drei GPT-4-Modelle zugreifen, indem Sie die API-Dienste von OpenAI abonnieren, mit ChatGPT interagieren oder über Dienste wie Descript, Perplexity AI und die verschiedenen Copiloten von Microsoft.

Was ist Lama 3?

Llama 3 ist ein Open-Source-LLM, das von Meta AI (Muttergesellschaft von Facebook, Instagram und WhatsApp) entwickelt und mithilfe einer Kombination aus überwachter Feinabstimmung, Ablehnungsstichprobe und Richtlinienoptimierung mit einem vielfältigen Datensatz, der Millionen umfasst, trainiert wird Von Menschen kommentierte Beispiele. Das Training konzentrierte sich auf hochwertige Eingabeaufforderungen und Präferenzrankings mit dem Ziel, ein vielseitiges und leistungsfähiges KI-Modell zu schaffen.

Derzeit sind zwei Llama 3-Modelle für die Öffentlichkeit verfügbar: Llama 3 8B und Llama 3 70B. Das „B“ steht für Milliarde und weist auf die Parametergröße des Modells hin. Meta trainiert außerdem ein Llama 3 400B-Modell, das voraussichtlich Ende 2024 auf den Markt kommen wird.

Sie können über Meta AI, seinen generativen KI-Chatbot, auf Llama 3 zugreifen. Alternativ können Sie die LLMs lokal auf Ihrem Computer ausführen, indem Sie Llama 3-Modelle herunterladen und über Ollama, Open WebUI oder LM Studio laden.

Multimodalität

Die Veröffentlichung von GPT-4o hat endlich zur ersten Vermarktung von GPT-4 mit multimodalen Funktionen geführt. Auf diese multimodalen Funktionen kann jetzt durch Interaktion mit ChatGPT mithilfe des GPT-4o-Modells zugegriffen werden. Seit Juni 2024 verfügt GPT-4o über keine integrierte Möglichkeit, Video und Audio zu generieren. Es verfügt jedoch über die Möglichkeit, Text und Bilder auf der Grundlage von Video- und Audioeingaben zu generieren.

Llama 3 plant außerdem die Bereitstellung eines multimodalen Modells für das kommende Llama 3 400B. Es wird höchstwahrscheinlich ähnliche Technologien wie CLIP (Contrast Language-Imager Pre-Training) integrieren, um Bilder mithilfe von Zero-Shot-Learning-Techniken zu erzeugen. Da sich Llama 400B jedoch noch im Training befindet, besteht die einzige Möglichkeit für die Modelle 8B und 70B zum Generieren von Bildern darin, Erweiterungen wie LLaVa, Visual-LLaMA und LLaMA-VID zu verwenden. Ab sofort ist Llama 3 ein rein sprachbasiertes Modell, das Text, Bilder und Audio als Eingaben für die Textgenerierung verwenden kann.

Kontextlänge

Kontextlänge bezieht sich auf die Textmenge, die ein Modell gleichzeitig verarbeiten kann. Dies ist ein wichtiger Faktor bei der Betrachtung der Leistungsfähigkeit eines LLM, da er die Menge an Kontext bestimmt, mit der das Modell bei der Interaktion mit Benutzern arbeiten kann. Im Allgemeinen macht eine höhere Kontextlänge ein LLM besser, da es ein höheres Maß an Kohärenz und Kontinuität bietet und Wiederholungen von Fehlern während Interaktionen reduzieren kann.

| Trainingsdatenbeschreibung | Parameter | Kontextlänge | GQA | Token-Anzahl | Wissensgrenze | |||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Llama 3 | Mischung aus öffentlich verfügbaren Online-Daten | 8B | 8k | Ja | 15T | März 2023 | |||||||||||||||||||||

| Lama 3 | Mischung aus öffentlich verfügbaren Online-Daten | 70B | 8k | Ja | 15T | Dezember 2023 |

Llama 3-Modelle verfügen über eine Kontextlänge von effektiv 8.000 Token (ca. 6.400 Wörter). Das bedeutet, dass ein Llama 3-Modell über ein Kontextgedächtnis von rund 6.400 Wörtern innerhalb Ihrer Interaktion verfügt. Alle Wörter, die das 8.000-Token-Limit überschreiten, werden vergessen und stellen während der Interaktion keinen weiteren Kontext bereit.

| Beschreibung | Kontextfenster | Trainingsdaten | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | Multimodales Flaggschiffmodell, günstiger und schneller als GPT-4 Turbo.128.000 Tokens (API) | Bis Oktober 2023 | |||||||||||||||||

| GPT-4-Turbo | Optimiertes GPT-4 Turbo-Modell mit Sichtfunktionen. | 128.000 Token (API) | Bis Dezember 2023 | ||||||||||||||||

| GPT-4 | Zuerst GPT-4-Modell | 8.192 Token | Bis September 2021 |

Im Gegensatz dazu unterstützt GPT-4 jetzt eine deutlich größere Kontextlänge von 32.000 Token (rund 25.600 Wörter) für ChatGPT-Benutzer und 128.000 Token (rund 102.400 Wörter) für diejenigen, die API-Endpunkte verwenden. Dies verschafft GPT-4-Modellen einen Vorteil bei der Verwaltung umfangreicher Gespräche und der Möglichkeit, lange Dokumente oder sogar ein ganzes Buch zu lesen.

Leistung

Vergleichen wir die Leistung anhand des Llama 3 vom 18. April 2024, Benchmark-Bericht von Meta AI und des GPT-4 vom 14. Mai 2024, GitHub-Bericht von OpenAI. Hier sind die Ergebnisse:

| MMLU | GPQA | MATH | HumanEval | DROP | ||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT-4o | 88,7 | 53,6 | 76,6 | 90,2 | 83,4 | ||||||||||||||||||||||||||||||||||||

| GPT-4 Turbo | 86,5 | 49,1 | 72,2 | 87,6 | 85,4 | ||||||||||||||||||||||||||||||||||||

| Llama3 8B | 68,4 | 34,2 | 30,0 | 62,2 | 58,4 | ||||||||||||||||||||||||||||||||||||

| Llama3 70B | 82,0 | 39,5 | 50,4 | 81,7 | 79,7 | ||||||||||||||||||||||||||||||||||||

| Llama3 400B | 86,1 | 48,0 | 57,8 | 84,1 | 83,5 |

Hier ist, was jedes Kriterium bewertet:

- MMLU (Massive Multitask Language Understanding): Bewertet die Fähigkeit des Modells, Fragen aus einer Vielzahl akademischer Bereiche zu verstehen und darauf zu antworten Themen.

- GPTQA (General Purpose Question Answering): Bewertet die Fähigkeit des Modells, offene Sachfragen zu beantworten.

- MATH: Testet die Fähigkeit des Modells mathematische Probleme lösen.

- HumanEval: Misst die Fähigkeit des Modells, korrekten Code basierend auf gegebenen Programmieranweisungen von Menschen zu generieren.

- DROP (Discrete Reasoning Over Paragraphs): Bewertet die Fähigkeit des Modells, diskrete Überlegungen anzustellen und Fragen basierend auf Textpassagen zu beantworten.

Die aktuellen Benchmarks verdeutlichen den Leistungsunterschied zwischen den Modellen GPT-4 und Llama 3. Obwohl das Modell Llama 3 8B deutlich hinterherzuhinken scheint, liefern die Modelle 70B und 400B schlechtere, aber ähnliche Ergebnisse wie die Modelle GPT-4o und GPT-4 Turbo in Bezug auf akademisches und allgemeines Wissen, Lesen und Verstehen, Argumentation und Logik usw Codierung. Allerdings kommt rein mathematisch noch kein Llama-3-Modell annähernd an die Leistung von GPT-4 heran.

Kosten

Die Kosten sind ein entscheidender Faktor Faktor für viele Benutzer. Das GPT-4o-Modell von OpenAI steht allen ChatGPT-Benutzern kostenlos mit einem Limit von 16 Nachrichten alle 3 Stunden zur Verfügung. Wenn Sie mehr benötigen, müssen Sie ChatGPT Plus abonnieren, das 20 USD pro Monat kostet, um das Nachrichtenlimit von GPT-4o auf 80 zu erweitern und gleichzeitig Zugriff auf die anderen GPT-4-Modelle zu haben.

Ein Andererseits sind beide Modelle Llama 3 8B und 70B kostenlos und Open Source, was ein erheblicher Vorteil für Entwickler und Forscher sein kann, die nach einer kostengünstigen Lösung ohne Kompromisse suchen Leistung.

Zugänglichkeit

GPT-4-Modelle sind über den generativen KI-Chatbot ChatGPT von OpenAI und über seine API allgemein zugänglich. Sie können GPT-4 auch auf Microsoft Copilot verwenden, was eine Möglichkeit ist, GPT-4 kostenlos zu nutzen. Diese umfassende Verfügbarkeit stellt sicher, dass Benutzer die Funktionen problemlos in verschiedenen Anwendungsfällen nutzen können. Im Gegensatz dazu ist Llama 3 ein Open-Source-Projekt, das Modellflexibilität bietet und umfassendere Experimente und Zusammenarbeit innerhalb der KI-Community fördert. Dieser Open-Access-Ansatz kann die KI-Technologie demokratisieren und sie einem viel breiteren Publikum zugänglich machen.

Obwohl beide Modelle leicht verfügbar sind, ist GPT-4 viel einfacher zu verwenden, da es in beliebte Produktivitätstools und -dienste integriert ist . Andererseits ist Llama 3 hauptsächlich in Forschungs- und Geschäftsplattformen wie Amazon Bedrock, Ollama und DataBricks integriert (mit Ausnahme des Meta AI-Chat-Assistenten), was den größeren Markt der technisch nicht versierten Benutzer nicht anspricht.

GPT-4 vs. Llama 3: Was ist besser?

Also, welches LLM ist besser? Ich würde sagen, dass GPT-4 das bessere LLM ist. GPT-4 zeichnet sich durch Multimodalität mit erweiterten Funktionen bei der Verarbeitung von Text-, Bild- und Audioeingaben aus, während sich die ähnlichen Funktionen von Llama 3 noch in der Entwicklung befinden. GPT-4 bietet außerdem eine viel größere Kontextlänge und eine bessere Leistung und ist über beliebte Tools und Dienste allgemein zugänglich, was es benutzerfreundlicher macht.

Es ist jedoch wichtig hervorzuheben, dass die Llama-3-Modelle eine außergewöhnlich gute Leistung erbracht haben für ein kostenloses und Open-Source-Projekt. Daher bleibt Llama 3 ein herausragendes LLM, das von Forschern und Unternehmen aufgrund seiner kostenlosen und Open-Source-Natur sowie seiner beeindruckenden Leistung, Flexibilität und zuverlässigen Datenschutzfunktionen bevorzugt wird. Während allgemeine Verbraucher möglicherweise keine unmittelbare Verwendung für Llama 3 finden, bleibt es für viele Forscher und Unternehmen die praktikableste Option.

Zusammenfassend lässt sich sagen, dass sich GPT-4 zwar durch seine erweiterten multimodalen Fähigkeiten, die größere Kontextlänge und andere auszeichnet Durch die nahtlose Integration in weit verbreitete Tools bietet Llama 3 mit seinem Open-Source-Charakter eine wertvolle Alternative, die eine größere Anpassung und Kosteneinsparungen ermöglicht. In Bezug auf die Anwendung ist GPT-4 also ideal für diejenigen, die Benutzerfreundlichkeit und umfassende Funktionen in einem Modell suchen, während Llama 3 gut für Entwickler und Forscher geeignet ist, die Flexibilität und Anpassungsfähigkeit suchen.

Das obige ist der detaillierte Inhalt vonLlama 3 vs. GPT-4: Was ist besser?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr