Heim >Technologie-Peripheriegeräte >KI >so cool! Alte iPhone-, iPad- und MacBook-Geräte bilden einen heterogenen Cluster und können Llama 3 ausführen

so cool! Alte iPhone-, iPad- und MacBook-Geräte bilden einen heterogenen Cluster und können Llama 3 ausführen

- PHPzOriginal

- 2024-07-19 05:09:591084Durchsuche

Wenn Sie ungenutzte Geräte haben, können Sie es vielleicht einmal versuchen.

Dieses Mal kann das Hardwaregerät in Ihrer Hand auch im Bereich KI seine Muskeln spielen lassen.

Durch die Kombination von iPhone, iPad und Macbook können Sie eine „heterogene Cluster-Inferenzlösung“ zusammenstellen und dann das Llama3-Modell reibungslos ausführen.

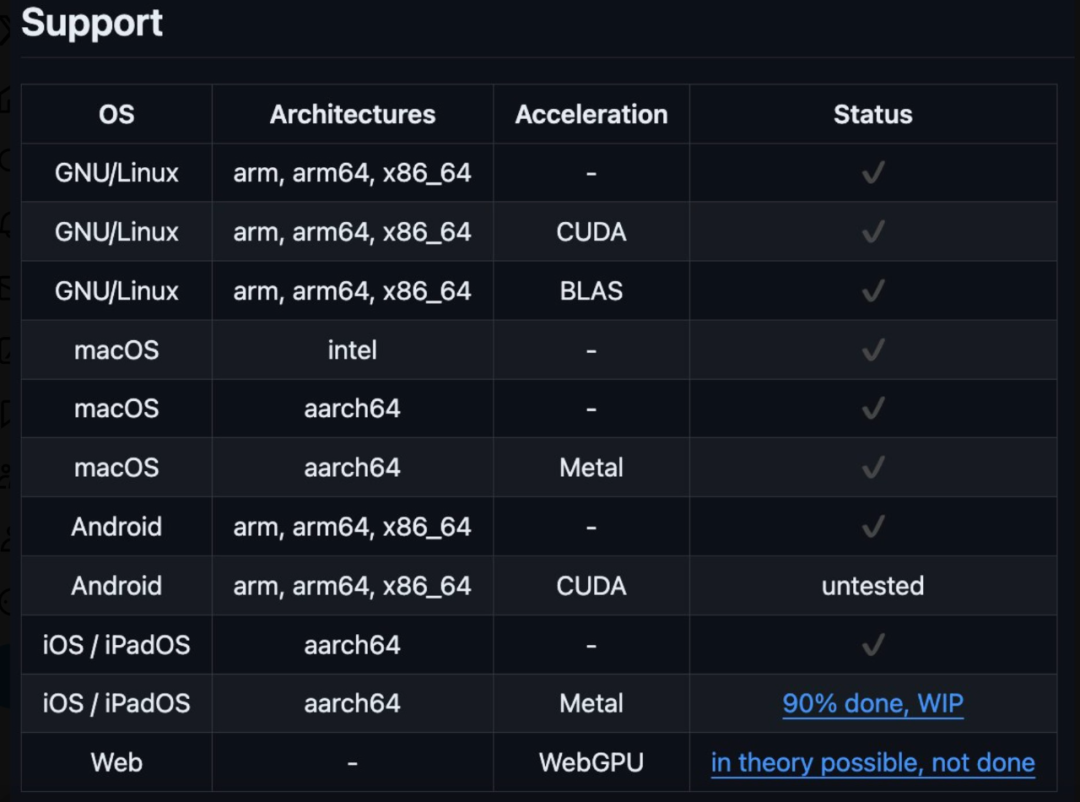

Es ist erwähnenswert, dass dieser heterogene Cluster ein Windows-, Linux- oder iOS-System sein kann und die Unterstützung für Android bald verfügbar sein wird. Der heterogene Cluster wird ausgeführt.

Laut dem Projektautor @evilsocket umfasst dieser heterogene Cluster iPhone 15 Pro Max, iPad Pro, MacBook Pro (M1 Max), NVIDIA GeForce 3080, 2x NVIDIA Titan X Pascal. Der gesamte Code wurde auf GitHub hochgeladen. Als die Internetnutzer dies sahen, äußerten sie, dass dieser alte Mann tatsächlich nicht einfach sei.

Laut dem Projektautor @evilsocket umfasst dieser heterogene Cluster iPhone 15 Pro Max, iPad Pro, MacBook Pro (M1 Max), NVIDIA GeForce 3080, 2x NVIDIA Titan X Pascal. Der gesamte Code wurde auf GitHub hochgeladen. Als die Internetnutzer dies sahen, äußerten sie, dass dieser alte Mann tatsächlich nicht einfach sei.

Einige Internetnutzer beginnen jedoch, sich Sorgen über den Energieverbrauch zu machen. Unabhängig von der Geschwindigkeit kann die Stromrechnung nicht bezahlt werden. Das Hin- und Herschieben von Daten verursacht zu viel Verlust.

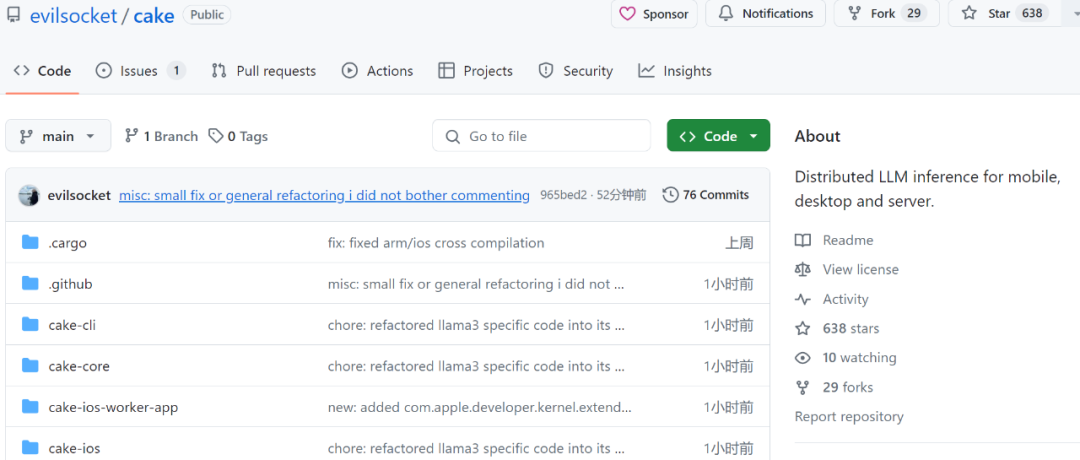

Projektadresse: https://github.com/evilsocket/cake

Die Hauptidee von Cake besteht darin, Transformatorblöcke auf mehrere Geräte aufzuteilen, um Inferenzen auf Modelle ausführen zu können, die normalerweise nicht hineinpassen der GPU-Speicher eines einzelnen Geräts. Der Rückschluss auf aufeinanderfolgende Transformatorblöcke im selben Arbeitsthread erfolgt stapelweise, um durch die Datenübertragung verursachte Verzögerungen zu minimieren.

cargo build --release

make ios

Verwenden Sie

, um den Worker-Knoten auszuführen:cake-cli --model /path/to/Meta-Llama-3-8B \ # model path, read below on how to optimize model size for workers --mode worker \# run as worker --name worker0 \ # worker name in topology file --topology topology.yml \# topology --address 0.0.0.0:10128 # bind address

cake-cli --model /path/to/Meta-Llama-3-8B \ --topology topology.ymlDie topology.yml bestimmt, welche Schichten von welchem Worker bedient werden:

linux_server_1:host: 'linux_server.host:10128'description: 'NVIDIA Titan X Pascal (12GB)'layers:- 'model.layers.0-5'linux_server_2:host: 'linux_server2.host:10128'description: 'NVIDIA GeForce 3080 (10GB)'layers:- 'model.layers.6-16'iphone:host: 'iphone.host:10128'description: 'iPhone 15 Pro Max'layers:- 'model.layers.17'ipad:host: 'ipad.host:10128'description: 'iPad'layers:- 'model.layers.18-19'macbook:host: 'macbook.host:10128'description: 'M1 Max'layers: - 'model.layers.20-31'

cake-split-model --model-path path/to/Meta-Llama-3-8B \ # source model to split --topology path/to/topology.yml \# topology file --output output-folder-nameReferenzlink: https://x.com/tuturetom/status/1812654489972973643

Das obige ist der detaillierte Inhalt vonso cool! Alte iPhone-, iPad- und MacBook-Geräte bilden einen heterogenen Cluster und können Llama 3 ausführen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr