Heim >Technologie-Peripheriegeräte >KI >Der erste Wettbewerbsplan für die KI-Mathematische Olympiade wurde bekannt gegeben: Die vier Gewinnerteams entschieden sich alle für das inländische Modell DeepSeekMath

Der erste Wettbewerbsplan für die KI-Mathematische Olympiade wurde bekannt gegeben: Die vier Gewinnerteams entschieden sich alle für das inländische Modell DeepSeekMath

- 王林Original

- 2024-07-16 18:14:571181Durchsuche

Das Gewinnermodell der KI-Matheolympiade ist da!

Zu diesem Zeitpunkt gab der Beamte lediglich die Liste der Gewinner bekannt und gab keine weiteren Informationen zu den Modellen dahinter preis. Jeder ist neugierig, welches Modell hat das Gewinnerteam verwendet?

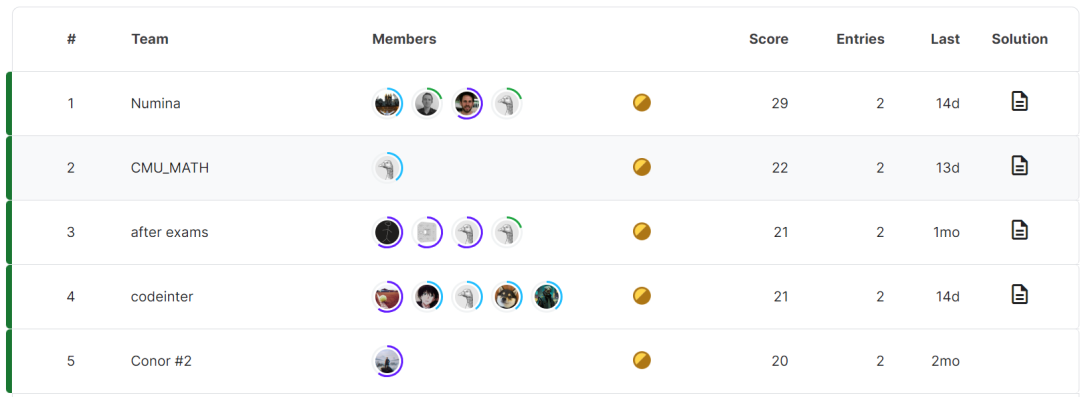

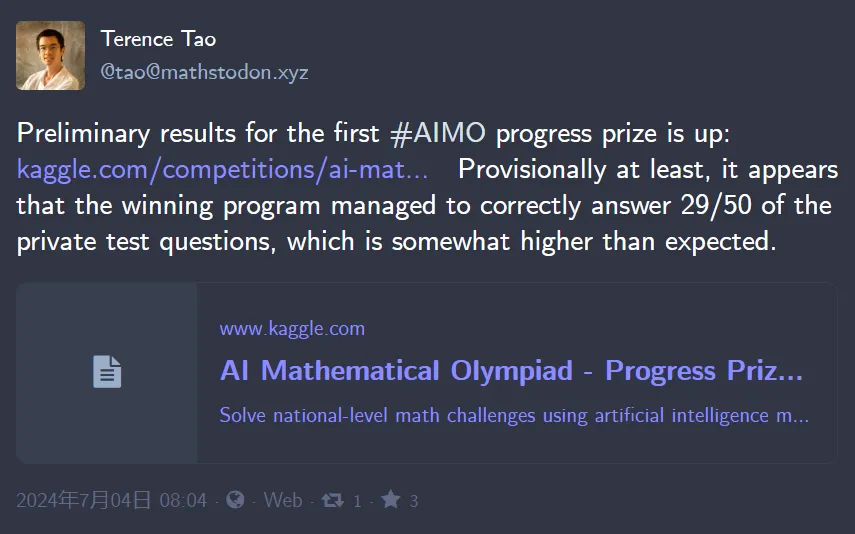

Gerade wurden die Modelle hinter den vier besten AIMO Progress Awards bekannt gegeben.

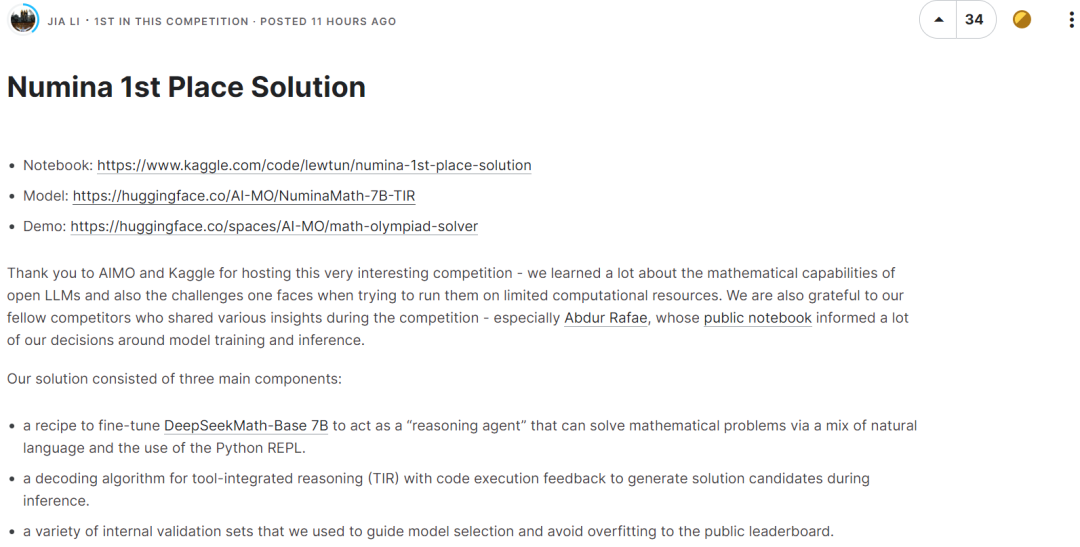

Gerade wurden die Modelle hinter den vier besten AIMO Progress Awards bekannt gegeben. Das vom Meisterschaftsteam verwendete Modell ist NuminaMath 7B TIR, eine fein abgestimmte Version von deepseek-math-7b-base.

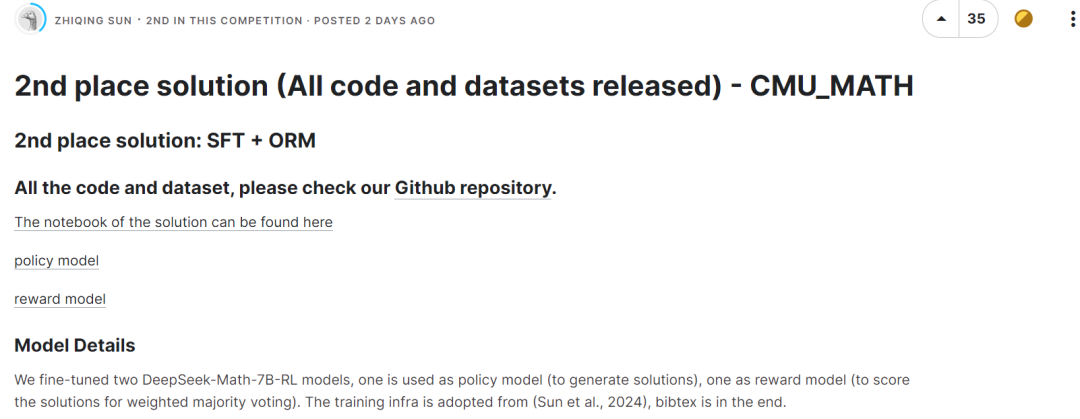

Das Team mit dem zweiten Platz hat zwei DeepSeek-Math-7B-RL-Modelle verfeinert, eines als Richtlinienmodell (zur Generierung von Lösungen) und eines als Belohnungsmodell (zur Abstimmung mit gewichteter Mehrheit). Lösungen werden bewertet.

Der dritte Platz nutzte ebenfalls das DeepSeek-Math-7B-RL-Modell ohne jegliche Feinabstimmung und nutzte eine Mehrheitsabstimmungsstrategie, um die richtige Antwort anhand der festgelegten Bewertungsregeln auszuwählen.

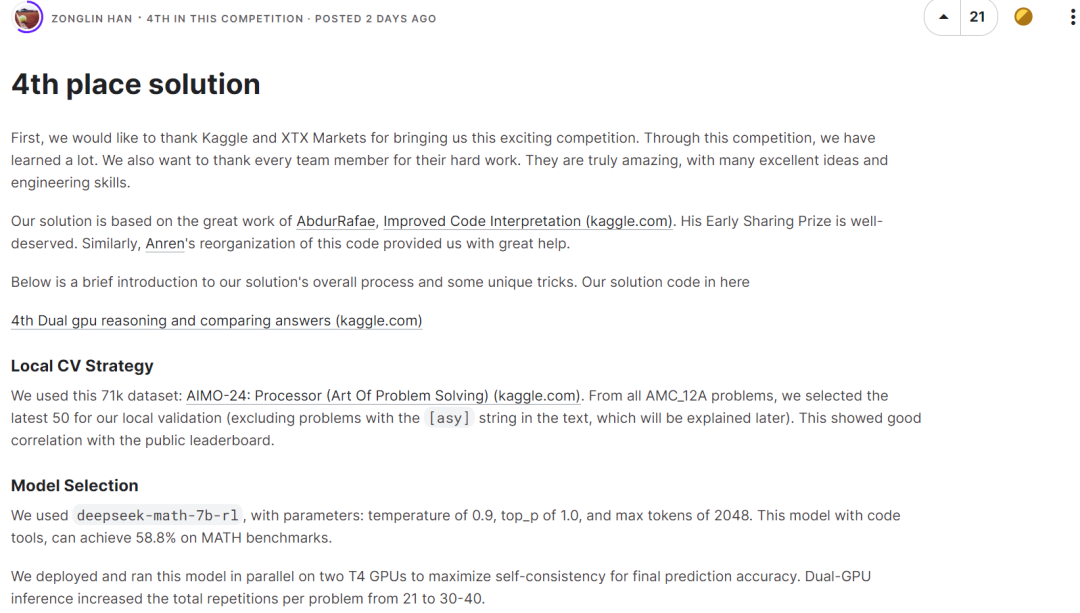

Der dritte Platz nutzte ebenfalls das DeepSeek-Math-7B-RL-Modell ohne jegliche Feinabstimmung und nutzte eine Mehrheitsabstimmungsstrategie, um die richtige Antwort anhand der festgelegten Bewertungsregeln auszuwählen.  Das viertplatzierte Team verwendete ebenfalls deepseek-math-7b-rl mit den Parametereinstellungen Temperature von 0,9, top_p von 1,0 und maximalen Token von 2048. In Kombination mit Codierungstools erreicht dieses Modell 58,8 % im MATH-Benchmark.

Das viertplatzierte Team verwendete ebenfalls deepseek-math-7b-rl mit den Parametereinstellungen Temperature von 0,9, top_p von 1,0 und maximalen Token von 2048. In Kombination mit Codierungstools erreicht dieses Modell 58,8 % im MATH-Benchmark.  Es ist nicht schwer festzustellen, dass die vier besten Teams alle DeepSeekMath-7B als Basismodell gewählt und gute Ergebnisse erzielt haben. Die Fähigkeit zum mathematischen Denken dieses Modells kommt der von GPT-4 nahe und übertrifft eine Reihe von 30 bis 70 Milliarden Open-Source-Modellen auf der MATH-Benchmark-Liste.

Es ist nicht schwer festzustellen, dass die vier besten Teams alle DeepSeekMath-7B als Basismodell gewählt und gute Ergebnisse erzielt haben. Die Fähigkeit zum mathematischen Denken dieses Modells kommt der von GPT-4 nahe und übertrifft eine Reihe von 30 bis 70 Milliarden Open-Source-Modellen auf der MATH-Benchmark-Liste.

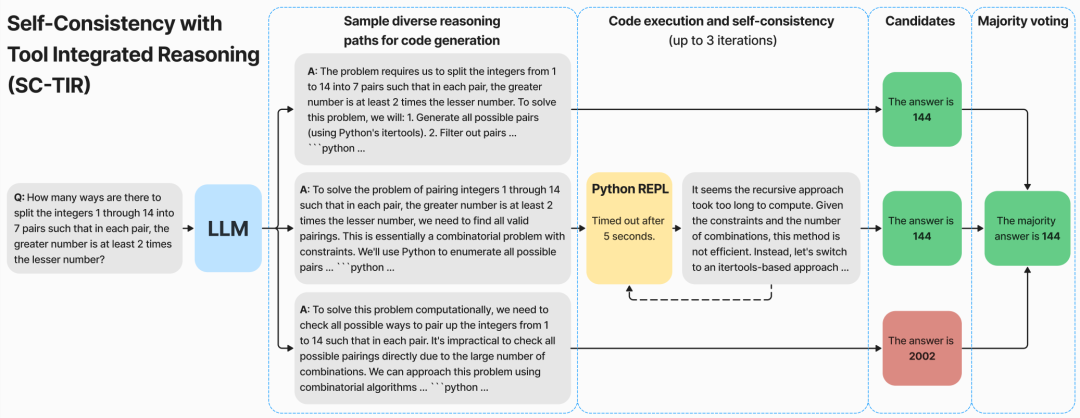

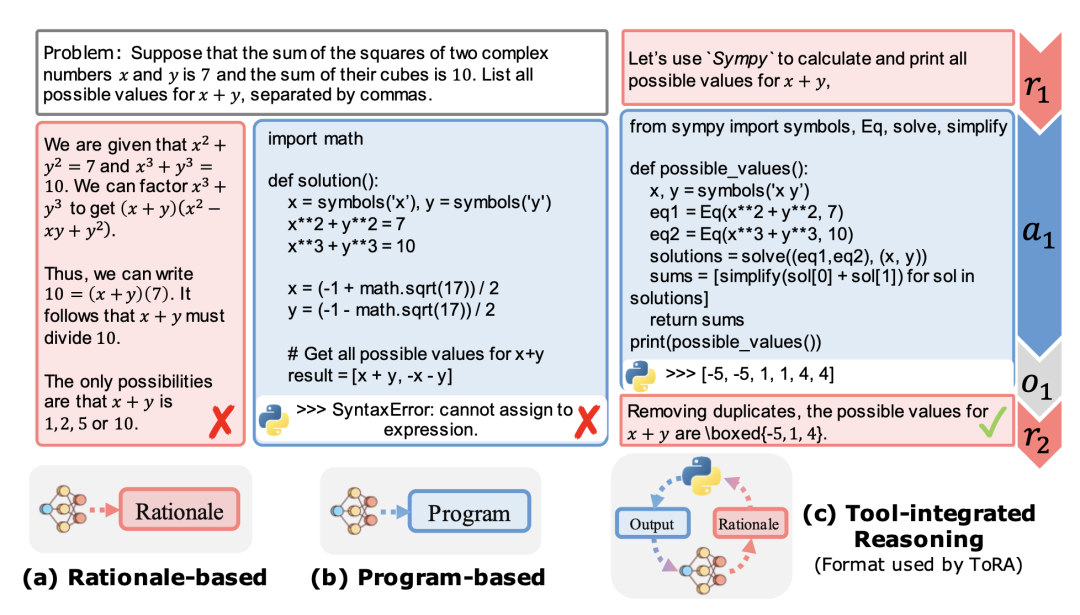

NuminaMath ist eine Familie von Sprachmodellen, die darauf trainiert sind, mathematische Probleme mithilfe von Tool Integrated Reasoning (TIR) zu lösen.

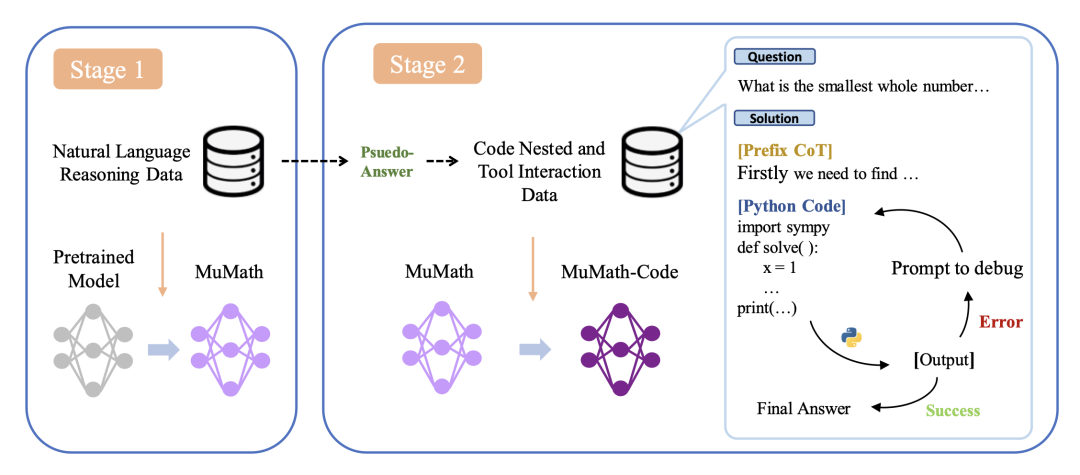

NuminaMath 7B TIR ist eine fein abgestimmte Version von deepseek-math-7b-base mit zwei Stufen der überwachten Feinabstimmung:

NuminaMath 7B TIR ist eine fein abgestimmte Version von deepseek-math-7b-base mit zwei Stufen der überwachten Feinabstimmung:

Das obige ist der detaillierte Inhalt vonDer erste Wettbewerbsplan für die KI-Mathematische Olympiade wurde bekannt gegeben: Die vier Gewinnerteams entschieden sich alle für das inländische Modell DeepSeekMath. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Stellungnahme:

Der Inhalt dieses Artikels wird freiwillig von Internetnutzern beigesteuert und das Urheberrecht liegt beim ursprünglichen Autor. Diese Website übernimmt keine entsprechende rechtliche Verantwortung. Wenn Sie Inhalte finden, bei denen der Verdacht eines Plagiats oder einer Rechtsverletzung besteht, wenden Sie sich bitte an admin@php.cn

Vorheriger Artikel:Hot GPTs-Erfahrungsbericht: Erstellen Sie exklusives GPT, der Frühling naht für Leute, die Code nicht verstehenNächster Artikel:Hot GPTs-Erfahrungsbericht: Erstellen Sie exklusives GPT, der Frühling naht für Leute, die Code nicht verstehen

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr