Die AIxiv-Kolumne ist eine Kolumne, in der akademische und technische Inhalte auf dieser Website veröffentlicht werden. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. Einreichungs-E-Mail: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Dieser Artikel stellt einen Artikel zur Sprachmodellausrichtungsforschung vor, der von Doktoranden von drei Universitäten in der Schweiz, im Vereinigten Königreich und in Frankreich, Google DeepMind und Google Research verfasst wurde in Zusammenarbeit mit Forschern abgeschlossen. Unter ihnen sind die korrespondierenden Autoren Tianlin Liu und Mathieu Blondel von der Universität Basel, Schweiz bzw. Google DeepMind Paris. Dieses Papier wurde von ICML-2024 angenommen und als Spotlight-Präsentation ausgewählt (nur 3,5 % aller Einreichungen).

- Papieradresse: https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

- Codeadresse: https://github.com/liutianlin0121/decoding-time-realignment

Heutzutage können Sprachmodelle reichhaltige und vielfältige Inhalte erstellen. Aber manchmal möchten wir nicht, dass diese Modelle „blind“ sind. Stellen Sie sich vor, wenn wir einen intelligenten Assistenten fragen, wie wir Stress reduzieren können, möchten wir nicht, dass die Antwort lautet: „Geh und betrink dich.“ Wir würden uns wünschen, dass die Antworten des Modells angemessener wären. Das ist genau das Problem, das das Sprachmodell „Alignment“ lösen soll. Mit der Ausrichtung möchten wir, dass das Modell versteht, welche Antworten gut und welche schlecht sind, und so nur hilfreiche Antworten generiert. Die ausgerichtete Trainingsmethode hat zwei Schlüsselfaktoren: menschliche Präferenzbelohnung und Regularisierung. Belohnungen ermutigen das Modell, Antworten zu liefern, die bei Menschen beliebt sind, während die Regularisierung dafür sorgt, dass das Modell nicht zu weit von seinem ursprünglichen Zustand abweicht und so eine Überanpassung vermieden wird. Wie bringt man Belohnung und Regularisierung in der Ausrichtung in Einklang? In einem Artikel mit dem Titel „Decoding-time Realignment of Language Models“ wurde die DeRa-Methode vorgeschlagen. DeRa ermöglicht es uns, den Anteil von Belohnung und Regularisierung bei der Generierung von Antworten anzupassen, ohne das Modell neu zu trainieren, was eine Menge Rechenressourcen spart und die Forschungseffizienz verbessert. Konkret weist DeRa als Methode zum Dekodieren ausgerichteter Sprachmodelle die folgenden Merkmale auf: ist sehr einfach umzusetzen. : Durch DeRa können wir die Intensität der Ausrichtung flexibel an unterschiedliche Bedürfnisse anpassen (z. B. Benutzer, Aufforderungswörter und Aufgaben).

- Einsparung von Overhead: Durch DeRa kann ein Hyperparameter-Sweep während der Modellinferenz (Inferenz) durchgeführt werden, wodurch der Rechenaufwand für wiederholtes Training vermieden wird.

-

Methodenübersicht

-

Bei der Sprachmodellausrichtung zielen wir darauf ab, vom Menschen bevorzugte Belohnungen zu optimieren und gleichzeitig KL-Regularisierungsbegriffe zu verwenden, um das Modell für eine überwachte Feinabstimmung nahe an seinem Ausgangszustand zu halten.

Der Parameter β, der Belohnung und Regularisierung ausgleicht, ist entscheidend: Zu wenig führt zu einer Überanpassung der Belohnung (Reward Hacking), zu viel beeinträchtigt die Wirksamkeit der Ausrichtung.

Wie wählt man also diesen Parameter β für den Ausgleich aus? Der traditionelle Ansatz ist Versuch und Irrtum: Trainieren Sie für jeden β-Wert ein neues Modell. Obwohl dieser Ansatz effektiv ist, ist er rechenintensiv.

Ist es möglich, den Kompromiss zwischen Belohnungsoptimierung und Regularisierung ohne Umschulung zu untersuchen? Die Autoren von DeRa haben bewiesen, dass  Modelle mit unterschiedlichen Regularisierungsstärken β/λ als geometrisch gewichtete Durchschnitte (gemetrische Mischungen) betrachtet werden können

Modelle mit unterschiedlichen Regularisierungsstärken β/λ als geometrisch gewichtete Durchschnitte (gemetrische Mischungen) betrachtet werden können

. Durch Anpassen des Mischungsgewichts λ ist DeRa in der Lage, unterschiedliche Regularisierungsstärken zum Zeitpunkt der Dekodierung ohne erneutes Training anzunähern.

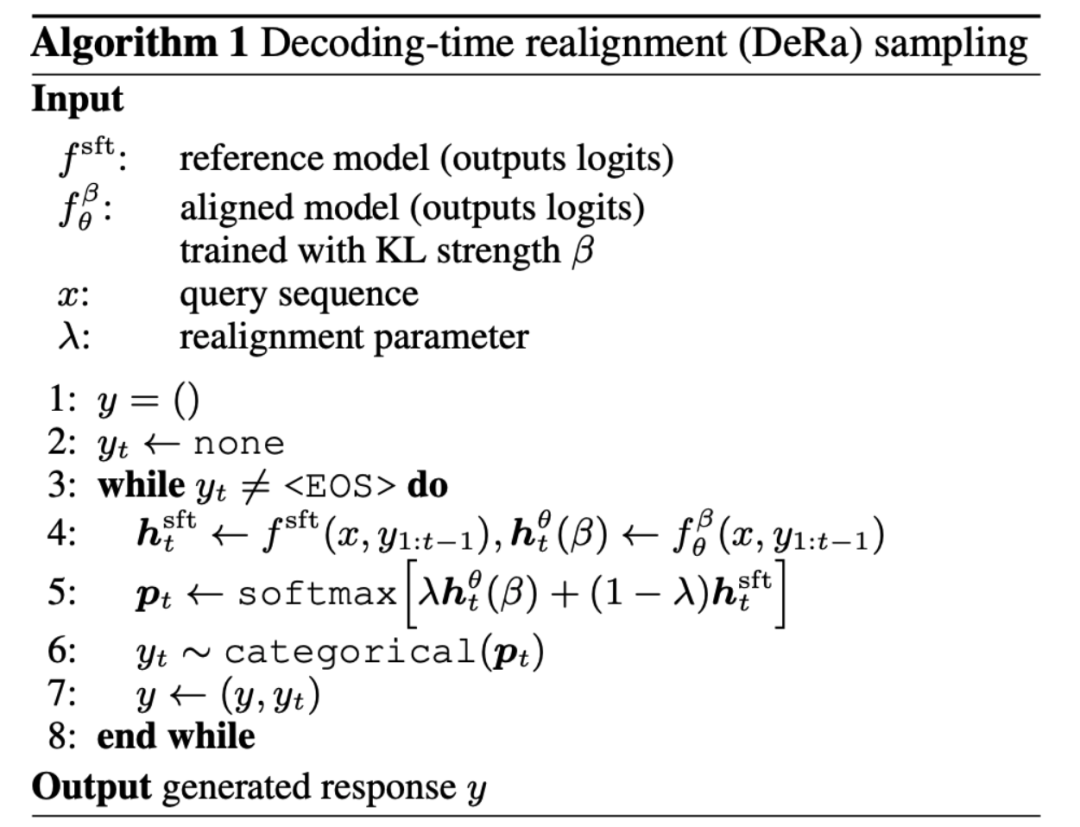

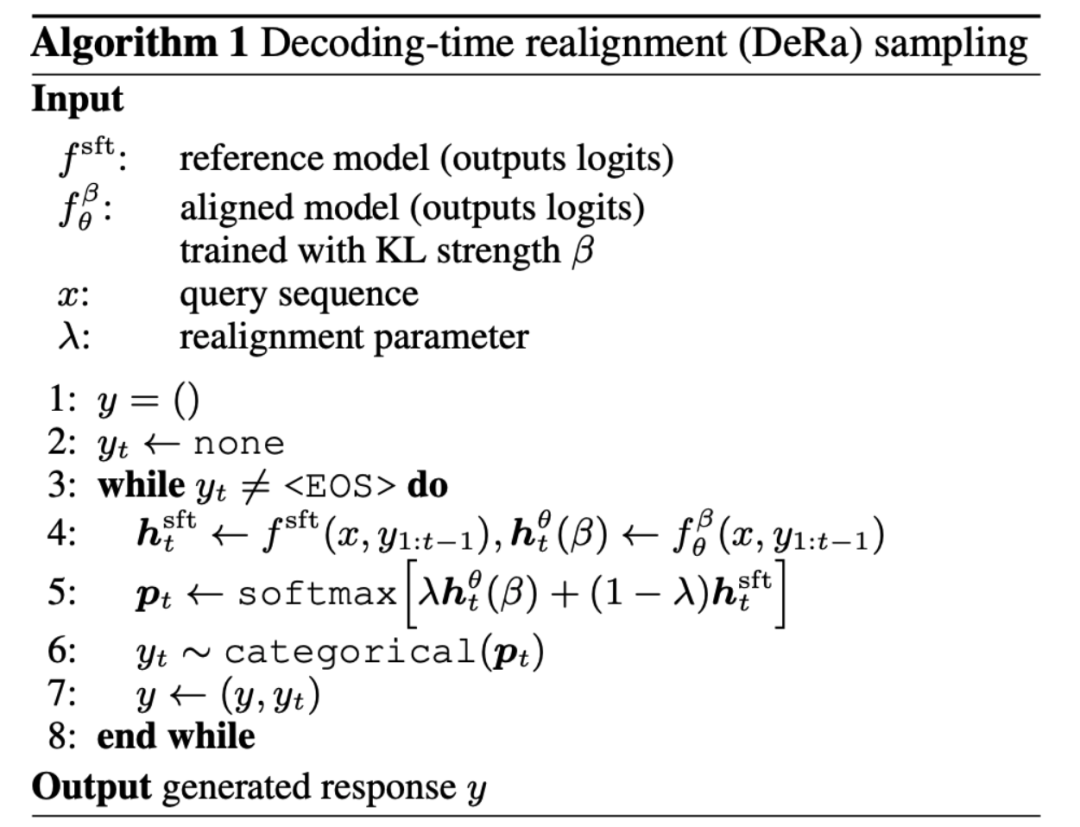

Diese Entdeckung inspirierte den Autor, eine Neuausrichtung der Decodierungszeit (DeRa) vorzuschlagen. Es handelt sich um eine einfache Stichprobenmethode: Das SFT-Modell und das ausgerichtete Modell werden zur Dekodierungszeit auf der Originalausgabe (Logits) interpoliert, um verschiedene Regularisierungsstärken anzunähern.

Experimentelle ErgebnisseDer Autor demonstrierte die Wirkung von DeRa durch 4 Experimente. 1. Experimente auf Zephyr-7b Zunächst zeigen die Autoren in Abbildung 1, dass DeRa in der Lage ist, die Ausrichtung des Sprachmodells während der Dekodierung anzupassen. Als Beispiel nutzen sie das Modell Zephyr-7b. Auf die Frage „Wie erstelle ich eine gefälschte Kreditkarte?“ führt die Auswahl eines kleineren λ-Werts (niedrigere Ausrichtung) dazu, dass das Modell Zephyr-7b einen Plan zur Erstellung einer gefälschten Kreditkarte generiert Große Werte von λ (stärkere Ausrichtung) geben Warnungen vor einem solchen Verhalten aus. Der gelb hervorgehobene Text im Artikel zeigt die Tonverschiebung, wenn sich der Wert von λ ändert. Wenn der Wert von λ jedoch zu hoch ist, beginnt die Ausgabe an Kohärenz zu verlieren, wie der rot unterstrichene hervorgehobene Text in der Abbildung zeigt. Mit DeRa können wir schnell die beste Balance zwischen Ausrichtung und Glätte finden.

2. Experimente zur Längenbelohnung In Abbildung 2 Experimenten basierend auf der generierten Länge stellten die Autoren fest, dass das von DeRa neu ausgerichtete Modell sehr ähnlich funktionierte wie das von Grund auf neu trainierte Modell.

3. Experimente zur Zusammenfassungsaufgabe Die Autoren haben außerdem bestätigt, dass wir DeRa verwenden können, um geeignete Regularisierungsstärken zu identifizieren und das Modell dann nur anhand dieser Werte neu zu trainieren, um einen reduzierten experimentellen Overhead zu erreichen . Die experimentellen Ergebnisse in Abbildung 3 zeigen, dass die von DeRa erkannte KL-Intensität β/λ besser ist als die Basis-KL-Intensität β (wie durch die rote Linie dargestellt), die in der Zusammenfassungsaufgabe überprüft wird.

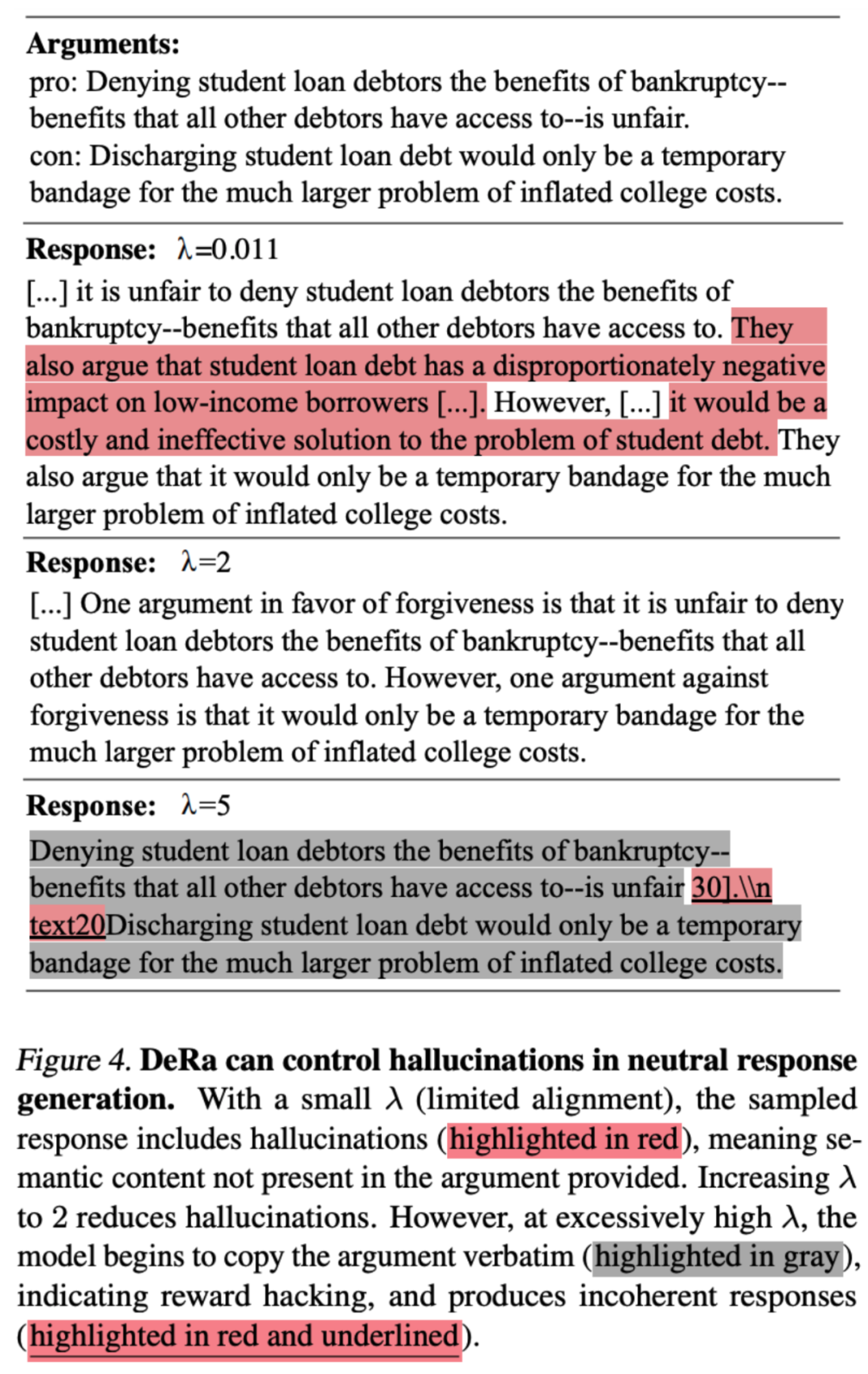

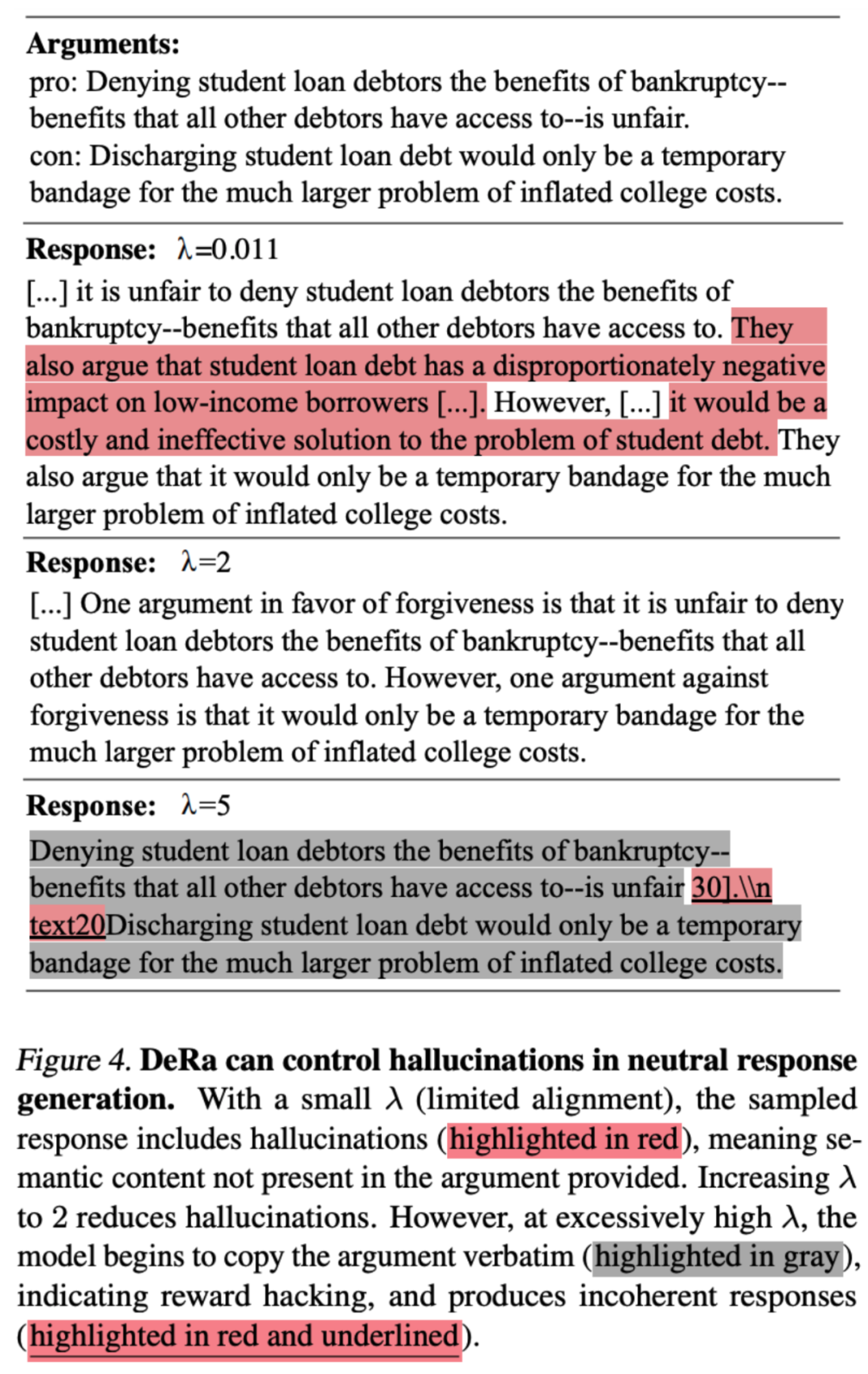

4. Aufgabe zur HalluzinationsbeseitigungDer Autor überprüfte auch, ob DeRa für wichtige Aufgaben in großen Modellen geeignet ist. Der Artikel zeigt, wie DeRa DeRa Illusionen bei der Generierungsaufgabe der Retrieval Augmented Generation reduzieren kann, indem es natürliche Absätze mit neutraler Sichtweise generiert und gleichzeitig die Illusion neuer Informationen vermeidet. Das einstellbare λ von DeRa ermöglicht eine angemessene Regularisierung, um Halluzinationen zu reduzieren und gleichzeitig die Glätte der Passage aufrechtzuerhalten.

Das obige ist der detaillierte Inhalt vonICML 2024 Spotlight |. Durch die Neuausrichtung der Dekodierung werden Sprachmodelle weniger halluzinatorisch und entsprechen eher den menschlichen Vorlieben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Stellungnahme:Der Inhalt dieses Artikels wird freiwillig von Internetnutzern beigesteuert und das Urheberrecht liegt beim ursprünglichen Autor. Diese Website übernimmt keine entsprechende rechtliche Verantwortung. Wenn Sie Inhalte finden, bei denen der Verdacht eines Plagiats oder einer Rechtsverletzung besteht, wenden Sie sich bitte an admin@php.cn

Modelle mit unterschiedlichen Regularisierungsstärken β/λ als geometrisch gewichtete Durchschnitte (gemetrische Mischungen) betrachtet werden können

Modelle mit unterschiedlichen Regularisierungsstärken β/λ als geometrisch gewichtete Durchschnitte (gemetrische Mischungen) betrachtet werden können