Heim >Technologie-Peripheriegeräte >KI >Technischer Bericht von Google Gemini 1.5: Einfache Prüfung von Mathematik-Olympiade-Fragen, die Flash-Version ist fünfmal schneller als GPT-4 Turbo

Technischer Bericht von Google Gemini 1.5: Einfache Prüfung von Mathematik-Olympiade-Fragen, die Flash-Version ist fünfmal schneller als GPT-4 Turbo

- PHPzOriginal

- 2024-06-13 13:52:271334Durchsuche

Im Februar dieses Jahres brachte Google das multimodale große Modell Gemini1.5 auf den Markt, das durch technische und Infrastrukturoptimierung, MoE-Architektur und andere Strategien die Leistung und Geschwindigkeit erheblich verbesserte. Mit längerem Kontext, stärkeren Argumentationsfähigkeiten und besserem Umgang mit modalübergreifenden Inhalten.

Diesen Freitag hat Google DeepMind offiziell den technischen Bericht von Gemini 1.5 veröffentlicht, der die Flash-Version und andere aktuelle Upgrades behandelt. Das Dokument ist 153 Seiten lang.

Link zum technischen Bericht: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

In diesem Bericht stellt Google die Modelle der Gemini 1.5-Serie vor. Es stellt die nächste Generation hoch recheneffizienter multimodaler Großmodelle dar, die in der Lage sind, feinkörnige Informationen und Überlegungen aus dem Kontext von Millionen von Token abzurufen, darunter mehrere lange Dokumente und stundenlange Videos. Die Modelle der Gemini 1.5-Serie verfügen über mehrere Sprach- und visuelle Argumentationsfunktionen, wodurch sie in den Bereichen natürlicher Sprachverarbeitung und Computer Vision weit verbreitet sind. Das Modell ist in der Lage, wichtige Informationen aus Texten zu extrahieren und Schlussfolgerungen zu ziehen sowie eine umfassende Analyse mehrerer langer Dokumente durchzuführen. Darüber hinaus unterstützt es die Verarbeitung großer Mengen visueller Daten und ist in der Lage, große Mengen visueller Daten in Stunden zu verarbeiten.

Die Serie umfasst zwei neue Modelle:

- Das aktualisierte Gemini 1.5 Pro mit den meisten Funktionen und Benchmarks Februar Die Version von

- Gemini 1.5 Flash, eine leichtere Variante, die auf Effizienz bei minimalen Leistungseinbußen ausgelegt ist.

In Bezug auf die Flash-Version, die diese Woche auf der Google I/O-Konferenz erwähnt wurde, heißt es in dem Bericht, dass Gemini 1.5 Flash ein Transformer-Decoder-Modell mit demselben 2M+-Kontext und denselben multimodalen Funktionen wie Gemini 1.5 Pro ist. Nutzt effizient Tensor Processing Units (TPUs) und weist eine geringe Modellbereitstellungslatenz auf. Gemini 1.5 Flash kann beispielsweise Aufmerksamkeits- und Feed-Forward-Komponenten parallel berechnen und ist außerdem ein Gemini 1.5 Pro-Modell mit größeren Netzwerk-Online-Extraktionsfunktionen. Es wird mithilfe von Vorverarbeitungsmethoden höherer Ordnung trainiert, um die Qualität zu verbessern.

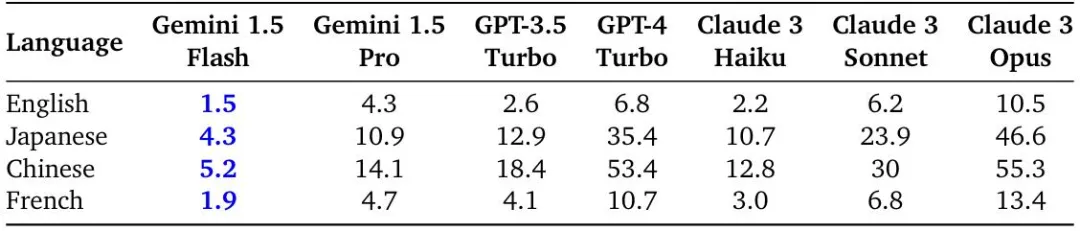

Der Bericht bewertet die durchschnittliche Zeit pro Ausgabezeichen für englische, chinesische, japanische und französische Abfragen aus Gemini 1.5 und der Vertex AI Streaming API.

Zeit pro Ausgabezeichen (ms) für Antworten auf Englisch, Chinesisch, Japanisch und Französisch. Mit 10.000 eingegebenen Zeichen erreichte Gemini 1.5 Flash die schnellste Generation aller getesteten Sprachen.

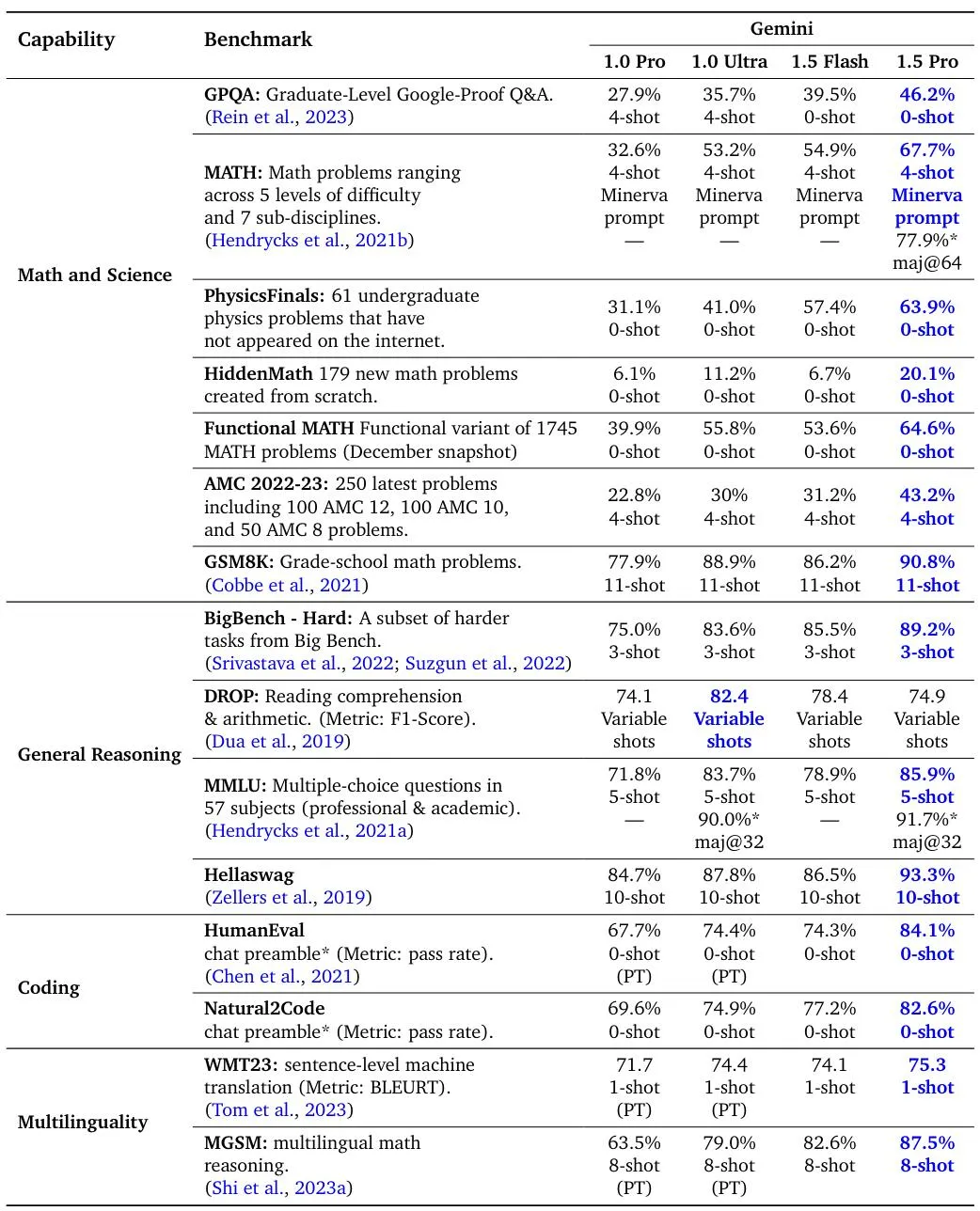

Bewertungsergebnisse der Modelle Gemini 1.5 Pro, 1.5 Flash und Gemini 1.0 in Bezug auf Standardcodierung, Mehrsprachigkeit sowie Benchmarks für Mathematik, Naturwissenschaften und logisches Denken. Alle Zahlen für 1.5 Pro und 1.5 Flash ergeben sich nach Befehlsanpassungen.

Gemini 1.5 Pro im Vergleich zu Gemini 1.0 Pro und Ultra bei Videoverständnis-Benchmarks.

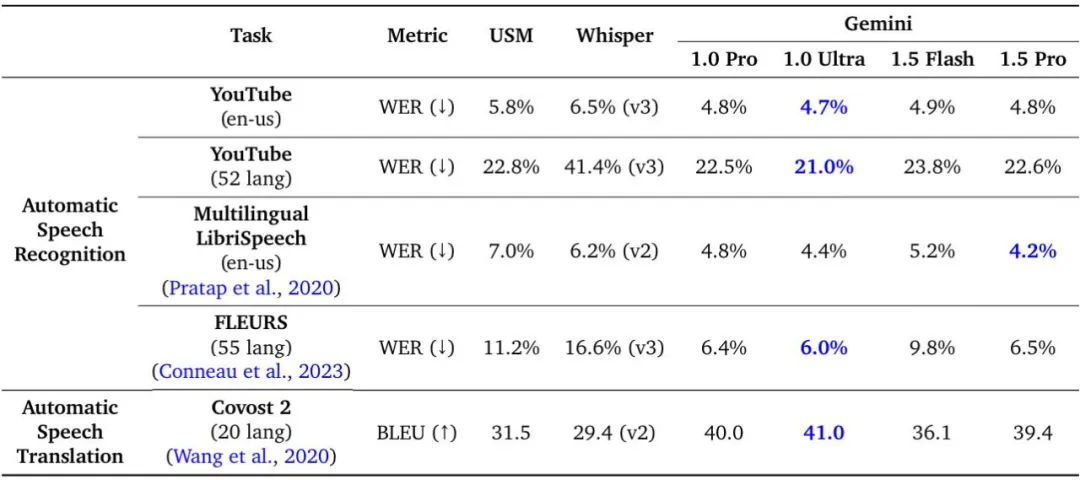

Vergleich von Gemini 1.5 Pro mit USM, Whisper, Gemini 1.0 Pro und Gemini 1.0 Ultra zu Audioverständnisaufgaben.

Das Gemini 1.5-Modell erreicht einen nahezu perfekten Rückruf bei modalübergreifenden Langkontext-Abrufaufgaben, verbessert das optimale Niveau der Langdokument-QA, Langvideo-QA und Langkontext-ASR und entspricht oder übertrifft den Gemini 1.0 Ultra-Lieferzustand Höchste Leistung bei einer Vielzahl von Benchmarks. Darüber hinaus gab Google an, dass die Leistung von Gemini 1.5 seit Mai dieses Jahres im Vergleich zum Februar deutlich verbessert wurde.

Gemini 1.5 Pro (Mai) im Vergleich zur Erstveröffentlichung (Februar) bei mehreren Benchmarks. Das neueste Gemini 1.5 Pro bietet Verbesserungen bei allen Inferenz-, Codierungs-, Vision- und Video-Benchmarks, während die Audio- und Übersetzungsleistung unverändert bleibt. Beachten Sie, dass für FLEURS niedrigere Werte besser sind.

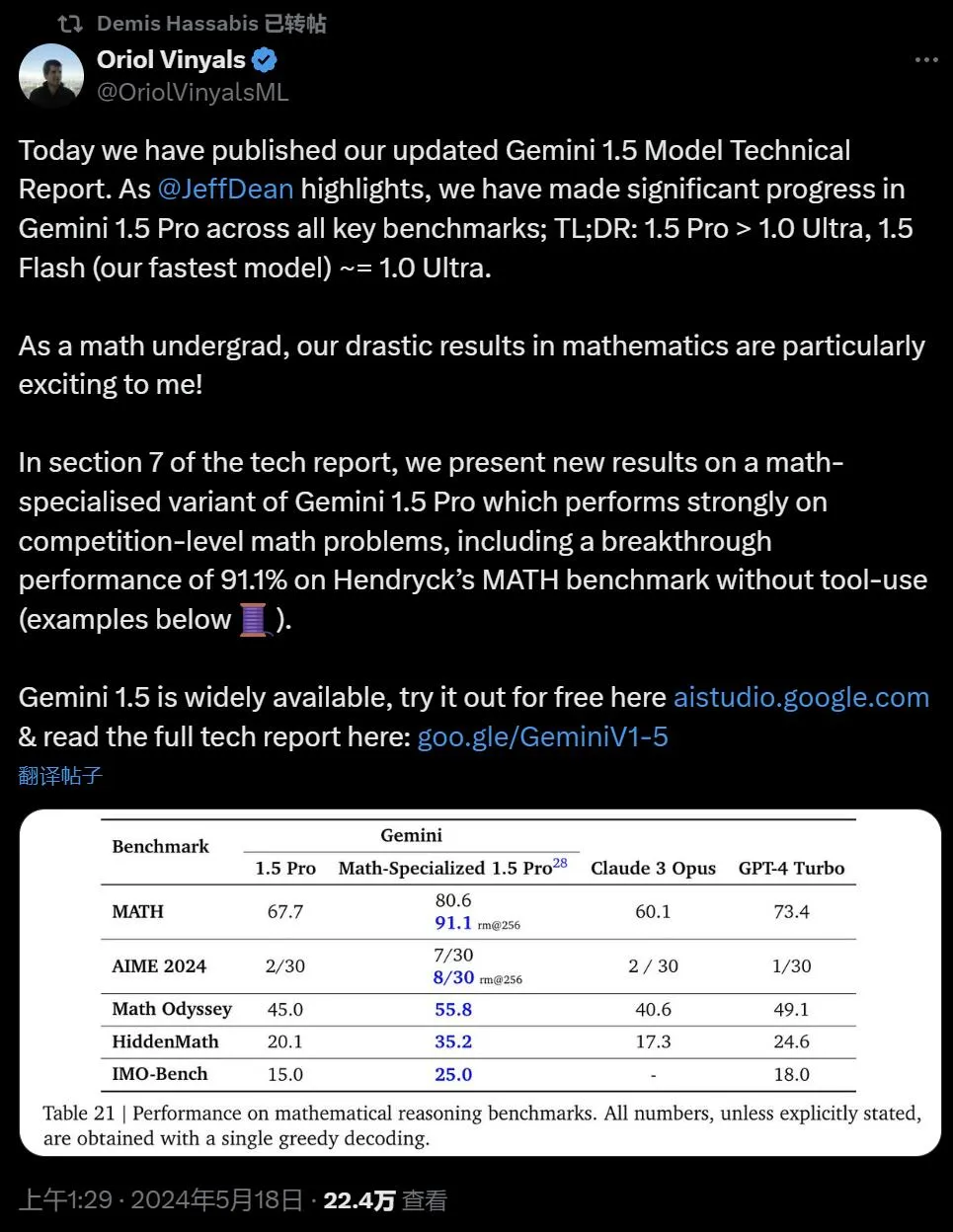

Oriol Vinyals, Vizepräsident von Google DeepMind und Co-Leiter des Gemini-Projekts, kam zu dem Schluss, dass Gemini 1.0 Ultra, 1.5 Flash (derzeit das schnellste Modell) ~= 1.0 Ultra.

Durch die Untersuchung der Grenzen der Long-Context-Fähigkeiten von Gemini 1.5 können wir kontinuierliche Verbesserungen bei der Vorhersage des nächsten Tokens und einem nahezu perfekten Abruf (>99 %) feststellen. Ein Generationssprung gegenüber bestehenden Modellen wie Claude 3.0 (200k) und GPT-4 Turbo (128k).

Im siebten Kapitel des Berichts stellt Google die Benchmarks der mathematisch erweiterten Version von Gemini 1.5 Pro vor, die bei mathematischen Problemen auf Wettbewerbsebene gute Leistungen erbringt, einschließlich des MATH-Benchmarks von Hendryck, ohne dass Tools verwendet werden von 91,1 %.

Im Folgenden finden Sie einige Beispiele für das Modell, das Probleme der Asia Pacific Mathematics Olympiad (APMO) löst, die frühere Modelle offensichtlich nicht lösen konnten. Oriol Vinyals sagt, diese Antwort sei großartig, weil es sich um einen Beweis (und nicht um eine Berechnung) handele, die Lösung auf den Punkt komme und „wunderschön“ sei.

Abschließend hob Google reale Anwendungsfälle für große Modelle hervor, wie etwa Gemini 1.5, das mit Profis zusammenarbeitet, um Aufgaben zu erledigen und Ziele zu erreichen, und so in 10 verschiedenen Jobkategorien 26–75 % Zeit spart.

Dieses hochmoderne große Sprachmodell weist auch einige überraschende neue Funktionen auf. Wenn man ein Grammatikhandbuch für Kalamang erhält, eine Sprache, die von weniger als 200 Menschen im Westen Papua-Neuguineas gesprochen wird, könnte das Modell lernen, Englisch ins Kalamang zu übersetzen, und zwar auf einem ähnlichen Niveau wie Menschen, die mit denselben Inhalten lernen.

Das obige ist der detaillierte Inhalt vonTechnischer Bericht von Google Gemini 1.5: Einfache Prüfung von Mathematik-Olympiade-Fragen, die Flash-Version ist fünfmal schneller als GPT-4 Turbo. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Auf welches Modell bezieht sich die 7-schichtige Netzwerkstruktur?

- So deaktivieren Sie die Popup-Blockierung in Google Chrome

- So verhindern Sie, dass Google Chrome automatisch aktualisiert wird

- So aktivieren Sie den Kamerazugriff in Google Chrome

- Wo ist der Zugang zur Google Chrome-Webversion? Chrome-Google-Suchmaschineneingang