六年种方式快速体验最新发布的 Llama 3!

- 王林转载

- 2024-04-19 12:16:01753浏览

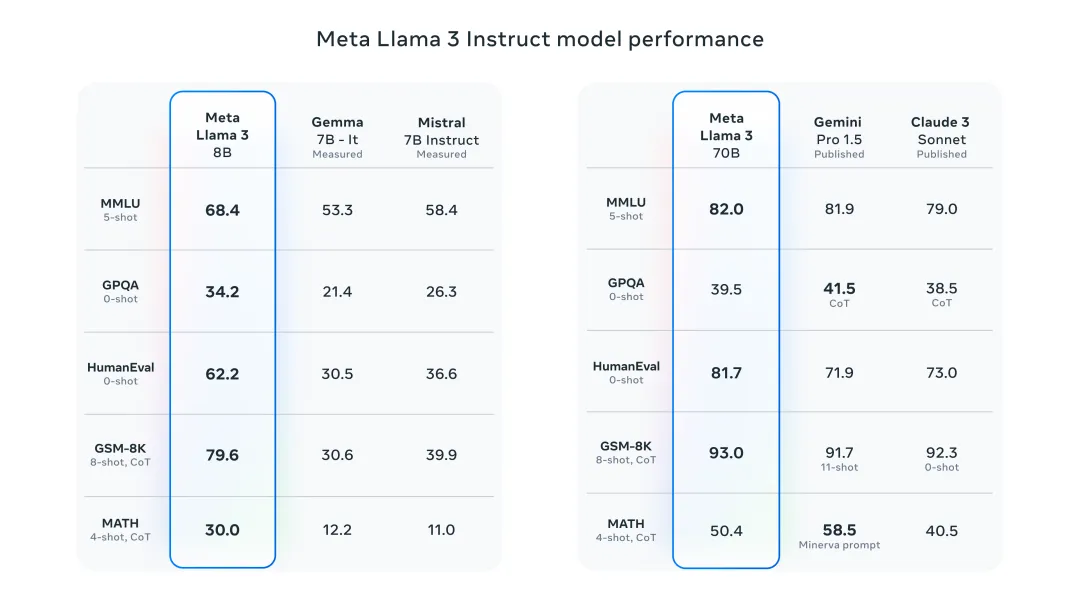

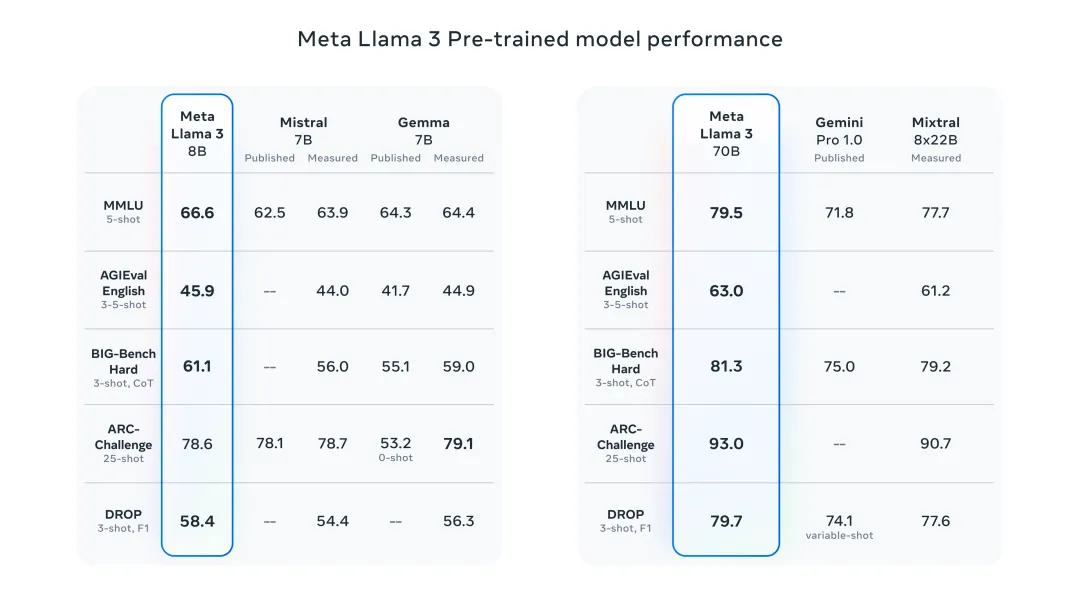

昨晚Meta发布了 Llama 3 8B 和 70B 模型,Llama 3 指令调整模型针对对话/聊天用例进行了微调和优化,在常见基准测试中优于许多现有的开源聊天模型。比如,Gemma 7B 和 Mistral 7B。

Llama 3模型对数据和规模进行了提升,达到了新的高度。它是在Meta最近发布的两个定制的24K GPU集群上,对超过15T token的数据进行训练的。这个训练数据集比Llama 2大7倍,包含多4倍的代码。这使得Llama模型的能力达到了目前的最高水平,它支持8K以上的文本长度,是Llama 2的两倍。

下面我将介绍 6 种方式,让你快速体验最新发布的 Llama 3!

在线体验 Llama 3

HuggingChat

llama2.ai

https://www.llama2.ai/

本地体验 Llama 3

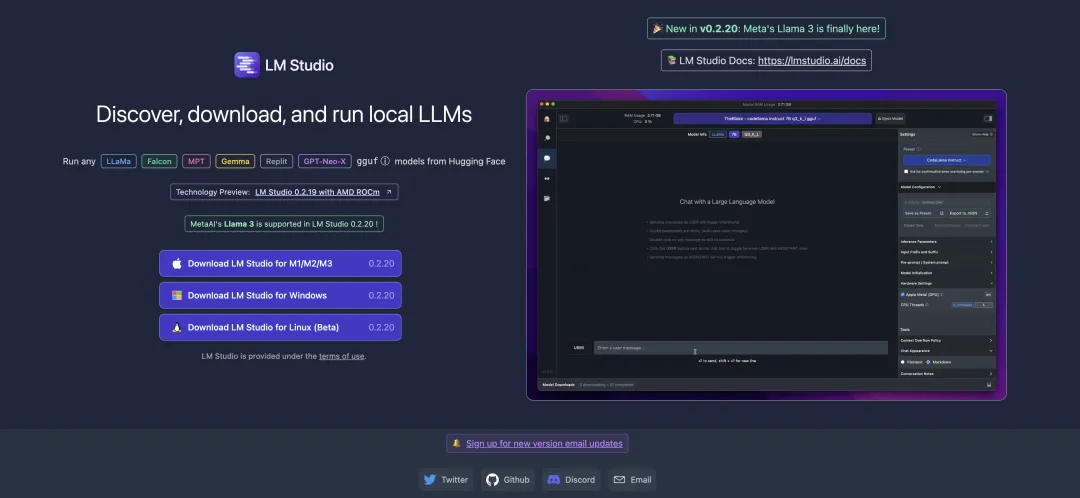

LM Studio

https://lmstudio.ai/

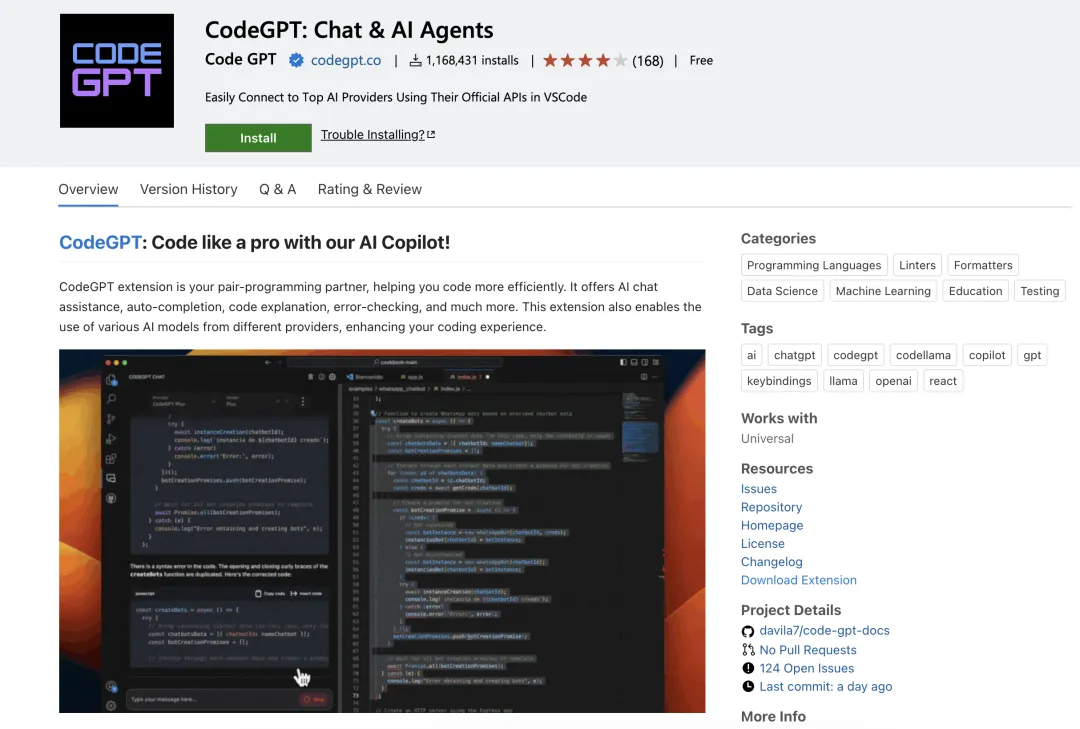

CodeGPT

https://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

使用 CodeGPT 前,记得先使用 Ollama 拉取相应的模型。比如,拉取 llama3:8b 模型:ollama pull llama3:8b。如果你本地尚未安装 ollama,可以阅读 “部署本地的大语言模型,只需几分钟!” 这篇文章。

Ollama

运行 Llama 3 8B 模型:

ollama run llama3

运行 Llama 3 70B 模型:

ollama run llama3:70b

Open WebUI & Ollama

https://pinokio.computer/item?uri=https://github.com/cocktailpeanutlabs/open-webui。

以上是六年种方式快速体验最新发布的 Llama 3!的详细内容。更多信息请关注PHP中文网其他相关文章!

声明:

本文转载于:51cto.com。如有侵权,请联系admin@php.cn删除