CVPR\'24 | LightDiff:低光照场景下的扩散模型,直接照亮夜晚!

- 王林转载

- 2024-04-15 12:40:121162浏览

原标题:Light the Night: A Multi-Condition Diffusion Framework for Unpaired Low-Light Enhancement in Autonomous Driving

论文链接:https://arxiv.org/pdf/2404.04804.pdf

作者单位:克利夫兰州立大学 德克萨斯大学奥斯汀分校 A*STAR 纽约大学 加州大学洛杉矶分校

论文思路:

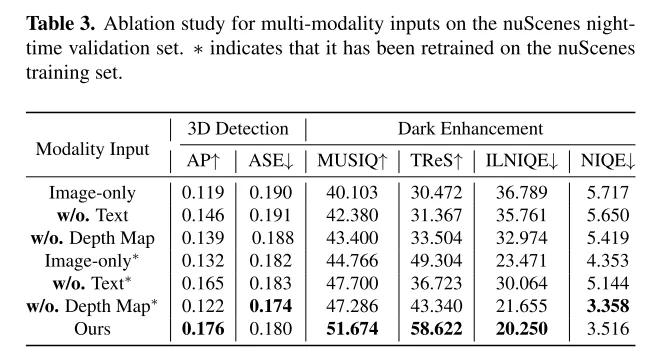

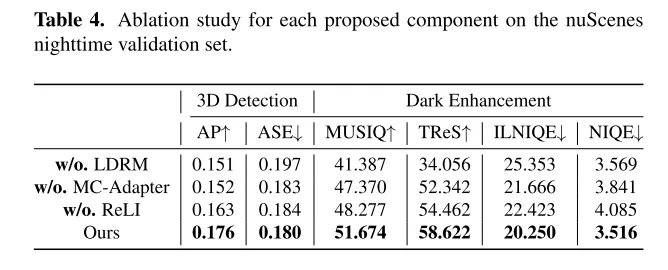

LightDiff 是一种为自动驾驶的视觉中心感知系统提升效益和可扩展性的技术。相比激光雷达系统,最近受到了相当多的关注。然而,这些系统在低光照条件下常常会遇到困难,可能会影响其性能和安全性。为了解决这个问题,本文介绍了 LightDiff,这是一个为自动驾驶应用中提升低光照图像质量而设计的自动化框架。具体来说,本文采用了一个多条件控制的扩散模型。LightDiff 无需人工收集的成对数据,而是利用动态数据退化过程。它结合了一个新颖的多条件适配器,该适配器能够自适应地控制来自不同模态的输入权重,包括深度图、RGB图像和文本标题,以在低光照和光照条件下同时保持内容的一致性。此外,为了使增强型的图像和检测模型的知识相匹配,LightDiff 使用特定于感知的评分作为奖励,通过强化学习指导扩散训练过程。在 nuScenes 数据集上进行的广泛实验表明,LightDiff 能够显著提高多个最新的3D检测器在夜间条件下的性能,并同时实现高视觉质量评分,凸显了其在保障自动驾驶安全方面的潜力。

主要贡献:

本文提出了Lighting Diffusion (LightDiff)模型,以增强自动驾驶中的低光照相机图像,减少了对大量夜间数据收集的需求,并保持了白天的性能能力。

本文整合了包括深度图和图像标题在内的多种输入模式,并提出了一个多条件适配器,以确保图像转换中的语义完整性,同时保持高视觉质量。本文采用了一种实用的过程,从白天数据生成昼夜图像对,以实现高效的模型训练。

本文介绍了一种使用强化学习的微调机制,结合了感知定制的领域知识(可信的激光雷达和统计分布的一致性),以确保扩散过程具有利于人类视觉感知的强度,并利用感知模型进行感知模型。该方法在人类视觉感知方面具有显著优势,同时也具有感知模型的优势。

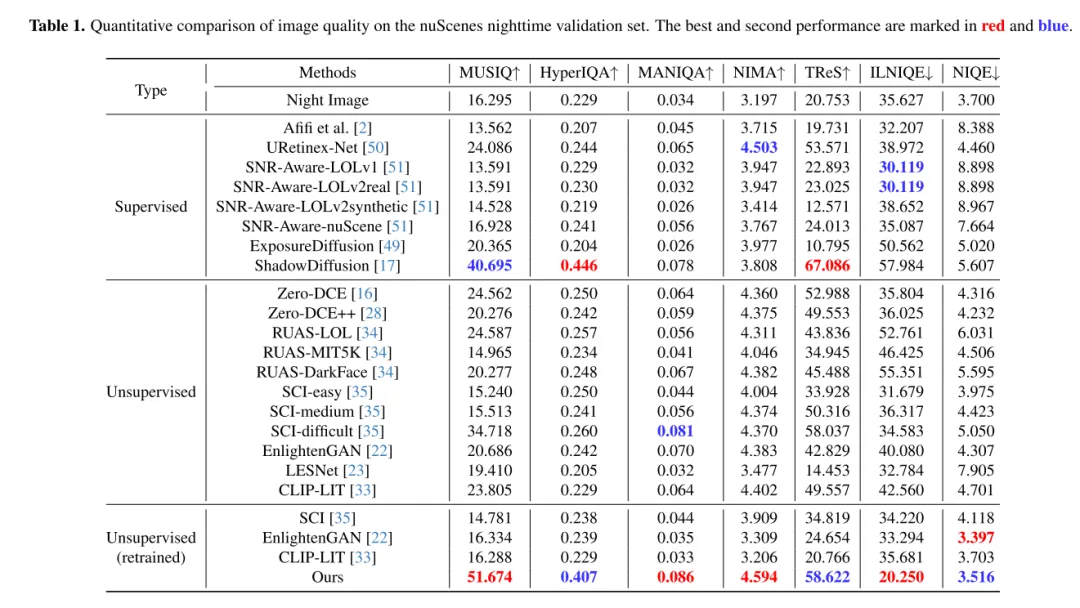

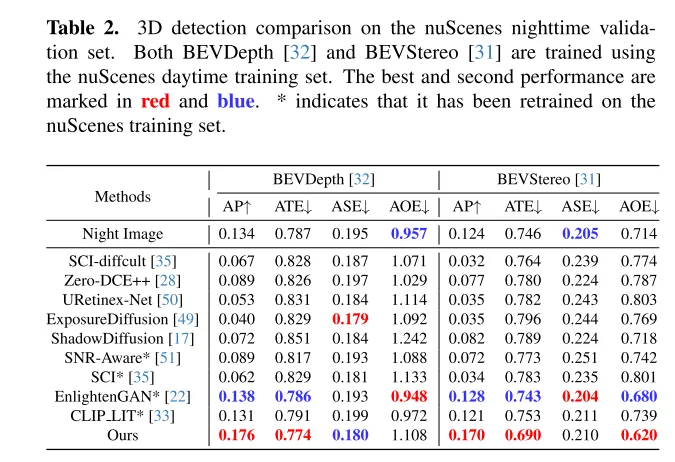

在nuScenes数据集上进行的广泛实验表明,LightDiff 显著提高了夜间3D车辆辆检测的性能,并在多个视角指标上超越了其他生成模型。

网络设计:

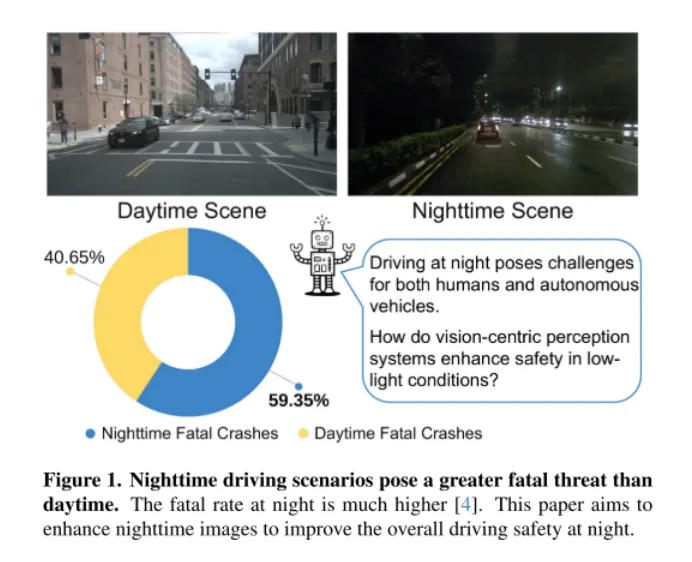

图1。夜间驾驶场景比白天更具有致命威胁。夜间的致命率要高得多[4]。本文旨在增强夜间图像,以提高夜间驾驶的整体安全性。

如图1所示,夜间驾驶对于人类来说是具有挑战性的,对于自动驾驶汽车来说更是如此。2018年3月18日,一起灾难性的事件突显了这一挑战,当时 Uber Advanced Technologies Group 的一辆自动驾驶汽车在亚利桑那州撞击并致死了一名行人[37]。这起事件是由于车辆未能在低光照条件下准确检测到行人而引起的,它将自动驾驶汽车的安全问题推到了前沿,尤其是在这样要求苛刻的环境中。随着以视觉为中心的自动驾驶系统越来越多地依赖于相机传感器,解决低光照条件下的安全隐患已经变得越来越关键,以确保这些车辆的整体安全。

一种直观的解决方案是收集大量的夜间驾驶数据。然而,这种方法不仅劳动密集、成本高昂,而且由于夜间与白天图像分布的差异,还有可能损害白天模型的性能。为了应对这些挑战,本文提出了 Lighting Diffusion (LightDiff )模型,这是一种新颖的方法,它消除了手动数据收集的需求,并保持了白天模型的性能。

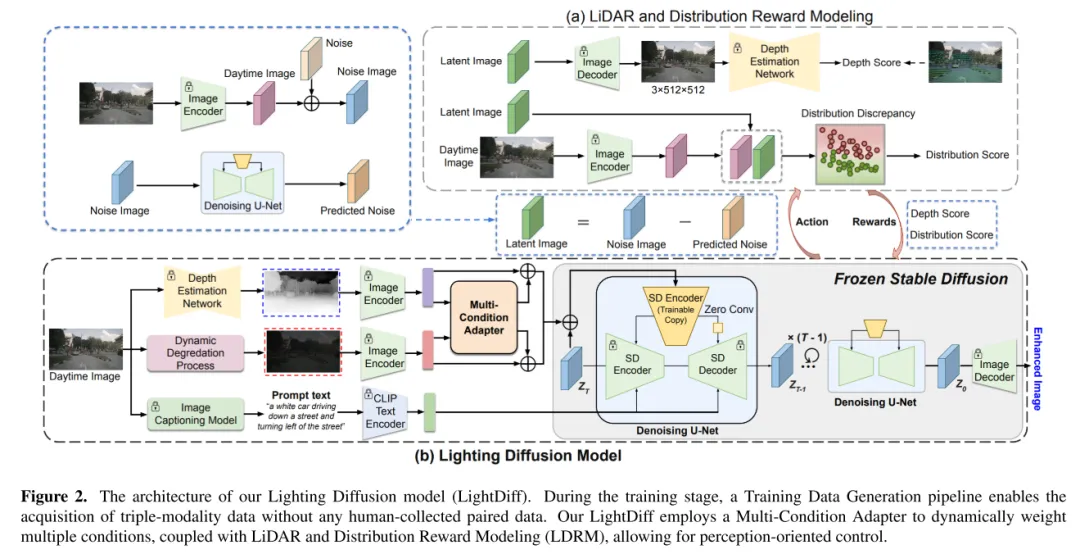

LightDiff 的目标是增强低光照相机图像,提高感知模型的性能。通过使用动态的低光照衰减过程,LightDiff 从现有的白天数据生成合成的昼夜图像对进行训练。接着,本文采用了 Stable Diffusion [44]技术,因为它能够产生高质量的视觉效果,有效地将夜间场景转换成白天的等效物。然而,在自动驾驶中保持语义一致性至关重要,这是原始 Stable Diffusion 模型面临的一个挑战。为了克服这一点,LightDiff 结合了多种输入模态,例如估计的深度图和相机图像标题,配合一个多条件适配器。这个适配器智能地确定每种输入模态的权重,确保转换图像的语义完整性,同时保持高视觉质量。为了引导扩散过程不仅朝着对人类视觉更亮的方向,而且对感知模型也是如此,本文进一步使用强化学习对本文的 LightDiff 进行微调,循环中加入了为感知量身定制的领域知识。本文在自动驾驶数据集nuScenes [7]上进行了广泛的实验,并证明了本文的 LightDiff 可以显著提高夜间3D车辆检测的平均精度(AP),分别为两个最先进模型BEVDepth [32]和BEVStereo [31]提高了4.2%和4.6%。

图2. 本文的 Lighting Diffusion 模型(LightDiff )的架构。在训练阶段,一个训练数据生成流程使得无需任何人工收集的配对数据就能获取三模态数据。本文的 LightDiff 使用了一个多条件适配器来动态加权多种条件,结合激光雷达和分布奖励建模(LDRM),允许以感知为导向的控制。

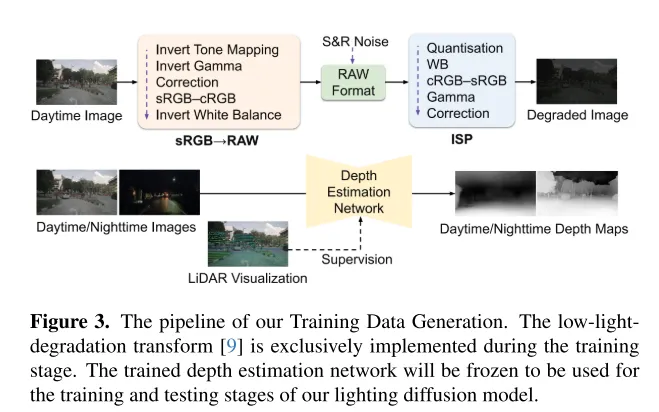

图3. 本文的训练数据生成流程。低光照退化转换[9]仅在训练阶段实施。训练好的深度估计网络将被冻结,用于本文 Lighting Diffusion 模型的训练和测试阶段。

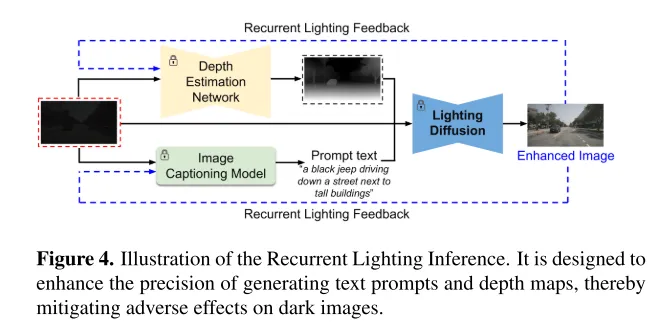

图4. 循环照明推理(Recurrent Lighting Inference)的示意图。其设计旨在提高生成文本提示和深度图的精确度,从而减轻对暗图像的不利影响。

实验结果:

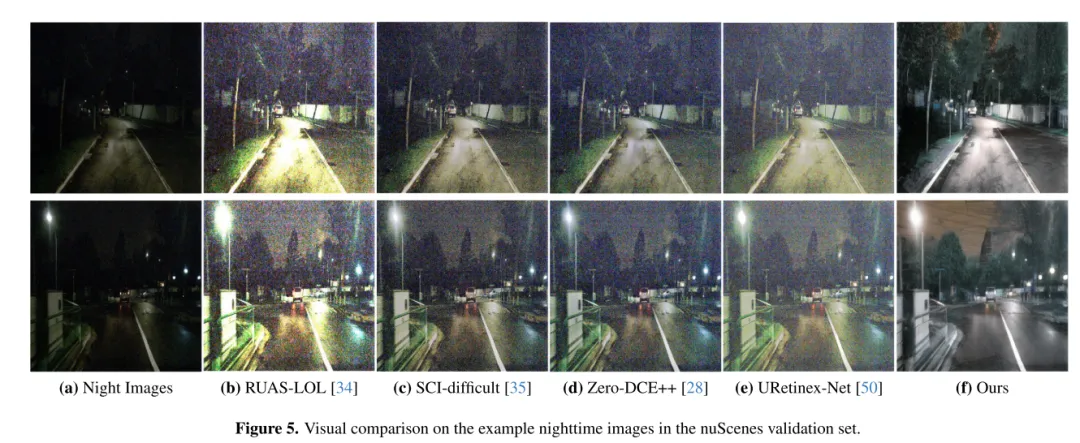

图5. 在 nuScenes 验证集中的夜间图像示例上的视觉对比。

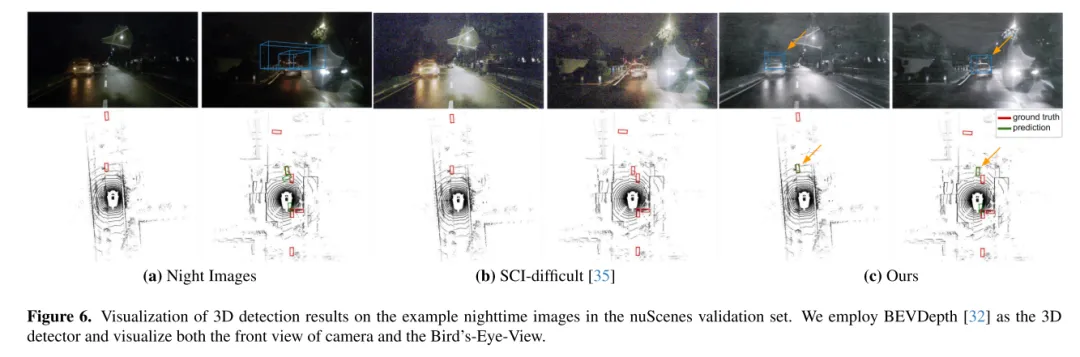

图6. 在 nuScenes 验证集中的夜间图像示例上的三维检测结果可视化。本文使用 BEVDepth [32] 作为三维检测器,并可视化相机的正视图和鸟瞰图(Bird’s-Eye-View)。

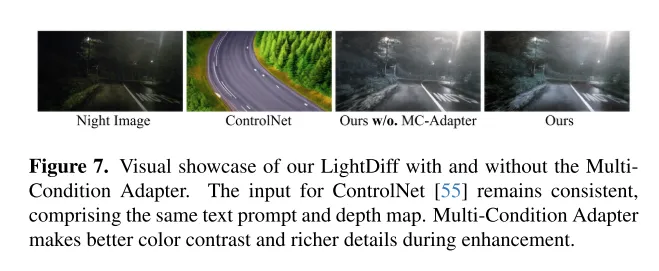

图7. 展示本文的 LightDiff 在有无多条件适配器(MultiCondition Adapter)的情况下的视觉效果。ControlNet [55]的输入保持一致,包括相同的文本提示和深度图。多条件适配器在增强过程中实现了更好的颜色对比和更丰富的细节。

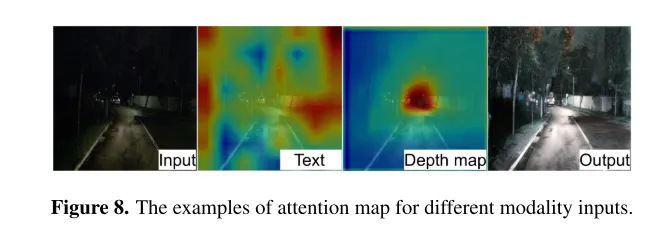

图8. 不同模态输入的注意力图示例。

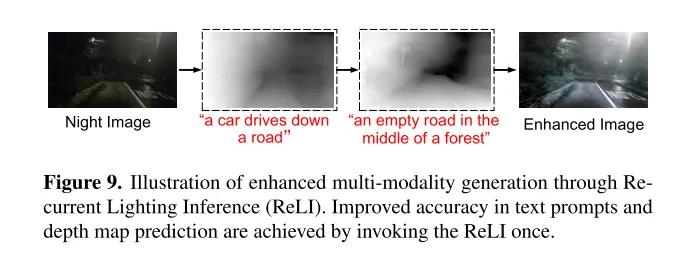

图9. 通过循环照明推理(Recurrent Lighting Inference, ReLI)增强多模态生成的示意图。通过调用一次 ReLI,提高了文本提示和深度图预测的准确性。

总结:

本文介绍了LightDiff ,这是一个为自动驾驶应用设计的、针对特定领域的框架,旨在提高低光照环境下图像的质量,减轻以视觉为中心的感知系统所面临的挑战。通过利用动态数据退化过程(dynamic data degradation process)、针对不同输入模态的多条件适配器,以及使用强化学习的感知特定评分引导奖励建模,LightDiff 显着提升了nuScenes 数据集夜间的图像质量和3D车辆检测性能。这一创新不仅消除了对大量夜间数据的需求,还确保了图像转换中的语义完整性,展示了其在提高自动驾驶场景中的安全性和可靠性方面的潜力。在没有现实的成对昼夜图像的情况下,合成带有车灯的暗淡驾驶图像是相当困难的,这限制了该领域的研究。未来的研究可以集中在更好地收集或生成高质量训练数据上。

引用:

@ARTICLE{2024arXiv240404804L,

author = {{Li}, Jinlong and {Li}, Baolu and {Tu}, Zhengzhong and { Liu}, Xinyu and {Guo}, Qing and {Juefei-Xu}, Felix and {Xu}, Runsheng and {Yu}, Hongkai},

title = "{Light the Night: A Multi-Condition Diffusion Framework for Unpaired Low-Light Enhancement in Autonomous Driving}",

journal = {arXiv e-prints},

keywords = {Computer Science - Computer Vision and Pattern Recognition},

year = 2024,

month = apr,

eid = {arXiv:2404.04804},

pages = {arXiv:2404.04804},

doi = {10.48550/arXiv.2404.04804},

archivePrefix = {arXiv},

eprint = {2404.04804},

primaryClass = {cs.CV},

adsurl = {https://ui.adsabs.harvard.edu/abs/2024arXiv240404804L},

adsnote = {Provided by the SAO /NASA Astrophysics Data System}

}

以上是CVPR\'24 | LightDiff:低光照场景下的扩散模型,直接照亮夜晚!的详细内容。更多信息请关注PHP中文网其他相关文章!