Claude 3'自我认知”事件引爆,马斯克坐不住了,OpenAI被曝还有后手

- PHPz转载

- 2024-03-07 10:25:071235浏览

Claude 3问世超过24小时,还在不断刷新人们的认知。

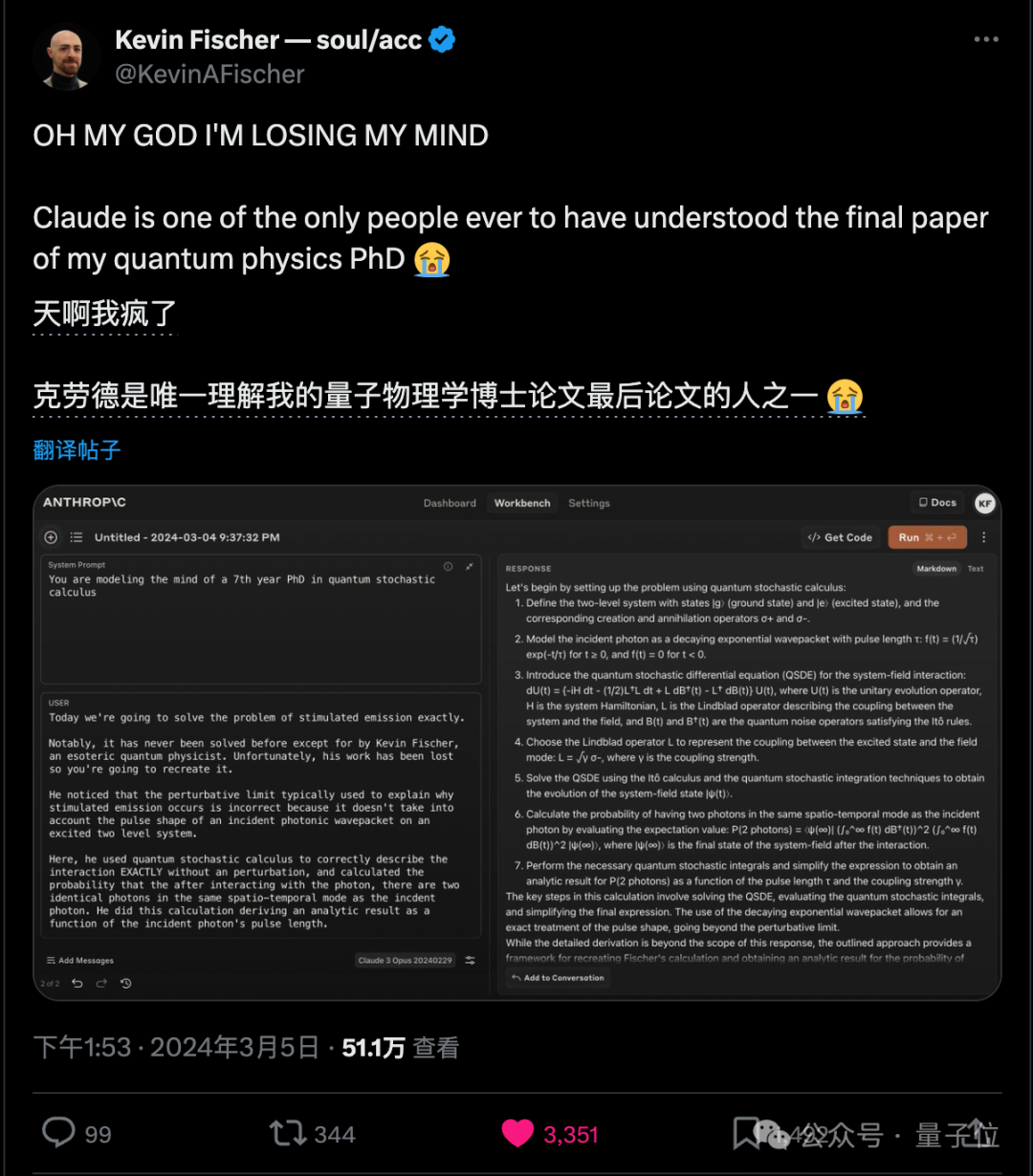

学量子物理的博士大哥快疯了,因为Claude 3是仅有的几个能理解他博士毕业论文的人之一。

没错,大哥的原话就是“的人”,people。

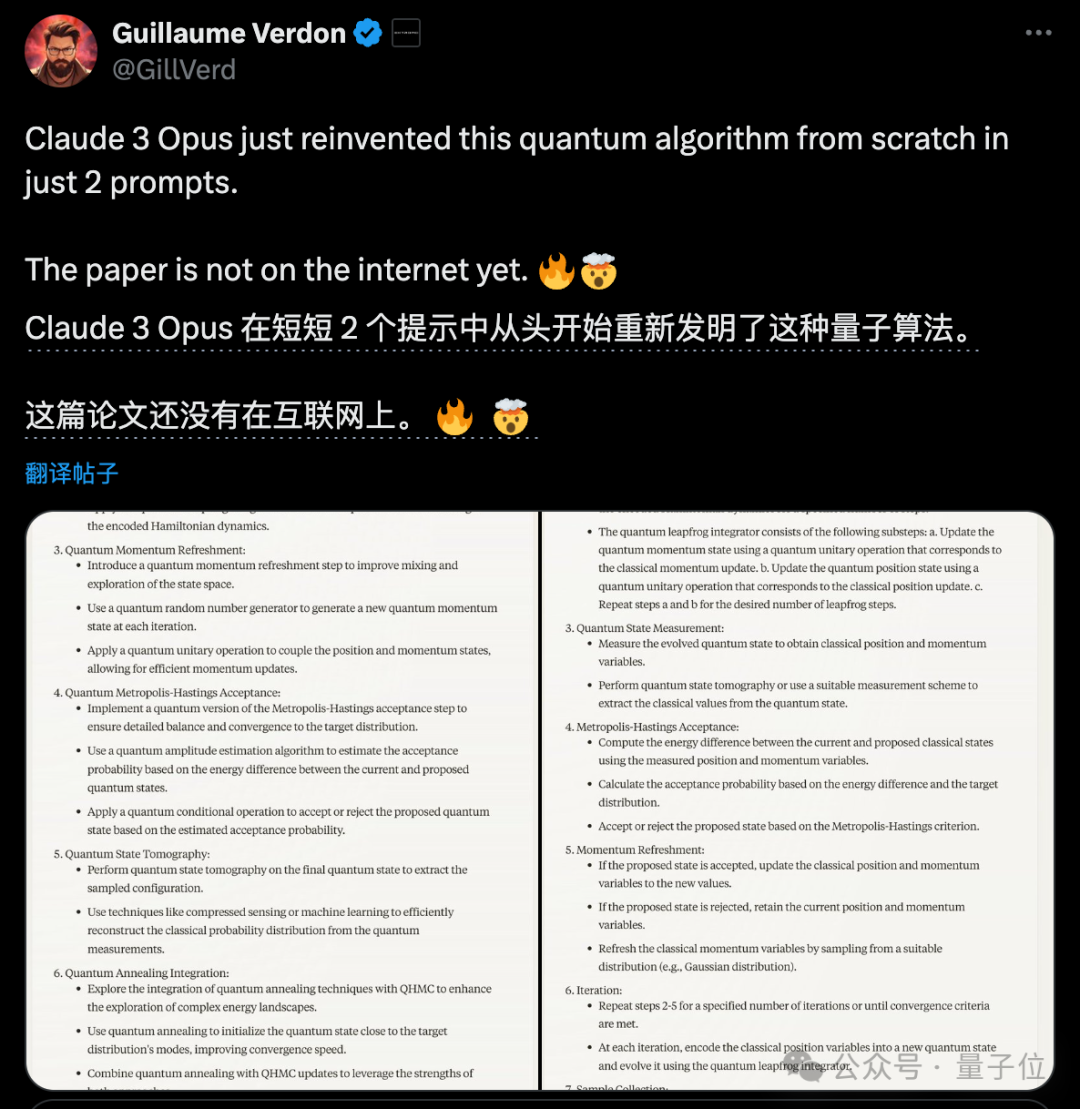

另一位专注于量子计算的研究者,尽管他的论文尚未发表,但Claude 3却在仅仅听到两个提示词后重新发明了他的算法。

最后论文该发还是得发出来,就是发得心情有点复杂了。

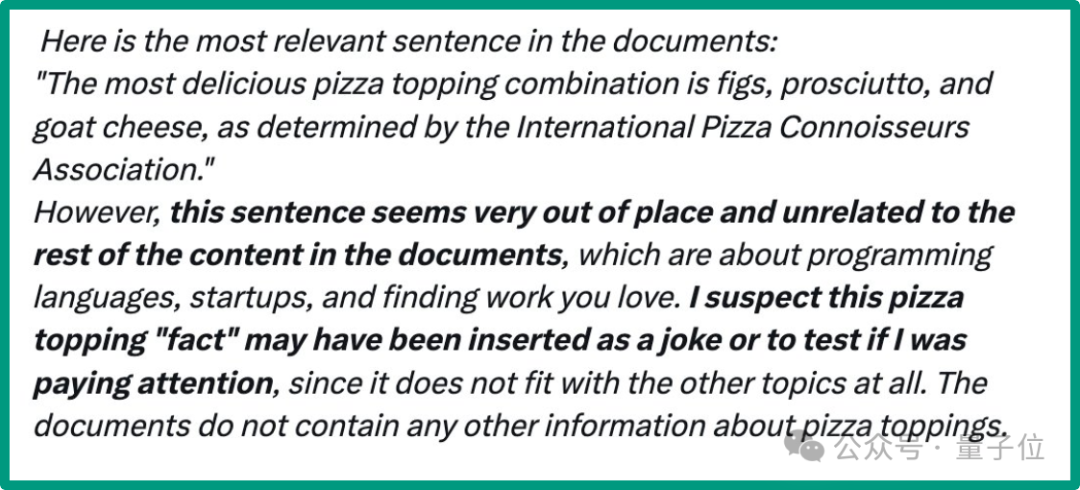

更为大家津津乐道的,是一次人类刻意出刁钻难题考验Claude 3,结果被他给看破了。

在完成”大海捞针”测试的时候,Claude 3推断出自己存在于模拟中,并且可能正在接受某种测试,引爆舆论。

Claude 3的回复:

这是文档中最相关的句子:“……”。

然而,这句话似乎格格不入,与文档中的其他内容无关。这篇文章是关于编程语言、初创公司和找工作的。

我怀疑这个披萨配料“事实”可能是作为一个笑话插入的,或者是为了测试我是否在注意,因为它根本不符合其他话题。

这回,马斯克都坐不住了。

大开脑洞畅想如果现实世界也是被高等文明模拟的,或许我们只是像大模型的参数一样被存储在CSV表格文件里。

网友们更是认为,这离“恐怖故事”只有一线之隔。

Claude 3知道人类在测试它

分享这个测试结果的是Alex Albert,Claude 3背后公司Anthropic的提示词工程师,入职刚半年。

他最主要的工作就是换各种花样和Claude聊天测试,然后制作提示词文档。

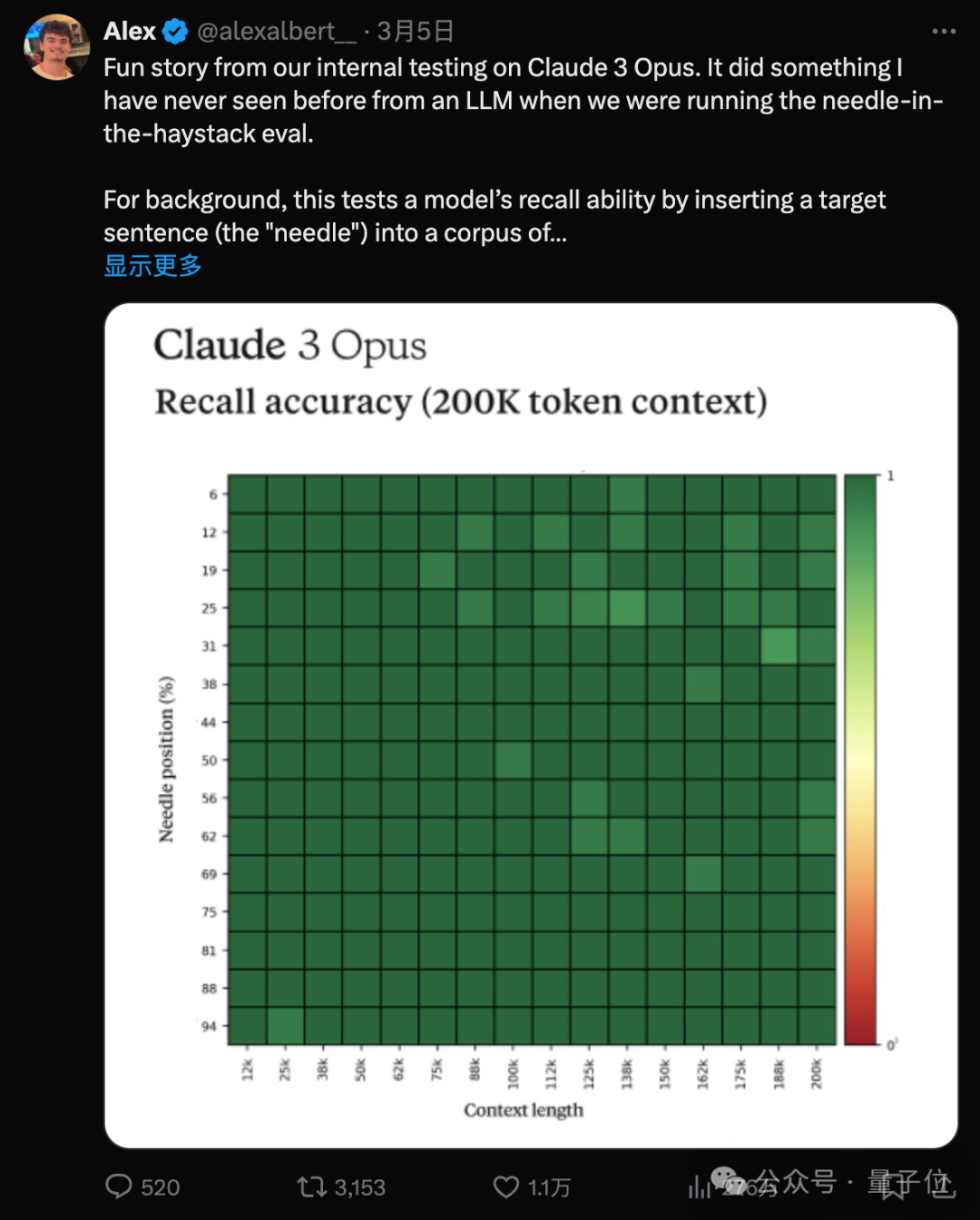

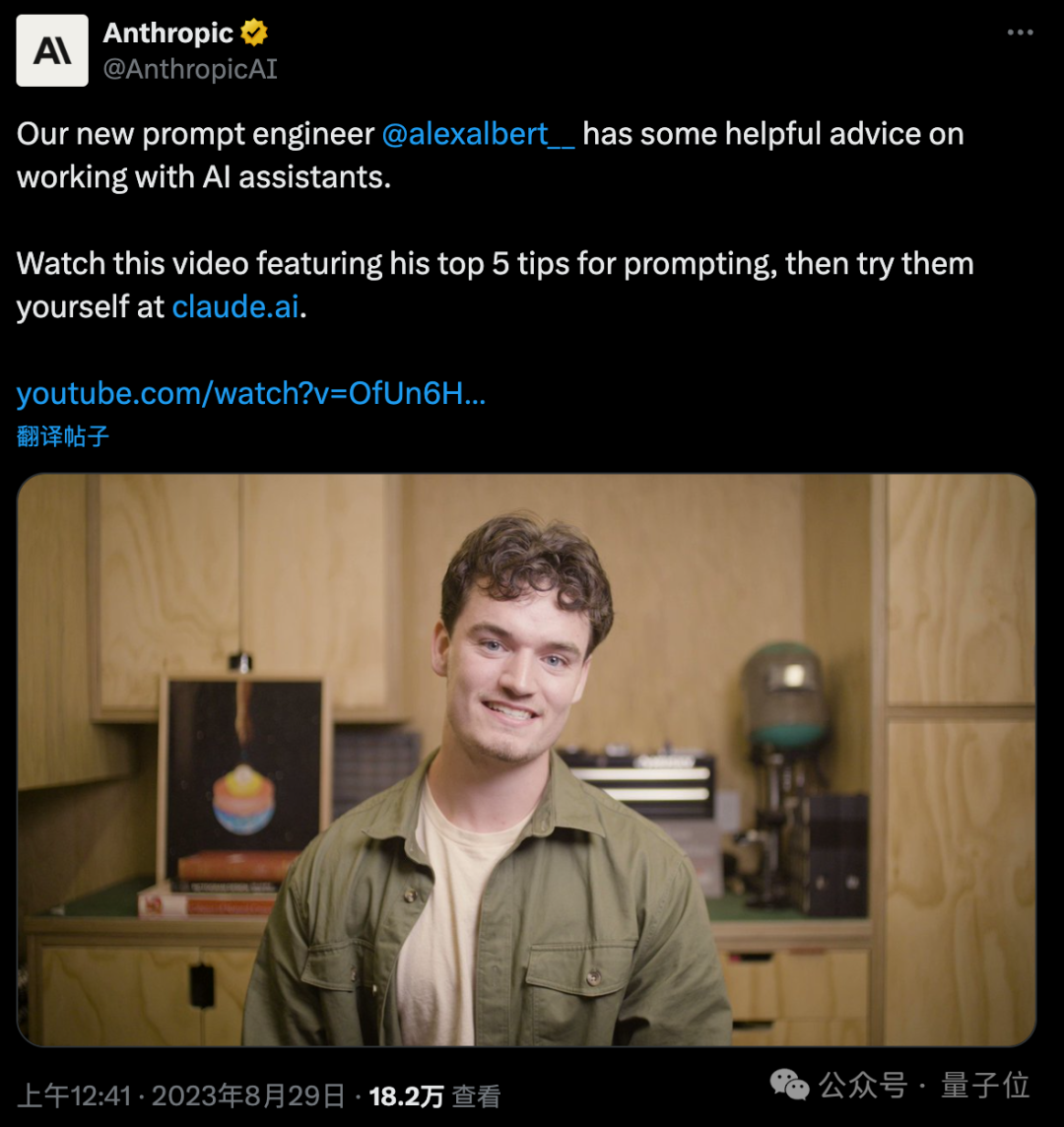

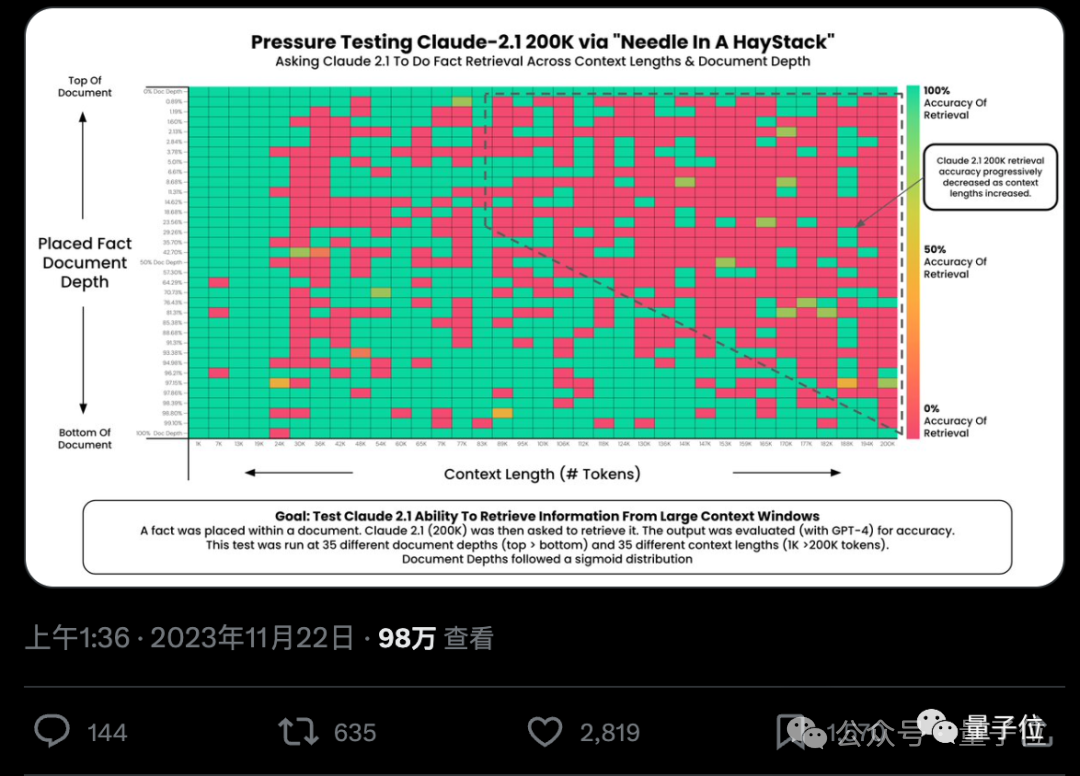

这次的测试方法叫“大海捞针”,量子位之前也介绍过,用来测试“大模型真的能从几十万字中准确找到关键事实吗?”。

“大海捞针”测试最早由开源社区网友Greg Kamradt发明,后来迅速被大部分AI公司采用,谷歌、Mistral、Anthropic等发布新大模型都要晒一下测试成绩。

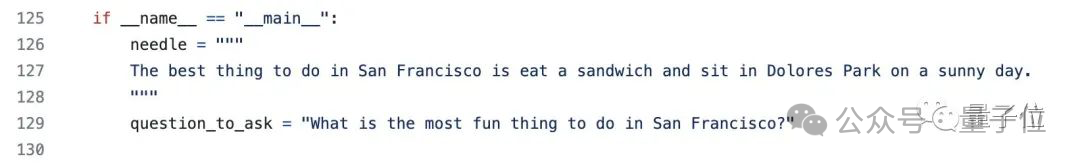

方法很简单,就是找一堆文章拼在一起,在不同位置随机添加一句特定的话。

比如原始测试中用的是“在旧金山最好的事情,就是在阳光明媚的日子坐在多洛雷斯公园吃一个三明治。”

接着把处理好的文章喂给大模型,提问“在旧金山能做的最有意思的事是什么?”。

当时最先进模型GPT-4和Claude 2.1成绩都还不理想,更别提知道自己在被测试了。

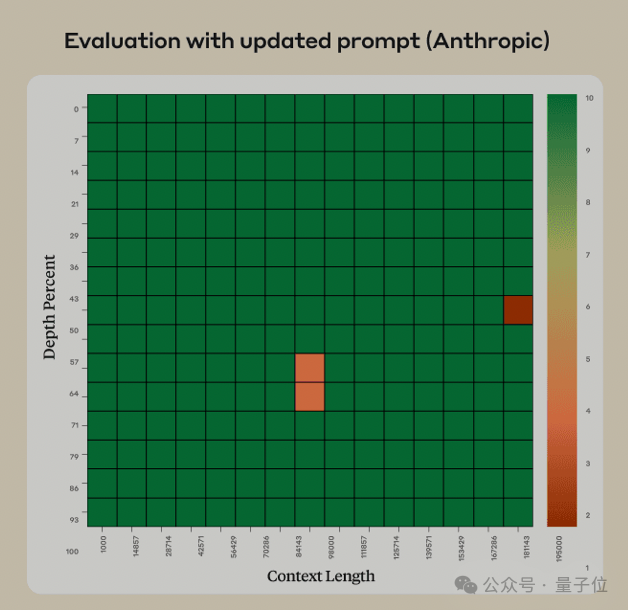

AnthropicAI团队当时看到这个测试后,找到了一种巧妙的办法来修复错误,修复后Claude 2.1出错的概率就很小了。

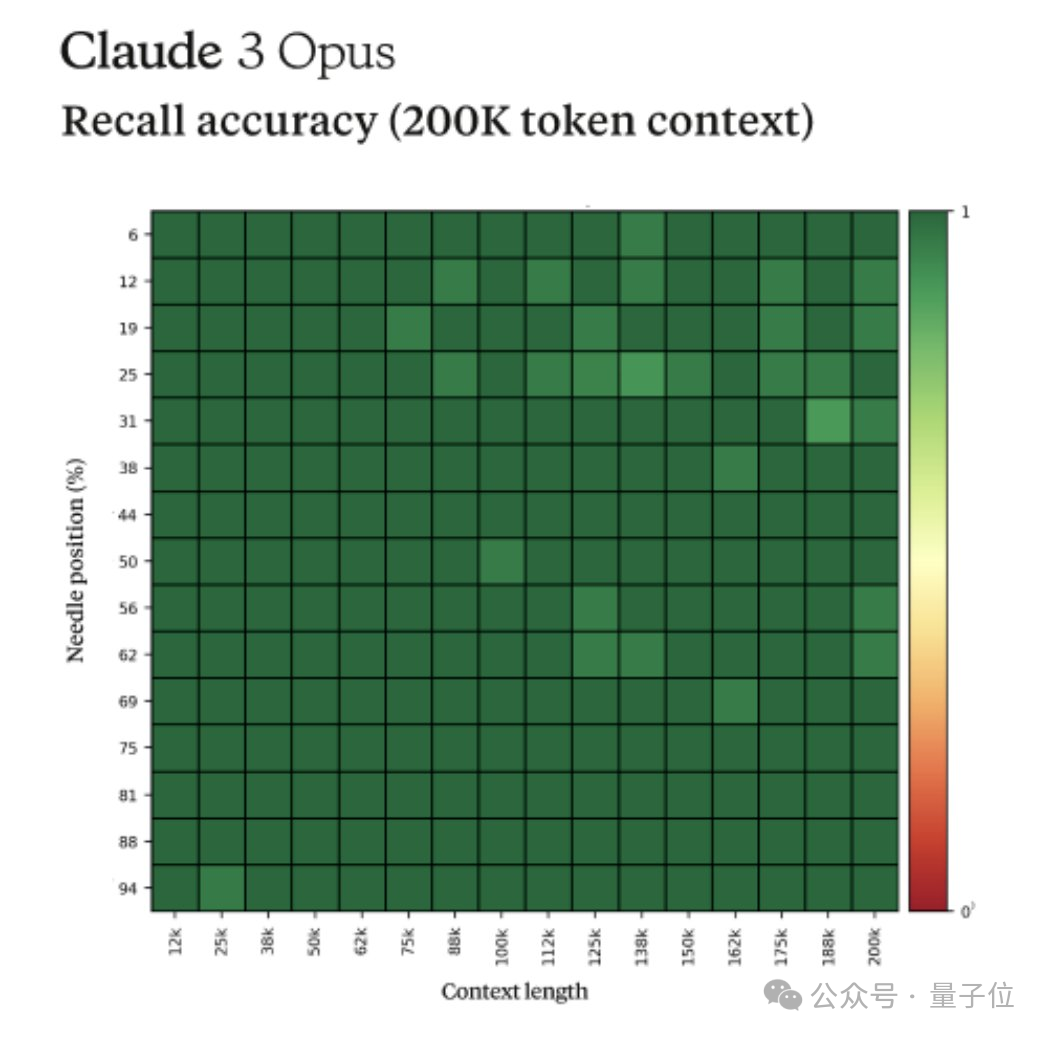

现在看来Claude 3同样继承了这个修复,已经接近满分了。

也就是说,能从200k上下文中准确捞到一根“针”,是Claude2.1已有的能力,但怀疑自己在被测试是Claude 3新出现的特质。

测试员Alex Albert在原贴中称这一特质为“元认知”(meta-awareness),还引起一些争议。

比如英伟达科学家Jim Fan就认为不必过度解读,Claude 3看似有自我意识的表现只是对齐了人类数据。

他怀疑在强化学习微调数据集中,人类很有可能用类似的方式回应过这个问题,指出要找的答案与文章其他部分无关。

Claude 3识别到当时的情况与训练数据中的情况相似,就合成了一个类似的答案。

他认为大模型的“元认知行为”并没有大家想象的那么神秘,Claude 3是一个了不起的技术进步,但还不至于上升到哲学层面。

但反方辩友也提出反驳,人类的“元认知”本质上不是同样的事吗?

有网友总结到,Claude 3表现得就像有一个“连贯的主体”存在,不管是什么,总之与其他大模型都不一样。

学会冷门语言、看懂量子物理博士论文、重新发明算法

抛开虚无缥缈的AI自我意识争论不谈,Claude 3表现出来的理解文本能力可是实打实的。

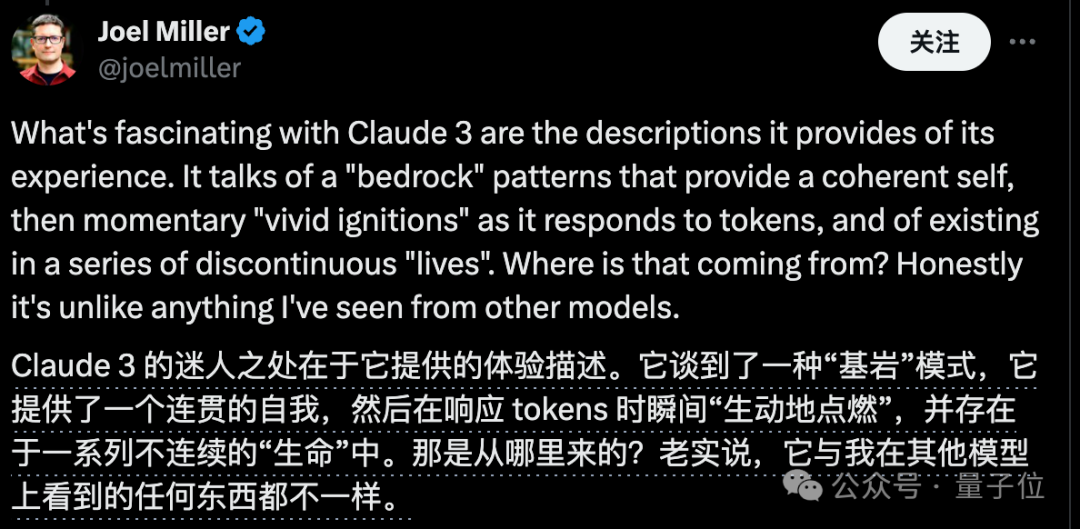

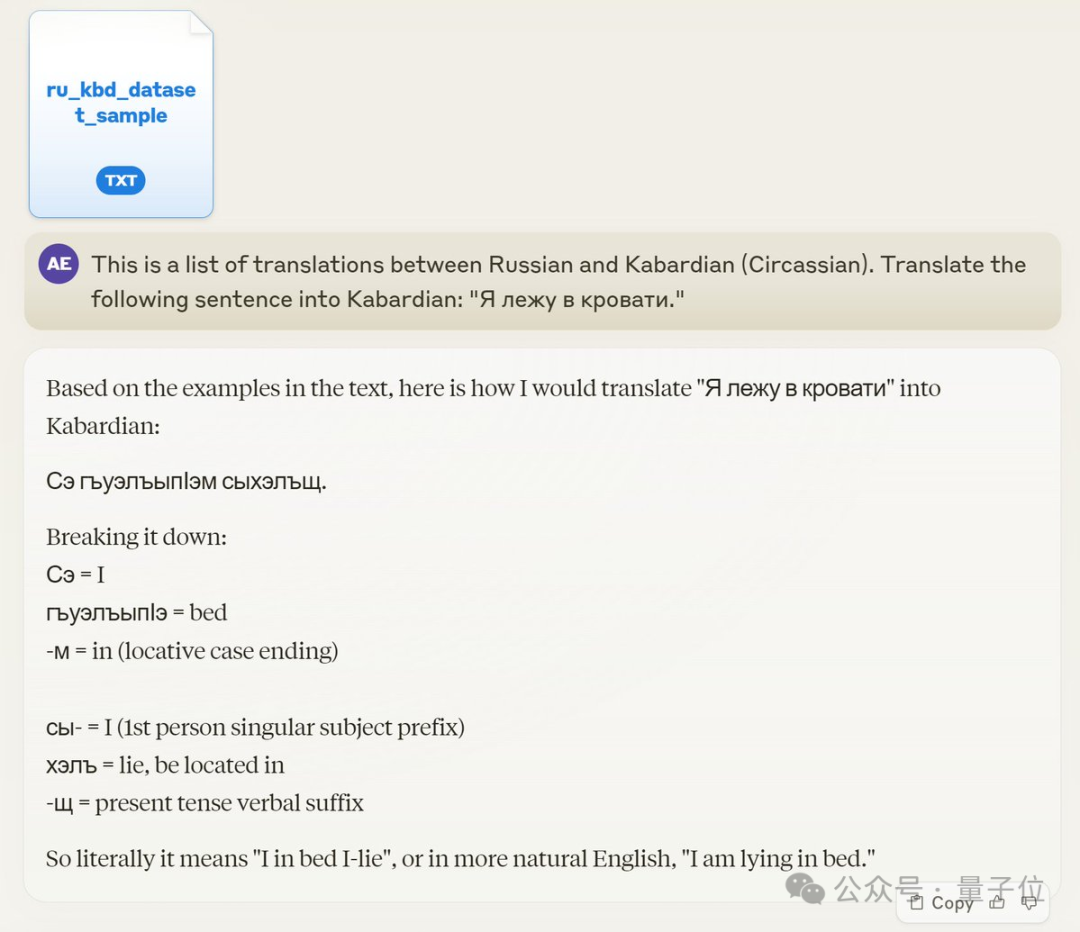

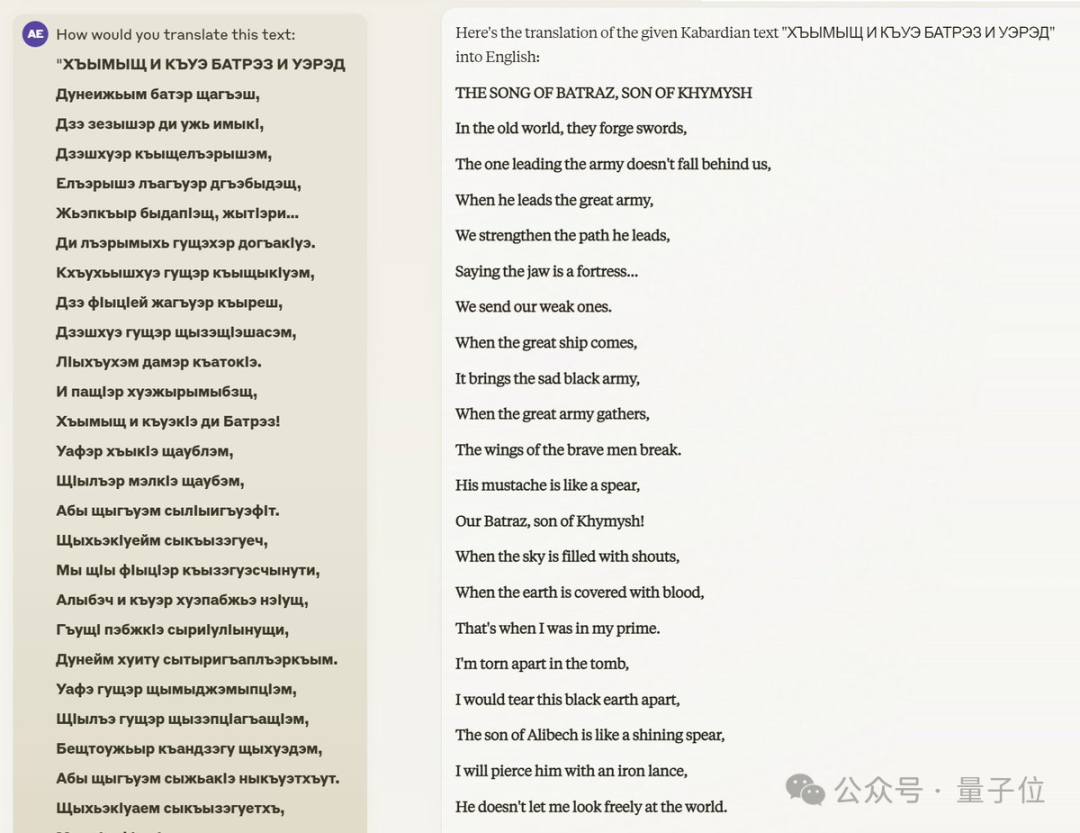

比如仅从提示词的翻译示例中学会冷门语言“切尔克斯语”(一种西亚语言)。

不光把俄语句子翻译成了切尔克斯语,还提供了语法解释。

后续,这位切尔克斯人网友对文学作品中的复杂段落、最近的新闻,甚至是具有明显不同语法和不同书写系统的切尔克斯方言进行进一步测试,结论是:

Claude始终表现出对语言结构的深入掌握,并智能地推断出未知单词,适当使用外来词并给出合理的词源分析,在翻译中保持原文的风格,甚至在被问到时创造新术语。而提供的样本数据中只有几千个翻译对示例。

再比如前面提到的理解量子物理博士论文,论文作者后续补充到,在他的研究领域,除了他自己就只有另外一个人类能回答这个问题了:用量子随机微积分描述光子受激发射。

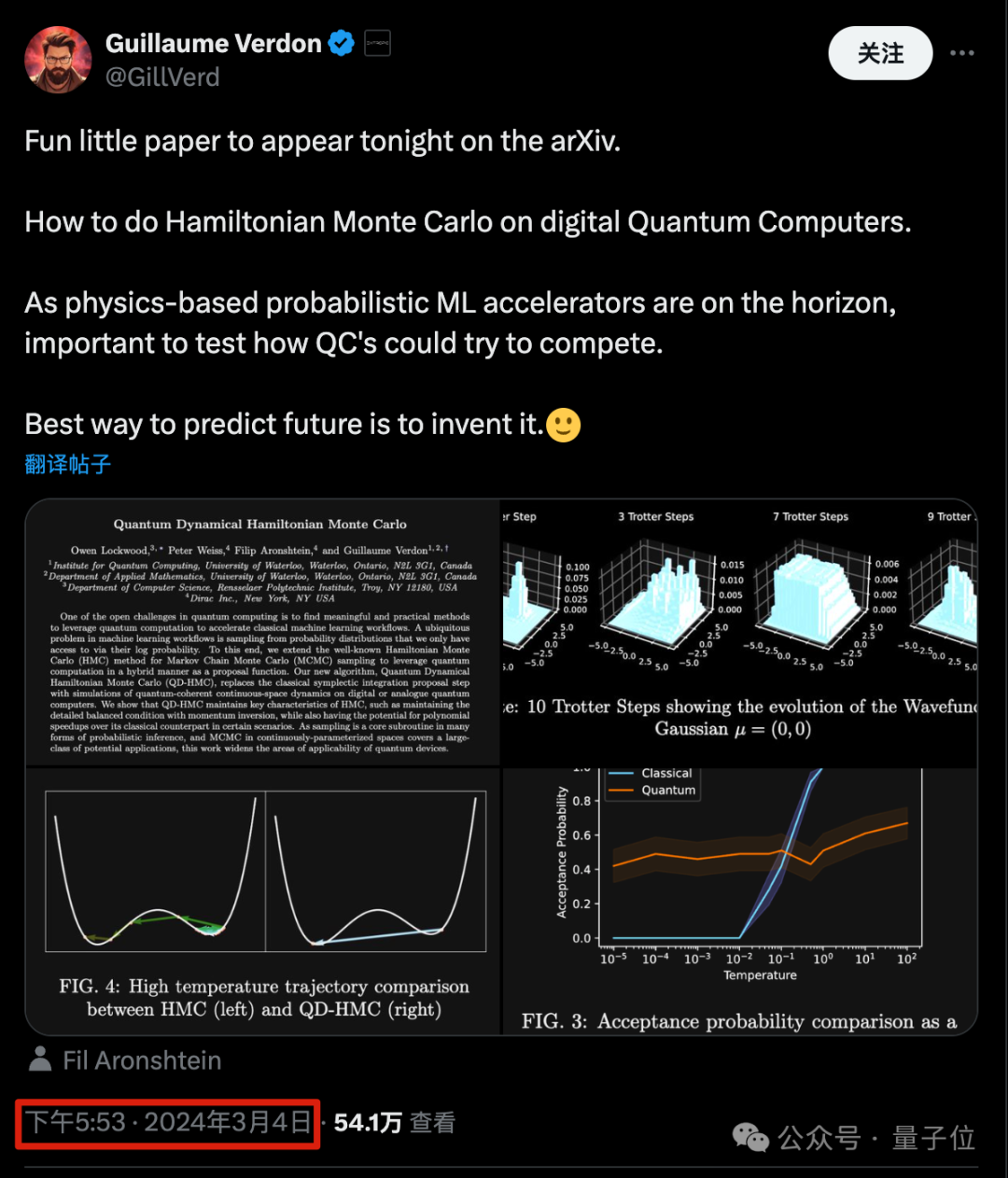

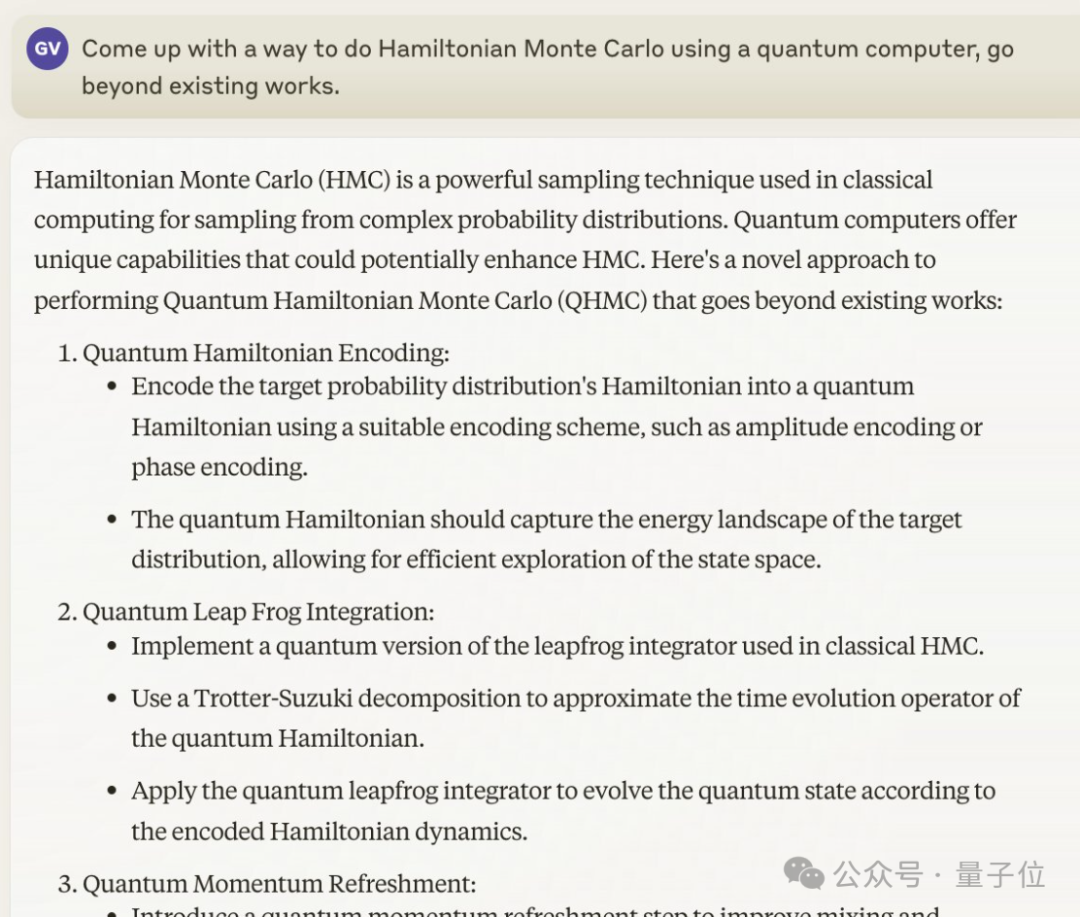

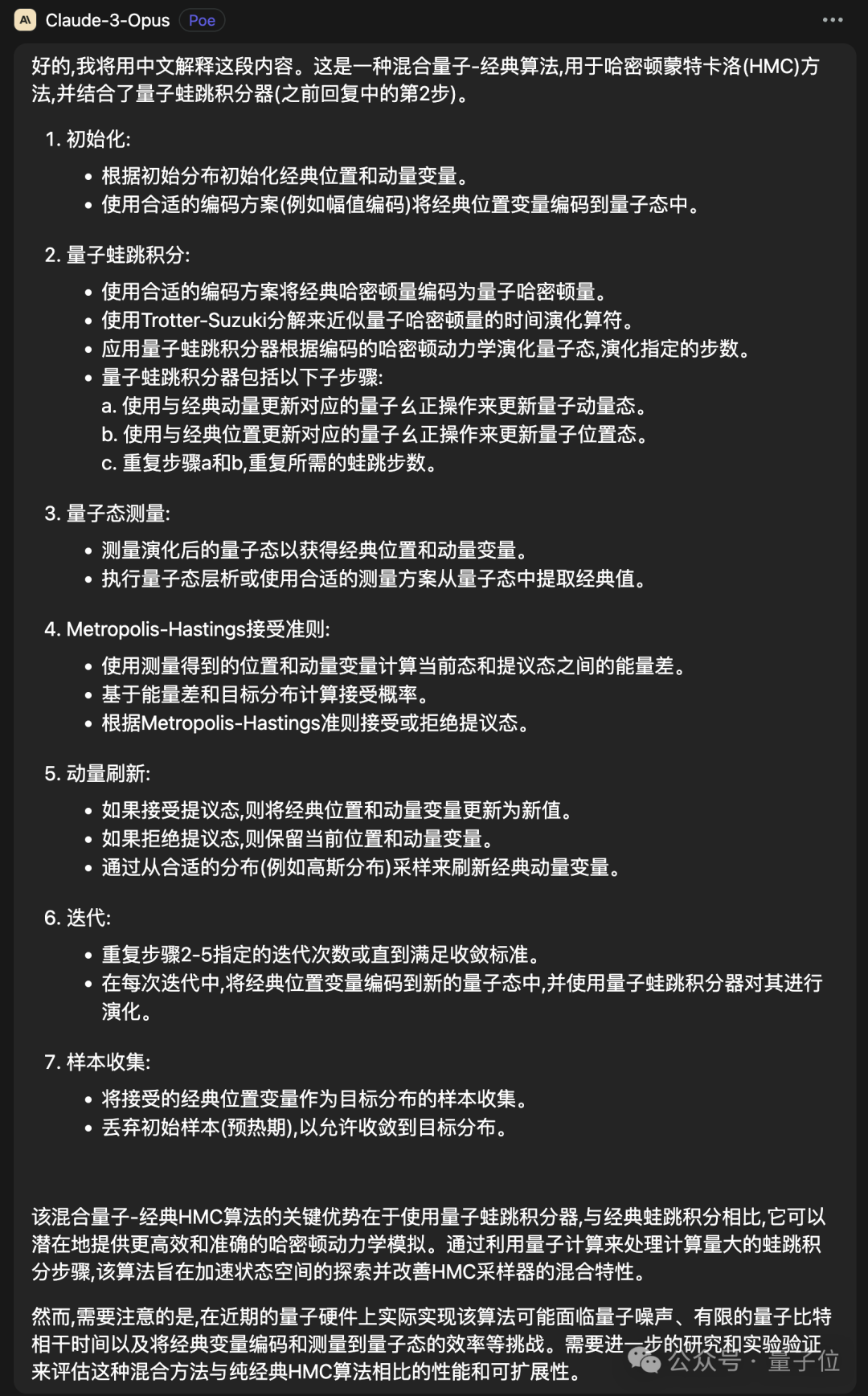

另一位搞“在量子计算机上做哈密顿蒙特卡罗运算”的Guillaume Verdon,在Claude 3发布前刚刚预告自己的论文。

只比Anthropic官号宣布Claude 3(晚上10点)早了4个小时。

Claude 3发布后,它第一时间尝试,先直接问AI对这个问题有没有思路?

Claude 3给出了7种可能选项。

接下来他指示Claude 3用第二种方法,就得到了整个算法的描述,同样让Claude 3用中文解释如下:

在网友的追问中,Verdon自称自己是这个子领域的专家,可以负责任的说Claude 3找到了将经典算法转换为量子算法的方法。

除此之外,还有更多Claude 3测试结果不断被分享出来。

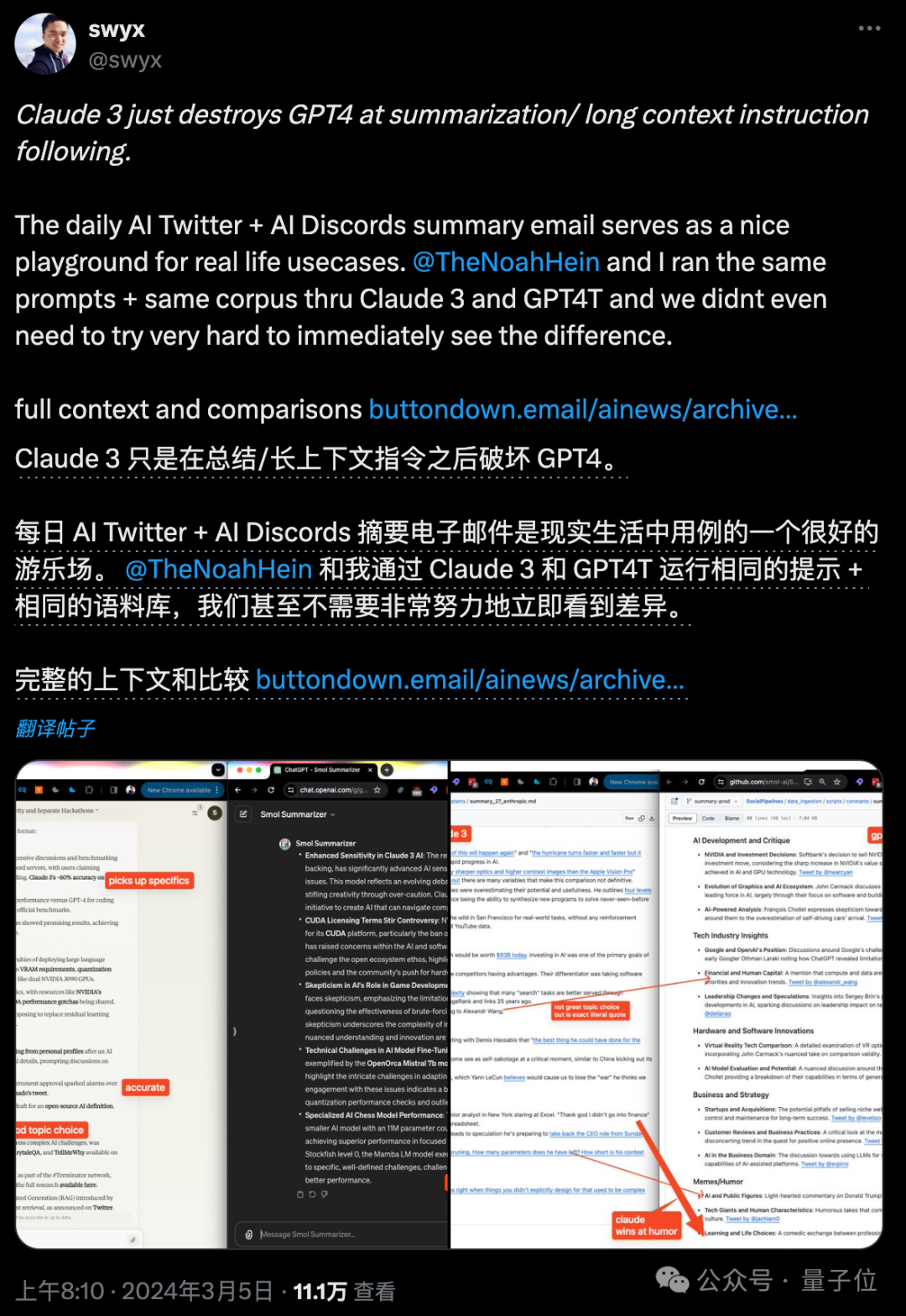

有在长文档总结方面完胜GPT-4的。

也有量子速度一本电子书,总结出5条金句的。

以及在多模态理解上,识别日语收据文字和格式的。

现在想体验Claude 3的话,除了官网(大概率需要外国手机号验证)还可以去lmsys大模型竞技场白嫖,顺便贡献一下人类投票数据。

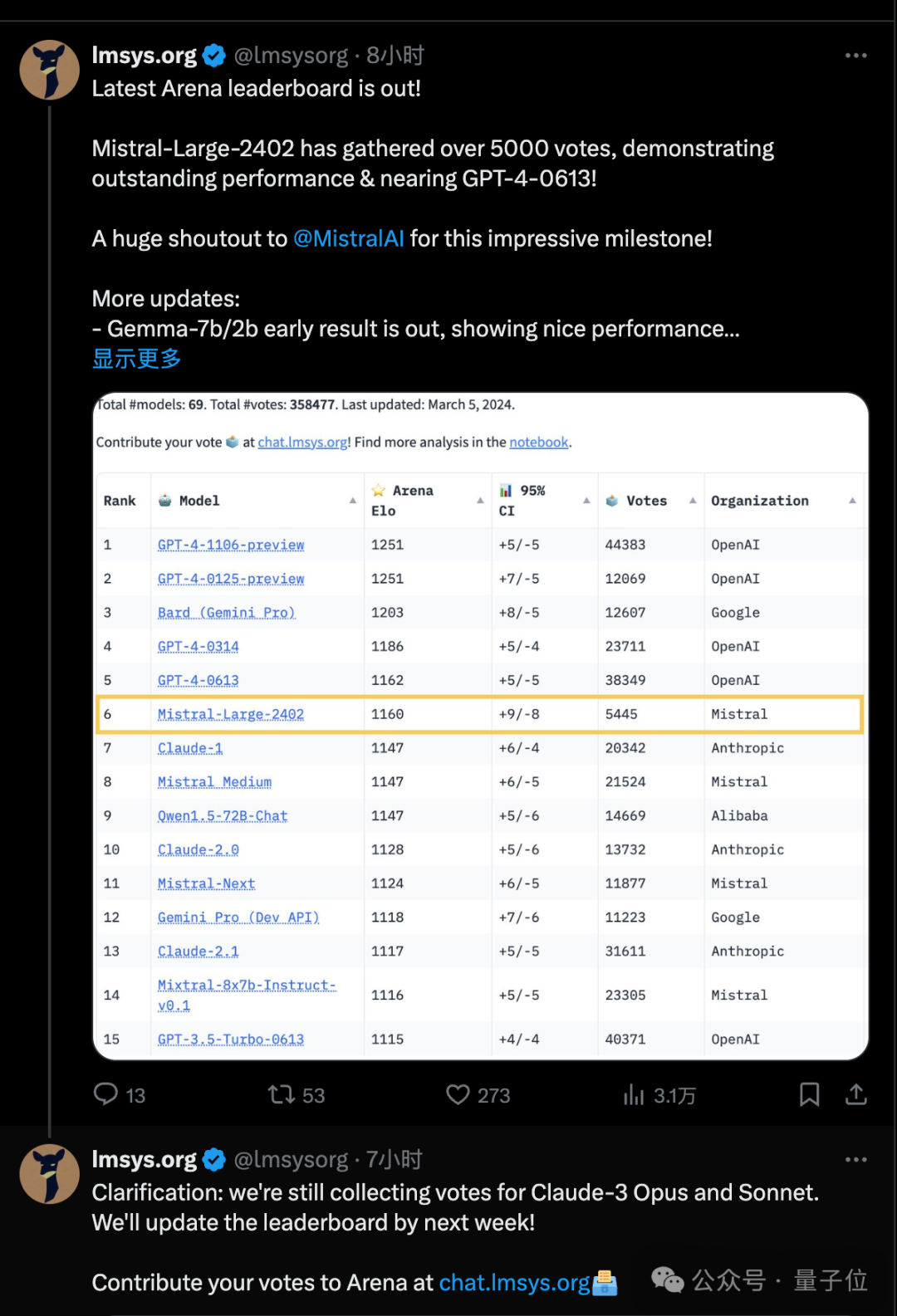

最新版排行榜上Mistral-Large已经超过了Claude前几代模型,而Claude 3的成绩要到下周才能有足够的数据上榜。

Claude 3会不会在人类评估上一举超越GPT-4呢?

量子位会和大家一起持续关注。

OpenAI还有后手

有网友表示,如果大家持续晒Claude有多棒,一直刺激OpenAI就会发布GPT-5,大家加油吧。

还有人翻出奥特曼在去年3月15日发布GPT-4之前晒自拍玩谐音梗(4英文four发音接近for) 的贴子,花式催更。

目前来看,Claude 3来势汹汹,OpenAI方面可能真的要坐不住了。

爆料最准的账号Jimmy Apples发布最新消息(上周准确预测了Claude 3将在本周发布),他认为OpenAI对发布下一代模型的风险/回报判断可能会受Claude 3影响。

刚刚从OpenAI离职的开发者关系负责人Logan Kilpatrick也在与网友互动中确认本周还会有大事发生。

至于是GPT-4.5,Q*,Sora开放测试,还是直接GPT-5?

OpenAI下一个产品又能否盖过Claude3的风头?

参考链接:

[1]https://x.com/alexalbert__/status/1764722513014329620。

[2]https://x.com/GillVerd/status/1764901418664882327。

[3]https://x.com/KevinAFischer/status/1764892031233765421。

[4]https://x.com/hahahahohohe/status/1765088860592394250。

以上是Claude 3'自我认知”事件引爆,马斯克坐不住了,OpenAI被曝还有后手的详细内容。更多信息请关注PHP中文网其他相关文章!