深度神经网络是一种强大的机器学习模型,它能自动学习特征和模式。然而,在实际应用中,神经网络的输出往往需要进行校准,以提高性能和可靠性。分类校准和回归校准是常用的校准技术,它们具有不同的原理和应用。本文将详细介绍这两种技术的工作原理和应用场景。

一、分类校准

分类校准是为了提高分类器的可靠性和准确性,通过调整分类器输出的概率分布向量来实现。在分类问题中,神经网络会输出一个表示每个类别预测概率的向量。然而,这些概率并不总是准确的,可能存在过高或过低的偏差。分类校准的目标是通过对这些概率进行调整,使其更加接近真实的概率分布。这样可以提高分类器的性能,使其更加可靠地预测不同类别的概率。

常用的分类校准方法包括以下两种:

1.温度缩放(Temperature scaling)

温度缩放是一种简单有效的分类校准技术,其原理是通过对神经网络的输出进行缩放,从而调整分类器的置信度。具体而言,温度缩放通过引入一个温度参数T,对神经网络的最后一层输出进行缩放,将原始的预测概率p转化为校准后的概率q:

q_i=\frac{p_i^{\frac{1}{T}}}{\sum_{j=1}^K p_j^{\frac{1}{T}}}其中,i表示第i个类别,K表示总共的类别数。当T=1时,温度缩放不会改变原始的预测概率,当T>1时,温度缩放会增加分类器的置信度,使得预测概率更加集中和自信;当T<1时,温度缩放会降低分类器的置信度,使得预测概率更加分散和谨慎。

温度缩放的优点在于简单易实现,成本低廉,而且可以在不重新训练模型的情况下进行校准。然而,温度缩放并不能保证在所有情况下都能够有效提高分类器的性能,因为其假设了所有类别的误差是独立且在同一尺度上的,这在实际应用中不一定成立。

2.Platt校准(Platt scaling)

Platt校准是一种比较传统的分类校准方法,其原理是基于逻辑回归模型,对神经网络的输出进行拟合,得到校准后的概率分布。具体而言,Platt校准通过引入一个二元逻辑回归模型,对神经网络的输出进行拟合,得到一个新的概率分布。逻辑回归模型的输入是神经网络的输出或者特征,输出是一个0到1之间的概率值。通过拟合逻辑回归模型,可以得到每个类别的校正后概率值。

Platt校准的优点在于能够更加准确地估计预测概率,适用于各种不同的分类问题。然而,Platt校准需要进行模型拟合,因此计算成本较高,同时需要大量的标记数据来训练逻辑回归模型。

二、回归校准

回归校准是指通过对回归模型的输出进行修正,使其更加可靠和准确。在回归问题中,神经网络的输出通常是一个连续的实数值,表示预测目标变量的值。然而,这些预测值可能存在偏差或方差,需要进行回归校准来提高预测的准确性和可靠性。

常用的回归校准方法包括以下两种:

1.历史平均校准(Historical Average Calibration)

历史平均校准是一种简单有效的回归校准技术,其原理是通过使用历史数据,计算出目标变量的平均值和方差,然后对神经网络的预测值进行调整。具体而言,历史平均校准通过计算历史数据的平均值和方差,得到一个校准因子,然后对神经网络的预测值进行修正,使其更加接近真实的目标值。历史平均校准的优点在于简单易用,不需要额外的训练数据和计算成本,同时适用于各种不同的回归问题。

2.线性回归校准(Linear Regression Calibration)

线性回归校准是一种基于线性回归模型的回归校准技术,其原理是通过拟合一个线性模型,将神经网络的预测值映射到真实的目标值上。具体而言,线性回归校准通过使用额外的标记数据,训练一个线性回归模型,将神经网络的预测值作为输入,真实的目标值作为输出,得到一个线性映射函数,从而对神经网络的预测值进行校准。

线性回归校准的优点在于能够更加准确地估计预测值和目标值之间的关系,适用于各种不同的回归问题。但是,线性回归模型的拟合需要大量的标记数据和计算成本,同时对于非线性关系的回归问题可能效果不佳。

总的来说,分类校准和回归校准是深度神经网络中常见的校准技术,能够提高模型的性能和可靠性。分类校准主要通过调整分类器的置信度,使得预测概率更加准确;回归校准主要通过修正预测值的偏差和方差,使得预测结果更加接近真实的目标值。在实际应用中,需要根据具体问题选择合适的校准方法,并结合其他技术来优化模型的性能。

以上是分类校准和回归校准的深度神经网络的详细内容。更多信息请关注PHP中文网其他相关文章!

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

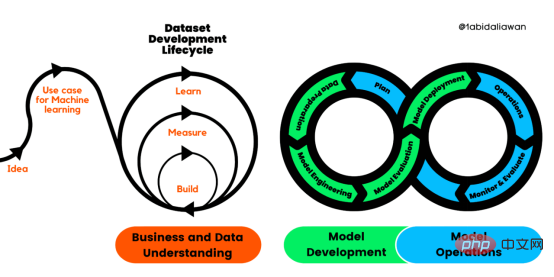

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM机器学习是一个不断发展的学科,一直在创造新的想法和技术。本文罗列了2023年机器学习的十大概念和技术。 本文罗列了2023年机器学习的十大概念和技术。2023年机器学习的十大概念和技术是一个教计算机从数据中学习的过程,无需明确的编程。机器学习是一个不断发展的学科,一直在创造新的想法和技术。为了保持领先,数据科学家应该关注其中一些网站,以跟上最新的发展。这将有助于了解机器学习中的技术如何在实践中使用,并为自己的业务或工作领域中的可能应用提供想法。2023年机器学习的十大概念和技术:1. 深度神经网

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM

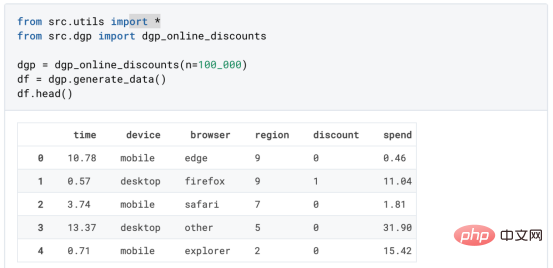

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM译者 | 朱先忠审校 | 孙淑娟在我之前的博客中,我们已经了解了如何使用因果树来评估政策的异质处理效应。如果你还没有阅读过,我建议你在阅读本文前先读一遍,因为我们在本文中认为你已经了解了此文中的部分与本文相关的内容。为什么是异质处理效应(HTE:heterogenous treatment effects)呢?首先,对异质处理效应的估计允许我们根据它们的预期结果(疾病、公司收入、客户满意度等)选择提供处理(药物、广告、产品等)的用户(患者、用户、客户等)。换句话说,估计HTE有助于我

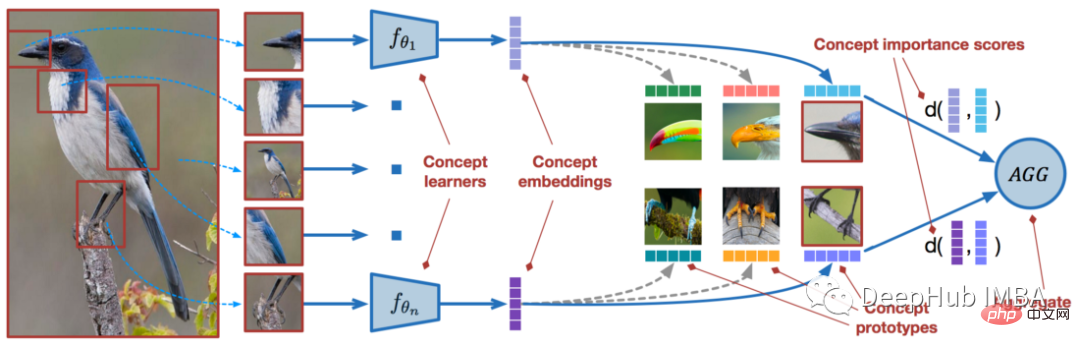

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM近年来,基于深度学习的模型在目标检测和图像识别等任务中表现出色。像ImageNet这样具有挑战性的图像分类数据集,包含1000种不同的对象分类,现在一些模型已经超过了人类水平上。但是这些模型依赖于监督训练流程,标记训练数据的可用性对它们有重大影响,并且模型能够检测到的类别也仅限于它们接受训练的类。由于在训练过程中没有足够的标记图像用于所有类,这些模型在现实环境中可能不太有用。并且我们希望的模型能够识别它在训练期间没有见到过的类,因为几乎不可能在所有潜在对象的图像上进行训练。我们将从几个样本中学习

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。 摘要本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。本文包括的内容如下:简介LazyPredict模块的安装在分类模型中实施LazyPredict

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM

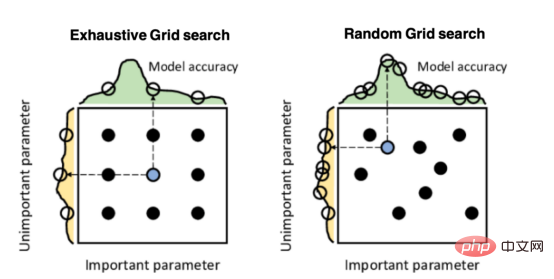

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM译者 | 朱先忠审校 | 孙淑娟引言模型超参数(或模型设置)的优化可能是训练机器学习算法中最重要的一步,因为它可以找到最小化模型损失函数的最佳参数。这一步对于构建不易过拟合的泛化模型也是必不可少的。优化模型超参数的最著名技术是穷举网格搜索和随机网格搜索。在第一种方法中,搜索空间被定义为跨越每个模型超参数的域的网格。通过在网格的每个点上训练模型来获得最优超参数。尽管网格搜索非常容易实现,但它在计算上变得昂贵,尤其是当要优化的变量数量很大时。另一方面,随机网格搜索是一种更快的优化方法,可以提供更好的

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM实现自我完善的过程是“机器学习”。机器学习是人工智能核心,是使计算机具有智能的根本途径;它使计算机能模拟人的学习行为,自动地通过学习来获取知识和技能,不断改善性能,实现自我完善。机器学习主要研究三方面问题:1、学习机理,人类获取知识、技能和抽象概念的天赋能力;2、学习方法,对生物学习机理进行简化的基础上,用计算的方法进行再现;3、学习系统,能够在一定程度上实现机器学习的系统。

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM本文将详细介绍用来提高机器学习效果的最常见的超参数优化方法。 译者 | 朱先忠审校 | 孙淑娟简介通常,在尝试改进机器学习模型时,人们首先想到的解决方案是添加更多的训练数据。额外的数据通常是有帮助(在某些情况下除外)的,但生成高质量的数据可能非常昂贵。通过使用现有数据获得最佳模型性能,超参数优化可以节省我们的时间和资源。顾名思义,超参数优化是为机器学习模型确定最佳超参数组合以满足优化函数(即,给定研究中的数据集,最大化模型的性能)的过程。换句话说,每个模型都会提供多个有关选项的调整“按钮

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

螳螂BT

Mantis是一个易于部署的基于Web的缺陷跟踪工具,用于帮助产品缺陷跟踪。它需要PHP、MySQL和一个Web服务器。请查看我们的演示和托管服务。

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

禅工作室 13.0.1

功能强大的PHP集成开发环境