使用SAM实现可靠的多模态3D检测的RoboFusion

- WBOY转载

- 2024-01-16 14:03:211244浏览

论文链接:https://arxiv.org/pdf/2401.03907.pdf

多模态3D检测器旨在研究安全可靠的自动驾驶感知系统。尽管它们在干净的基准数据集上取得了最先进的性能,但往往忽略了现实世界环境的复杂性和恶劣条件。与此同时,随着视觉基础模型(VFM)的出现,提高多模态三维检测的鲁棒性和泛化能力在自动驾驶中面临机遇和挑战。因此,作者提出了RoboFusion框架,它利用像SAM这样的VFM来解决分布外(OOD)噪声场景。

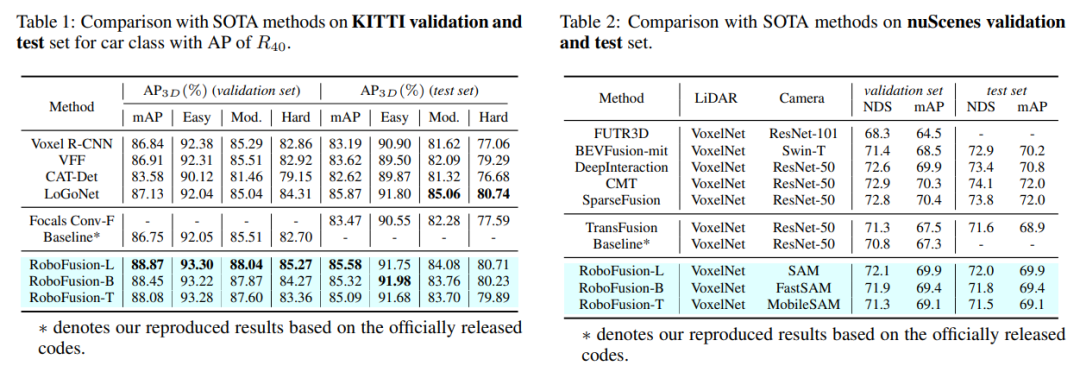

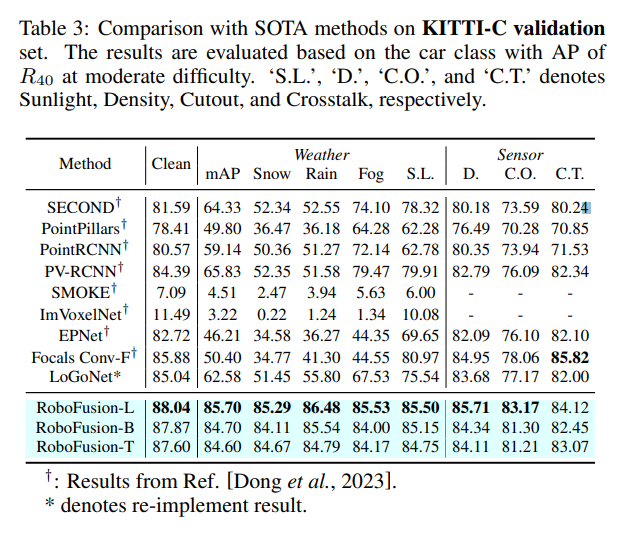

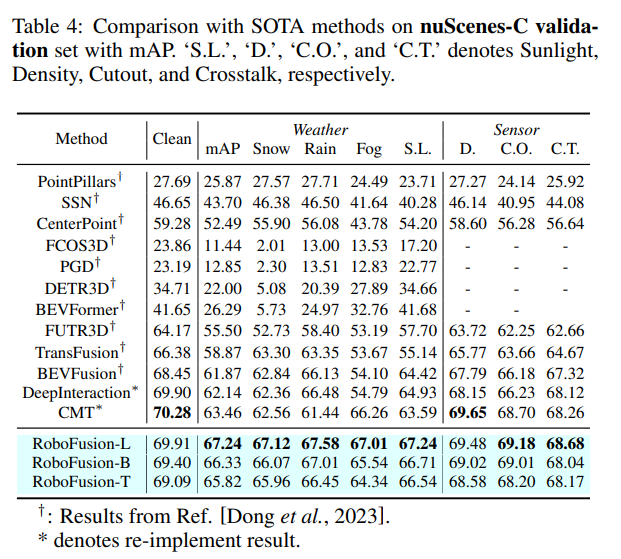

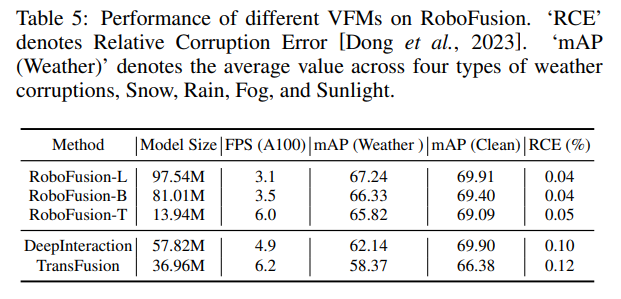

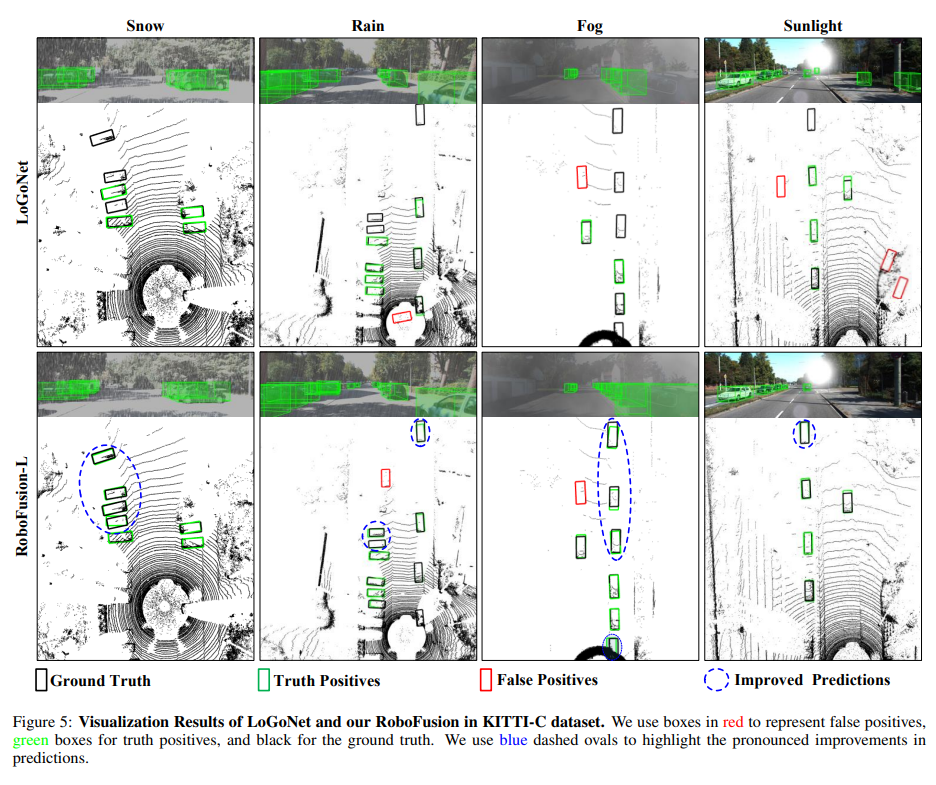

首先,我们将最初的SAM应用于名为SAM-AD的自动驾驶场景。为了将SAM或SAMAD与多模态方法对齐,我们引入了AD-FPN来对SAM提取的图像特征进行上采样。为了进一步降低噪声和天气干扰,我们采用小波分解对深度引导图像进行去噪。最后,我们使用自注意机制来自适应地重新加权融合的特征,以增强信息特征的同时抑制过量噪声。 RoboFusion通过利用VFM的泛化和鲁棒性逐渐降低噪声,从而增强了多模式3D目标检测的弹性。因此,根据KITTIC和nuScenes-C基准测试的结果,RoboFusion在噪声场景中实现了最先进的性能。

论文提出了一个稳健的框架,名为RoboFusion,它利用像SAM这样的VFM来将3D多模态目标检测器从干净场景调整为OOD噪声场景。其中,SAM的适应策略是关键。

1) 使用从SAM中提取的特征,而不是推理分割结果。

2) 提出了SAM-AD,这是针对AD场景的预训练SAM。

3) 介绍了一种新的AD-FPN来解决用于将VFM与多模式3D检测器对准的特征上采样问题。

为了降低噪声干扰并保留信号特征,引入了深度引导小波注意(DGWA)模块,有效衰减高低频噪声。

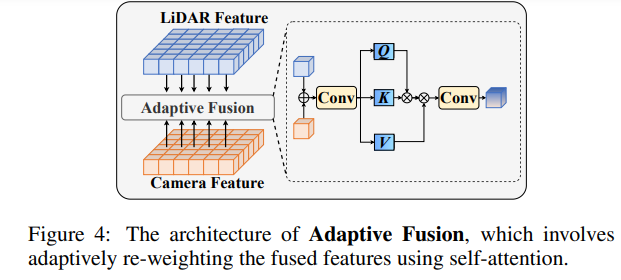

在融合点云特征和图像特征后,通过自适应融合重新加权特征,增强特征的鲁棒性和抗噪性。

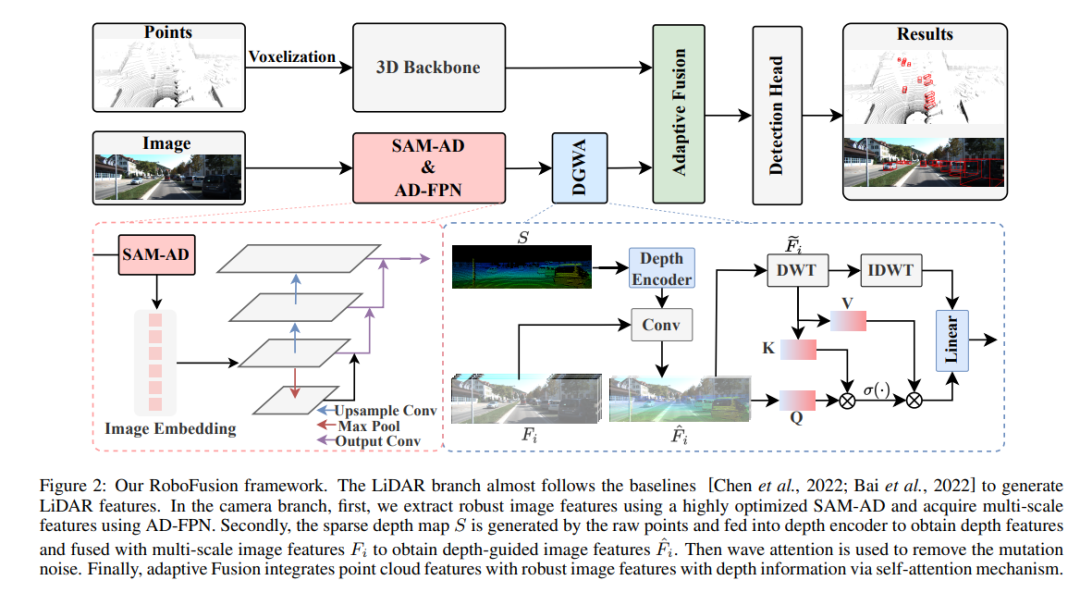

RoboFusion网络结构

RoboFusion框架如下所示,其激光雷达分支遵循基线[Chen et al.,2022;Bai et al.,2022]生成激光雷达特征。在相机分支中,首先采用高度优化的SAM-AD算法提取稳健的图像特征,并结合AD-FPN获取多尺度特征。接下来,利用原始点生成稀疏深度图S,并将其输入深度编码器以获得深度特征,同时与多尺度图像特征进行融合,得到深度引导图像特征。然后,通过波动注意力机制去除突变噪声。最后,通过自注意机制实现自适应融合,将点云特征与具有深度信息的鲁棒图像特征相结合。

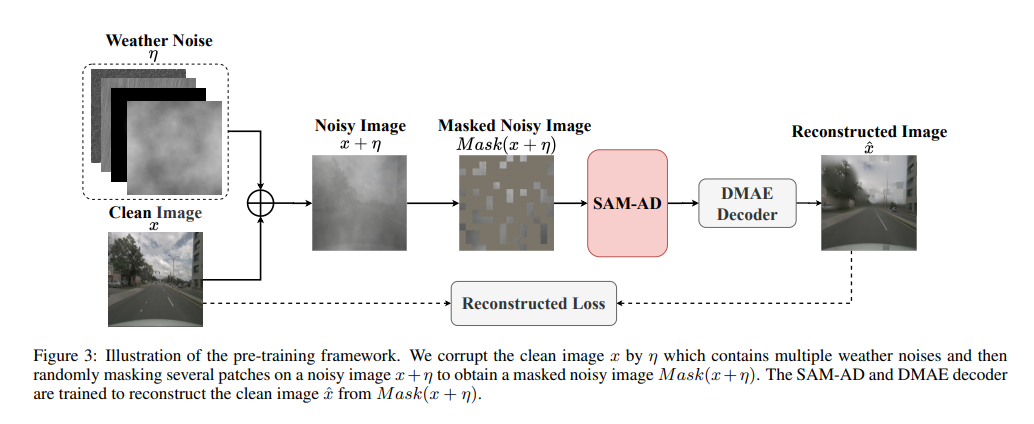

SAM-AD:为了进一步使SAM适应AD(自动驾驶)场景,对SAM进行预训练以获得SAM-AD。具体而言,我们从成熟的数据集(即KITTI和nuScenes)中收集了大量图像样本,形成了基础的AD数据集。在DMAE之后,对SAM进行预训练,以获得AD场景中的SAM-AD,如图3所示。将x表示为来自AD数据集的干净图像(即KITTI和nuScenes),将η表示为基于x生成的噪声图像。噪声类型和严重程度分别从四种天气(即雨、雪、雾和阳光)和1-5的五种严重程度中随机选择。使用SAM、MobileSAM的图像编码器作为我们的编码器,而解码器和重建损失与DMAE相同。

AD-FPN。作为一种可提示的分割模型,SAM由三个部分组成:图像编码器、提示编码器和掩码解码器。一般来说,有必要将图像编码器推广到训练VFM,然后再训练解码器。换言之,图像编码器可以为下游模型提供高质量和高度鲁棒的图像嵌入,而掩码解码器仅被设计为提供用于语义分割的解码服务。此外,我们需要的是鲁棒的图像特征,而不是提示编码器对提示信息的处理。因此,我们使用SAM的图像编码器来提取稳健的图像特征。然而,SAM利用ViT系列作为其图像编码器,其排除了多尺度特征,仅提供高维低分辨率特征。为了生成目标检测所需的多尺度特征,受[Li et al.,2022a]的启发,设计了一种AD-FPN,它提供基于ViT的多尺度特性!

尽管SAM-AD或SAM具有提取稳健图像特征的能力,但2D域和3D域之间的差距仍然存在,并且在损坏的环境中缺乏几何信息的相机经常放大噪声并引起负迁移问题。为了缓解这个问题,我们提出了深度引导小波注意(DGWA)模块,该模块可以分为以下两个步骤。1) 设计了一个深度引导网络,通过结合点云的图像特征和深度特征,在图像特征之前添加几何体。2) 使用Haar小波变换将图像的特征分解为四个子带,然后注意力机制允许对子带中的信息特征进行去噪!

实验对比

原文链接:https://mp.weixin.qq.com/s/78y1KyipHeUSh5sLQZy-ng

以上是使用SAM实现可靠的多模态3D检测的RoboFusion的详细内容。更多信息请关注PHP中文网其他相关文章!