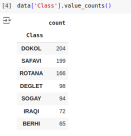

模型评估是深度学习和机器学习中非常重要的一部分,用于衡量模型的性能和效果。本文将逐步分解混淆矩阵,准确性,精度,召回率和F1分数

混淆矩阵

混淆矩阵用于评估模型在分类问题中的性能,它是一个展示模型对样本分类情况的表格。行代表实际类别,列代表预测类别。对于二分类问题,混淆矩阵的结构如下所示:

- True Positive (TP): 实际为正例,模型预测为正例的样本数,模型正确识别正面实例的能力。更高的TP通常是可取的

- False Negative (FN): 实际为正例,模型预测为负例的样本数,根据应用程序的不同,这可能是关键的(例如,未能检测到安全威胁)。

- False Positive (FP): 实际为负例,模型预测为正例的样本数,强调模型在不应该预测为正的情况下预测为正的情况,这可能会产生取决于应用的后果(例如,医疗诊断中不必要的治疗)

- True Negative (TN): 实际为负例,模型预测为负例的样本数,反映模型正确识别否定实例的能力。通常需要更高的TN

初学者看起来很乱,但实际上这很简单。后面的Negative/Positive是模型预测值,前面的True/False是模型预测的准确性。例如,True Negative表示模型预测为Negative且与实际值相符,即预测正确。这样就容易理解了。以下是一个简单的混淆矩阵:

from sklearn.metrics import confusion_matrix import seaborn as sns import matplotlib.pyplot as plt # Example predictions and true labels y_true = [1, 0, 1, 1, 0, 1, 0, 0, 1, 0] y_pred = [1, 0, 1, 0, 0, 1, 0, 1, 1, 1] # Create a confusion matrix cm = confusion_matrix(y_true, y_pred) # Visualize the blueprint sns.heatmap(cm, annot=True, fmt="d", cmap="Blues", xticklabels=["Predicted 0", "Predicted 1"], yticklabels=["Actual 0", "Actual 1"]) plt.xlabel("Predicted") plt.ylabel("Actual") plt.show()

当你想强调正确的预测和整体准确性时,使用TP和TN。当你想了解你的模型所犯的错误类型时,使用FP和FN。例如,在误报成本很高的应用程序中,最小化误报可能是至关重要的。

举个例子,我们来谈谈垃圾邮件分类器。混淆矩阵可以帮助我们了解该分类器正确识别了多少封垃圾邮件,以及错误地将多少封非垃圾邮件标记为垃圾邮件

基于混淆矩阵,可以计算许多其他评估指标,例如准确度、精确度、召回率和F1分数。

Accuracy

根据我们上面的总结,计算的是能够正确预测的的比例,分子是TP和TN都是True,也就是模型预测对了的总数

Precision

可以看到公式,他计算的是Positive 的占比,也就是说数据中所有Positive的,正确预测对了有多少,所以精确度Precision又被称作查准率

在误报有重大后果或成本的情况下,这一点变得非常重要。以医学诊断模型为例,精确度的确保确保只有真正需要治疗的人接受治疗

Recall

回收率,又称为敏感度或真阳性率,是指模型捕捉到所有正类实例的能力

从公式中可以看出,它的主要目的是计算模型所捕获的实际正例的数量,也就是正例的比例。因此,Recall又被称为查全率

F1 Score

F1分数的计算公式为: F1 = 2 * (精确度 * 召回率) / (精确度 + 召回率) 其中,精确度是指模型预测为正例的样本中,实际为正例的比例;召回率是指模型正确预测为正例的样本数占所有实际为正例的样本数的比例。F1分数是精确度和召回率的调和平均值,它能够综合考虑模型的准确性和全面性,以评估模型的性能

F1分数很重要,因为它提供了精确率和召回率之间的折衷。当你想在准确率和召回率之间找到平衡时,或者说针对一般的应用可以使用F1 Score

总结

在本文中,我们详细介绍了混淆矩阵、准确度、精确度、召回率和F1分数,并指出这些指标可以有效评估和提升模型的性能

以上是一文读懂分类模型评估指标的详细内容。更多信息请关注PHP中文网其他相关文章!

10个免费资源学习LLMSApr 14, 2025 am 10:04 AM

10个免费资源学习LLMSApr 14, 2025 am 10:04 AM解锁大型语言模型(LLMS)的力量:10个免费资源 踏上进入大语模型(LLM)世界的旅程,这是智能聊天机器人和高级数据分析背后的推动力。 该综合指南揭开了十个FR

您是否在分类建模中犯了这些错误?Apr 14, 2025 am 10:02 AM

您是否在分类建模中犯了这些错误?Apr 14, 2025 am 10:02 AM介绍 评估机器学习模型不仅是最后一步,而且是成功的基石。想象一下,建立一个高精度使其眼花azz乱的尖端模型,只是发现它在现实下崩溃了

Trocr和Zhen乳胶OCRApr 14, 2025 am 09:59 AM

Trocr和Zhen乳胶OCRApr 14, 2025 am 09:59 AM探索图像到文本模型的力量:Trocr和Zhen乳胶OCR AI的世界充满了语言模型及其在虚拟协助和内容创建中的应用。 但是,图像到文本转换的领域,由光学驱动

如何在SQL中删除重复行?Apr 14, 2025 am 09:55 AM

如何在SQL中删除重复行?Apr 14, 2025 am 09:55 AM介绍 SQL数据库通常会遭受重复记录,阻碍数据分析和操作效率。 本指南提供了删除这些冗余条目的实用技术,无论您是否正在使用客户数据,交易

大师SegformerApr 14, 2025 am 09:46 AM

大师SegformerApr 14, 2025 am 09:46 AMSegformer:深入研究有效的图像分割 现代应用需要高级图像处理功能,图像分割起着至关重要的作用。 本文探讨了Segformer,这是一个在分割图像方面出色的强大模型

Python中的框架是什么?Apr 14, 2025 am 09:41 AM

Python中的框架是什么?Apr 14, 2025 am 09:41 AM介绍 想象一下,您正在建造一个新的摩天大楼。没有蓝图,您不会开始,对吗?同样,在开发软件时,拥有正确的框架至关重要。在Python的广阔世界中,框架AC

不要错过2025年及时的工程课程Apr 14, 2025 am 09:38 AM

不要错过2025年及时的工程课程Apr 14, 2025 am 09:38 AM介绍 迅速的工程一直是2024年的热门话题,生成性AI的迅速发展使学习者在这个竞争性领域中提高技能。掌握及时工程就像拥有电力f的钥匙

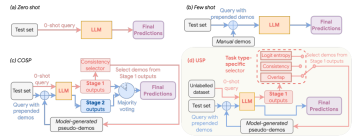

使用自适应提示和DSPY转换NLPApr 14, 2025 am 09:34 AM

使用自适应提示和DSPY转换NLPApr 14, 2025 am 09:34 AM自适应提示:革新与DSPY的AI互动 想象一下您的AI同伴完美理解并回应每个细微差别的对话。这不是科幻小说;这是自适应提示的力量。这项技术动态

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境

Dreamweaver Mac版

视觉化网页开发工具

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

Dreamweaver CS6

视觉化网页开发工具