多模态大模型集成了检测分割模块后,抠图变得更简单了!

我们的模型可以通过自然语言描述来快速标注要寻找的物体,并提供文字解释,让您轻松完成任务。

新加坡国立大学NExT++实验室与清华刘知远团队合作开发的全新多模态大模型,为我们提供了强大的支持。这个模型的背后是经过精心打造的,它能够在解谜过程中为玩家们提供全面的帮助和指导。它结合了多种模态的信息,为玩家们呈现出全新的解谜方法和策略。这个模型的应用将为玩家们

随着GPT-4v的推出,多模态领域迎来了一系列新模型,如LLaVA、BLIP-2等等。这些模型的出现在提升了多模态任务的性能和效果方面做出了巨大贡献。

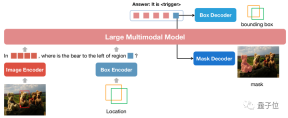

为了进一步提升多模态大模型的区域理解能力,研究团队开发了一个名为NExT-Chat的多模态模型。该模型具备同时进行对话和检测、分割的能力。

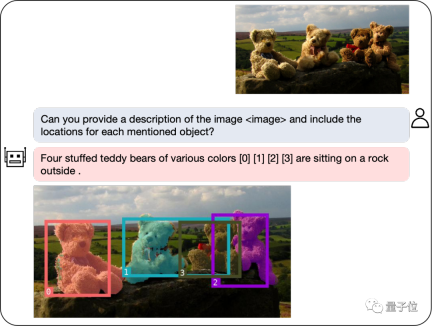

NExT-Chat的最大亮点是其多模态模型中引入了位置输入和输出的能力。这一特点使得NExT-Chat在交互中能够更加准确地理解和回应用户的需求。通过位置输入,NExT-Chat可以根据用户所在的地理位置提供相关的信息和建议,从而提升用户体验。而通过位置输出,NExT-Chat可以将特定地理位置的相关信息传达给用户,帮助他们更好

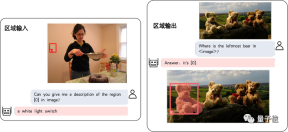

其中,位置输入能力是指根据指定的区域回答问题,而位置输出能力则是指定位对话中提及的物体。这两种能力在解谜游戏中非常重要。

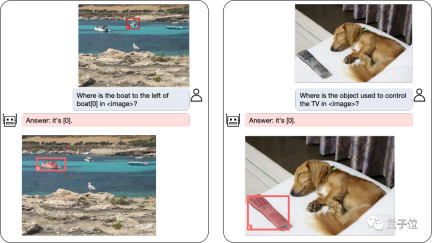

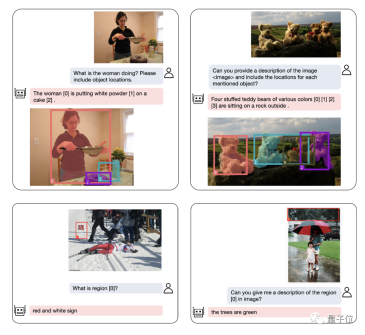

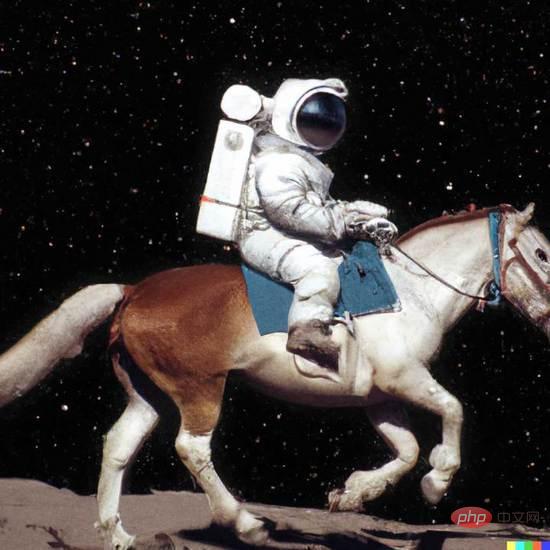

即使是复杂的定位问题,也能迎刃而解:

除了物体定位,NExT-Chat还可以对图片或其中的某个部分进行描述:

分析完图像的内容之后,NExT-Chat可以利用得到的信息进行推理:

为了准确评估NExT-Chat的表现,研究团队在多个任务数据集上进行了测试。

在多个数据集上取得SOTA

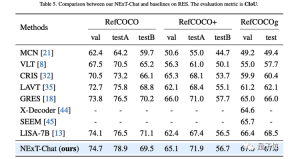

作者首先展示了NExT-Chat在指代表达式分割(RES)任务上的实验结果。

虽然仅仅用了极少量的分割数据,NExT-Chat却展现出了良好的指代分割能力,甚至打败了一系列有监督模型(如MCN,VLT等)和用了5倍以上分割掩模标注的LISA方法。

△RES任务上NExT-Chat结果

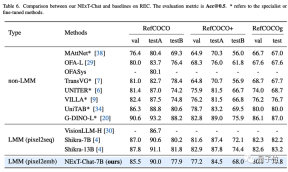

接着,研究团队展示了NExT-Chat在REC任务上的实验结果。

如下表所示,相比于相当一系列的有监督方法(如UNITER),NExT-Chat都可以取得更优的效果。

一个有意思的发现是NExT-Chat比使用了类似框训练数据的Shikra效果要稍差一些。

作者猜测,这是由于pix2emb方法中LM loss和detection loss更难以平衡,以及Shikra更贴近现有的纯文本大模型的预训练形式导致的。

△REC任务上NExT-Chat结果

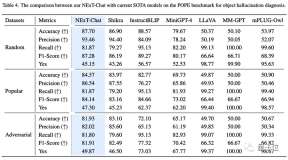

在图像幻觉任务上,如表3所示,NExT-Chat可以在Random和Popular数据集上取得最优的准确率。

△POPE数据集上NExT-Chat结果

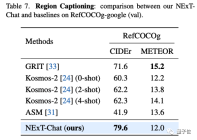

在区域描述任务上,NExT-Chat也能取得最优的CIDEr表现,且在该指标打败了4-shot情况下的Kosmos-2。

△RefCOCOg数据集上NExT-Chat结果

那么,NExT-Chat背后都采用了哪些方法呢?

提出图像编码新方式

传统方法的缺陷

传统的模型主要通过pix2seq的方式进行LLM相关的位置建模。

比如Kosmos-2将图像划分成32x32的区块,用每个区块的id来代表点的坐标;Shikra将物体框的坐标转化为纯文本的形式从而使得LLM可以理解坐标。

但使用pix2seq方法的模型输出主要局限在框和点这样的简单格式,而很难泛化到其他更密集的位置表示格式,比如segmentation mask。

为了解决这个问题,本文提出了一种全新的基于embedding的位置建模方式pix2emb。

pix2emb方法

不同于pix2seq,pix2emb所有的位置信息都通过对应的encoder和decoder进行编码和解码,而不是借助LLM本身的文字预测头。

△pix2emb方法简单示例

如上图所示,位置输入被对应的encoder编码为位置embedding,而输出的位置embedding则通过Box Decoder和Mask Decoder转化为框和掩模。

这样做带来了两个好处:

- 模型的输出格式可以非常方便的扩展到更多复杂形式,比如segmentation mask。

- 模型可以非常容易的定位任务中已有的实践方式,比如本文的detection loss采用L1 Loss和GIoU Loss (pix2seq则只能使用文本生成loss),本文的mask decoder借助了已有的SAM来做初始化。

通过将pix2seq与pix2emb结合,作者训练了全新的NExT-Chat模型。

NExT-Chat模型

△NExT-Chat模型架构

NExT-Chat整体采用了LLaVA架构,即通过Image Encoder来编码图像信息并输入LLM进行理解,并在此基础上添加了对应的Box Encoder和两种位置输出的Decoder。

为了解决LLM不知道何时该使用语言的LM head还是位置解码器的问题,NExT-Chat额外引入一个全新的token类型来标识位置信息。

如果模型输出了,则该token的embedding会被送入对应的位置解码器进行解码而不是语言解码器。

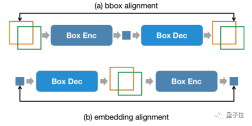

此外,为了维持输入阶段和输出阶段位置信息的一致性,NExT-Chat额外引入了一个对齐约束:

△位置输入、输出约束

如上图所示,box和位置embedding会被分别通过解码器、编码器或解码器编码器组合,并要求前后不发生变化。

作者发现该方法可以极大程度促进位置输入能力的收敛。

而NExT-Chat的模型训练主要包括3个阶段:

- 第一阶段:训练模型基本的框输入输出基本能力。NExT-Chat采用Flickr-30K,RefCOCO,VisualGenome等包含框输入输出的数据集进行预训练。训练过程中,LLM参数会被全部训练。

- 第二阶段:调整LLM的指令遵循能力。通过一些Shikra-RD,LLaVA-instruct之类的指令微调数据使得模型可以更好的响应人类的要求,输出更人性化的结果。

- 第三阶段:赋予NExT-Chat模型分割能力。通过以上两阶段训练,模型已经有了很好的位置建模能力。作者进一步将这种能力扩展到mask输出上。实验发现,通过使用极少量的mask标注数据和训练时间(大约3小时),NExT-Chat可以快速的拥有良好的分割能力。

这样的训练流程的好处在于:检测框数据丰富且训练开销更小。

NExT-Chat通过在充沛的检测框数据训练基本的位置建模能力,之后可以快速的扩展到难度更大且标注更稀缺的分割任务上。

以上是大规模模型已经可以为图像做标注,只需简单对话!清华&NUS的研究成果的详细内容。更多信息请关注PHP中文网其他相关文章!

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM1 前言在发布DALL·E的15个月后,OpenAI在今年春天带了续作DALL·E 2,以其更加惊艳的效果和丰富的可玩性迅速占领了各大AI社区的头条。近年来,随着生成对抗网络(GAN)、变分自编码器(VAE)、扩散模型(Diffusion models)的出现,深度学习已向世人展现其强大的图像生成能力;加上GPT-3、BERT等NLP模型的成功,人类正逐步打破文本和图像的信息界限。在DALL·E 2中,只需输入简单的文本(prompt),它就可以生成多张1024*1024的高清图像。这些图像甚至

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM“Making large models smaller”这是很多语言模型研究人员的学术追求,针对大模型昂贵的环境和训练成本,陈丹琦在智源大会青源学术年会上做了题为“Making large models smaller”的特邀报告。报告中重点提及了基于记忆增强的TRIME算法和基于粗细粒度联合剪枝和逐层蒸馏的CofiPruning算法。前者能够在不改变模型结构的基础上兼顾语言模型困惑度和检索速度方面的优势;而后者可以在保证下游任务准确度的同时实现更快的处理速度,具有更小的模型结构。陈丹琦 普

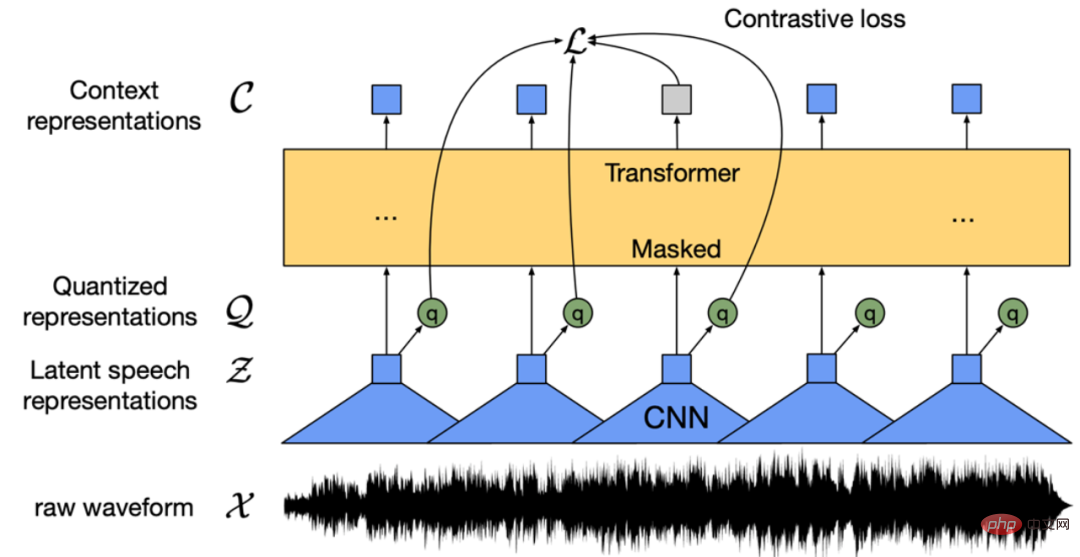

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM由于复杂的注意力机制和模型设计,大多数现有的视觉 Transformer(ViT)在现实的工业部署场景中不能像卷积神经网络(CNN)那样高效地执行。这就带来了一个问题:视觉神经网络能否像 CNN 一样快速推断并像 ViT 一样强大?近期一些工作试图设计 CNN-Transformer 混合架构来解决这个问题,但这些工作的整体性能远不能令人满意。基于此,来自字节跳动的研究者提出了一种能在现实工业场景中有效部署的下一代视觉 Transformer——Next-ViT。从延迟 / 准确性权衡的角度看,

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM3月27号,Stability AI的创始人兼首席执行官Emad Mostaque在一条推文中宣布,Stable Diffusion XL 现已可用于公开测试。以下是一些事项:“XL”不是这个新的AI模型的官方名称。一旦发布稳定性AI公司的官方公告,名称将会更改。与先前版本相比,图像质量有所提高与先前版本相比,图像生成速度大大加快。示例图像让我们看看新旧AI模型在结果上的差异。Prompt: Luxury sports car with aerodynamic curves, shot in a

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM人工智能就是一个「拼财力」的行业,如果没有高性能计算设备,别说开发基础模型,就连微调模型都做不到。但如果只靠拼硬件,单靠当前计算性能的发展速度,迟早有一天无法满足日益膨胀的需求,所以还需要配套的软件来协调统筹计算能力,这时候就需要用到「智能计算」技术。最近,来自之江实验室、中国工程院、国防科技大学、浙江大学等多达十二个国内外研究机构共同发表了一篇论文,首次对智能计算领域进行了全面的调研,涵盖了理论基础、智能与计算的技术融合、重要应用、挑战和未来前景。论文链接:https://spj.scien

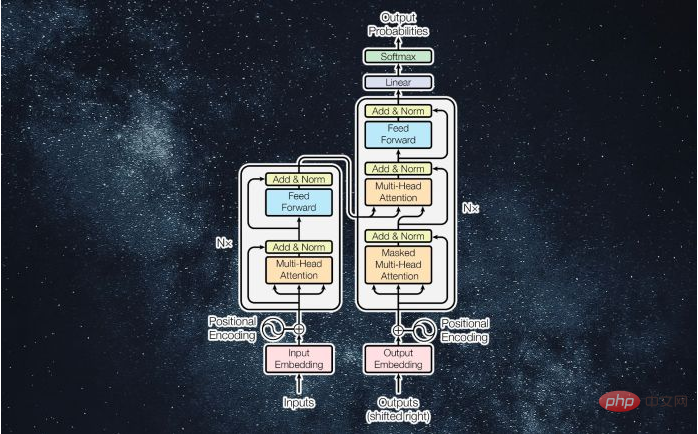

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM译者 | 李睿审校 | 孙淑娟近年来, Transformer 机器学习模型已经成为深度学习和深度神经网络技术进步的主要亮点之一。它主要用于自然语言处理中的高级应用。谷歌正在使用它来增强其搜索引擎结果。OpenAI 使用 Transformer 创建了著名的 GPT-2和 GPT-3模型。自从2017年首次亮相以来,Transformer 架构不断发展并扩展到多种不同的变体,从语言任务扩展到其他领域。它们已被用于时间序列预测。它们是 DeepMind 的蛋白质结构预测模型 AlphaFold

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM说起2010年南非世界杯的最大网红,一定非「章鱼保罗」莫属!这只位于德国海洋生物中心的神奇章鱼,不仅成功预测了德国队全部七场比赛的结果,还顺利地选出了最终的总冠军西班牙队。不幸的是,保罗已经永远地离开了我们,但它的「遗产」却在人们预测足球比赛结果的尝试中持续存在。在艾伦图灵研究所(The Alan Turing Institute),随着2022年卡塔尔世界杯的持续进行,三位研究员Nick Barlow、Jack Roberts和Ryan Chan决定用一种AI算法预测今年的冠军归属。预测模型图

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

SublimeText3 Linux新版

SublimeText3 Linux最新版

SublimeText3汉化版

中文版,非常好用

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)