Q-Learning是强化学习中一种至关重要的无模型算法,专注于学习特定状态下动作的价值或“Q 值”。这种方法在具有不可预测性的环境中表现出色,因为它不需要周围环境的预定义模型。它有效地适应随机转换和各种奖励,使其适用于结果不确定的场景。这种灵活性使 Q-Learning 成为需要自适应决策的强大工具,而无需事先了解环境动态。

使用 Dyna-Q 扩展 Q-Learning 以增强决策能力

探索 Dyna-Q,这是一种先进的强化学习算法,通过将真实体验与模拟规划相结合来扩展 Q-Learning。

Q-Learning 是强化学习中一种至关重要的无模型算法,专注于学习特定状态下动作的价值或“Q 值”。这种方法在具有不可预测性的环境中表现出色,因为它不需要周围环境的预定义模型。它有效地适应随机转换和各种奖励,使其适用于结果不确定的场景。这种灵活性使 Q-Learning 成为需要自适应决策的强大工具,而无需事先了解环境动态。

学习过程

Q-learning 的工作原理是更新每个状态下每个动作的 Q 值表。它使用贝尔曼方程,根据观察到的奖励及其对未来奖励的估计,迭代更新这些值。策略 - 选择行动的策略 - 是从这些Q值中得出的。

- Q值 - 表示通过在给定状态下采取特定操作可以获得的预期未来奖励

- 更新规则 - Q 值更新如下:

- Q (状态, 动作) ← Q (状态, 动作) + α (奖励 + 最大γ Q (下一个状态,a) − Q (状态, 动作))

- 学习率α表示新信息的重要性,折扣系数γ表示未来奖励的重要性。

提供的代码用作 Q-Learner 的训练功能。它利用贝尔曼方程来确定状态之间最有效的转换。

def train_Q(self,s_prime,r): self.QTable[self.s,self.action] = (1-self.alpha)*self.QTable[self.s, self.action] + \ self.alpha * (r + self.gamma * (self.QTable[s_prime, np.argmax(self.QTable[s_prime])])) self.experiences.append((self.s, self.action, s_prime, r)) self.num_experiences = self.num_experiences + 1 self.s = s_prime self.action = action return action

勘探与开发

Q-learning的一个关键方面是平衡探索(尝试新的行动来发现他们的奖励)和利用(使用已知信息来最大化奖励)。算法通常使用ε贪婪等策略来维持这种平衡。

首先设置随机操作的速率,以平衡探索和开发。实现衰减率,以随着 Q 表积累更多数据而逐渐降低随机性。这种方法保证了随着时间的推移,随着更多证据的积累,算法越来越多地转向利用。

if rand.random() >= self.random_action_rate: action = np.argmax(self.QTable[s_prime,:]) #Exploit: Select Action that leads to a State with the Best Reward else: action = rand.randint(0,self.num_actions - 1) #Explore: Randomly select an Action. # Use a decay rate to reduce the randomness (Exploration) as the Q-Table gets more evidence self.random_action_rate = self.random_action_rate * self.random_action_decay_rate

Dyna-Q简介

Dyna-Q 是传统 Q-Learning 算法的创新扩展,处于将真实体验与模拟规划相结合的最前沿。这种方法通过整合实际交互和模拟体验,显著增强了学习过程,使智能体能够在复杂的环境中快速适应并做出明智的决策。通过利用从环境反馈中直接学习和通过仿真获得的见解,Dyna-Q提供了一种全面而有效的策略,以应对真实世界数据稀缺或获取成本高昂的挑战。

Dyna-Q的组件

- Q-Learning:从真实经验中学习

- 模型学习:学习环境模型

- 规划:使用模型生成模拟体验

模型学习

- 该模型跟踪转换和奖励。对于每个状态-动作对 (s, a),模型存储下一个状态 s′ 和奖励 r。

- 当智能体观察到转换 (s, a,r,s′) 时,它会更新模型。

使用模拟体验进行规划

- 在每个步骤中,代理从真实体验更新其 Q 值后,还会根据模拟体验更新 Q 值。

- 这些体验是使用学习模型生成的:对于选定的状态-动作对(s,a),它预测下一个状态和奖励,并且Q值被更新,就好像已经经历了这种转变一样。

算法 Dyna-Q

- 初始化所有状态-动作对的 Q 值 Q(s, a) 和模型 (s, a)。

- 循环(每集):

- 初始化状态 s。

- 循环(针对剧集的每个步骤):

- 使用派生自 Q 从状态 s 中选择操作 a(例如,ε-greedy )

- 采取行动 a,观察奖励 r,然后下一个状态 s′

- 直接学习:使用观察到的跃迁(s、a、r、s′)更新 Q 值

- 模型学习:使用转换(s、a、r、s′)更新模型

- 计划:重复 n 次:

- 随机选择以前经历过的状态-动作对 (s, a)。

- 使用模型生成预测的下一个状态 s′ 并奖励 r

- 使用模拟跃迁 (s, a,r,s′) 更新 Q 值

- s← s′。

- 结束循环 此功能将 Dyna-Q 计划阶段合并到前面提到的 Q-Learner 中,从而能够指定在每一集中运行的所需模拟量,其中操作是随机选择的。此功能增强了 Q-Learn 的整体功能和多功能性。

def train_DynaQ(self,s_prime,r): self.QTable[self.s,self.action] = (1-self.alpha)*self.QTable[self.s, self.action] + \ self.alpha * (r + self.gamma * (self.QTable[s_prime, np.argmax(self.QTable[s_prime])])) self.experiences.append((self.s, self.action, s_prime, r)) self.num_experiences = self.num_experiences + 1 # Dyna-Q Planning - Start if self.dyna_planning_steps > 0: # Number of simulations to perform idx_array = np.random.randint(0, self.num_experiences, self.dyna) for exp in range(0, self.dyna): # Pick random experiences and update QTable idx = idx_array[exp] self.QTable[self.experiences[idx][0],self.experiences[idx][1]] = (1-self.alpha)*self.QTable[self.experiences[idx][0], self.experiences[idx][1]] + \ self.alpha * (self.experiences[idx][3] + self.gamma * (self.QTable[self.experiences[idx][2], np.argmax(self.QTable[self.experiences[idx][2],:])])) # Dyna-Q Planning - End if rand.random() >= self.random_action_rate: action = np.argmax(self.QTable[s_prime,:]) #Exploit: Select Action that leads to a State with the Best Reward else: action = rand.randint(0,self.num_actions - 1) #Explore: Randomly select an Action. # Use a decay rate to reduce the randomness (Exploration) as the Q-Table gets more evidence self.random_action_rate = self.random_action_rate * self.random_action_decay_rate self.s = s_prime self.action = action return action

结论

Dyna Q 代表了一种进步,我们追求设计能够在复杂和不确定的环境中学习和适应的代理。通过理解和实施 Dyna Q,人工智能和机器学习领域的专家和爱好者可以为各种实际问题设计出有弹性的解决方案。本教程的目的不是介绍概念和算法,而是在这个引人入胜的研究领域激发创造性应用和未来进展的创造力。

以上是使用Dyna-Q扩展Q-Learning以增强决策能力的详细内容。更多信息请关注PHP中文网其他相关文章!

如何使用LM Studio在本地运行LLM? - 分析VidhyaApr 19, 2025 am 11:38 AM

如何使用LM Studio在本地运行LLM? - 分析VidhyaApr 19, 2025 am 11:38 AM轻松在家运行大型语言模型:LM Studio 使用指南 近年来,软件和硬件的进步使得在个人电脑上运行大型语言模型 (LLM) 成为可能。LM Studio 就是一个让这一过程变得轻松便捷的优秀工具。本文将深入探讨如何使用 LM Studio 在本地运行 LLM,涵盖关键步骤、潜在挑战以及在本地拥有 LLM 的优势。无论您是技术爱好者还是对最新 AI 技术感到好奇,本指南都将提供宝贵的见解和实用技巧。让我们开始吧! 概述 了解在本地运行 LLM 的基本要求。 在您的电脑上设置 LM Studi

盖伊·佩里(Guy Peri)通过数据转换帮助麦考密克的未来Apr 19, 2025 am 11:35 AM

盖伊·佩里(Guy Peri)通过数据转换帮助麦考密克的未来Apr 19, 2025 am 11:35 AM盖伊·佩里(Guy Peri)是麦考密克(McCormick)的首席信息和数字官。尽管他的角色仅七个月,但Peri正在迅速促进公司数字能力的全面转变。他的职业生涯专注于数据和分析信息

迅速工程中的情感链是什么? - 分析VidhyaApr 19, 2025 am 11:33 AM

迅速工程中的情感链是什么? - 分析VidhyaApr 19, 2025 am 11:33 AM介绍 人工智能(AI)不仅要理解单词,而且要理解情感,从而以人的触感做出反应。 这种复杂的互动对于AI和自然语言处理的快速前进的领域至关重要。 Th

12个最佳数据科学工作流程的AI工具-Analytics VidhyaApr 19, 2025 am 11:31 AM

12个最佳数据科学工作流程的AI工具-Analytics VidhyaApr 19, 2025 am 11:31 AM介绍 在当今以数据为中心的世界中,利用先进的AI技术对于寻求竞争优势和提高效率的企业至关重要。 一系列强大的工具使数据科学家,分析师和开发人员都能构建,Depl

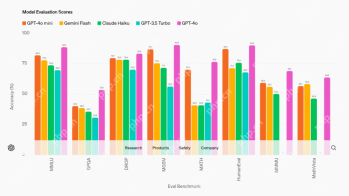

AV字节:OpenAI的GPT-4O Mini和其他AI创新Apr 19, 2025 am 11:30 AM

AV字节:OpenAI的GPT-4O Mini和其他AI创新Apr 19, 2025 am 11:30 AM本周的AI景观爆炸了,来自Openai,Mistral AI,Nvidia,Deepseek和Hugging Face等行业巨头的开创性发行。 这些新型号有望提高功率,负担能力和可访问性,这在TR的进步中推动了

报告发现,困惑的Android应用程序有安全缺陷。Apr 19, 2025 am 11:24 AM

报告发现,困惑的Android应用程序有安全缺陷。Apr 19, 2025 am 11:24 AM但是,该公司的Android应用不仅提供搜索功能,而且还充当AI助手,并充满了许多安全问题,可以将其用户暴露于数据盗用,帐户收购和恶意攻击中

每个人都擅长使用AI:关于氛围编码的想法Apr 19, 2025 am 11:17 AM

每个人都擅长使用AI:关于氛围编码的想法Apr 19, 2025 am 11:17 AM您可以查看会议和贸易展览中正在发生的事情。您可以询问工程师在做什么,或咨询首席执行官。 您看的任何地方,事情都以惊人的速度发生变化。 工程师和非工程师 有什么区别

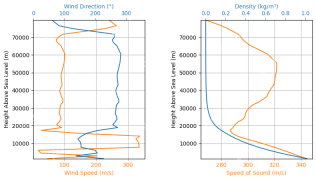

火箭发射模拟和分析使用Rocketpy -Analytics VidhyaApr 19, 2025 am 11:12 AM

火箭发射模拟和分析使用Rocketpy -Analytics VidhyaApr 19, 2025 am 11:12 AM模拟火箭发射的火箭发射:综合指南 本文指导您使用强大的Python库Rocketpy模拟高功率火箭发射。 我们将介绍从定义火箭组件到分析模拟的所有内容

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

WebStorm Mac版

好用的JavaScript开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

SublimeText3 Linux新版

SublimeText3 Linux最新版

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。