1. 环境描述

SuSE 11 sp1 x86_64 + MySQL 5.5.37

blog地址:http://blog.csdn.net/hw_libo/article/details/39583247

测试表order_line有3.2亿数据,大小约37G:

NDSC02:/data/mysql/mysql3306/data/tpcc1000 # du -shl order_line.* 12K order_line.frm 37G order_line.ibd

mysql> show table status like 'order_line'; +------------+--------+---------+------------+-----------+----------------+-------------+-----------------+--------------+-----------+-- | Name | Engine | Version | Row_format | Rows | Avg_row_length | Data_length | Max_data_length | Index_length | Data_free | A +------------+--------+---------+------------+-----------+----------------+-------------+-----------------+--------------+-----------+-- | order_line | InnoDB | 10 | Compact | 328191117 | 84 | 27771404288 | 0 | 10846420992 | 6291456 | +------------+--------+---------+------------+-----------+----------------+-------------+-----------------+--------------+-----------+-- 1 row in set (0.09 sec)MySQL的my.cnf配置:

# InnoDB variables innodb_data_file_path = ibdata1:1G:autoextend innodb_buffer_pool_size = 35G innodb_file_per_table = 1 innodb_thread_concurrency = 20 innodb_flush_log_at_trx_commit = 1 innodb_log_buffer_size = 16M innodb_log_file_size = 256M innodb_log_files_in_group = 3 innodb_max_dirty_pages_pct = 50 innodb_lock_wait_timeout = 120 innodb_rollback_on_timeout innodb_status_file = 1 transaction_isolation = READ-COMMITTED

bulk_insert_buffer_size<span style="white-space:pre"> </span>= 64M

2. 使用mysqldump导出该表

参数说明:

-e, --extended-insert,长INSERT,多row在一起批量INSERT,提高导入效率,和没有开启 -e 的备份导入耗时至少相差3、4倍,默认开启;用--extended-insert=false关闭。强烈建议开启,通过下面的测试比较就会明白为什么了。

(1)默认方式导出,也即--extended-insert=true

# time mysqldump -S /tmp/mysql.sock -uroot -proot --single-transaction -B tpcc1000 --tables order_line > ./tpcc1000_order_line1.sql real 7m38.824s user 6m44.777s sys 0m50.627s

NDSC02:/opt/mysql/backup # ls -l tpcc1000_order_line1.sql -rw-r--r-- 1 root root 24703941064 09-26 16:39 tpcc1000_order_line1.sql NDSC02:/opt/mysql/backup # du -sh tpcc1000_order_line1.sql 24G tpcc1000_order_line1.sql

(2)关闭--extended-insert,也即--extended-insert=false

# time mysqldump -S /tmp/mysql.sock -uroot -proot --single-transaction --extended-insert=false -B tpcc1000 --tables order_line > ./tpcc1000_order_line2.sql real 9m36.340s user 8m18.219s sys 1m12.241s

NDSC02:/opt/mysql/backup # ls -l tpcc1000_order_line2.sql -rw-r--r-- 1 root root 35094700366 09-26 16:49 tpcc1000_order_line2.sql NDSC02:/opt/mysql/backup # du -sh tpcc1000_order_line2.sql 33G tpcc1000_order_line2.sql

可见,默认情况下(--extended-insert=true),导出37G的表,耗时7分38秒,导出文件为24G,如果关闭--extended-insert=false,同样的表,导出时耗时9分36秒,且导出文件为33G。

我测试过两次,基本一样。可以导出文件时,开启--extended-insert=true是必须的,这样导出文件小,耗时也比较少。

3. 导入的影响

这里说说默认情况下(--extended-insert=true)导出的文件与使用--extended-insert=false导出的文件在导入时的性能影响。

说明:innodb_flush_log_at_trx_commit=2

这里使用了测试表orders,表的大小为2.6GB,行数为31493000行,下面是导出文件:

# du -sh tpcc1000_orders* 1.4G tpcc1000_orders1.sql ## 使用默认情况下(--extended-insert=true)导出的文件 2.3G tpcc1000_orders2.sql ## 使用--extended-insert=false导出的文件(1)导入默认情况下(--extended-insert=true)导出的表

# time mysql -f -S /tmp/mysql.sock -uroot -proot test < ./tpcc1000_orders1.sql real 12m2.184s user 0m28.538s sys 0m1.460s(2)导入使用--extended-insert=false导出的表

# time mysql -f -S /tmp/mysql3308.sock -uroot -proot bosco2 < ./tpcc1000_orders2.sql real 276m39.231s ## 约4.6小时 user 8m13.391s sys 6m20.120s经过上面的一比较,发现导入速度相差非常多。

那么使用--extended-insert=false导出表是不是一无是处呢?

并非如此。比如数据库中表中已经存在大量数据,那么再往表中导入数据时,如果出现主键数据冲突Duplicate key error,将会导致导入操作失败,但此时如果是使用--extended-insert=false导出表,导入时主键冲突的会报错Duplicate key error,但不冲突的数据仍然能正常导入。

blog地址:http://blog.csdn.net/hw_libo/article/details/39583247

-- Bosco QQ:375612082

---- END ----

如何优化Java开发中的文件压缩解压性能Jul 01, 2023 am 11:54 AM

如何优化Java开发中的文件压缩解压性能Jul 01, 2023 am 11:54 AM如何优化Java开发中的文件压缩解压性能随着互联网技术的不断发展,文件传输和存储成为我们日常开发中经常遇到的需求。为了减小网络传输的带宽消耗和文件存储的空间占用,我们通常需要对文件进行压缩。在Java开发中,常用的文件压缩格式有ZIP和GZIP。本文将介绍如何优化Java开发中的文件压缩解压性能,帮助提高效率。一、合理选择压缩算法在Java开发中,进行文件压

电脑性能看哪些方面Dec 23, 2020 pm 01:54 PM

电脑性能看哪些方面Dec 23, 2020 pm 01:54 PM电脑性能看如下几个方面:1、电脑安装的操作系统的版本;2、电脑所配置的处理器类型;3、电脑安装的内存大小;4、操作系统是32位的还是64位的。

Vue3中的lazy函数详解:懒加载组件提高应用性能Jun 19, 2023 am 08:39 AM

Vue3中的lazy函数详解:懒加载组件提高应用性能Jun 19, 2023 am 08:39 AMVue3是一款流行的JavaScript框架,它具有易学易用、高效稳定的特点,尤其擅长构建单页应用程序(SPA)。Vue3中的lazy函数,作为懒加载组件的利器之一,可以很大程度上提高应用程序的性能。本文将详解Vue3中的lazy函数的使用方法与原理,以及它在实际开发中的应用场景和优点。什么是懒加载?在传统的前后端分离的开发中,前端开发人员往往需要处理大量的

Java开发中如何优化字符串查找性能Jun 29, 2023 am 11:12 AM

Java开发中如何优化字符串查找性能Jun 29, 2023 am 11:12 AM在Java开发中,字符串查找是一个常见且关键的操作。无论是在文本处理、数据分析还是系统日志分析等应用场景中,字符串的查找性能都对程序的整体性能有着重要影响。因此,如何优化字符串查找性能成为了Java开发中不可忽视的问题。一、使用indexOf()方法代替contains()方法在字符串查找中,Java提供了两个常用的方法:indexOf()和contains

Java随机数生成性能优化方法Jun 30, 2023 pm 12:25 PM

Java随机数生成性能优化方法Jun 30, 2023 pm 12:25 PM如何优化Java开发中的随机数生成性能随机数在计算机科学中有广泛的应用,特别是在密码学、模拟、游戏等领域。在Java开发中,我们常常需要生成随机数来满足各种需求。然而,随机数生成的性能通常是开发者关注的问题之一。本文将探讨如何优化Java开发中的随机数生成性能。使用ThreadLocalRandom类在Java7中引入了ThreadLocalRandom类

如何通过设置MySQL缓存来提高性能May 11, 2023 am 08:09 AM

如何通过设置MySQL缓存来提高性能May 11, 2023 am 08:09 AMMySQL是一种常用的关系型数据库管理系统(RDBMS),在各种应用场景下都得到广泛的应用。然而,在高并发、大数据量的情况下,MySQL数据库的性能受到挑战,特别是在读写操作频繁的场景下,容易出现性能瓶颈。为了提高MySQL数据库的性能,可以通过设置MySQL缓存来减少数据库的IO操作,从而提高MySQL的查询效率。在本文中,我们将介绍如何通过设置MySQL

自动驾驶决策规划技术详解Apr 04, 2023 pm 02:35 PM

自动驾驶决策规划技术详解Apr 04, 2023 pm 02:35 PM随着深度强化学习技术的快速发展,越来越多的研究团队开始将其应用于自动驾驶决策规划中,将行为决策与运动规划模块相融合,直接学习得到行驶轨迹。 自动驾驶中的决策规划模块是衡量和评价自动驾驶能力最核心的指标之一,它的主要任务是在接收到传感器的各种感知信息之后,对当前环境作出分析,然后对底层控制模块下达指令。典型的决策规划模块可以分为三个层次:全局路径规划、行为决策、运动规划。01 引言在一套完整的自动驾驶系统中,如果将感知模块比作人的眼睛和耳朵,那么决策规划就是自动驾驶的大脑。大脑在接收到传感器的各种

一篇学会本地知识库对LLM的性能优化Jun 12, 2023 am 09:23 AM

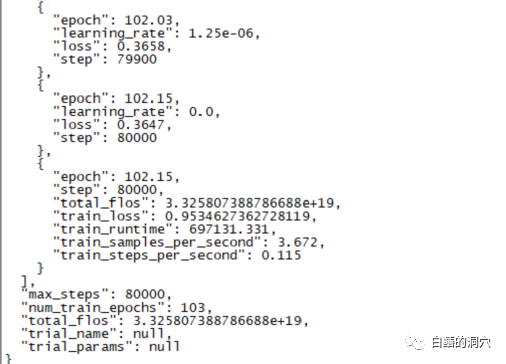

一篇学会本地知识库对LLM的性能优化Jun 12, 2023 am 09:23 AM昨天一个跑了220个小时的微调训练完成了,主要任务是想在CHATGLM-6B上微调出一个能够较为精确的诊断数据库错误信息的对话模型来。不过这个等了将近十天的训练最后的结果令人失望,比起我之前做的一个样本覆盖更小的训练来,差的还是挺大的。这样的结果还是有点令人失望的,这个模型基本上是没有实用价值的。看样子需要重新调整参数与训练集,再做一次训练。大语言模型的训练是一场军备竞赛,没有好的装备是玩不起来的。看样子我们也必须要升级一下实验室的装备了,否则没有几个十天可以浪费。从最近的几次失败的微调训练来看

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

禅工作室 13.0.1

功能强大的PHP集成开发环境

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

Dreamweaver Mac版

视觉化网页开发工具

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境

Dreamweaver CS6

视觉化网页开发工具