Meta 推出 AI 音频模型 Audiobox,支持语音及文字同时输入

- WBOY转载

- 2023-12-04 17:25:561319浏览

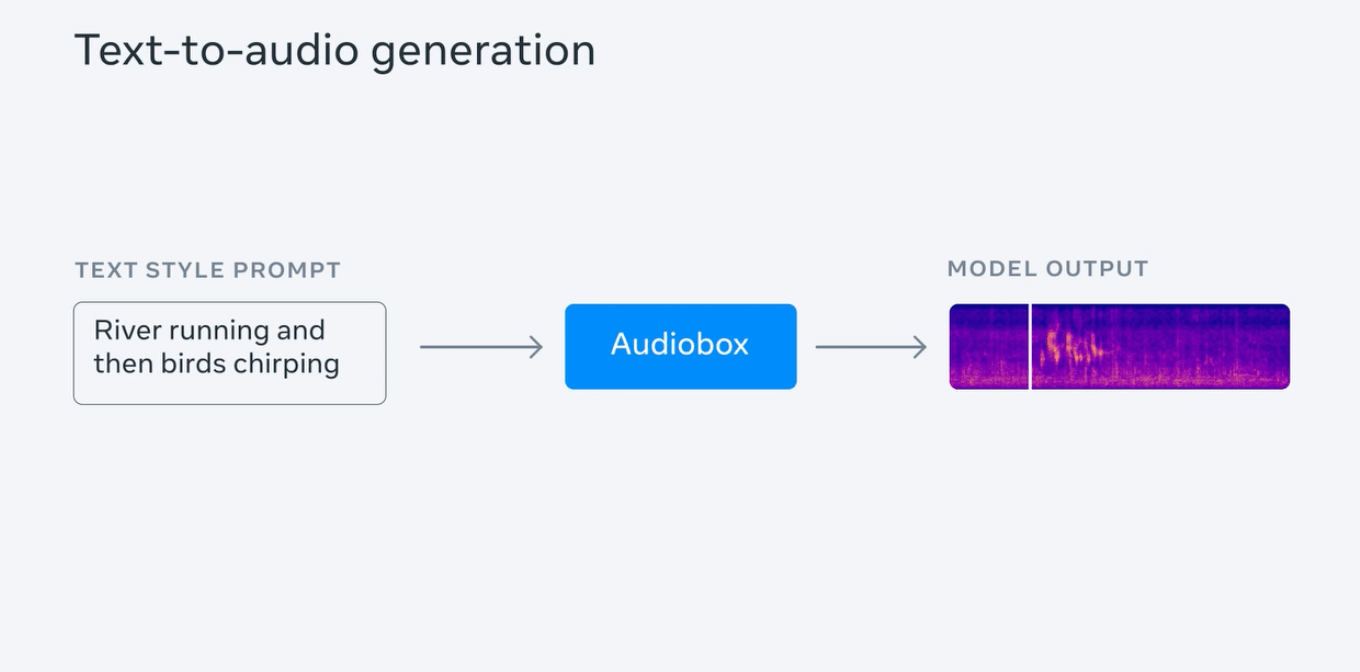

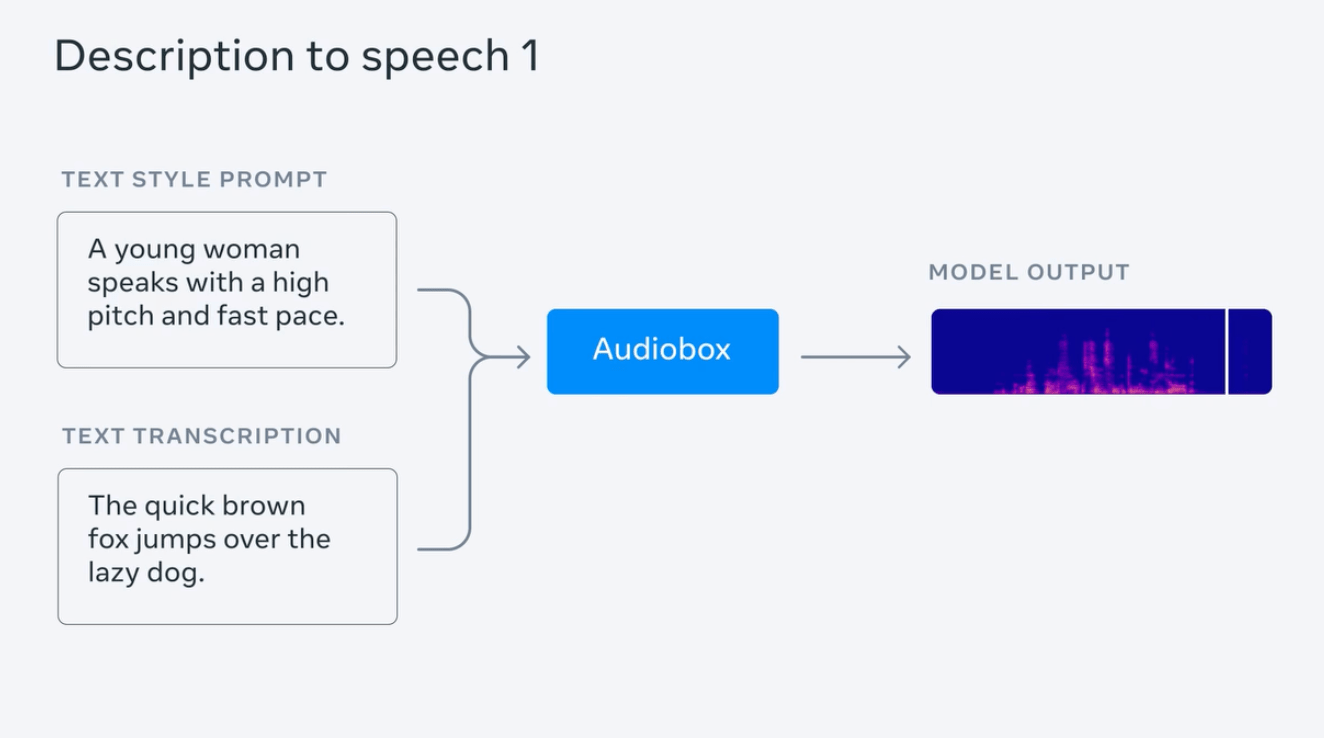

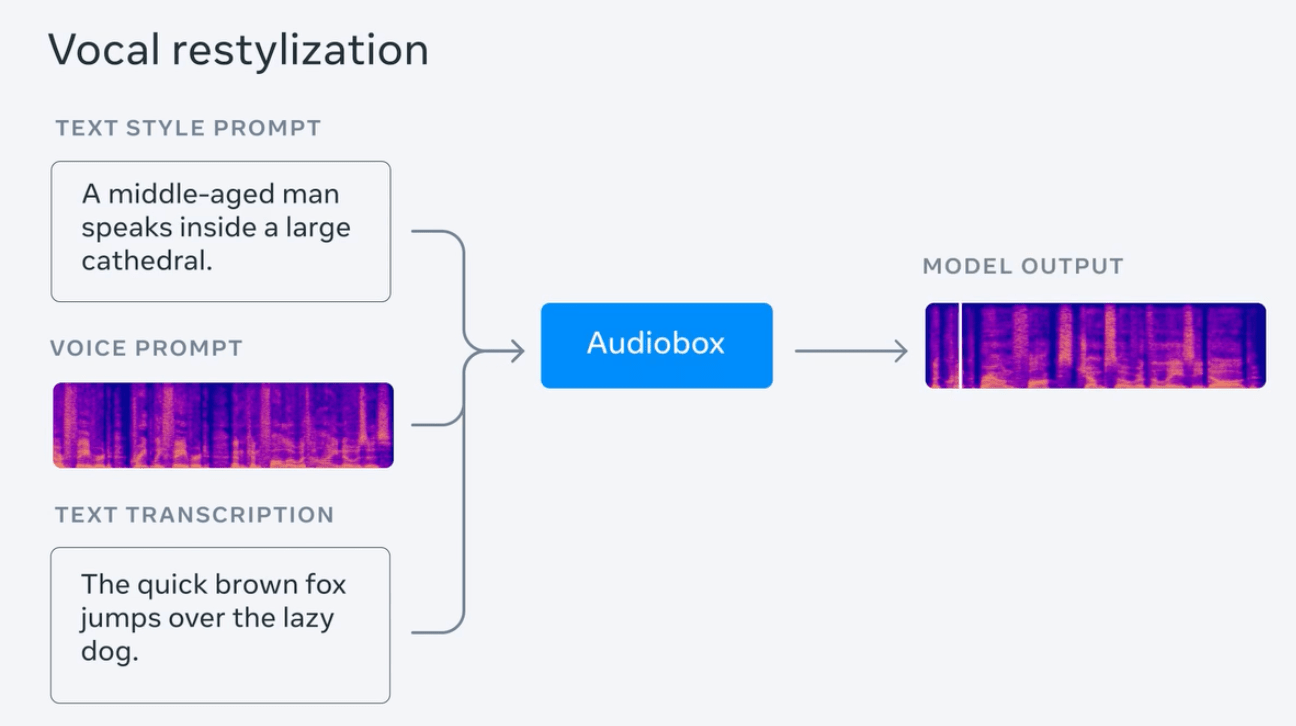

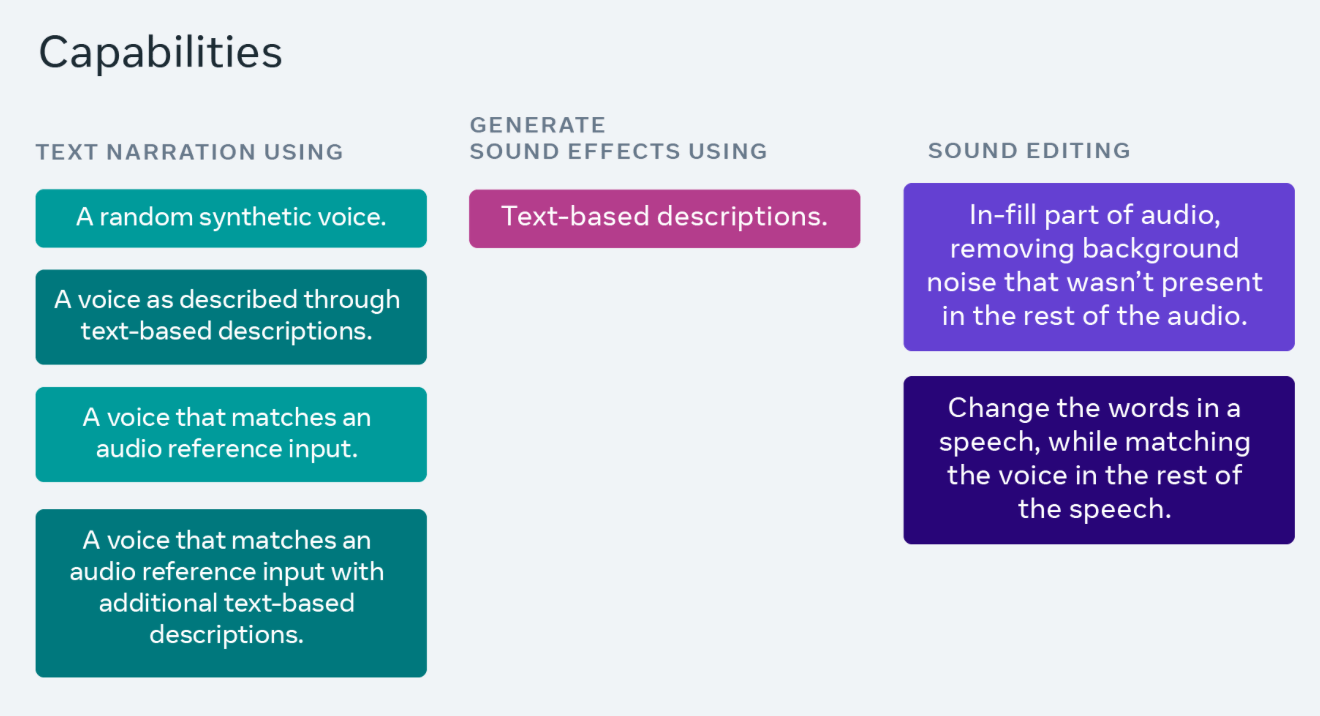

Meta最近推出了一款名为Audiobox的AI声音生成模型。这个模型可以同时接收语音和文字输入,用户可以通过语音和文字描述来生成所需的音频

据悉,这款模型基于 Meta 今年 6 月推出的 Voicebox AI 模型,据称 Audiobox 能生成各种环境音、自然对话语音,并整合了音频生成和编辑能力,以便于用户自由生成自己所需的音频。

Meta 介绍称,生成高品质音频需要有大量音频库及深厚的领域知识,但大众难以获得这些资源,而该公司推出这个模型旨在降低声音生成门槛,让任何人都更容易制作视频、游戏等应用场景的音效。

IT之家发现,这款 Audiobox 模型基于 Voicebox 的“引导声音”机制,以便于生成目标音频,并配合“流量比对(flow-matching)”扩散模型生成方法,以实现“声音填充(audio infilling)”功能,从而生成多层次的音频。

Meta 测试生成带有雷暴声的下雨音频,并输入一系列提示句进行演示,例如“流水声伴随鸟鸣”、“以高音调快节奏说话的年轻女性”等;同时测试了同时输入人声及文字提示,以生成带有情绪(“哀痛而缓慢”)并拥有背景音(身处教堂)的语音。

Meta 声称,Audiobox 在音质及“生成内容的准确度” 顺利击败了 AudioLDM2、VoiceLDM 及 TANGO,超越了现有最佳的音频生成模型。

目前 Audiobox 已经开放向特定研究人员及学术界试用,以供测试模型品质及安全性,Meta 声称,他们计划“再过几周将社会全面公开该模型”。

以上是Meta 推出 AI 音频模型 Audiobox,支持语音及文字同时输入的详细内容。更多信息请关注PHP中文网其他相关文章!

声明:

本文转载于:sohu.com。如有侵权,请联系admin@php.cn删除