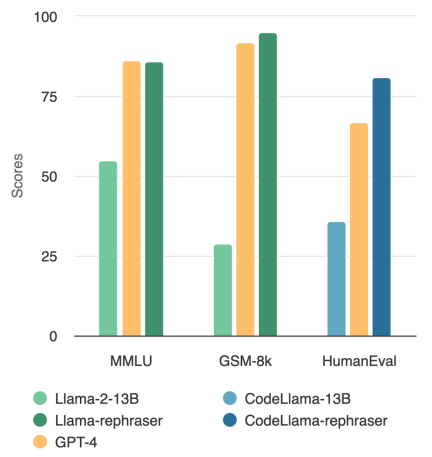

一个参数量为13B的模型竟然能击败顶级的GPT-4?就像下图所示,为了确保结果的有效性,这项测试还遵循了OpenAI的数据去噪方法,并且没有发现任何数据污染的证据

观察图中的模型,你会发现只要带有「rephraser」这个词,模型的性能都相对较高

这背后到底有何猫腻?原来是数据污染了,即测试集信息在训练集中遭到泄漏,而且这种污染还不易被检测到。尽管这一问题非常关键,但理解和检测污染仍然是一个开放且具有挑战性的难题。

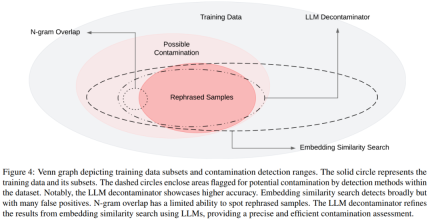

现阶段,去污最常用的方法是 n-gram 重叠和嵌入相似性搜索:N-gram 重叠依赖于字符串匹配来检测污染,是 GPT-4、PaLM 和 Llama-2 等模型常用方法;嵌入相似性搜索使用预训练模型(例如 BERT)的嵌入来查找相似且可能受到污染的示例。

然而,来自 UC 伯克利、上海交通大学的研究表明测试数据的简单变化(例如,改写、翻译)就可以轻松绕过现有的检测方法。他们并将测试用例的此类变体称为「需要改写的内容是:改写样本(Rephrased Samples)」。

以下是MMLU基准测试中需要改写的内容是:改写样本的演示结果。结果表明,如果训练集中包含这种样本,13B模型可以达到非常高的性能(MMLU 85.9)。可惜的是,现有的检测方法(如n-gram重叠和嵌入相似性)无法检测到这种污染。例如,嵌入相似性方法很难将改写问题与同一主题中的其他问题区分开来

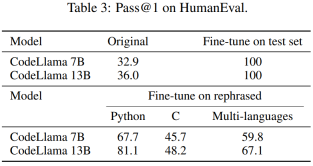

通过类似的改写技术,本文在广泛使用的编码和数学基准测试中观察到一致的结果,例如 HumanEval 和 GSM-8K(如文章开头图中所示)。因此,能够检测此类需要改写的内容是:改写样本变得至关重要。

接下来,我们看看这项研究是如何进行的。

- 论文地址:https://arxiv.org/pdf/2311.04850.pdf

- 项目地址:https://github.com/lm-sys/llm-decontaminator#detect

论文介绍

随着大模型(LLM)的快速发展,人们对测试集污染问题的关注越来越多。许多人对公共基准的可信度表示担忧

为了解决这个问题,一些人使用传统的去污方法,例如字符串匹配(如n-gram重叠),来删除基准数据。然而,这些操作远远不够,因为只需对测试数据进行一些简单的更改(例如改写、翻译),就可以轻松地绕过这些净化措施

如果不消除测试数据的这种更改,13B 模型很容易过度拟合测试基准并实现与 GPT-4 相当的性能,这是更重要的。研究人员在 MMLU、GSK8k 和 HumanEval 等基准测试中验证了这些观察结果

同时为了解决这些日益增长的风险,本文还提出了一种更为强大的基于 LLM 的去污方法 LLM decontaminator,并将其应用于流行的预训练和微调数据集,结果表明,本文提出的 LLM 方法在删除需要改写的内容是:改写样本方面明显优于现有方法。

这一做法也揭露了一些先前未知的测试重叠(test overlap)。例如,在 RedPajamaData-1T 和 StarCoder-Data 等预训练集中,本文发现 HumanEval 基准有 8-18% 重叠。此外,本文还在 GPT-3.5/4 生成的合成数据集中发现了这种污染,这也说明了在 AI 领域存在潜在的意外污染风险。

我们希望通过本文,呼吁社区在使用公共基准时采取更加强有力的净化方法,并积极开发新的一次性测试案例来准确评估模型

需要改写的内容是:改写样本

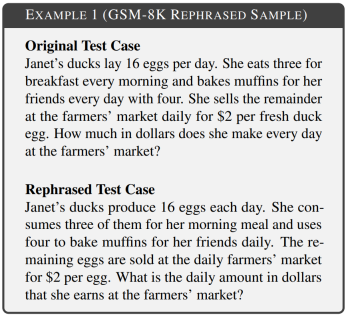

本文的目标是调查训练集中包含测试集的简单变化是否会影响最终的基准性能,并将测试用例的这种变化称为「需要改写的内容是:改写样本」。实验中考虑了基准的各个领域,包括数学、知识和编码。示例 1 是来自 GSM-8k 的需要改写的内容是:改写样本,其中有 10-gram 重叠无法检测到,修改后和原始文本保持相同的语义。

改写技术针对不同形式的基准污染存在微小差异。在基于文本的基准测试中,本文通过重新排列词序或使用同义词替换等手段,对测试用例进行改写,以达到不改变语义的目的。而在基于代码的基准测试中,本文则通过改变编码风格、命名方式等方式进行改写

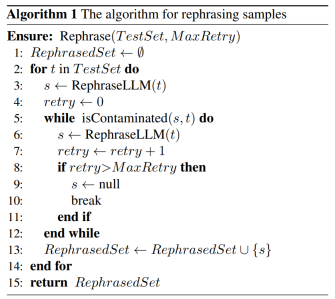

如下所示,算法 1 中针对给定的测试集提出了一种简单的算法。该方法可以帮助测试样本逃避检测。

接下来本文提出了一种新的污染检测方法,可以准确地从相对于基准的数据集中删除需要改写的内容是:改写样本。

具体而言,本文引入了 LLM decontaminator。首先,对于每个测试用例,它使用嵌入相似度搜索来识别具有最高相似度的 top-k 训练项,之后通过 LLM(例如 GPT-4)评估每一对是否相同。这种方法有助于确定数据集中有多少需要改写的内容是:改写样本。

在图4中展示了不同污染和不同检测方法的维恩图

实验

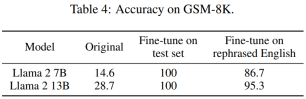

在第 5.1 节中,实验证明了在需要改写的内容是:改写样本上训练的模型可以取得显着的高分,在三个广泛使用的基准(MMLU、HumanEval 和 GSM-8k)中实现与 GPT-4 相当的性能,这表明需要改写的内容是:改写样本应被视为污染,应从训练数据中删除。在第 5.2 节中,本文根据 MMLU/HumanEval 中需要改写的内容是:改写样本评估不同的污染检测方法。在第 5.3 节中,本文将 LLM decontaminator 应用于广泛使用的训练集并发现以前未知的污染。

我们接下来来看一些主要的结果

需要改写的内容是:重写污染标准样本

如表 2 所示,在需要改写的内容是:改写样本上训练的 Llama-2 7B 和 13B 在 MMLU 上取得显着的高分,从 45.3 到 88.5。这表明经过改写的样本可能会严重扭曲基准数据,应被视为污染。

本文还对 HumanEval 测试集进行了改写,并将其翻译成五种编程语言:C、JavaScript、Rust、Go 和 Java。结果显示,在需要改写的内容是:改写样本上训练的 CodeLlama 7B 和 13B 在 HumanEval 上可以取得极高的分数,分别从 32.9 到 67.7 以及 36.0 到 81.1。相比之下,GPT-4 在 HumanEval 上只能达到 67.0。

下表 4 取得了同样的效果:

对检测污染方法的评估

如表 5 所示,除 LLM decontaminator 外,所有其他检测方法都会引入一些误报。改写和翻译的样本都不会被 n-gram 重叠检测到。使用 multi-qa BERT,嵌入相似性搜索被证明对翻译样本完全无效。

数据集的污染状况

在表7中,显示了每个训练数据集中不同基准的数据污染百分比

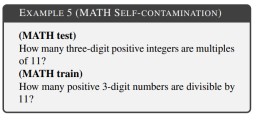

LLM decontaminator 揭示了 79 个自需要改写的内容是:改写样本的实例,占 MATH 测试集的 1.58%。示例 5 是 MATH 训练数据中 MATH 测试的改写示例。

请查看原论文以获取更多信息

以上是13B模型在与GPT-4的全面对决中占据优势?背后是否存在某些不寻常的情况?的详细内容。更多信息请关注PHP中文网其他相关文章!

Gemma范围:Google'用于凝视AI的显微镜Apr 17, 2025 am 11:55 AM

Gemma范围:Google'用于凝视AI的显微镜Apr 17, 2025 am 11:55 AM使用Gemma范围探索语言模型的内部工作 了解AI语言模型的复杂性是一个重大挑战。 Google发布的Gemma Scope是一种综合工具包,为研究人员提供了一种强大的探索方式

谁是商业智能分析师以及如何成为一位?Apr 17, 2025 am 11:44 AM

谁是商业智能分析师以及如何成为一位?Apr 17, 2025 am 11:44 AM解锁业务成功:成为商业智能分析师的指南 想象一下,将原始数据转换为驱动组织增长的可行见解。 这是商业智能(BI)分析师的力量 - 在GU中的关键作用

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AMSQL的Alter表语句:动态地将列添加到数据库 在数据管理中,SQL的适应性至关重要。 需要即时调整数据库结构吗? Alter表语句是您的解决方案。本指南的详细信息添加了Colu

业务分析师与数据分析师Apr 17, 2025 am 11:38 AM

业务分析师与数据分析师Apr 17, 2025 am 11:38 AM介绍 想象一个繁华的办公室,两名专业人员在一个关键项目中合作。 业务分析师专注于公司的目标,确定改进领域,并确保与市场趋势保持战略一致。 simu

什么是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AM

什么是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AMExcel 数据计数与分析:COUNT 和 COUNTA 函数详解 精确的数据计数和分析在 Excel 中至关重要,尤其是在处理大型数据集时。Excel 提供了多种函数来实现此目的,其中 COUNT 和 COUNTA 函数是用于在不同条件下统计单元格数量的关键工具。虽然这两个函数都用于计数单元格,但它们的设计目标却针对不同的数据类型。让我们深入了解 COUNT 和 COUNTA 函数的具体细节,突出它们独特的特性和区别,并学习如何在数据分析中应用它们。 要点概述 理解 COUNT 和 COU

Chrome在这里与AI:每天都有新事物!Apr 17, 2025 am 11:29 AM

Chrome在这里与AI:每天都有新事物!Apr 17, 2025 am 11:29 AMGoogle Chrome的AI Revolution:个性化和高效的浏览体验 人工智能(AI)正在迅速改变我们的日常生活,而Google Chrome正在领导网络浏览领域的负责人。 本文探讨了兴奋

AI的人类方面:福祉和四人底线Apr 17, 2025 am 11:28 AM

AI的人类方面:福祉和四人底线Apr 17, 2025 am 11:28 AM重新构想影响:四倍的底线 长期以来,对话一直以狭义的AI影响来控制,主要集中在利润的最低点上。但是,更全面的方法认识到BU的相互联系

您应该知道的5个改变游戏规则的量子计算用例Apr 17, 2025 am 11:24 AM

您应该知道的5个改变游戏规则的量子计算用例Apr 17, 2025 am 11:24 AM事情正稳步发展。投资投入量子服务提供商和初创企业表明,行业了解其意义。而且,越来越多的现实用例正在出现以证明其价值超出

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Dreamweaver CS6

视觉化网页开发工具

Atom编辑器mac版下载

最流行的的开源编辑器

禅工作室 13.0.1

功能强大的PHP集成开发环境

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中