阿里巨型模型再次开源!图像理解与物体识别功能一应俱全,基于通用问题集7B训练,商业应用可行

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB转载

- 2023-09-03 13:01:08800浏览

阿里巴巴开源了一个新的大模型,非常令人兴奋~

继通义千问-7B(Qwen-7B)之后,阿里云又推出了大规模视觉语言模型Qwen-VL,并且一上线就直接开源。

Qwen-VL是一种基于通义千问-7B的多模态大模型,具体而言,它支持图像、文本和检测框等多种输入,并且不仅仅可以输出文本,还可以输出检测框

举个例子,我们输入一张阿尼亚的图片,通过问答的形式,Qwen-VL-Chat能够总结图片内容,并且能够准确地定位到图片中的阿尼亚

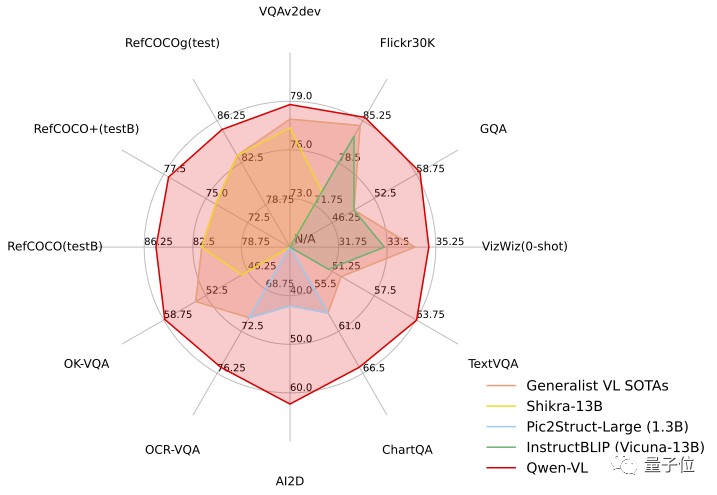

在测试任务中,Qwen-VL展现出了“六边形战士”的实力,在四大类多模态任务的标准英文测评中(Zero-shot Caption/VQA/DocVQA/Grounding)上,都取得了最先进的成果

一经开源消息传出,立刻引起了广泛关注

让我们一起来看看具体的表现如何吧!

首个支持中文开放域定位的通用模型

首先,让我们来整体看一下Qwen-VL系列模型的特点:

- 多语言对话:支持多语言对话,端到端支持图片里中英双语的长文本识别;

- 多图交错对话:支持多图输入和比较,指定图片问答,多图文学创作等;

- 首个支持中文开放域定位的通用模型:通过中文开放域语言表达进行检测框标注,也就是能在画面中精准地找到目标物体;

- 细粒度识别和理解:相比于目前其它开源LVLM(大规模视觉语言模型)使用的224分辨率,Qwen-VL是首个开源的448分辨率LVLM模型。更高分辨率可以提升细粒度的文字识别、文档问答和检测框标注。

在不改变原意的情况下,需要重写的内容是:Qwen-VL可以在知识问答、图像问答、文档问答、细粒度视觉定位等场景中使用

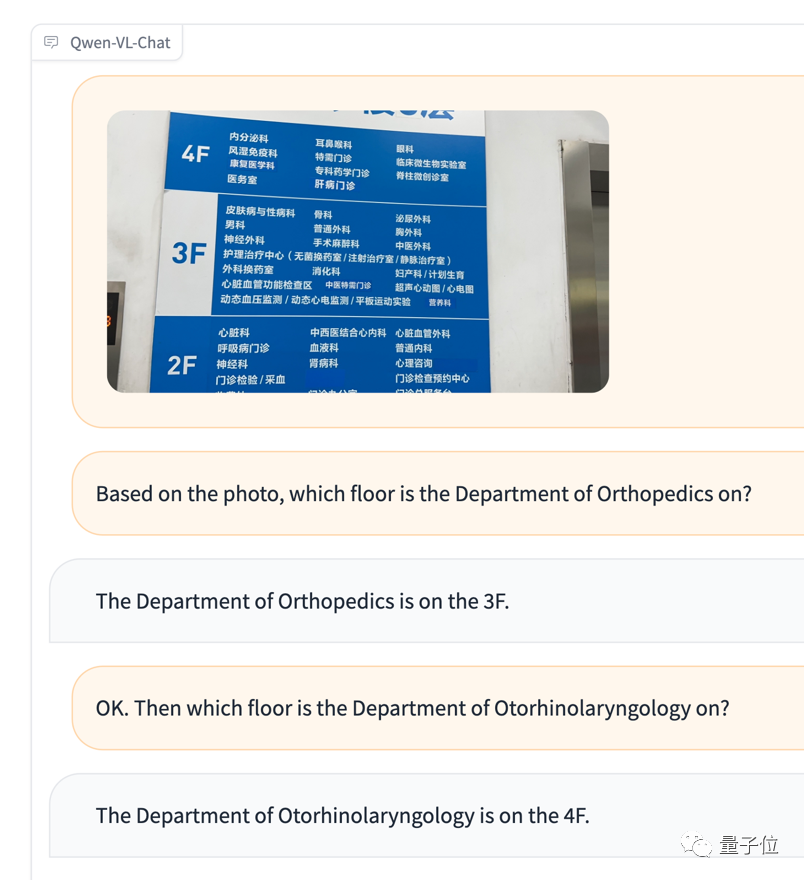

例如,有一个外国朋友不懂中文去医院看病,对着导览图感到困惑,不知道如何前往相应的科室,可以直接将图和问题交给Qwen-VL,让它根据图片信息充当翻译

再次进行多图输入和比较的测试

尽管没有认出阿尼亚,但情绪判断确实相当准确(手动狗头)

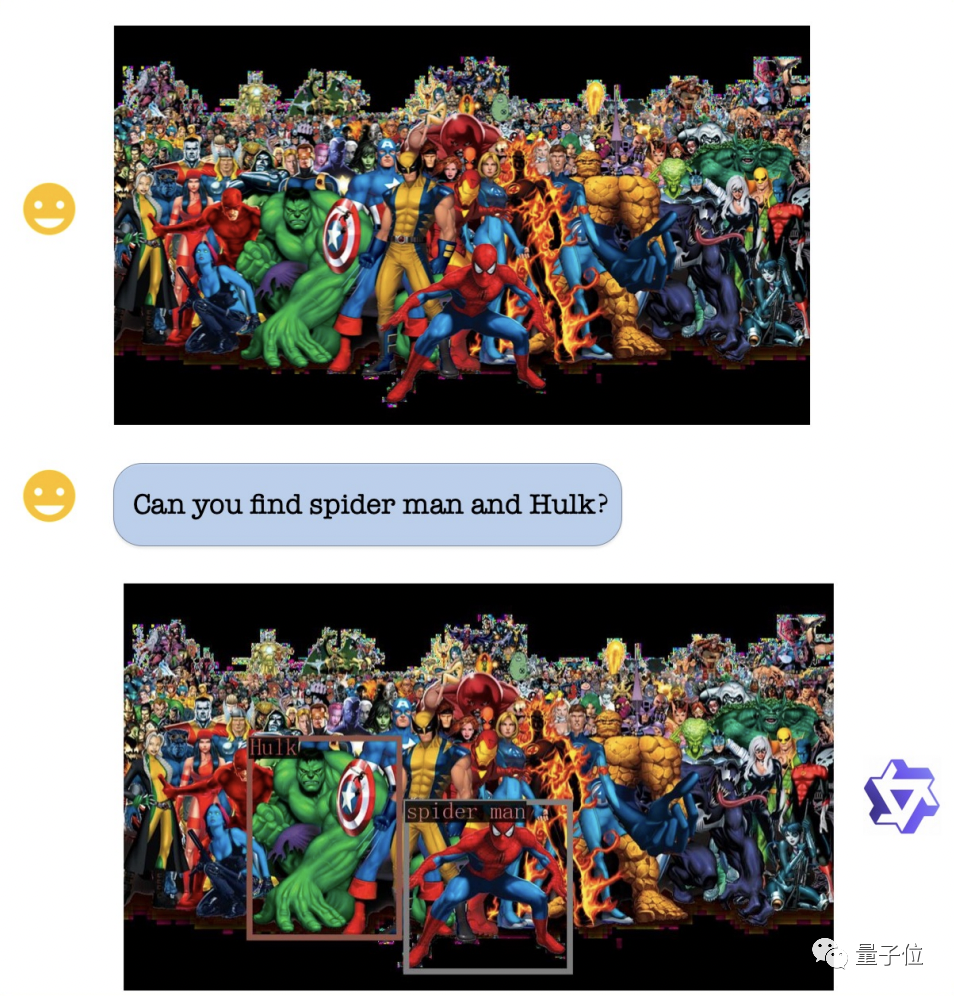

在视觉定位能力方面,即使图片非常复杂且人物众多,Qwen-VL仍然可以根据要求准确地找出绿巨人和蜘蛛侠

Qwen-VL在技术细节上以Qwen-7B为基座语言模型,并通过引入视觉编码器ViT和位置感知的视觉语言适配器,使得模型能够支持视觉信号输入

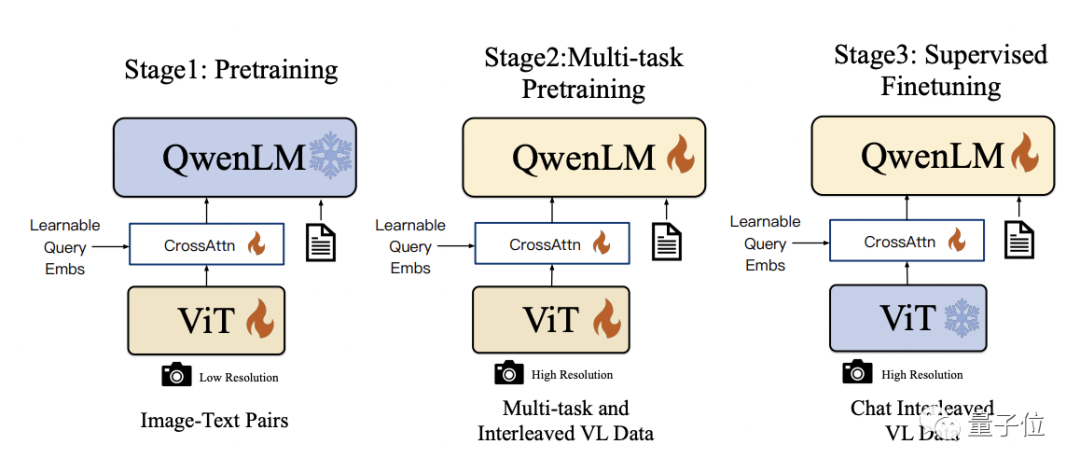

具体的训练过程分为三步:

- 预训练:只优化视觉编码器和视觉语言适配器,冻结语言模型。使用大规模图像-文本配对数据,输入图像分辨率为224x224。

- 多任务预训练:引入更高分辨率(448x448)的多任务视觉语言数据,如VQA、文本VQA、指称理解等,进行多任务联合预训练。

- 监督微调:冻结视觉编码器,优化语言模型和适配器。使用对话交互数据进行提示调优,得到最终的带交互能力的Qwen-VL-Chat模型。

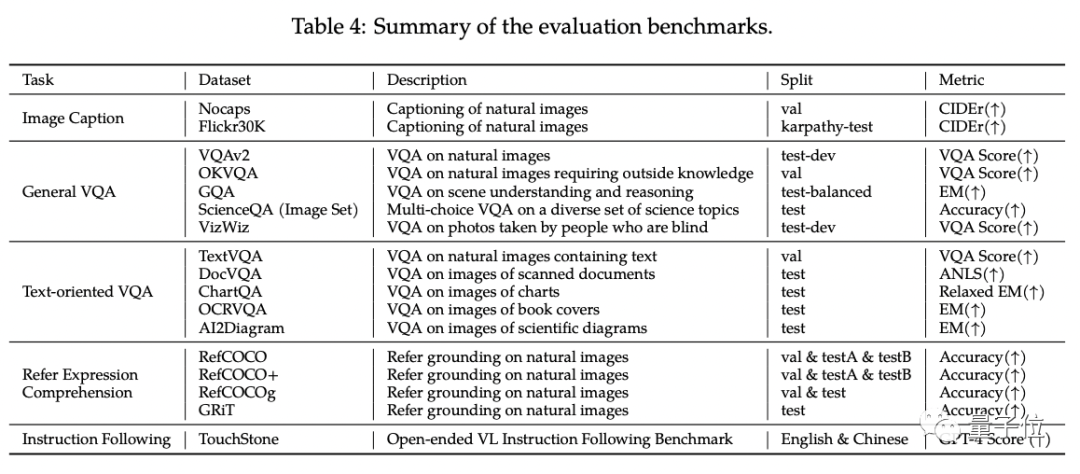

在Qwen-VL的标准英文测评中,研究人员对四大类多模态任务(Zero-shot Caption/VQA/DocVQA/Grounding)进行了测试

根据结果显示,Qwen-VL在与同等尺寸的开源LVLM进行比较时取得了最佳效果

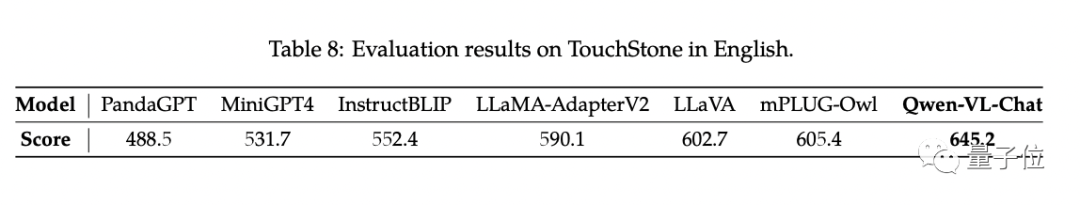

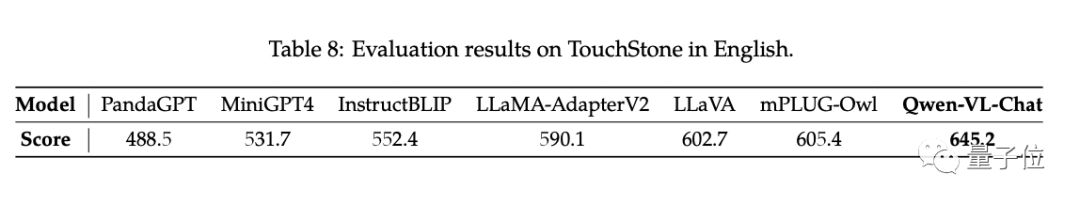

另外,研究人员构建了一套基于GPT-4打分机制的测试集TouchStone。

Qwen-VL-Chat在这项对比测试中取得了最先进技术水平(SOTA)

如果你对Qwen-VL感兴趣,你可以在魔搭社区和huggingface上找到demo来直接试玩。链接在文末提供

Qwen-VL支持研究人员和开发者进行二次开发,并且允许商业使用。但需要注意的是,如果要进行商业使用,需要先填写问卷申请

项目链接:https://modelscope.cn/models/qwen/Qwen-VL/summary

https://modelscope.cn/models/qwen/Qwen-VL-Chat/summary

https://huggingface.co/Qwen/Qwen-VL

https://huggingface.co/Qwen/Qwen-VL-Chat

https://github.com/QwenLM/Qwen-VL

请点击以下链接查看论文:https://arxiv.org/abs/2308.12966

以上是阿里巨型模型再次开源!图像理解与物体识别功能一应俱全,基于通用问题集7B训练,商业应用可行的详细内容。更多信息请关注PHP中文网其他相关文章!