如何优化C++大数据开发中的数据重复检测?

在C++大数据开发过程中,数据重复检测是一个非常常见且重要的任务。数据重复可能会导致程序运行效率低下,占用大量的存储空间,还可能导致数据分析结果的不准确。因此,优化数据重复检测的算法对于提高程序的性能和准确性至关重要。本文将介绍几种常用的优化方法,并提供相应的代码示例。

一、哈希表方法

哈希表是一种常用的数据结构,可以快速判断一个元素是否存在于集合中。在数据重复检测中,我们可以使用哈希表来记录已经出现过的数据,通过查询哈希表来判断新的数据是否已经存在。这种方法的时间复杂度为O(1),非常高效。

示例代码如下:

#include <iostream>

#include <unordered_set>

using namespace std;

bool hasDuplicate(int arr[], int size) {

unordered_set<int> hashSet;

for (int i = 0; i < size; i++) {

if (hashSet.find(arr[i]) != hashSet.end()) {

return true;

}

hashSet.insert(arr[i]);

}

return false;

}

int main() {

int arr[] = {1, 2, 3, 4, 5, 6, 7};

int size = sizeof(arr) / sizeof(arr[0]);

if (hasDuplicate(arr, size)) {

cout << "存在重复数据" << endl;

} else {

cout << "不存在重复数据" << endl;

}

return 0;

}二、排序方法

另一种常用的优化方法是先对数据进行排序,然后逐个比较相邻的元素是否相等。如果有相等的元素,说明存在重复数据。排序方法的时间复杂度为O(nlogn),相对哈希表方法略低一些。

示例代码如下:

#include <iostream>

#include <algorithm>

using namespace std;

bool hasDuplicate(int arr[], int size) {

sort(arr, arr + size);

for (int i = 1; i < size; i++) {

if (arr[i] == arr[i - 1]) {

return true;

}

}

return false;

}

int main() {

int arr[] = {7, 4, 5, 2, 1, 3, 6};

int size = sizeof(arr) / sizeof(arr[0]);

if (hasDuplicate(arr, size)) {

cout << "存在重复数据" << endl;

} else {

cout << "不存在重复数据" << endl;

}

return 0;

}三、位图方法

对于大规模数据的重复检测,位图方法是一种非常高效的优化技术。位图是一种用于存储大量布尔值的数据结构,可以有效地节省存储空间,并且支持常数时间的查询和修改操作。

示例代码如下:

#include <iostream>

#include <vector>

using namespace std;

bool hasDuplicate(int arr[], int size) {

const int MAX_VALUE = 1000000; // 数组元素的最大值

vector<bool> bitmap(MAX_VALUE + 1); // 初始化位图,存储MAX_VALUE+1个布尔值,默认为false

for (int i = 0; i < size; i++) {

if (bitmap[arr[i]]) {

return true;

}

bitmap[arr[i]] = true;

}

return false;

}

int main() {

int arr[] = {1, 2, 3, 4, 5, 5, 6};

int size = sizeof(arr) / sizeof(arr[0]);

if (hasDuplicate(arr, size)) {

cout << "存在重复数据" << endl;

} else {

cout << "不存在重复数据" << endl;

}

return 0;

}通过使用上述优化方法,我们可以大大提高数据重复检测的效率和准确性。具体选择哪种方法取决于具体的问题场景和数据规模。在实际应用中,还可以根据具体需求对这些方法进行进一步的优化和扩展,以满足不同的需求。

总结起来,优化C++大数据开发中数据重复检测的方法包括哈希表、排序和位图等。这些方法可以提高程序的性能和准确性,使得大数据开发更加高效和可靠。在实际应用中,我们可以根据具体需求选择适合的方法,并根据实际情况进行优化和扩展。

以上是如何优化C++大数据开发中的数据重复检测?的详细内容。更多信息请关注PHP中文网其他相关文章!

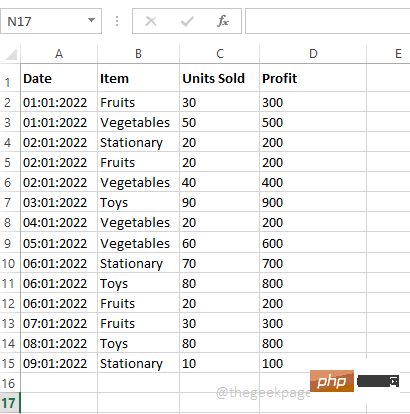

在 Microsoft Excel 中如何创建数据透视表Apr 22, 2023 pm 12:10 PM

在 Microsoft Excel 中如何创建数据透视表Apr 22, 2023 pm 12:10 PM当您拥有大量数据时,分析数据通常会变得越来越困难。但真的必须如此吗?MicrosoftExcel提供了一个令人惊叹的内置功能,称为数据透视表,可用于轻松分析庞大的数据块。它们可用于通过创建您自己的自定义报告来有效地汇总您的数据。它们可用于自动计算列的总和,可以对其应用过滤器,可以对其中的数据进行排序等。可以对数据透视表执行的操作以及如何使用数据透视表为了缓解您的日常excel障碍是无止境的。继续阅读,了解如何轻松创建数据透视表并了解如何有效组织它。希望你喜欢阅读这篇文章。第1节:什么是数据透视

如何阻止 Apple 在 iPhone 上收集诊断和使用数据Apr 16, 2023 pm 09:25 PM

如何阻止 Apple 在 iPhone 上收集诊断和使用数据Apr 16, 2023 pm 09:25 PM苹果以其对用户隐私的承诺而闻名。当您购买iPhone或Mac时,您知道您正在投资一家承诺保护您的数据的公司的产品。这在我们这个时代非常重要——因为我们越来越多地将更多的个人信息存储在这些设备上。我们使用的大多数设备都会收集使用数据以改进相应的产品和服务。例如,当应用程序在您的手机上崩溃时,可以通知开发人员以帮助他们查明此错误的原因。虽然这些数据通常是匿名的,但一些用户不喜欢让公司收集他们的日志。此外,通过共享这些诊断信息,您的设备会将它们上传到公司的服务器。这可能会耗尽您的(有限)数据计划和部分

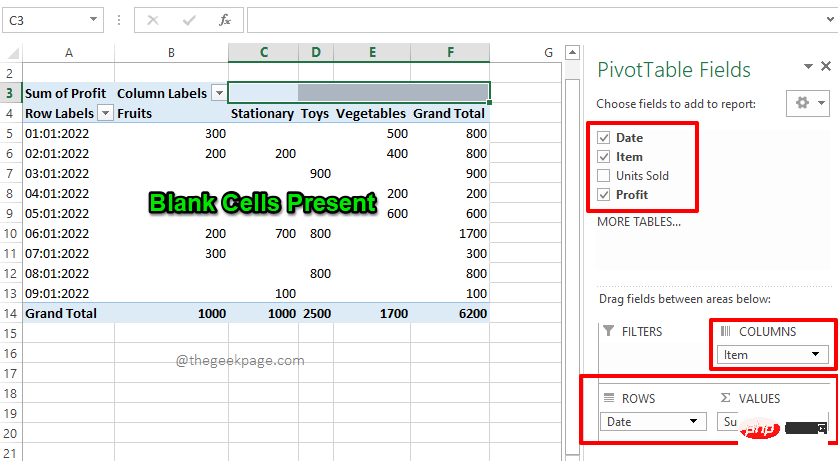

如何用零替换 Excel 数据透视表中的空白单元格Apr 15, 2023 am 11:52 AM

如何用零替换 Excel 数据透视表中的空白单元格Apr 15, 2023 am 11:52 AM了COLUMNS部分下的字段Item、ROWS部分下的字段Date和VALUES部分下的Profit字段。注意:如果您需要有关数据透视表如何工作以及如何有效地创建数据透视表的更多信息,请参阅我们的文章如何在MicrosoftExcel中创建数据透视表。因此,根据我的选择,我的数据透视表生成如下面的屏幕截图所示,使其成为我想要的完美摘要报告。但是,如果您查看数据透视表,您会发现我的数据透视表中有一些空白单元格。现在,让我们在接下来的步骤中将它们替换为零。第6步:要用零替换空白单元格,首先右键单击数

AI 算法在大数据治理中的应用Apr 12, 2023 pm 01:37 PM

AI 算法在大数据治理中的应用Apr 12, 2023 pm 01:37 PM本文主要分享 Datacake 在大数据治理中,AI 算法的应用经验。本次分享分为五大部分:第一部分阐明大数据与 AI 的关系,大数据不仅可以服务于 AI,也可以使用 AI 来优化自身服务,两者是互相支撑、依赖的关系;第二部分介绍利用 AI 模型综合评估大数据任务健康度的应用实践,为后续开展数据治理提供量化依据;第三部分介绍利用 AI 模型智能推荐 Spark 任务运行参数配置的应用实践,实现了提高云资源利用率的目标;第四部分介绍在 SQL 查询场景中,由模型智能推荐任务执行引擎的实践;第五部分

如何在 Microsoft Excel 图表中添加和自定义数据标签?May 07, 2023 pm 04:22 PM

如何在 Microsoft Excel 图表中添加和自定义数据标签?May 07, 2023 pm 04:22 PMMicrosoft Excel有许多至今令人们惊叹的功能。人们每天都会学到一些新东西。今天,我们将了解如何在Excel图表中添加和自定义数据标签。Excel图表包含大量数据,一眼看懂图表可能具有挑战性。使用数据标签是指出重要信息的好方法。数据标签可以用作柱形图或条形图的一部分。当您创建饼图时,它甚至可以用作标注。添加数据标签为了展示如何添加数据标签,我们将以饼图为例。虽然大多数人使用图例来显示饼图中的内容,但数据标签的效率要高得多。要添加数据标签,请创建饼图。打开它,然后单击显示图表设计

腾讯广告模型基于"太极"的训练成本优化实践Apr 14, 2023 pm 06:46 PM

腾讯广告模型基于"太极"的训练成本优化实践Apr 14, 2023 pm 06:46 PM近年来,大数据加大模型成为了AI领域建模的标准范式。在广告场景,大模型由于使用了更多的模型参数,利用更多的训练数据,模型具备了更强的记忆能力和泛化能力,为广告效果向上提升打开了更大的空间。但是大模型在训练过程中所需要的资源也是成倍的增长,存储以及计算上的压力对机器学习平台都是巨大的挑战。腾讯太极机器学习平台持续探索降本增效方案,在广告离线训练场景利用混合部署资源大大降低了资源成本,每天为腾讯广告提供50W核心廉价混合部署资源,帮助腾讯广告离线模型训练资源成本降低30%,同时通过一系列优化手段使得

如何使用 Go 语言进行大数据分析?Jun 11, 2023 am 11:11 AM

如何使用 Go 语言进行大数据分析?Jun 11, 2023 am 11:11 AM随着数据规模逐渐增大,大数据分析变得越来越重要。而Go语言作为一门快速、轻量级的编程语言,也成为了越来越多数据科学家和工程师的选择。本文将介绍如何使用Go语言进行大数据分析。数据采集在开始大数据分析之前,我们需要先采集数据。Go语言有很多包可以用于数据采集,例如“net/http”、“io/ioutil”等。通过这些包,我们可以从网站、API、日志

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境