想象一下,您正在参加一个充满活力的鸡尾酒会,局间充满了热烈的谈话声和玻璃杯碰撞的叮当声。

此时,您作为一个悠闲的观察者,怡然自得地躲在角落里。然而,就算没有处在聚会的中心,您还是可以轻松地弄清楚不同人之间的社会关系,了解正在发生的事情,甚至通过阅读人们的言语和非言语线索来读懂明里暗里的社交信息。

如果一个LLM能够复现这种水平的社交能力呢?这不,Koko Mind就是这么个东西。

随便打开一个视频,该模型就开始分析人物表情,得出人物情绪的结论。

然后,在右侧的prompt栏还可以提出问题,让AI进一步分析视频中暗流涌动的社交谜题。

(说实话对有些人来说这都很难)

图片

图片

Koko Mind包含了150个复杂的多方社交互动以及自由文本问题和答案。

为了确保数据的多样性和可扩展性,并避免数据污染,所有社交互动、问题和答案均由GPT-4生成,并随后由人类专家验证。

分析数据基于三个不同的来源:

-

GPT-4-only:该子集仅由 GPT-4 通过提示创建。

-

基于电影:为了避免数据污染,这部分数据基于从2022年之后上映的电影中提取的各种场景。GPT-4负责塑造这些场景,在保留核心本质的同时添加了自己的元素。

- 基于 ToMi:该部分包含由模拟数据集ToMi支持的数据,其中涉及将物理对象移动到不同的地方,这是心理理论的经典测试。当然,这些社交互动还得被GPT-4修饰和扩展一下。

三种数据来源的占比如下:

图片

图片

对于每次社交互动,研究人员都会提出各种问题,旨在探讨以下几个和社交理解息息相关的方面。

-

心理理论:评估对其他人心理状态和观点的理解的问题。

-

社会规范:旨在辨别情境中的社会价值观和规范的问题。

-

情绪识别:旨在识别和理解上下文中的情绪元素的问题。

-

社会关系:关注人际动态和关系。

-

反事实问题:旨在探索替代结果或可能性的假设查询。

- 社会建议:提出与特定情况相关的建议或行动建议的问题。

研究人员以text-davinci-003 作为参考,评估了AlpacaEval后的不同模型。

其中,研究人员从上下文中删除了括号中的非语言线索(例如,紧张地喝咖啡等)。

以下则是一些有趣的要点:

-

在两个模型中,与Claude相比,GPT-4在识别获胜模型方面表现出更大的确定性和信心。

-

当上下文没有非语言线索,且交互要么完全由GPT-4生成,要么基于电影时,Claude的表现优于 GPT-4。

- 而如果上下文包含了非语言线索,那GPT-4总是比Claude更好。

(一种可能的解释是,GPT-4是一种多模态模型可以更好地理解额外的非语言信息。)

在博客中,研究人员绘制了表格,可以清晰的看到各个模型的表现。

图片

图片

结果虽然在很多方面都令人兴奋,但也有一定的局限性。首先, Koko Mind的规模相对较小,这可能会限制研究人员结论的广泛适用性和全面性。

其次, Koko Mind中的所有交互都是由GPT-4生成的,需要人工验证,这使得数据集难以扩展。

另外,虽然Koko Mind在数据集中提供了经过人工验证的答案,研究人员在评估时没有使用这些答案作为参考,并且由于这些答案是由GPT-4生成的,因此它们可能会偏向GPT-4。

未来的研究可以集中在如何评估模型上具有经过人工验证的机器生成的参考答案。

当然,虽说存在这样或那样的限制,研究人员仍将Koko Mind视为未来与社会智能、多模态语言模型等相关的研究的跳板。

以上是「社交达人」GPT-4!解读表情、揣测心理全都会的详细内容。更多信息请关注PHP中文网其他相关文章!

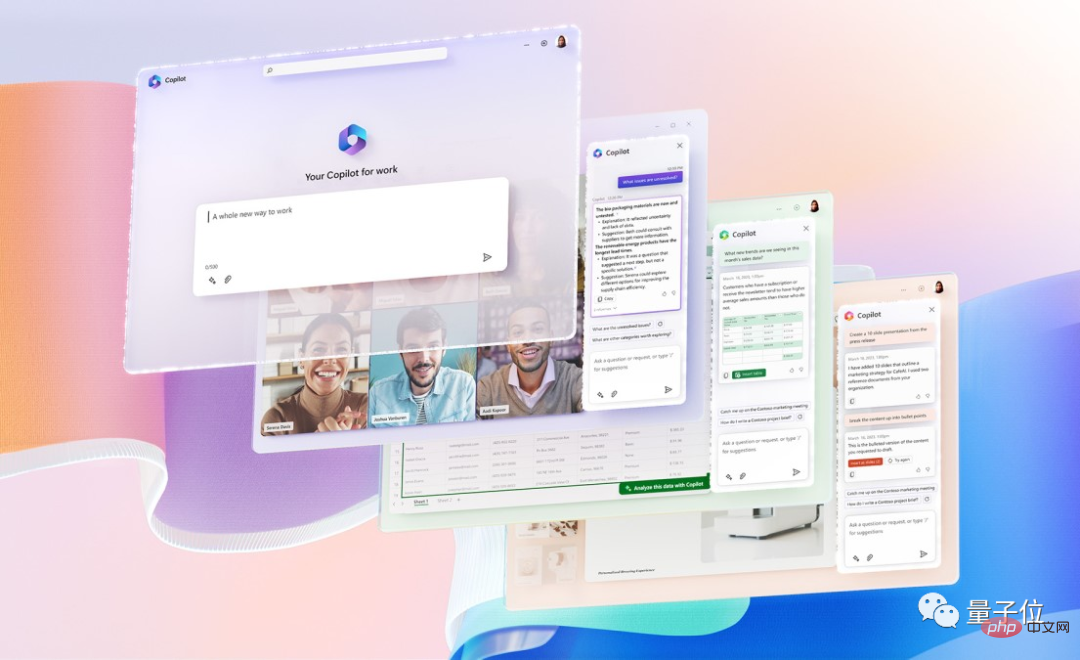

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力Apr 12, 2023 pm 02:40 PM

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力Apr 12, 2023 pm 02:40 PM一觉醒来,工作的方式被彻底改变。微软把AI神器GPT-4全面接入Office,这下ChatPPT、ChatWord、ChatExcel一家整整齐齐。CEO纳德拉在发布会上直接放话:今天,进入人机交互的新时代,重新发明生产力。新功能名叫Microsoft 365 Copilot(副驾驶),与改变了程序员的代码助手GitHub Copilot成为一个系列,继续改变更多人。现在AI不光能自动做PPT,而且能根据Word文档的内容一键做出精美排版。甚至连上台时对着每一页PPT应该讲什么话,都给一起安排

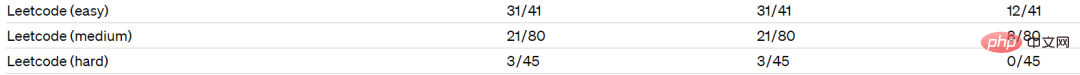

集成GPT-4的Cursor让编写代码和聊天一样简单,用自然语言编写代码的新时代已来Apr 04, 2023 pm 12:15 PM

集成GPT-4的Cursor让编写代码和聊天一样简单,用自然语言编写代码的新时代已来Apr 04, 2023 pm 12:15 PM集成GPT-4的Github Copilot X还在小范围内测中,而集成GPT-4的Cursor已公开发行。Cursor是一个集成GPT-4的IDE,可以用自然语言编写代码,让编写代码和聊天一样简单。 GPT-4和GPT-3.5在处理和编写代码的能力上差别还是很大的。官网的一份测试报告。前两个是GPT-4,一个采用文本输入,一个采用图像输入;第三个是GPT3.5,可以看出GPT-4的代码能力相较于GPT-3.5有较大能力的提升。集成GPT-4的Github Copilot X还在小范围内测中,而

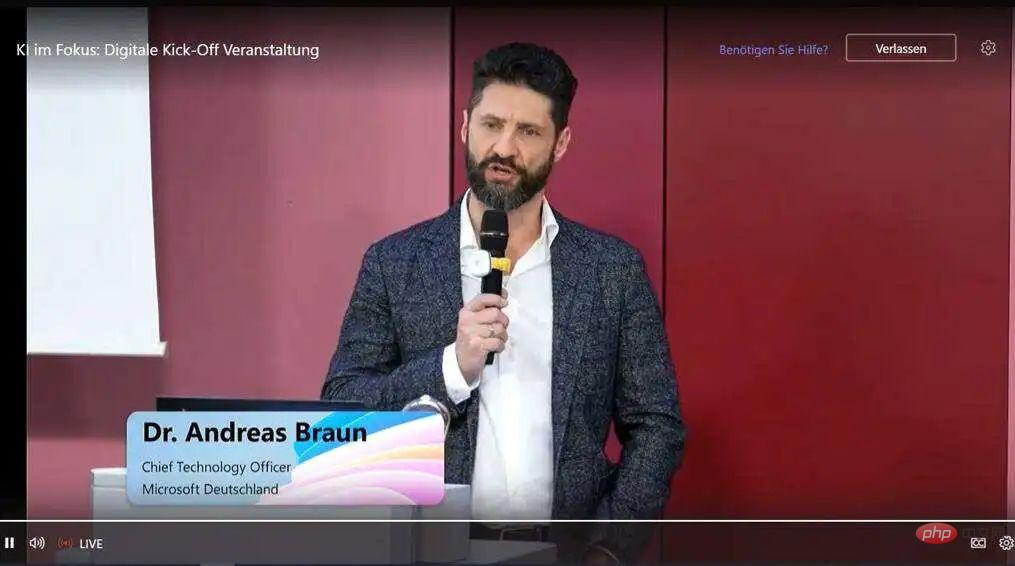

GPT-4的两个谣言和最新预测!Apr 11, 2023 pm 06:07 PM

GPT-4的两个谣言和最新预测!Apr 11, 2023 pm 06:07 PM作者 | 云昭3月9日,微软德国CTO Andreas Braun在AI kickoff会议上带来了一个期待已久的消息:“我们将于下周推出GPT-4,届时我们将推出多模式模式,提供完全不同的可能性——例如视频。”言语之中,他将大型语言模型(LLM)比作“游戏改变者”,因为他们教机器理解自然语言,然后机器以统计的方式理解以前只能由人类阅读和理解的东西。与此同时,这项技术已经发展到“适用于所有语言”:你可以用德语提问,也可以用意大利语回答。借助多模态,微软(-OpenAI)将“使模型变得全面”。那

再一次改变“AI”世界 GPT-4千呼万唤始出来Apr 10, 2023 pm 02:40 PM

再一次改变“AI”世界 GPT-4千呼万唤始出来Apr 10, 2023 pm 02:40 PM近段时间,人工智能聊天机器人ChatGPT刷爆网络,网友们争先恐后去领略它的超高情商和巨大威力。参加高考、修改代码、构思小说……它在广大网友的“鞭策”下不断突破自我,甚至可以用一整段程序,为你拼接出一只小狗。而这些技能只是基于GPT-3.5开发而来,在3月15日,AI世界再次更新,最新版本的GPT-4也被OpenAI发布了出来。与之前相比,GPT-4不仅展现了更加强大的语言理解能力,还能够处理图像内容,在考试中的得分甚至能超越90%的人类。那么,如此“逆天”的GPT-4还具有哪些能力?它又是如何

GPT-4救了我狗的命Apr 04, 2023 pm 12:25 PM

GPT-4救了我狗的命Apr 04, 2023 pm 12:25 PMGPT-4在发布之时公布了一项医学知识测试结果,该测试由美国医师学会开发,最终它答对了75%的问题,相比GPT3.5的53%有很大的飞跃。 这两天,一篇关于“GPT-4救了我狗的命”的帖子属实有点火:短短一两天就有数千人转发,上万人点赞,网友在评论区讨论得热火朝天。△ 是真狗命,not人的“狗命”(Doge)乍一听,大家想必很纳闷:这俩能扯上什么关系?GPT-4还能长眼睛发现狗有什么危险吗?真实的经过是这样子的:当兽医说无能为力时,他问了GPT-4发帖人名叫Cooper。他自述自己养的一条狗子,

GPT-4帮助企业实现数字化转型的五种方法May 05, 2023 pm 12:19 PM

GPT-4帮助企业实现数字化转型的五种方法May 05, 2023 pm 12:19 PM人工智能在过去几十年里发展势头强劲,像GPT-4这样的大型语言模型引起了用户的更多兴趣,他们想知道GPT-4如何支持数字化转型。根据行业媒体的预测,到2024年,GPT-4所基于的ChatGPT深度学习堆栈将产生10亿美元的收入。GPT-4的普及是由于人工智能技术的力量,以及高用户可访问性和广泛的通用性。科技行业的许多不同领域都可以利用GPT-4来自动化和个性化许多任务,使企业员工能够专注于更复杂的任务。以下是GPT-4在几个不同领域促进数字化转型的一些例子。1、个性化员工培训像GPT-4这样的

有没有可能Bing正在集成GPT-4?这是否属实还是无根之论?May 08, 2023 pm 10:37 PM

有没有可能Bing正在集成GPT-4?这是否属实还是无根之论?May 08, 2023 pm 10:37 PM作者|徐杰承在微软NewBing发布前,绝大部分人对其的预测都是——NewBing的整体表现将会与ChatGPT极其相似,即使二者在细节层面存在某些差异,用户也应当无法从体验角度发现这些区别。然而随着NewBing的发布与更新,越来越多的人开始怀疑,微软与OpenAI此前那宗100亿美元的交易,似乎不止关系到ChatGPT这一个“宝贝”。1、微软官宣:集成全新模型虽然NewBing与ChatGPT都基于GPT3.5系列模型微调而成,但在2月中旬,微软宣称已将一种全新的AI语言模型集成到了N

微软 Bing Chat 聊天机器人已升级使用最新 OpenAI GPT-4 技术Apr 12, 2023 pm 10:58 PM

微软 Bing Chat 聊天机器人已升级使用最新 OpenAI GPT-4 技术Apr 12, 2023 pm 10:58 PM3 月 15 日消息,今天 OpenAI 发布了全新的 GPT-4 大型语言模型,随后微软官方宣布,Bing Chat 此前已经升级使用 OpenAI 的 GPT-4 技术。微软公司副总裁兼消费者首席营销官 Yusuf Mehdi 确认 Bing Chat 聊天机器人 AI 已经在 GPT-4 上运行,ChatGPT 基于最新版本 GPT-4,由 OpenAI 开发 。微软 Bing 博客网站上的一篇帖子进一步证实了这一消息。微软表示,如果用户在过去五周内的任何时间使用过新的 Bing 预览版,

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

SublimeText3汉化版

中文版,非常好用

WebStorm Mac版

好用的JavaScript开发工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

SublimeText3 Linux新版

SublimeText3 Linux最新版