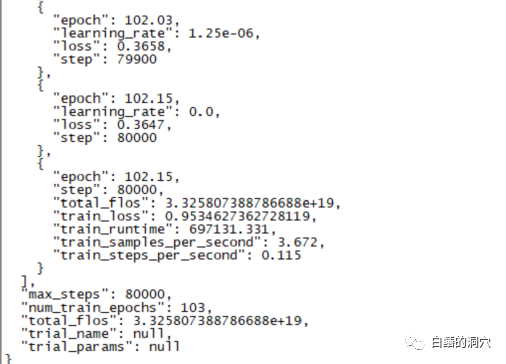

昨天一个跑了220个小时的微调训练完成了,主要任务是想在CHATGLM-6B上微调出一个能够较为精确的诊断数据库错误信息的对话模型来。

不过这个等了将近十天的训练最后的结果令人失望,比起我之前做的一个样本覆盖更小的训练来,差的还是挺大的。

这样的结果还是有点令人失望的,这个模型基本上是没有实用价值的。看样子需要重新调整参数与训练集,再做一次训练。大语言模型的训练是一场军备竞赛,没有好的装备是玩不起来的。看样子我们也必须要升级一下实验室的装备了,否则没有几个十天可以浪费。

从最近的几次失败的微调训练来看,微调训练这条路也并不容易完成。不同的任务目标混杂在一起跑训练,可能不同的任务目标需要的训练参数不同,使最终的训练集无法满足某些任务的需求。因此PTUNING只适合某个十分确定的任务,不一定适合混合任务,以混合任务为目的的模型,可能需要用FINETUNE。这和前几天我在和一个朋友交流时大家的观点类似。

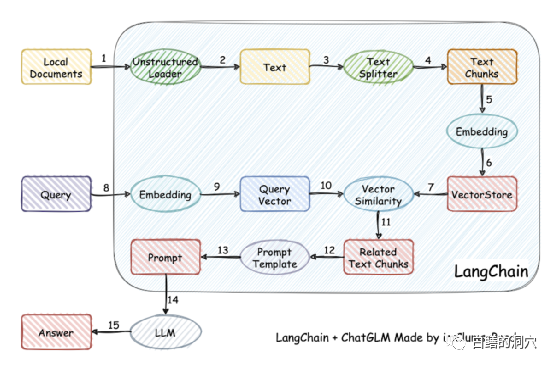

实际上因为训练模型难度比较大,一些人已经放弃了自己训练模型,而采用将本地知识库矢量化后进行较为精准的检索,然后通过AUTOPROMPT将检索后的结果生成自动提示,去问打语音模型。利用langchain很容易实现这个目标。

这个工作的原理是将本地文档通过加载器加载为文本,然后对文本进行切分行程文本片段,经过编码后写入向量存储中功查询使用。查询结果出来后,通过Prompt Template自动形成提问用的提示,去询问LLM,LLM生成最后的回答。

这项工作里有另个要点,一个是较为精准的搜索到本地知识库中的知识,这个通过向量存储于搜索来实现,目前针对中英文的本地知识库的向量化与搜索的解决方案很多,可以选择某个对你的知识库比较友好的方案来使用。

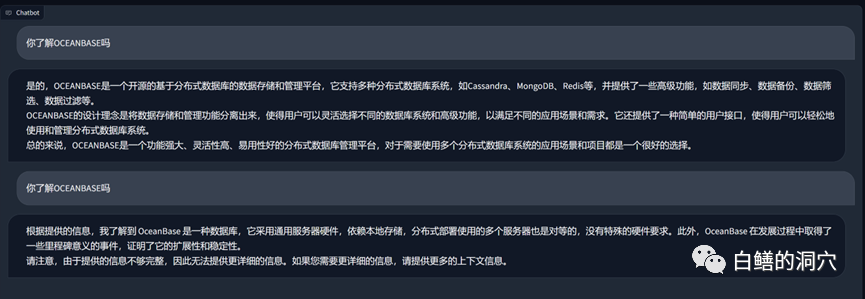

上面是一个在vicuna-13b上通过关于OB的知识库进行的问答,上面的是没有使用本地知识库,直接使用LLM的能力的回答,下面是加载了本地知识库后的回答。可以看出性能提升还是挺明显的。

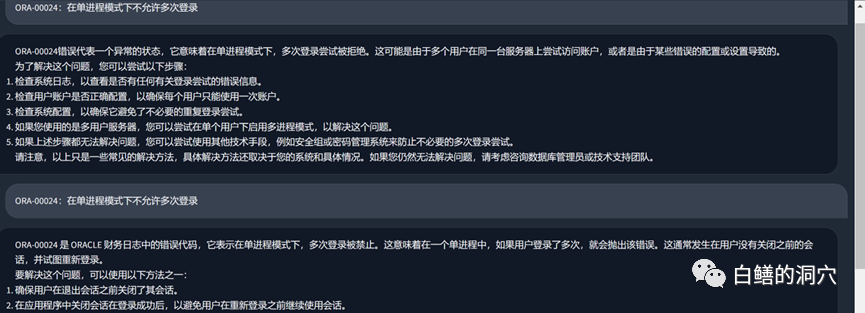

我们再来看看刚才那个ORA错误的问题,在没有使用本地知识库之前,LLM基本上是胡说八道的,而加载了本地知识库之后,这个回答还是中规中矩的,文中的错别字也是我们知识库中的错误。实际上PTUNING使用的训练集也是通过这个本地知识库生成出来的。

从最近我们踩过的坑可以收获一些经验。首先ptuning的难度比我们想象得要高得多,虽然说ptuning比finetune需要的装备低一点,不过训练难度一点都不低。其次是通过Langchain和autoprompt利用本地知识库来改善LLM能力效果不错,对于大多数企业应用来说,只要把本地知识库梳理好,选择合适的矢量化方案,应该都能获得不比PTUNING/FINETUNE差的效果。第三,还是上回说的那个问题,LLM的能力至关重要。必须选择一个能力较强的LLM作为基础模型来使用。任何嵌入式模型都只能局部改善能力,不能起决定性的作用。第四,对于数据库相关的知识,vicuna-13b的能力确实不错。

今天一大早还要去客户那边做个交流,早上时间有限,就简单写几句吧。大家对此有何心得,欢迎留言讨论(讨论仅你我可见),我也是在这条路上孤独行走,希望有同路人指点一二。

以上是一篇学会本地知识库对LLM的性能优化的详细内容。更多信息请关注PHP中文网其他相关文章!

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

WebStorm Mac版

好用的JavaScript开发工具

SublimeText3汉化版

中文版,非常好用

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具