GMAC 代表“Giga Multiply-Add Operations per Second”(每秒千兆乘法累加运算),是用于衡量深度学习模型计算效率的指标。该指标用每秒十亿个乘加运算的形式表示模型的计算速度。

乘法累加 (MAC) 运算是许多数学计算中的基本运算,包括矩阵乘法、卷积和深度学习中常用的其他张量运算。每个 MAC 操作都涉及将两个数字相乘并将结果添加到累加器。

可以使用以下公式计算 GMAC 指标:

<code>GMAC =(乘法累加运算次数)/(10⁹)</code>

乘加运算的数量通常通过分析网络架构和模型参数的维度来确定,例如权重和偏差。

通过 GMAC 指标,研究人员和从业者可以就模型选择、硬件要求和优化策略做出明智的决策,以实现高效且有效的深度学习计算。

GFLOPS是计算机系统或特定运算计算性能的衡量指标,代表每秒可执行十亿次浮点运算。它是每秒钟浮点运算的数量,用十亿 (giga) 表示。

浮点运算是指进行以 IEEE 754 浮点格式表示的实数进行算术计算。这些运算通常包括加法、减法、乘法、除法和其他数学运算。

GFLOPS 通常用于高性能计算 (HPC) 和基准测试,特别是在需要繁重计算任务的领域,例如科学模拟、数据分析和深度学习。

计算 GFLOPS公式如下:

<code>GFLOPS =(浮点运算次数)/(以秒为单位的运行时间)/ (10⁹)</code>

GFLOPS是一项有效的测量不同计算机系统、处理器或特定操作的计算能力的指标。它有助于评估执行浮点计算的硬件或算法的速度和效率。GFLOPS 是衡量理论峰值性能的指标,可能无法反映实际场景中实现的实际性能,因为它没有考虑内存访问、并行化和其他系统限制等因素。

GMAC 和 GFLOPS 之间的关系

<code>1 GFLOP = 2 GMAC</code>

如果我们想计算这两个指标,手动写代码的话会比较麻烦,但是Python已经有现成的库让我们使用:

ptflops 库就可以计算 GMAC 和 GFLOPs

<code>pip install ptflops</code>

使用也非常简单:

<code>import torchvision.models as models import torch from ptflops import get_model_complexity_info import re #Model thats already available net = models.densenet161() macs, params = get_model_complexity_info(net, (3, 224, 224), as_strings=True, print_per_layer_stat=True, verbose=True) # Extract the numerical value flops = eval(re.findall(r'([\d.]+)', macs)[0])*2 # Extract the unit flops_unit = re.findall(r'([A-Za-z]+)', macs)[0][0] print('Computational complexity: {:<8}'.format(macs)) print('Computational complexity: {} {}Flops'.format(flops, flops_unit)) print('Number of parameters: {:<8}'.format(params))</code>

结果如下:

<code>Computational complexity: 7.82 GMac Computational complexity: 15.64 GFlops Number of parameters: 28.68 M</code>

我们可以自定义一个模型来看看结果是否正确:

<code>import os import torch from torch import nn class NeuralNetwork(nn.Module): def __init__(self): super().__init__() self.flatten = nn.Flatten() self.linear_relu_stack = nn.Sequential( nn.Linear(28*28, 512), nn.ReLU(), nn.Linear(512, 512), nn.ReLU(), nn.Linear(512, 10),) def forward(self, x): x = self.flatten(x) logits = self.linear_relu_stack(x) return logits custom_net = NeuralNetwork() macs, params = get_model_complexity_info(custom_net, (28, 28), as_strings=True, print_per_layer_stat=True, verbose=True) # Extract the numerical value flops = eval(re.findall(r'([\d.]+)', macs)[0])*2 # Extract the unit flops_unit = re.findall(r'([A-Za-z]+)', macs)[0][0] print('Computational complexity: {:<8}'.format(macs)) print('Computational complexity: {} {}Flops'.format(flops, flops_unit)) print('Number of parameters: {:<8}'.format(params))</code>

结果如下:

<code>Computational complexity: 670.73 KMac Computational complexity: 1341.46 KFlops Number of parameters: 669.71 k</code>

为了方便演示,我们只编写全连接层代码来手动计算GMAC。遍历模型权重参数并计算乘法和加法操作数量的形状取决于权重参数,这是计算GMAC的关键。计算GMAC所需的全连接层权重的公式为2 x (输入维度 x 输出维度) 。总的GMAC值是通过将每个线性层的权重参数的形状相乘并累加而得出的,这一过程基于模型的结构。

<code>import torch import torch.nn as nn def compute_gmac(model): gmac_count = 0 for param in model.parameters(): shape = param.shape if len(shape) == 2:# 全连接层的权重 gmac_count += shape[0] * shape[1] * 2 gmac_count = gmac_count / 1e9# 转换为十亿为单位 return gmac_count</code>

根据上面给定的模型,计算GMAC的结果如下:

<code>0.66972288</code>

由于GMAC的结果以十亿为单位,因此与我们上面使用类库计算的结果相差不大。最后再说一下,计算卷积的GMAC稍微有些复杂,公式为 ((输入通道 x 卷积核高度 x 卷积核宽度) x 输出通道) x 2,这里给一个简单的代码,不一定完全正确,供参考

<code>def compute_gmac(model): gmac_count = 0 for param in model.parameters(): shape = param.shape if len(shape) == 2:# 全连接层的权重 gmac_count += shape[0] * shape[1] * 2 elif len(shape) == 4:# 卷积层的权重 gmac_count += shape[0] * shape[1] * shape[2] * shape[3] * 2 gmac_count = gmac_count / 1e9# 转换为十亿为单位 return gmac_count</code>

以上是浅析计算GMAC和GFLOPS的详细内容。更多信息请关注PHP中文网其他相关文章!

Simpson的悖论如何发现数据中隐藏的趋势? - 分析VidhyaApr 23, 2025 am 09:20 AM

Simpson的悖论如何发现数据中隐藏的趋势? - 分析VidhyaApr 23, 2025 am 09:20 AM辛普森的悖论:揭示数据中的隐藏趋势 您是否曾经被统计数据误导?辛普森(Simpson)的悖论展示了汇总数据如何掩盖关键趋势,从而揭示了分析多个级别数据的重要性。这个简洁的gui

什么是名义数据? - 分析VidhyaApr 23, 2025 am 09:13 AM

什么是名义数据? - 分析VidhyaApr 23, 2025 am 09:13 AM介绍 名义数据构成了数据分析的基石,在统计,计算机科学,心理学和营销等各个领域中起着至关重要的作用。 本文深入研究了Nomi的特征,应用和区分

什么是一声提示? - 分析VidhyaApr 23, 2025 am 09:12 AM

什么是一声提示? - 分析VidhyaApr 23, 2025 am 09:12 AM介绍 在机器学习的动态世界中,使用最小数据有效生成精确的响应至关重要。 一声提示提供了一个强大的解决方案,使AI模型仅使用一个示例执行特定任务

特斯拉的Robovan是2024年的Robotaxi预告片中的隐藏宝石Apr 22, 2025 am 11:48 AM

特斯拉的Robovan是2024年的Robotaxi预告片中的隐藏宝石Apr 22, 2025 am 11:48 AM自2008年以来,我一直倡导这辆共享乘车面包车,即后来被称为“ Robotjitney”,后来是“ Vansit”,这是城市运输的未来。 我预见这些车辆是21世纪的下一代过境解决方案Surpas

Sam俱乐部在AI上押注以消除收据检查并增强零售Apr 22, 2025 am 11:29 AM

Sam俱乐部在AI上押注以消除收据检查并增强零售Apr 22, 2025 am 11:29 AM革新结帐体验 Sam's Club的创新性“ Just Go”系统建立在其现有的AI驱动“扫描和GO”技术的基础上,使会员可以在购物旅行期间通过Sam's Club应用程序进行扫描。

Nvidia的AI Omniverse在GTC 2025扩展Apr 22, 2025 am 11:28 AM

Nvidia的AI Omniverse在GTC 2025扩展Apr 22, 2025 am 11:28 AMNVIDIA在GTC 2025上的增强可预测性和新产品阵容 NVIDIA是AI基础架构的关键参与者,正在专注于提高其客户的可预测性。 这涉及一致的产品交付,达到绩效期望以及

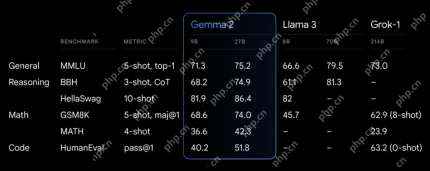

探索Google的功能Apr 22, 2025 am 11:26 AM

探索Google的功能Apr 22, 2025 am 11:26 AMGoogle的Gemma 2:强大,高效的语言模型 Google的Gemma语言模型家族以效率和性能而庆祝,随着Gemma 2的到来而扩展。此最新版本包括两种模型:270亿个参数VER

下一波《 Genai:与Kirk Borne博士的观点》 -Analytics VidhyaApr 22, 2025 am 11:21 AM

下一波《 Genai:与Kirk Borne博士的观点》 -Analytics VidhyaApr 22, 2025 am 11:21 AM这一领先的数据剧集以数据科学家,天体物理学家和TEDX演讲者Kirk Borne博士为特色。 Borne博士是大数据,AI和机器学习的著名专家,为当前状态和未来的Traje提供了宝贵的见解

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

禅工作室 13.0.1

功能强大的PHP集成开发环境

SublimeText3 英文版

推荐:为Win版本,支持代码提示!