近期,浙江大学ReLER实验室将SAM与视频分割进行深度结合,发布Segment-and-Track Anything (SAM-Track)。

SAM-Track赋予了SAM对视频目标进行跟踪的能力,并支持多种方式(点、画笔、文字)进行交互。

在此基础上,SAM-Track统一了多个传统视频分割任务,达成了一键分割追踪任意视频中的任意目标,将传统视频分割外推至通用视频分割。

SAM-Track具有卓越的性能,在复杂场景下仅需单卡就能高质量地稳定跟踪数百个目标。

项目地址:https://github.com/z-x-yang/Segment-and-Track-Anything

论文地址:https://arxiv.org/abs/2305.06558

效果展示

SAM-Track支持语言输入作为Prompt。比如,给定类别文本「熊猫」,便可一键实例级分割追踪所有属于「熊猫」这一类别的目标。

也可进一步给出更详细的描述,比如输入文字「最左边的熊猫」,SAM-Track可以定位至特定目标进行分割追踪。

相较于传统视频追踪算法,SAM-Track的另一个强大之处在于可对大量目标同时进行跟踪分割,并自动检测新出现的物体。

SAM-Track还支持多种交互方式组合使用,用户可根据实际需求搭配。比如使用画笔来框定与人体紧密连接的滑板,防止分割多余物体,而后使用点击选择人体。

全自动视频目标分割与追踪自然也不在话下,各种应用场景包括街景、航拍、AR、动画、医学图像等,均可一键分割追踪并自动检测新出现的物体。

如果对自动分割结果不满意,用户可在此基础上进行编辑修正,例如使用点击来修正过分割的电车。

同时最新版本的SAM-Track支持对追踪结果进行在线浏览,可选择中间任意一帧的分割结果进行修改和新增目标,并再次追踪。

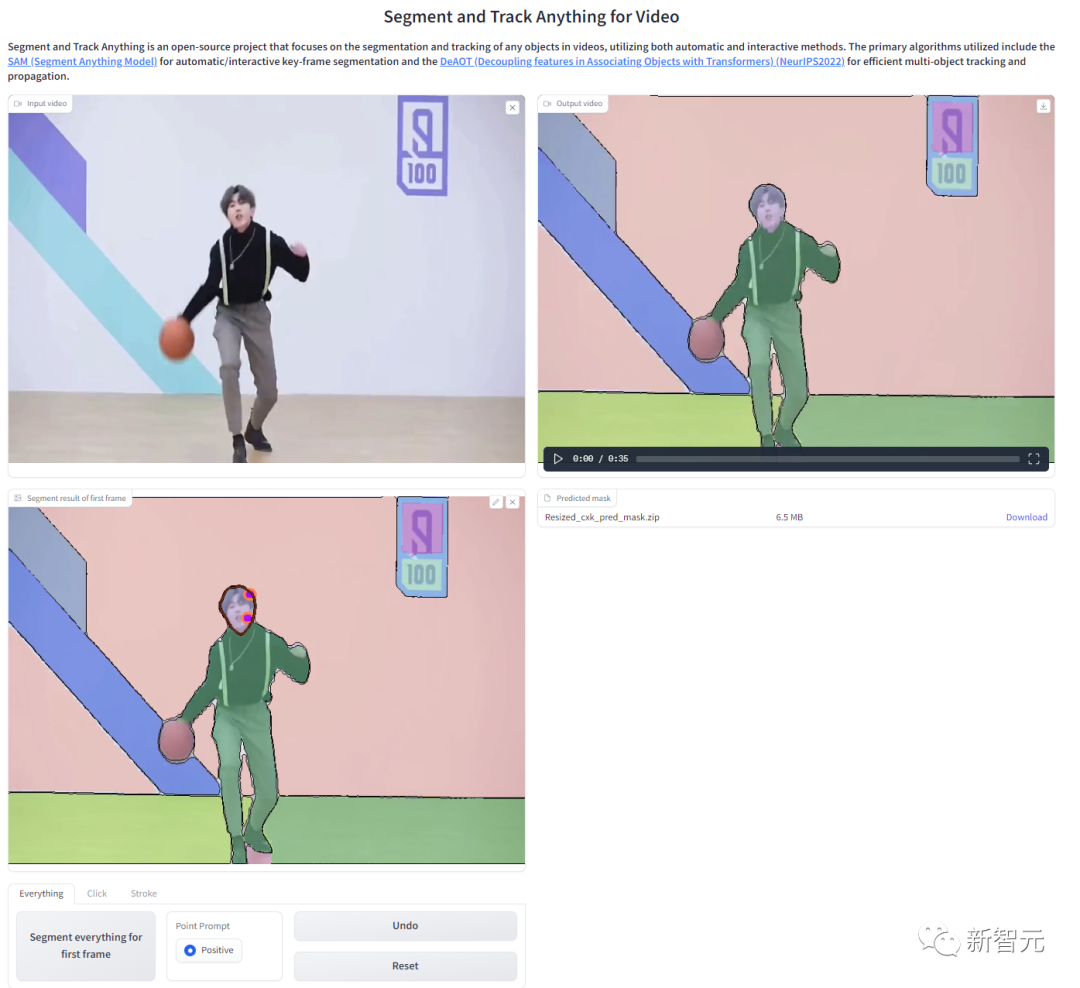

为了方便用户线上体验,项目提供了WebUI,可通过Colab一键部署:

模型组成

SAM-Track模型基于ECCV'22 VOT Workshop四个赛道的冠军方案DeAOT。

DeAOT是一个高效的多目标VOS模型,在给定首帧物体标注的情况下,可以对视频其余帧中的物体进行追踪分割。

DeAOT采用一种识别机制,将一个视频中的多个目标嵌入到同一高维空间中,从而实现了同时对多个物体进行追踪。

DeAOT在多物体追踪方面的速度表现能够与其他针对单个物体追踪的VOS方法相媲美。

此外,通过基于分层的Transformer的传播机制,DeAOT更好地聚合了长时序和短时序信息,表现出了优异的追踪性能。

由于DeAOT需要参考帧的标注来初始化,为了提高便捷性,SAM-Track使用了最近在图像分割领域大放异彩的Segment Anything Model(SAM)模型来获取标注信息。

利用SAM出色的零样本迁移能力,以及多种交互方式,SAM-Track能高效地为DeAOT获取高质量的参考帧标注信息。

虽然SAM模型在图像分割领域表现出色,但它无法输出语义标签,且文本提示也不能很好地支持Referring Object Segmentation及其他依赖深层语义理解的任务。

因此,SAM-Track模型进一步集成了Grounding-DINO,实现了高精度的语言引导的视频分割。Grounding DINO是一个开放集合目标检测模型,具有很好的语言理解能力。

根据输入的类别或目标对象的详细描述,Grounding-DINO可以检测到目标并返回位置框。

SAM-Track模型架构

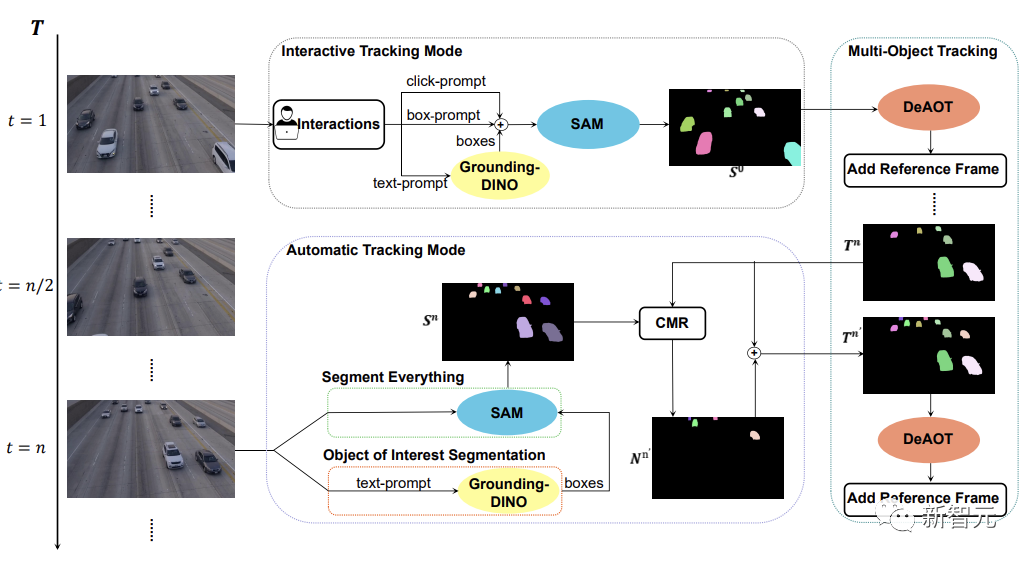

如下图所示,SAM-Track模型支持了三种物体跟踪模式,分别为交互跟踪模式、自动跟踪模式以及融合模式。

对于交互跟踪模式,SAM-Track模型首先会应用SAM,在参考帧中利用点击或画框的方式选中目标,直到得到用户满意的交互分割结果。

如果想要实现语言引导的视频物体分割,SAM-Track则会调用Grounding-DINO根据输入的文本,先得到目标物体的位置框,并在此基础上通过SAM得到感兴趣物体的分割结果。

最后DeAOT将交互分割结果作为参考帧,对选中的目标进行追踪。在追踪的过程中,DeAOT会将过去帧中的视觉嵌入和高维ID嵌入分层传播到当前帧中,实现逐帧追踪分割多个目标对象。因此,SAM-Track能过支持多模态的交互方式来追踪分割视频中的感兴趣物体。

然而,交互跟踪模式无法处理视频中出现的新出现的物体。限制了SAM-Track在特定领域的应用,例如,自动驾驶,智慧城市等。

为了进一步拓展SAM-Track的应用范围和性能,SAM-Track实现了自动跟踪模式,对视频中出现的新物体进行追踪。

自动跟踪模式通过Segment Everything和Object of Interest Segmentation两种方式来获得每n帧中新出现的物体的注释。对于新出现的物体的ID分配问题,SAM-Track采用了比较掩码模块(CMR)来确定新的对象的ID。

融合模式则是把交互跟踪模式和自动跟踪模式相结合。通过交互式跟踪模式用户可以很方便地获取视频中第一帧的注释,而自动跟踪模式则可以处理视频后续帧中出现的未被选中的新对象。追踪方法的组合扩大了SAM-Track的应用范围,增加了SAM-Track的实用性。

以上是视频分割大结局!浙大最新发布SAM-Track:通用智能视频分割一键直达的详细内容。更多信息请关注PHP中文网其他相关文章!

学习Excel的十大YouTube频道 - 分析VidhyaApr 13, 2025 am 09:27 AM

学习Excel的十大YouTube频道 - 分析VidhyaApr 13, 2025 am 09:27 AM介绍 Excel对于提高所有领域的生产率和效率都是必不可少的。 YouTube上的广泛资源可以帮助各个级别的学习者找到针对他们需求的有用教程。这个AR

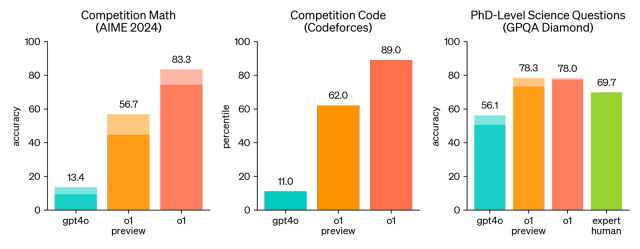

Openai O1:一种在回答问题之前'思考”的新模型Apr 13, 2025 am 09:26 AM

Openai O1:一种在回答问题之前'思考”的新模型Apr 13, 2025 am 09:26 AM你听到了大新闻吗? Openai刚刚推出了一系列新型AI模型的预览 - OpenAi O1(也称为草莓/Q*)。这些模型很特别,因为它们花费更多的时间“思考”

Claude vs Gemini:综合比较 - 分析VidhyaApr 13, 2025 am 09:20 AM

Claude vs Gemini:综合比较 - 分析VidhyaApr 13, 2025 am 09:20 AM介绍 在人工智能的快速变化领域中,两种语言模型Claude和Gemini已成为杰出的竞争者,每个语言都提供了不同的优势和技能。虽然这两种模型都可以法术

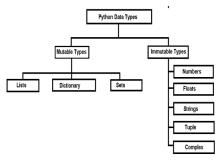

python中的可变与不变的物体 - 分析vidhyaApr 13, 2025 am 09:15 AM

python中的可变与不变的物体 - 分析vidhyaApr 13, 2025 am 09:15 AM介绍 Python是一种面向对象的编程语言(或OOPS)。在我的上一篇文章中,我们探索了它的多功能性质。因此,Python提供了多种数据类型,可以将其广泛分为M

11 YouTube频道免费学习Tableau -Analytics VidhyaApr 13, 2025 am 09:14 AM

11 YouTube频道免费学习Tableau -Analytics VidhyaApr 13, 2025 am 09:14 AM介绍 Tableau被认为是全球公司和个人目前正在使用的最强大的数据可视化工具之一,用于有效的数据分析和呈现。具有用户友好的界面并扩展

10个生成AI编码扩展,在VS代码中,您必须探索Apr 13, 2025 am 01:14 AM

10个生成AI编码扩展,在VS代码中,您必须探索Apr 13, 2025 am 01:14 AM嘿,编码忍者!您当天计划哪些与编码有关的任务?在您进一步研究此博客之前,我希望您考虑所有与编码相关的困境,这是将其列出的。 完毕? - 让&#8217

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PM

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PMAI增强食物准备 在新生的使用中,AI系统越来越多地用于食品制备中。 AI驱动的机器人在厨房中用于自动化食物准备任务,例如翻转汉堡,制作披萨或组装SA

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM介绍 了解Python功能中变量的名称空间,范围和行为对于有效编写和避免运行时错误或异常至关重要。在本文中,我们将研究各种ASP

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)