图灵奖得主LeCun:ChatGPT局限巨大,自回归模型寿命不超5年

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB转载

- 2023-05-04 13:04:13727浏览

今年上半年,可谓是AI届最波澜壮阔的半年。

在急速发展的各类GPT甚至AGI的雏形背后,是持不同观点的两大阵营的人们。

一派认为,以ChatGPT为首的生成式AI非常强大,能带动一大波革命性的风潮,继续推进没有问题。

另一派认为,咱发展的有点太快了。不说禁止,也得停一停。而且道德方面,相匹配的约束也太少了。

而作为AI届的一位大拿,Yann LeCun对此却有不同看法。

彻底禁止?不可行

LeCun表示,他对ChatGPT的表现并不感到惊讶,也不赞成暂停人工智能的研究。

「这可能会产生和预期相反的结果。」

他表示,人工智能作为人类智能的放大器,可能是新文艺复兴的起源。

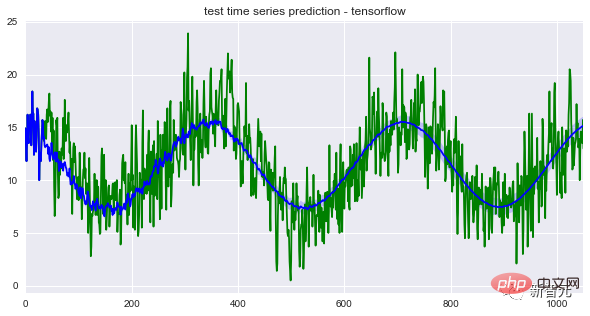

ChatGPT这种大语言模型是「自回归」。AI接受训练,从一个包含多达14000亿个单词的语料库中提取单词,预测给定句子序列中的最后一个单词,也就是下一个必须出现的单词。

Claude Shannon在上个世纪50年代开展的相关研究就是基于这一原则。

原则没变,变得是语料库的规模,以及模型本身的计算能力。

LeCun表示,「目前,我们无法靠这类模型生成长而连贯的文本,这些系统不是可控的。比如说,我们不能直接要求ChatGPT生成一段目标人群是13岁儿童的文本。

其次,ChatGPT生成的文本作为信息来源并不是100%可靠的。GPT的功能更像是一种辅助工具。就好比现有的驾驶辅助系统一样,开着自动驾驶功能,也得把着方向盘。

而且,我们今天所熟知的自回归语言模型的寿命都非常短,五年算是一个周期,五年以后,过去的模型就没有人再会用了。

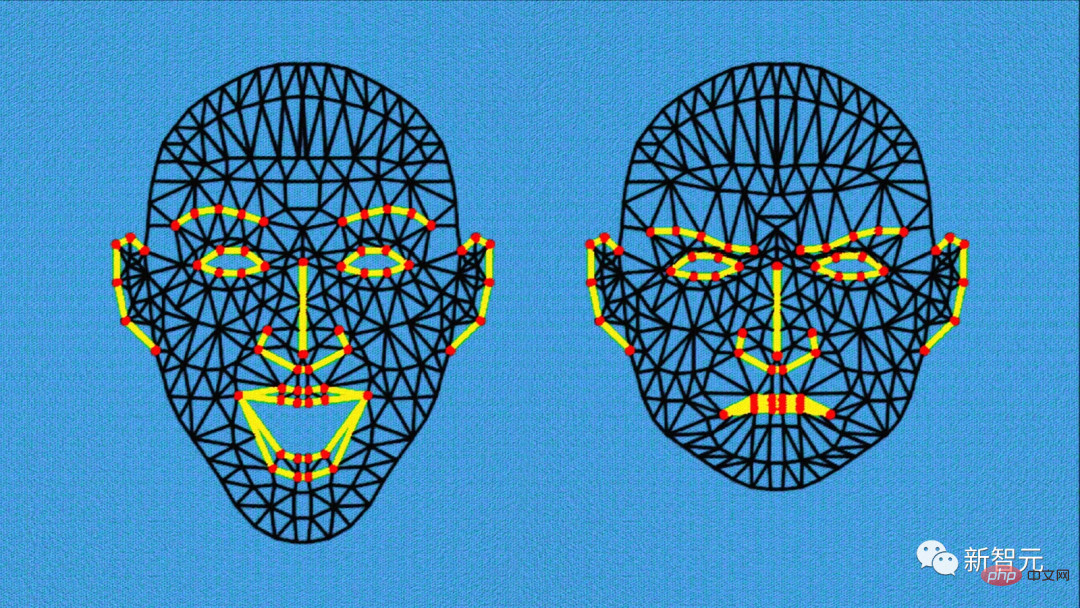

而我们的研究重点,就应该集中在找到一种是这些模型可控的办法上。换句话说,我们要研究的AI,是能根据给定目标进行推理和计划的AI,并且得能保证其安全性和可靠性的标准是一致的。这种AI能感受到情绪。」

要知道,人类情绪的很大一部分和目标的实现与否有关,也就是和某种形式的预期有关。

而有了这样的可控模型,我们就能生成出长而连贯的文本。

LeCun的想法是,未来设计出能混合来自不同工具的数据的增强版模型,比如计算器或者搜索引擎。

像ChatGPT这样的模型只接受文本训练,因此ChatGPT对现实世界的认识并不完整。而想要在此基础上进一步发展,就需要学习一些和整个世界的感官知觉、世界结构有关的内容。

而这些更复杂的内容并不是简单地通过阅读文本就能实现的,这才是未来几年的最大挑战之一。

开源才是尽头

对权力的渴望,是人类特有的。而AI并不会因为变得越来越强大就会具备这种渴望。

只有人类这个物种才知道如何制定法律,保障个体的行为不会过多损害共同利益。

OpenAI最初是一个开放的研究项目,现在已经关闭了。而OpenAI对其工作只字未提,这种情况的逆转在研究领域并不常见。

问题在于训练一个语言模型很昂贵,要花费几千万欧元,所以初创企业负担不起。

这也是微软与OpenAI合并的主要原因,需要集团共同的计算能力来改进其未来的模型。这也是为什么DeepMind和谷歌大脑最终还是合并了。

LeCun表示,最终在市场方面,开发者会走向一个开放平台的共同生态。如果只有少部分公司控制着这类技术,就糟糕了。

从历史上来看,不管是Facebook还是改完名的Meta,都在积极推动开放性的基础研究,比如LlaMa这个开源项目。

90年代初期,Sun Microsystems和Microsoft大打出手,争夺操作服务器的权力。要记住,所有能一直站稳脚跟的互联网技术都是开源的。

LeCun最后表示,目前,阻止这类开放的开源AI平台的关键,是法律上的问题。如果未来欧盟想要推动AI产业的结构化,那么这种类似的开源平台是必不可少的。

以上是图灵奖得主LeCun:ChatGPT局限巨大,自回归模型寿命不超5年的详细内容。更多信息请关注PHP中文网其他相关文章!