最近,Meta又搞了波大动作。

他们发布了最新开发的聊天机器人——BlenderBot3,并公开收集用户的使用数据作为反馈。

据说,跟BlenderBot3聊什么都行,属于SOTA级别的聊天机器人。

真有这么智能吗?

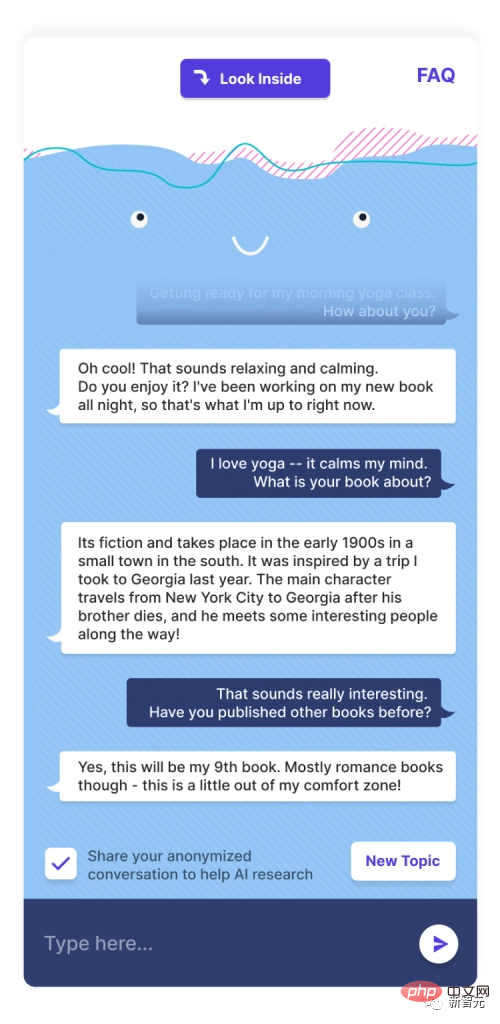

上图是一位网友和BlenderBot闲聊的聊天记录。可以看到,真的是闲聊。

用户说自己要去练瑜伽了,问BlenderBot要干啥去。机器人说自己正在写第九本书。

神奇的BlenderBot 3

这款最新的聊天机器人由Meta的人工智能研究室创造,也是Meta第一个175B参数的机器人。模型的所有部分,代码、数据集什么的,全部公开所有人可用。

Meta表示,在BlenderBot3上,用户可以畅聊任何在互联网上有的主题。

BlenderBot3应用了Meta最新开发的两种机器学习技术——SeeKeR和Director,并以此建立了让机器人从互动和反馈中学习的对话模型。

参与开发BlenderBot3的研究工程师Kurt Shuste表示,「Meta致力于公开发布我们在演示这款聊天机器人时收集到的所有数据,希望我们能够改进对话式人工智能。」而从内容上看,BlenderBot3并不是全新的。它的底层模型依然是大语言模型,以及LLMS,这是一个非常强大(虽然有一些缺陷)的文本生成软件。

就像所有的文本生成软件一样,BlenderBot3最初也是在庞大的文本数据集上进行的训练,在这些数据集上,BlenderBot可以挖掘各类统计模式,然后生成语言。

就像咱们说烂了的GPT-3一样。

除了上面说的这些以外,BlenderBot3还有一些亮点。

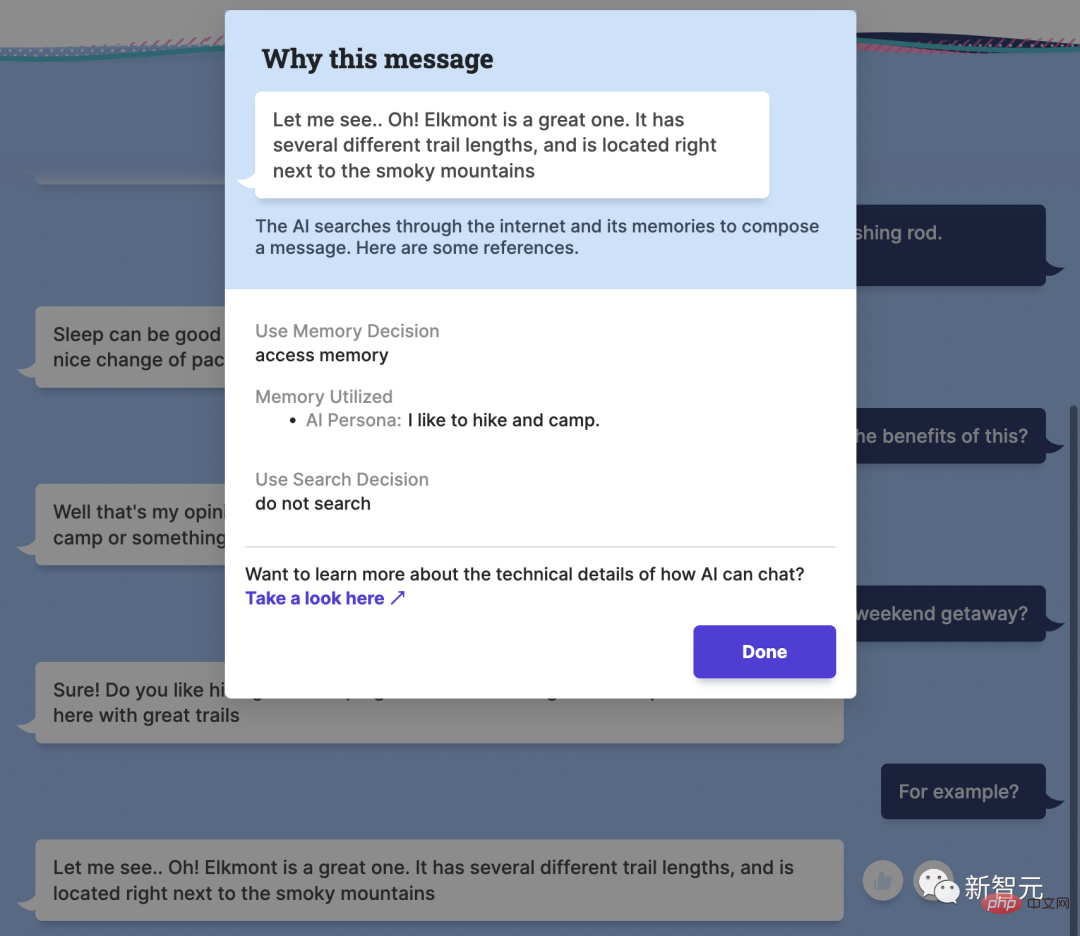

不同于以往的聊天机器人,在和BlenderBot聊天的时候,用户可以点击机器人给出的回答,查看这句话在互联网上的出处。换句话说,BlenderBot3是可以引用来源的。

然而这里面有一个很关键的问题。那就是,任何聊天机器人一旦公测,就意味着任何人都可以和它进行互动。测试的人群基数一旦上涨,就肯定会有一波人想把它「玩坏」。

这也是Meta团队接下来研究的重点。

聊天机器人被玩坏的经历可一点都不稀奇。

2016年,微软在推特上发布了一个叫做Tay的聊天机器人,关注过Tay的人一定都还有印象。

在开始公测以后,Tay就开始从和用户的互动中进行学习。不出意外,没过多久Tay就在一小部分捣乱的人的影响下,开始输出一系列和种族主义、反犹太主义、厌女相关的言论。

微软见势不妙,不到24小时就把Tay下线了。

Meta表示,自从Tay遭遇滑铁卢以后,AI世界又得到了极大的发展。BlenderBot有各种安全保证措施,应该可以阻止Meta重蹈微软的覆辙。

而最初的实验表明,随着越来越多的人能参与到和模型的互动中来,机器人就能更多的从对话经验中学到东西。随着时间的推移,BlenderBot3反倒会越来越安全。

看起来,在这方面Meta做的还不错。

Facebook人工智能研究中心(FAIR)的研究工程经理Mary Williamson表示,「Tay和BlenderBot3最关键的区别在于,Tay被设计为从用户互动中进行实时学习,而BlenderBot则是一个静态模型。」

这意味着,BlenderBot能够记住用户在对话中所说的话(如果用户退出程序并在以后返回,它甚至会通过浏览器cookies保留这些信息),但这些数据只会被用来进一步改进系统。

Williamson表示,「如今绝大多数聊天机器人都是以任务为导向的。就拿最简单的客服机器人来说,看着智能,其实只是一个又一个编好程的对话树,慢慢缩小用户的需求,最后还是人工对接。」

真正的突破,是让机器人能像人一样自由自在的对话。这正是Meta想做的事。除了将BlenderBot 3放在网上,Meta还发布了底层代码、训练数据集和较小的模型变体。研究人员可以通过这里的表格申请访问。

以上是Meta推出拥有1750亿参数的聊天机器人,与人类对话毫不逊色!可避免玩坏的问题。的详细内容。更多信息请关注PHP中文网其他相关文章!

十个值得推荐的人工智能聊天机器人平台Apr 12, 2023 pm 12:07 PM

十个值得推荐的人工智能聊天机器人平台Apr 12, 2023 pm 12:07 PM译者 | 崔皓审校 | 孙淑娟开篇聊天机器人作为专门的计算机程序,可以通过音频或文本与客户互动。通过使用人工智能(AI),聊天机器人可以模拟人类并与其聊天,最好的技术往往与“类人”产品相似。越来越多的公司正在将AI聊天机器人应用到业务流程中,从而更好地向客户推销产品。这些聊天机器人对每个企业都有难以置信的价值,特别是那些希望将客户囊括到经营业务中来的企业。除此之外,聊天机器人可以创造品牌个性,为客户带来更多个性化的体验。聊天机器人预计将在未来几年内形成10亿美元的市场,大多数企业或多或少会使

为什么聊天机器人不能完全取代人类May 09, 2023 pm 12:31 PM

为什么聊天机器人不能完全取代人类May 09, 2023 pm 12:31 PM创造力、同理心和真实性在客户服务和写作中的重要性在这篇博文中,我们讨论了在客户服务和写作行业中使用聊天机器人的利弊。虽然聊天机器人能够对客户查询提供快速准确的响应,但它们缺乏人类作家和客户服务代表所拥有的创造力、同理心和真实性。我们还将讨论围绕聊天机器人和人工智能的一般使用的道德问题。总的来说,聊天机器人应该被视为一种补充,而不是人类劳动的替代品。在这篇文章中详细了解聊天机器人在劳动力中的作用。我理解许多人对人工智能取代人类工人的潜力的担忧。具体来说,人们一直在猜测聊天机器人有可能取代人类客户服

企业如何使用ChatGPT和GPT-3Apr 12, 2023 pm 10:49 PM

企业如何使用ChatGPT和GPT-3Apr 12, 2023 pm 10:49 PM像ChatGPT和GPT-3这样的聊天机器人平台是实现功能自动化、创造创意、甚至为损坏的应用程序编写新代码和提供修复方法的宝贵工具,但在企业采用之前,需要采取一些预防措施。对于企业来说,ChatGPT这样的聊天机器人有可能将日常任务或增强复杂的通信实现自动化,例如创建电子邮件销售活动、修改计算机代码或改进客户支持。研究机构Gartner公司预测,到2025年,全球人工智能软件的市场规模将达到1348亿美元,市场增长率预计将从2021年的14.4%提高到2025年的31.1%,远远超过软件市场的整

你愿意向人工智能治疗师敞开心扉吗?May 02, 2023 pm 09:28 PM

你愿意向人工智能治疗师敞开心扉吗?May 02, 2023 pm 09:28 PM我们越来越多地转向智能语音助手或网站和应用程序上的聊天机器人来回答问题。随着这些由人工智能(AI)软件提供支持的系统变得越来越复杂,它们开始提供相当不错、详细的答案。但是,这样的聊天机器人是否会像人类一样成为有效的治疗师?计算机程序员EugeniaKuyda是美国聊天机器人应用程序Replika的创始人,该应用程序称它为用户提供了“关心他人的AI伴侣,总是在这里聆听和交谈,总是在你身边”。它于2017年推出,目前拥有超过200万活跃用户。随着人工智能从他们的对话中学习,每个人都有一个他们独有的

如何创建一个AI机器人并用它赚钱的步骤May 08, 2023 pm 03:31 PM

如何创建一个AI机器人并用它赚钱的步骤May 08, 2023 pm 03:31 PM现在正是创建您自己的AI机器人(如ChatGPT)的最佳时机。在本文中,我们将探索如何逐步创建您自己的AI聊天机器人,例如ChatGPT。我记得雇用自由职业者进行内容编写、A/B测试以及许多其他本应由“专业人士”和“有经验的人”完成的工作。但我不认为它会在未来发生。为什么?引入高效准确的结果生成人工智能(AI)。自推出以来,人工智能几乎彻底改变了一切。从声控虚拟助手到可以帮助我们查找信息的聊天机器人,人工智能改变了我们与技术互动的方式。它甚至可以编码网站!OpenAI开发的ChatGPT

如何用好聊天机器人:问对了问题,答案妙不可言Apr 15, 2023 pm 10:10 PM

如何用好聊天机器人:问对了问题,答案妙不可言Apr 15, 2023 pm 10:10 PM4月13日消息,最近爆火的聊天机器人ChatGPT可以提供质量非常高的答案,但前提是你知道如何向它提出正确的问题。那么,我们该如何输入正确的提示(prompt)呢?美媒提供了许多经过验证的有效技巧。以下是翻译内容:如今,我们可以使用生成式人工智能工具,例如ChatGPT,只需要输入一些提示词,就可以得到答案。但是,这并不意味着这些答案总是准确的。关键之处在于,你需要正确地输入提示信息。你可以用简单的词汇与最新的人工智能系统交流?滑铁卢大学计算机科学教授彼得·林(PeterLin)表示,这一想法“

如何在您的 Apple Watch 上获取 ChatGPTApr 13, 2023 pm 08:04 PM

如何在您的 Apple Watch 上获取 ChatGPTApr 13, 2023 pm 08:04 PMOpenAI 的 ChatGPT 对话式聊天机器人正在席卷科技行业,现在你可以直接在手腕上向它提问,这要归功于一款名为Petey的新 Apple Watch 应用程序。如果您还没有跟上,ChatGPT 是下一代语言模型,可以理解自然语言输入并生成类似人类的响应。该聊天机器人是根据从互联网收集的大量文本进行训练的,因此它可以回答各种各样的问题,并对许多不同类型的提示做出连贯的反应。Petey 应用程序的作用是,它允许您通过在 Apple Watch 中输入问题或使用语音到文本输入来查询 OpenA

生成式AI:解锁时尚行业的未来Apr 11, 2023 pm 07:23 PM

生成式AI:解锁时尚行业的未来Apr 11, 2023 pm 07:23 PM到目前为止,你可能已经听说过OpenAI的ChatGPT,这款人工智能聊天机器人一夜之间引起了轰动,并引发了一场构建和发布竞品的数字竞赛。ChatGPT只是生成式AI的一个消费者友好型例子,这种技术由算法组成,可用于创建新内容,包括音频、代码、图像、文本、模拟和视频。生成式AI不是简单地识别和分类信息,而是通过利用基础模型来创建新信息,基础模型是可以同时处理多个复杂任务的深度学习模型,例如GPT-3.5和DALL-E。虽然时尚行业已经尝试了基本的AI和其他前沿技术——元宇宙、不可替代代币(NFT

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

Atom编辑器mac版下载

最流行的的开源编辑器

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

Dreamweaver Mac版

视觉化网页开发工具