最近由于工作突然变动,新的办公地点离现在的住处很远,必须要换房子租了。

我坐上中介的小电驴,开始探索城市各处的陌生角落。

在各个租房app之间周转的过程中,我属实有些焦头烂额,因为效率真的很低下:

首先,因为跟女友住在一起,需要同时考虑两人的上班路程,但各平台按通勤时长找房的功能都比较鸡肋,有的平台不支持同时选择多个地点,有的平台只能机械的取到离各个地点通勤时长相同的点,满足不了使用需求。

其次,站在一个租房人的立场,租房平台实在太多了,并且各平台筛选和排序逻辑都不太一致,导致很难将相似房源的信息进行横向比较。

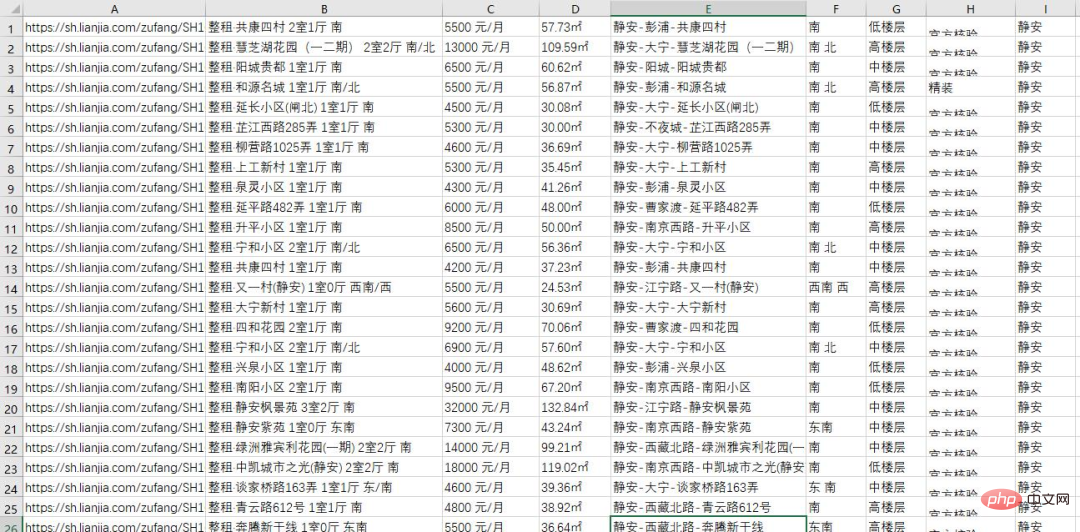

但是没有关系,作为一名程序员,当然要用程序员的方法来解决问题了。于是,昨晚我用一个python脚本,获取了某租房平台上海地区的所有房源信息,一共2w多条:

下面就把本次爬数据的整个过程分享给大家。

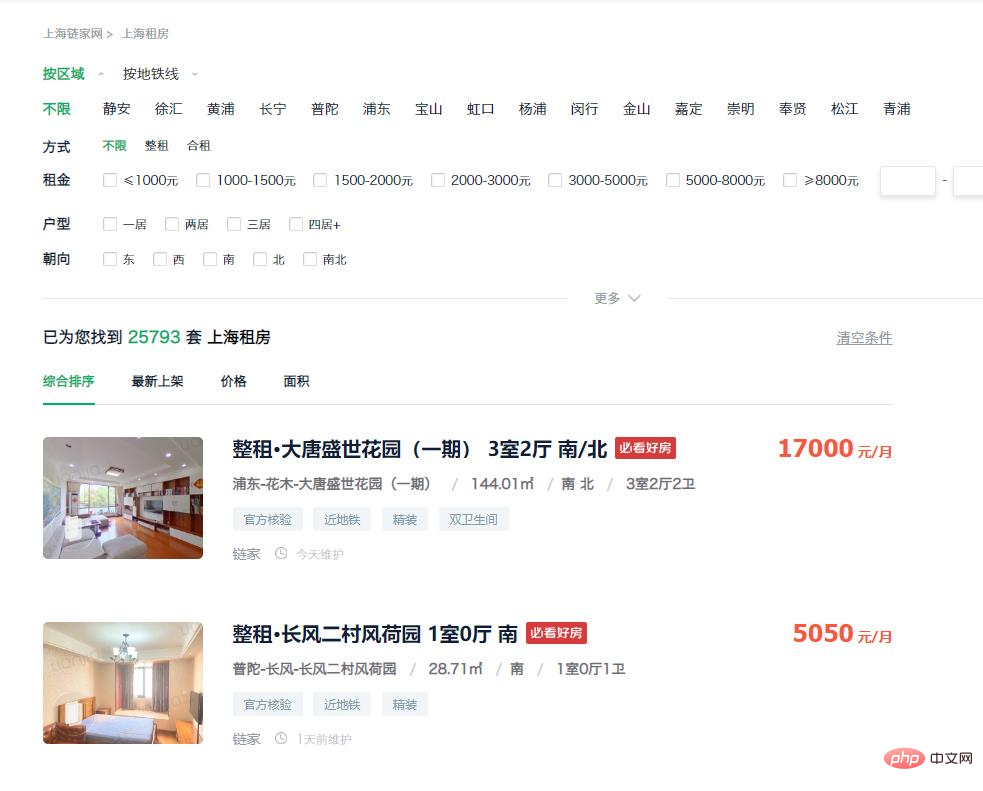

分析页面,寻找切入点

首先进入该平台的租房页面,可以看到,主页上的房源列表里已经包括了我们所需要的大部分信息,并且这些信息都能直接从dom中获取到,因此考虑直接通过模拟请求来收集网页数据。

https://sh.lianjia.com/zufang/

因此接下来就要考虑怎么获取url了。通过观察我们发现,该地区一共有2w套以上的房源,而通过网页只能访问到前100页的数据,每页显示数量上限是30条,算下来就是一共3k条,无法获取到全部信息。

不过我们可以通过添加筛选条件来解决这个问题。在筛选项中选择“静安”,进入到如下的url:

https://sh.lianjia.com/zufang/jingan/

可以看到该地区一共有2k多套房源,数据页数为75,每页30条,理论上可以访问到所有的数据。所以可以通过分别获取各区房源数据的方法,得到该市所有的数据。

https://sh.lianjia.com/zufang/jingan/pg2/

点击第二页按钮后,进入到了上面的url,可以发现只要修改pg后面的数字,就能进入到对应的页数。

不过这里发现一个问题,相同的页数每次访问得到的数据是不一样的,这样会导致收集到的数据出现重复。所以我们点击排序条件中的“最新上架",进入到如下链接:

https://sh.lianjia.com/zufang/jingan/pg2rco11/

用这种排序方式获得的数据次序是稳定的,至此我们的思路便有了:首先分别访问每个小地区的第一页,然后通过第一页获取当前地区的最大页数,然后访问模拟请求访问每一页获取所有数据。

爬取数据

有了思路之后就要动手写代码了,首先我们要收集包含所有的链接,代码如下:

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))之后,我们要逐一处理上一步得到的urls,获取链接内的数据,代码如下:

num=1

for url in urls:

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})整理数据,导出文件

通过对页面结构的观察,我们能得到每个元素存储的位置,找到对应的页面元素,就能获取到我们需要的信息了。

这里附上完整的代码,感兴趣的朋友可以根据自己的需要,替换掉链接中的地区标识和小地区的标识,就能够获取到自己所在地区的信息了。其他租房平台的爬取方式大都类似,就不再赘述了。

import time, re, csv, requests

import codecs

from bs4 import BeautifulSoup

print("****处理开始****")

with open(r'..sh.csv', 'wb+')as fp:

fp.write(codecs.BOM_UTF8)

f = open(r'..sh.csv','w+',newline='', encoding='utf-8')

writer = csv.writer(f)

urls = []

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))

num=1

for url in urls:

# 模拟请求

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

# 读取页面中数据

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})

# 数据处理

for info in infos:

house_url = 'https://sh.lianjia.com' + info.a['href']

title = info.find('p', {'class': 'content__list--item--title'}).find('a').get_text().strip()

group = title.split()[0][3:]

price = info.find('span', {'class': 'content__list--item-price'}).get_text()

tag = info.find('p', {'class': 'content__list--item--bottom oneline'}).get_text()

mixed = info.find('p', {'class': 'content__list--item--des'}).get_text()

mix = re.split(r'/', mixed)

address = mix[0].strip()

area = mix[1].strip()

door_orientation = mix[2].strip()

style = mix[-1].strip()

region = re.split(r'-', address)[0]

writer.writerow((house_url, title, group, price, area, address, door_orientation, style, tag, region))

time.sleep(0)

print("第{}页数据处理完毕,共{}条数据。".format(str(num), len(infos)))

num+=1

f.close()

print("****全部完成****")经过一番操作,我们获取到了当地各租房平台完整的房源信息。至此,我们已经可以通过一些基本的筛选方式,获取自己需要的数据了。

以上是为了在上海租房,我用Python连夜爬了20000多条房源信息的详细内容。更多信息请关注PHP中文网其他相关文章!

Python:游戏,Guis等Apr 13, 2025 am 12:14 AM

Python:游戏,Guis等Apr 13, 2025 am 12:14 AMPython在游戏和GUI开发中表现出色。1)游戏开发使用Pygame,提供绘图、音频等功能,适合创建2D游戏。2)GUI开发可选择Tkinter或PyQt,Tkinter简单易用,PyQt功能丰富,适合专业开发。

Python vs.C:申请和用例Apr 12, 2025 am 12:01 AM

Python vs.C:申请和用例Apr 12, 2025 am 12:01 AMPython适合数据科学、Web开发和自动化任务,而C 适用于系统编程、游戏开发和嵌入式系统。 Python以简洁和强大的生态系统着称,C 则以高性能和底层控制能力闻名。

2小时的Python计划:一种现实的方法Apr 11, 2025 am 12:04 AM

2小时的Python计划:一种现实的方法Apr 11, 2025 am 12:04 AM2小时内可以学会Python的基本编程概念和技能。1.学习变量和数据类型,2.掌握控制流(条件语句和循环),3.理解函数的定义和使用,4.通过简单示例和代码片段快速上手Python编程。

Python:探索其主要应用程序Apr 10, 2025 am 09:41 AM

Python:探索其主要应用程序Apr 10, 2025 am 09:41 AMPython在web开发、数据科学、机器学习、自动化和脚本编写等领域有广泛应用。1)在web开发中,Django和Flask框架简化了开发过程。2)数据科学和机器学习领域,NumPy、Pandas、Scikit-learn和TensorFlow库提供了强大支持。3)自动化和脚本编写方面,Python适用于自动化测试和系统管理等任务。

您可以在2小时内学到多少python?Apr 09, 2025 pm 04:33 PM

您可以在2小时内学到多少python?Apr 09, 2025 pm 04:33 PM两小时内可以学到Python的基础知识。1.学习变量和数据类型,2.掌握控制结构如if语句和循环,3.了解函数的定义和使用。这些将帮助你开始编写简单的Python程序。

如何在10小时内通过项目和问题驱动的方式教计算机小白编程基础?Apr 02, 2025 am 07:18 AM

如何在10小时内通过项目和问题驱动的方式教计算机小白编程基础?Apr 02, 2025 am 07:18 AM如何在10小时内教计算机小白编程基础?如果你只有10个小时来教计算机小白一些编程知识,你会选择教些什么�...

如何在使用 Fiddler Everywhere 进行中间人读取时避免被浏览器检测到?Apr 02, 2025 am 07:15 AM

如何在使用 Fiddler Everywhere 进行中间人读取时避免被浏览器检测到?Apr 02, 2025 am 07:15 AM使用FiddlerEverywhere进行中间人读取时如何避免被检测到当你使用FiddlerEverywhere...

Python 3.6加载Pickle文件报错"__builtin__"模块未找到怎么办?Apr 02, 2025 am 07:12 AM

Python 3.6加载Pickle文件报错"__builtin__"模块未找到怎么办?Apr 02, 2025 am 07:12 AMPython3.6环境下加载Pickle文件报错:ModuleNotFoundError:Nomodulenamed...

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Atom编辑器mac版下载

最流行的的开源编辑器

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

Dreamweaver CS6

视觉化网页开发工具

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),