这段音频火爆外网!文字、图片一键生成逼真音效,音频界AIGC来了

- 王林转载

- 2023-04-12 18:25:041881浏览

近期 AIGC 如同上了热搜一般,火热程度居高不下,当然除了名头格外响亮,突破也是绝对斐然:输入自然语言就可自动生成图像、视频甚至是 3D 模型,你说意不意外?

但在音频音效的领域,AIGC 的福利似乎还差了一些。主要由于高自由度音频生成需要依靠大量文本 - 音频对数据,同时长时波形建模还有诸多困难。为了解决上述困难,浙江大学与北京大学联合火山语音,共同提出了一款创新的、文本到音频的生成系统,即 Make-An-Audio。其可以将自然语言描述作为输入,而且是任意模态(例如文本、音频、图像、视频等)均可,同时输出符合描述的音频音效,广大网友很难不为其可控性以及泛化性点赞。

- 论文链接:https://arxiv.org/abs/2301.12661

- 项目链接:https://text-to-audio.github.io

短短两天,Demo 视频在 Twitter 上获得了 45K 的播放量。

2023 年除夕后,以 Make-An-Audio、 MusicLM 等大量音频合成文章涌现,48 小时内已经有 4 篇突破性的进展。

网友评论 1

广大网友们纷纷表示,AIGC 音效合成将会改变电影、短视频制作的未来。

网友评论 2

网友评论 3

更有网友发出这样的感叹:「audio is all you need……」

网友评论 4

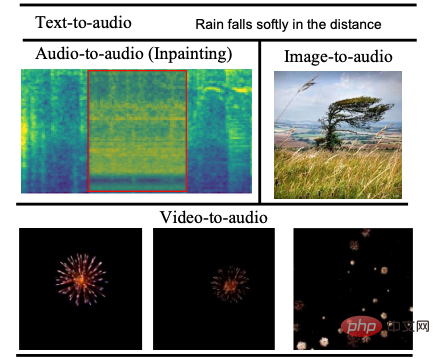

听觉效果展示

话不多说直接看效果,根据文本生成音效原来也可以如此便捷顺畅。

文本 1:a speedboat running as wind blows into a microphone

转化音频1音频:00:0000:09

文本 2:fireworks pop and explode

转化音频2音频:00:0000:09

是不是也一度因破损音频修复而大伤脑筋?Make-An-Audio 模型一出,这事儿就变得简单多了。

修复前

修复前音频

修复前音频音频:00:0000:09

修复后

修复后音频

修复后音频音频:00:0000:09

通过理解图片生成音效,也不是不可以。

图片 1

转化音频

图片转化音频音频:00:0000:09

图片 2

转化音频

图片转化音频2音频:00:0000:09

根据视频内容生成对应音效,这款模型也可以轻松做到。

视频 1

转化音频

视频1音频:00:0000:09

视频 2

转化音频

视频2音频:00:0000:09

模型内在技术原理

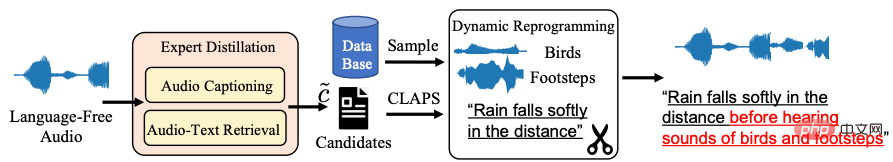

深度解析「网红」模型的神奇内在,还要回到音频 - 自然语言对数据稀少的客观问题上,对此浙大北大联合火山语音团队协同两大高校共同提出了Distill-then-Reprogram 文本增强策略,即使用教师模型获得音频的自然语言描述,再通过随机重组获得具有动态性的训练样本。

具体来说,在 Distill 环节中,使用音频转文本与音频 - 文本检索模型,找到语言缺失 (Language-Free) 音频的自然语言描述候选 (Candidate),通过计算候选文本与音频的匹配相似度,在阈值下取得最佳结果作为音频的描述。该方法具有强泛化性,且真实自然语言避免了测试阶段的域外文本。「在 Reprogram 环节中,团队从额外的事件数据集中随机采样,并与当前训练样本相结合,得到全新的概念组合与描述,以扩增模型对不同事件组合的鲁棒性。」 研究团队表示。

Distill-then-Reprogram 文本增强策略框架图

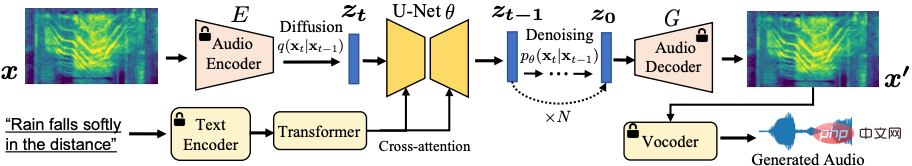

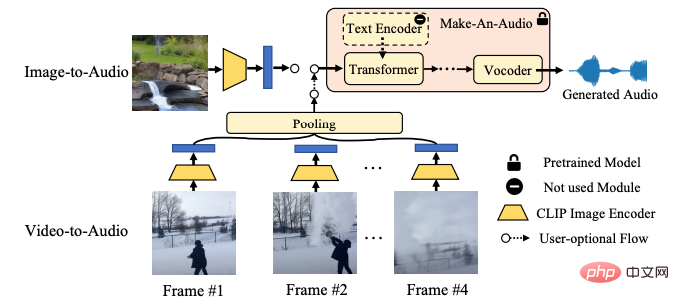

如上图所示,自监督学习已经成功将图片迁移到音频频谱,利用了频谱自编码器以解决长音频序列问题,并基于 Latent Diffusion 生成模型完成对自监督表征的预测,避免了直接预测长时波形。

Make-An-Audio 模型系统框架图

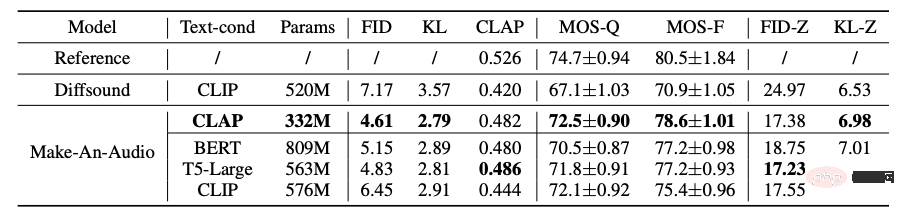

此外在研究中团队还探索了强大的文本条件策略,包括对比式 Contrastive Language-Audio Pretraining (CLAP) 以及语言模型 (LLM) T5, BERT 等,验证了 CLAP 文本表征的有效与计算友好性。同时还首次使用 CLAP Score 来评估生成的音频,可以用于衡量文本和生成场景之间的一致性;使用主、客观相结合的评估方式,在 benchmark 数据集测试中验证了模型的有效性,展示了模型出色的零样本学习 (Zero-Shot) 泛化性等。

Make-An-Audio 与基线模型主客观评测实验结果

神奇模型的应用前景知多少?

总体来看,Make-An-Audio 模型实现了高质量、高可控性的音频合成,并提出了「No Modality Left Behind」,对文本条件音频模型进行微调 (finetune),即能解锁对任意模态输入的音频合成 (audio/image/video)。

Make-An-Audio 首次实现高可控 X - 音频的 AIGC 合成,X 可以是文本 / 音频 / 图像 / 视频

在视觉指导的音频合成上,Make-An-Audio 以 CLIP 文本编码器为条件,利用其图像 - 文本联合空间,能够直接以图像编码为条件合成音频。

Make-An-Audio 视觉 - 音频合成框架图

可以预见的是,音频合成 AIGC 将会在未来电影配音、短视频创作等领域发挥重要作用,而借助 Make-An-Audio 等模型,或许在未来人人都有可能成为专业的音效师,都可以凭借文字、视频、图像在任意时间、任意地点,合成出栩栩如生的音频、音效。但现阶段 Make-An-Audio 也并不是完美无缺的,可能由于丰富的数据来源以及不可避免的样本质量问题,训练过程中难免会产生副作用,例如生成不符合文字内容的音频,Make-An-Audio 在技术上被定位是 “辅助艺术家生成”,可以肯定的一点,AIGC 领域的进展确实令人惊喜。

火山语音,长期以来面向字节跳动各大业务线提供全球优势的 AI 语音技术能力以及全栈语音产品解决方案,包括音频理解、音频合成、虚拟数字人、对话交互、音乐检索、智能硬件等。自 2017 年成立以来,团队专注研发行业领先的 AI 智能语音技术,不断探索 AI 与业务场景的高效结合,以实现更大的用户价值。目前其语音识别和语音合成已经覆盖了多种语言和方言,多篇技术论文入选各类 AI 顶级会议,为抖音、剪映、飞书、番茄小说、Pico 等业务提供了领先的语音能力,并适用于短视频、直播、视频创作、办公以及穿戴设备等多样化场景,通过火山引擎开放给外部企业。

以上是这段音频火爆外网!文字、图片一键生成逼真音效,音频界AIGC来了的详细内容。更多信息请关注PHP中文网其他相关文章!