2021年12月,GitHub发布了一次技术预览(technology preview),针对GitHub代码搜索「啥也搜不出来」的问题进行了一次全面优化。

去年11月,在GitHub Universe开发者大会上,官方再次发布了公开测试版,主要解决开发者寻找、阅读和导航代码的问题。

在大会上,有人问了一个重要的问题,「代码搜索」改进背后的原理到底是什么?

最近,GitHub发布了一篇博客,详细解释了新模型背后的技术原理和系统架构。

从零打造GitHub搜索引擎

简单来说,新搜索引擎的背后就是研究人员用Rust重新编写的一个轮子,专门针对代码搜索进行优化,代号黑鸟(Blackbird)。

乍一看,从零开始构建搜索引擎似乎是一个令人费解的决定:为什么要从头再来?现有的开源解决方案不是已经很多了吗?为什么还要再浪费精力造一个新的东西?

实际上GitHub一直在尝试使用现有的解决方案来解决搜索问题,但不巧的是,用于通用文本搜索的产品很难适配到「代码」搜索上。由于索引速度太慢,导致用户体验很差,并且所需的服务器数量很大,运行成本也过高。

虽然有一些较新的、专门适配于代码搜索的开源项目,但它们仍然不适合 GitHub这么大规模的代码库。

基于上述观察,GitHub的开发者设定的目标和结论主要有三个:

1. 用户在搜索过程中能够得到全新的体验,可以通过提出一些代码上的问题来迭代搜索、浏览、导航(navigate)和阅读代码来得到答案。

2. 代码搜索与通用文本搜索之间有着许多不同之处。

开发者编写代码是为了让机器理解,所以代码搜索的过程应该利用上代码的结构和相关性;并且用户可能会搜索标点符号(例如,句号、开括号等代码中的操作符);不要对代码中的词做词干分析(stemming);不要从query中删除停止词;或者使用正则表达式进行搜索。

3. GitHub 的规模确实是一个独特的挑战。

旧版本的搜索引擎使用的是Elasticsearch,第一次部署的时候花了几个月的时间来索引GitHub上的所有代码(当时大约有800万个代码库),但现在代码仓库数量已经超过了2亿,而且这些代码还不是静态的:开发者不断提交,代码也在不断变化,对于构建搜索引擎来说非常具有挑战性。

目前在测试版中,用户可以搜索大约4500万个代码库,包含115TB的代码和155亿个文档。

综上所述,现成的东西满足不了需求,所以,从零开始再造一个。

试试Grep?

在搜索的时候,一个常用的工具就是「grep」,通过输入表达式,就能在文本中进行匹配,所以为什么不干脆用grep蛮力解决搜索问题?

为了回答这个问题,可以先计算一下用ripgrep对115TB的代码进行匹配需要多长时间。

在一台配备8核 Intel CPU 的机器上,ripgrep 可以在2.769秒内(约0.6 GB/sec/core)对缓存在内存中的13 GB 文件运行正则表达式查询。

简单的计算后就能发现,对于当下的海量数据来说,该方法是行不通的:假设代码搜索程序运行在一个拥有32台服务器的集群上,每台机器有64个核心,即使把115TB的代码全放到内存里,并且一切运行顺利,2,048个 CPU 核大概需要96秒跑完「一个」query,而且只能是一个,其他用户得排队,也就是说只有QPS是0.01的话才能用grep

所以蛮力走不通,只能先建一个索引。

搜索索引(serach index)

只有以索引的形式预先计算好相关信息后,才能让搜索引擎在查询时快速响应,简单来说,索引就是一个key-value映射,在倒排索引(inverted index)的情况下,key就是一个关键词,value就是出现该词的有序文档ID列表。

在代码搜索任务中,研究人员用到了一种特殊类型的倒排索引,即ngram索引。

一个 ngram 是长度为 n 的字符序列,例如 n = 3(trigams)意为key的最大长度只能是3,对于较长的key来说,就需要按照长度3进行切割,比如limits就被分为lim, imi, mit和its

执行搜索时,综合多个key的查询结果,合并后得到该字符串所出现的文档列表

下一个问题是如何在相对合理的时间内完成索引的构建。

研究人员观察到:Git 使用内容寻址散列,以及 GitHub 上实际上有相当多的重复内容,所以研究人员提出下面两个方法建立索引。

1. shard by Git blob object ID 提供了一种在 shards 之间均匀分布文档的好方法,并且可以避免重复,同时能够根据需要随时扩展shards的数量。

2. 将索引建模为树,并使用差分编码(delta encoding)来减少crawling的数量并优化索引中的元数据,其中元数据包括文档出现的位置列表(哪个path、分支和代码库)以及关于这些对象的信息(代码库名称、所有者、可见性等)。对于一些热门仓库来说,元数据量可能会相当大。

GitHub还设计了一个系统,使得查询结果与提交后的代码保持一致。

如果用户在团队成员推送代码时搜索代码库,那么在系统完全处理完新提交的文档之前,搜索结果中不应该包含这些文档,Blackbird将commit查询一致性作为其设计的核心部分。

Blackbird

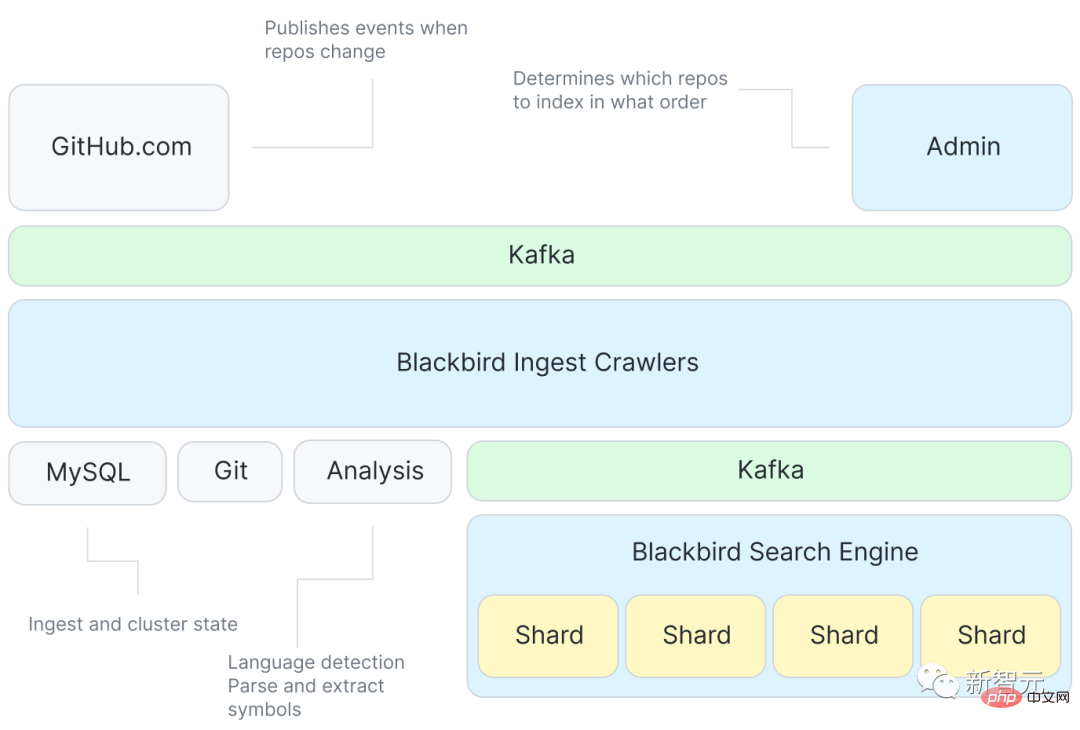

下面是Blackbird搜索引擎的架构图。

首先,Kafka会提供events来指定索引的内容,然后就会有大量的爬虫(crawler)程序与Git进行交互,其中还有一个从代码中提取符号的服务;再次使用Kafka对每个shard进行索引,获取目标文档。

虽然该系统只是响应像「git push」来抓取更改内容等类似的事件,但在首次ingest所有代码库时还需要做一些额外的工作。

该系统的一个关键特性就是对初始ingest顺序的优化以充分利用增量编码。

GitHub使用了一种全新的概率数据结构来表示代码库的相似性,并且通过从代码库相似性图的一个最小生成树的水平顺序遍历中计算得到ingest的顺序。

基于优化后的ingest顺序,delta 树的构建过程就是将每个代码库与其父代码库进行差分,这也意味着该系统只需要抓取当前代码库所特有的 blobs,爬取包括从 Git 获取 blob 内容,分析后提取符号,以及创建将作为索引输入的文档。

然后将这些文件发布到另一个Kafka主题中,也是在shards之间将数据分区的地方。每个shards使用主题中的一个Kafka分区。

使用Kafka可以将索引与crawl解耦,并且Kafka中对消息的排序也可以也可以使得查询结果一致。

然后,indexer shards找到这些文档并构建索引:tokenizing内容、符号和path以构造 ngram indices和其他有用的indices(语言、所有者、代码库等) ,并将结果刷新到磁盘上。

最后,对shards进行压缩(compaction),将较小的索引折叠成较大的索引,这样查询起来更有效,移动起来也更容易。

query的生命周期

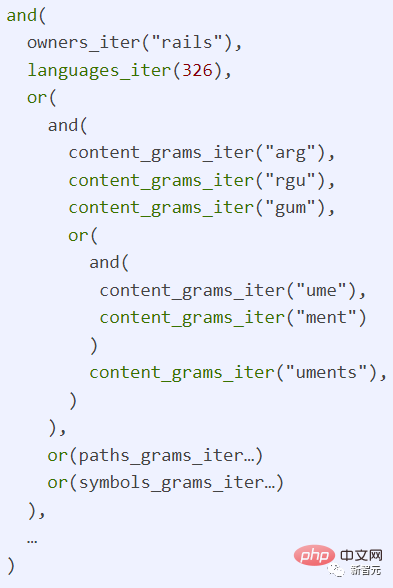

有了索引之后,通过系统跟踪query就变得简单了,每个query都是一个正则表达式,可以写作「/arguments?/ org:rails lang:Ruby」,即查找一个由Rails组织用Ruby语言编写的代码。

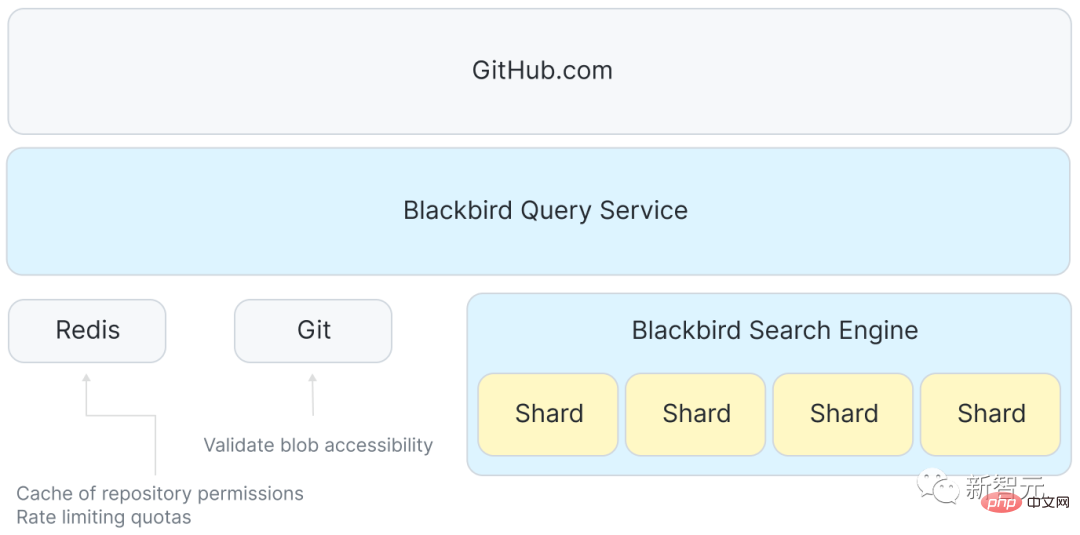

在 GitHub.com 和shards之间还有一个服务,负责协调接收用户query,并将请求分散到搜索集群中的每个主机上,最后使用 Redis 来管理磁盘空间(quotas)和缓存一些访问控制数据。

前端接受一个用户查询并将其传递给黑鸟,然后将query解析为一个抽象语法树,将其重写为规范的语言 ID,并在额外的子句上标记权限和范围。

下一步将发送 n 个并发请求: 向搜索集群中的每个shard发送一个,系统中设定的sharding策略就是向集群中的每个shard发送查询请求。

然后,在每个单独的shard上对查询进行一些转换以便在索引中查找信息。

最后聚合所有shard返回的结果,按分数重新排序,筛选(再次检查权限) ,并返回 top 100,然后GitHub.com 的前端进行语法突显、术语高亮、分页,最后我们才能将结果呈现给页面。

实际使用中,单个shard的p99响应时间大约是100ms,但是由于聚合response、检查权限以及语法突显等原因,总的响应时间要长一些。

一个query在索引服务器上占用一个 CPU 核心100毫秒,因此64个核心主机的上限大约是每秒640个查询。与 grep 方法(0.01 QPS)相比,这种方法可以说是相当快了。

总结

完整的系统架构介绍完以后,可以重新来审视一下问题的规模了。

GitHub的ingest pipeline每秒可以发布大约12万个文档,因此全部处理完155亿个文档需要大约36个小时;但是增量索引(delta indexing)可以降低所需抓取的文档数量的50%以上,使得整个过程可以在大约18小时内重新索引整个语料库。

在索引规模方面取得了一些突破,初始的内容量为115TB,删除重复内容、使用增量索引后将内容的数量减少到28TB左右。

而索引本身只有25TB,其中不仅包括所有索引(含ngram) ,还包括所有唯一内容的压缩副本,这也意味着包括内容在内的总索引大小大约只有原始数据大小的四分之一!

以上是放弃ElasticSearch,GitHub从零打造搜索引擎!2亿代码仓库怎么搜?的详细内容。更多信息请关注PHP中文网其他相关文章!

易于理解的解释如何保存对话历史记录(对话日志)!May 16, 2025 am 05:41 AM

易于理解的解释如何保存对话历史记录(对话日志)!May 16, 2025 am 05:41 AM高效保存ChatGPT对话记录的多种方法 您是否曾想过保存ChatGPT生成的对话记录?本文将详细介绍多种保存方法,包括官方功能、Chrome扩展程序和截图等,助您充分利用ChatGPT对话记录。 了解各种方法的特点和步骤,选择最适合您的方式。 [OpenAI最新发布的AI代理“OpenAI Operator”介绍](此处应插入OpenAI Operator的链接) 目录 使用ChatGPT导出功能保存对话记录 官方导出功能的使用步骤 使用Chrome扩展程序保存ChatGPT日志 ChatGP

使用Chatgpt创建时间表!解释可用于创建和调整表的提示May 16, 2025 am 05:40 AM

使用Chatgpt创建时间表!解释可用于创建和调整表的提示May 16, 2025 am 05:40 AM现代社会节奏紧凑,高效的日程管理至关重要。工作、生活、学习等任务交织在一起,优先级排序和日程安排常常让人头疼不已。 因此,利用AI技术的智能日程管理方法备受关注。特别是利用ChatGPT强大的自然语言处理能力,可以自动化繁琐的日程安排和任务管理,显着提高生产力。 本文将深入讲解如何利用ChatGPT进行日程管理。我们将结合具体的案例和步骤,展示AI如何提升日常生活和工作效率。 此外,我们还会讨论使用ChatGPT时需要注意的事项,确保安全有效地利用这项技术。 立即体验ChatGPT,让您的日程

如何将chatgpt与电子表格连接!对您可以做什么的详尽解释May 16, 2025 am 05:39 AM

如何将chatgpt与电子表格连接!对您可以做什么的详尽解释May 16, 2025 am 05:39 AM我们将解释如何将Google表和Chatgpt联系起来,以提高业务效率。在本文中,我们将详细解释如何使用易于使用的“床单和文档的GPT”附加组件。无需编程知识。 通过CHATGPT和电子表格集成提高业务效率 本文将重点介绍如何使用附加组件将Chatgpt与电子表格连接。附加组件使您可以轻松地将ChatGpt功能集成到电子表格中。 gpt for shee

6个投资者对AI的预测于2025年May 16, 2025 am 05:37 AM

6个投资者对AI的预测于2025年May 16, 2025 am 05:37 AM专家们预测AI革命的未来几年,专家们预测专家们都在强调了总体趋势和模式。例如,对数据的需求很大,我们将在后面讨论。此外,对能量的需求是D

使用chatgpt进行写作!提示的提示和示例的详尽说明!May 16, 2025 am 05:36 AM

使用chatgpt进行写作!提示的提示和示例的详尽说明!May 16, 2025 am 05:36 AMChatgpt不仅是文本生成工具,而且是一个真正的合作伙伴,可显着提高作家的创造力。通过在整个写作过程中使用chatgpt,例如初始手稿创建,构思想法和风格变化,您可以同时节省时间并提高质量。本文将详细说明在每个阶段使用Chatgpt的特定方法,以及最大化生产力和创造力的技巧。此外,我们将研究将Chatgpt与语法检查工具和SEO优化工具相结合的协同作用。通过与AI的合作,作家可以通过免费想法创造独创性

如何在chatgpt中创建图形!无需插件,因此也可以用于Excel!May 16, 2025 am 05:35 AM

如何在chatgpt中创建图形!无需插件,因此也可以用于Excel!May 16, 2025 am 05:35 AM使用chatgpt的数据可视化:从图创建到数据分析 数据可视化以易于理解的方式传达复杂信息,在现代社会中至关重要。近年来,由于AI技术的进步,使用Chatgpt的图形创建引起了人们的关注。在本文中,我们将解释如何以易于理解的方式使用Chatgpt创建图形,甚至对于初学者。我们将介绍免费版本和付费版本(Chatgpt Plus),特定创建步骤以及如何显示日语标签以及实际示例之间的差异。 使用chatgpt创建图形:从基础到高级使用 chatg

用餐盘推动现代LLM的极限?May 16, 2025 am 05:34 AM

用餐盘推动现代LLM的极限?May 16, 2025 am 05:34 AM通常,我们知道AI很大,而且越来越大。快速,越来越快。 但是,具体来说,并不是每个人都熟悉行业中一些最新的硬件和软件方法,以及它们如何促进更好的结果。人民

归档您的Chatgpt对话历史!解释保存的步骤以及如何还原May 16, 2025 am 05:33 AM

归档您的Chatgpt对话历史!解释保存的步骤以及如何还原May 16, 2025 am 05:33 AMChatGPT对话记录管理指南:高效整理,充分利用你的知识宝库! ChatGPT对话记录是创意和知识的源泉,但不断增长的记录如何有效管理呢? 查找重要信息耗时费力?别担心!本文将详细讲解如何有效“归档”(保存和管理)你的ChatGPT对话记录。我们将涵盖官方归档功能、数据导出、共享链接以及数据利用和注意事项。 目录 ChatGPT的“归档”功能详解 ChatGPT归档功能使用方法 ChatGPT归档记录的保存位置和查看方法 ChatGPT归档记录的取消和删除方法 取消归档 删除归档 总结 Ch

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

SublimeText3 Linux新版

SublimeText3 Linux最新版

EditPlus 中文破解版

体积小,语法高亮,不支持代码提示功能

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中