语言生成模型来了,学校的作业会不会从此变得形同虚设?近日,纽约市教育官员宣布禁止学生在公立学校使用 ChatGPT 的事件引发了争论。

语言模型自动生成的内容会「参照」现有作品,产出的速度又几乎无限,人们对其的担忧已经蔓延到了 AI 学界自身,全球知名机器学习会议之一的 ICML 最近也宣布禁止发表包含由 ChatGPT 和其他类似系统生成内容的论文,以免出现「意外后果」。

对于这样的情况,ChatGPT 的提出者 OpenAI 已宣布正在努力开发「缓解措施」,帮助人们检测由 AI 自动生成的文本。

「我们将 ChatGPT 作为新研究的预览技术,希望能从现实世界的应用中进行学习。我们认为这是开发和部署功能强大、安全的 AI 系统的关键部分。我们会不断吸取反馈和经验教训,」公司发言人表示。「OpenAI 一直呼吁在使用 AI 生成的文本时要保持透明。我们的使用条款要求用户在使用我们的 API 和创意工具时,首先对其面向的人群负责……我们期待与教育工作者合作制定有效的解决方案,帮助教师和学生等人群寻找从 AI 中受益的方法。」

如果出现了能够区分人类和机器产生内容的算法,生成模型在学术界的使用方式或许会出现改变。学校将能够更有效地限制人工智能生成的论文,而如果人们的态度发生转变,转而期待这些工具能够帮助学生,或许我们也可以逐渐接受使用 AI 进行辅助的方式,提高工作学习的效率。

现在看起来,眼前还有很长的一段路要走。尽管 AI 生成的文字内容在学术会议和学校禁止机器写论文作弊的新闻中看起来令人印象深刻,但你需要知道,与真正的人类写作相比,它们时常缺乏真正的理解与逻辑。

当像 GPT-3 或 ChatGPT 这样的工具通过给出令人震惊的详细答案而让人感到惊讶时,也有冷静的专家表示这证明了模型能够编码知识,但当它们无法正确处理事情时,给出的答案往往很离谱。波莫纳学院 (Pomona College) 经济学教授 Gary Smith 提醒我们,不要上当。

在一篇专栏文章中,Gary Smith 展示了几个 GPT-3 无法有效推理和回答问题的例子,「如果你尝试使用 GPT-3,你最初的反应可能是惊讶——似乎是在与一个非常聪明的人进行真正的对话。然而深入探究后,你很快就会发现虽然 GPT-3 可以用令人信服的方式将单词串在一起,但它并不知道单词的含义。」

「预测 down 这个词有可能跟在 fell 这个词后面,并不要求对这两个词的含义有任何理解。只是通过统计层面的计算,AI 就能认为这些词经常在一起。因此,GPT-3 很容易做出完全错误,但又武断的声明。」

OpenAI 在 2022 年 11 月发布了 ChatGPT,这是一个较新的模型,基于 GPT-3 进行了改进。尽管如此,它仍然存在着这些相同的问题,就像所有现有的语言模型一样。

如何用 AI 检测 AI 生成的文字?

曾几何时,AI 生成的文字内容还是「一眼假」,但自从 ChatGPT 横空出世以来,这种分辨工作是越来越难做了。

在教育领域,ChatGPT 的争论主要围绕作弊的可能性展开。在谷歌上搜索「ChatGPT 写论文」,你能发现大量教育工作者、记者和学生通过使用 ChatGPT 完成家庭作业和标准化论文测试来试水的例子。

《华尔街日报》的专栏作家曾使用 ChatGPT 撰写了一篇能拿及格分的 AP 英语论文,而《福布斯》记者则利用它在 20 分钟内完成了两篇大学论文。亚利桑那州立大学教授 Dan Gillmor 在接受卫报采访时回忆说,他尝试给 ChatGPT 布置一道给学生的作业,结果发现 AI 生成的论文也可以获得好成绩。

目前,已经有开发者制作了面向 ChatGPT 生成内容的检测工具——「GPTZero」,只需要将内容粘贴在输入框,就能在几秒钟之内得到分析结果,快速检测出一篇文章是 ChatGPT 还是人工撰写的。

网友评:世界各地的学生看到后都哭了。

网友评:世界各地的学生看到后都哭了。

作者是普林斯顿大学的学生 Edward Tian,他利用假期的一部分时间编写了 GPTZero。

让我们看看检测过程,先以一段《New Yorker》的报道内容为例(百分之百确定由人类写作):

再看一段由 ChatGPT 生成的内容接受检测:

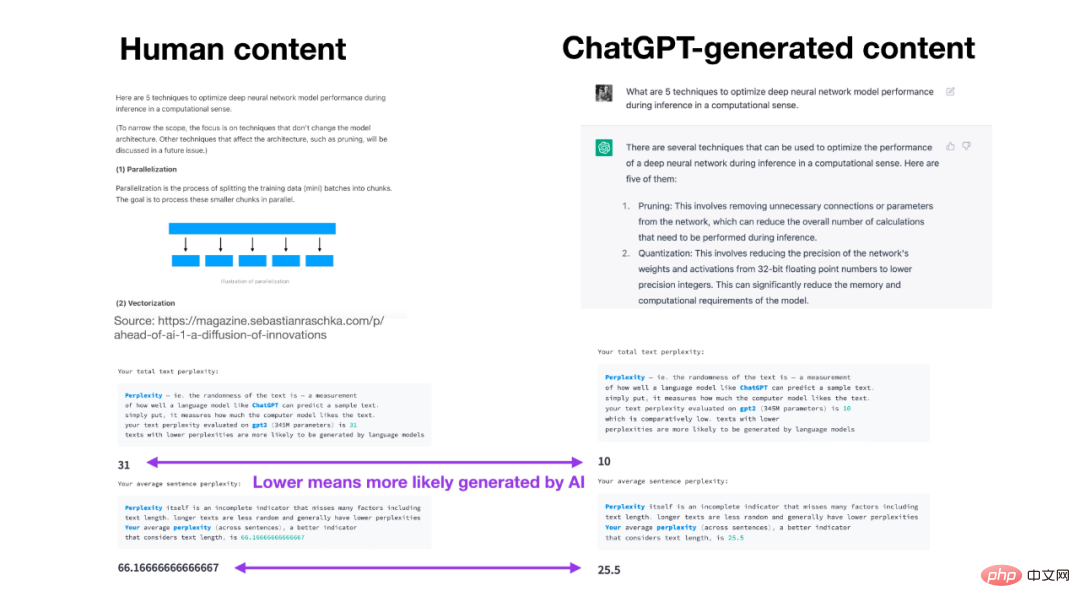

GPTZero 应用程序的原理是借助一些文本属性进行分析。首先是困惑度(perplexity),即文本对模型的随机性,或语言模型对文本的「喜爱」程度;然后是突发度(burstiness),即机器写作的文本在一段时间内表现出的困惑度更均匀和恒定,而人类书写的文本则不会这样。

GPTZero:「同学们,对不起!教授们,不客气!」

GPTZero:「同学们,对不起!教授们,不客气!」

据《卫报》报道,OpenAI 目前正在开发一项功能,用于统计 ChatGPT 输出结果的「水印」,以便阅读器可以在 AI 文本选择中发现隐藏模式。

在得克萨斯大学的一次演讲中,OpenAI 客座研究员 Scott Aaronson 表示,公司正在研究一种通过「对输出进行统计水印」来打击作弊的系统。Aaronson 说,这项技术将通过微妙地调整 ChatGPT 选择的特定单词选择来发挥作用,读者不会注意到这种方式,但对于任何寻找机器生成文本迹象的人来说,这在统计上都是可预测的。

「我们实际上有一个水印方案的工作原型了,」Aaronson 补充道。「它似乎表现很好——根据经验,几百个词似乎足以得到一个信号:是的,这段文本来自 GPT。」

虽然面临人们的担忧,但有关 ChatGPT 的应用也在快速铺开。在很多场景中,人们不想与无法理解简单查询的聊天机器人对话,什么都可以说上两句的 ChatGPT 可以解决这一问题。总部位于多伦多的 Ada 已与 OpenAI 合作把 GPT-3.5,ChatGPT 背后的大模型应用在了客服聊天机器人上,完成了 45 亿次客户服务交互。

据 The Information 报道,微软还与 OpenAI 签订了独家许可协议,并计划将该技术整合到 Bing 搜索引擎中。

ChatGPT 正在模拟真人的道路上加速前进,这场打假的战役还会继续下去。

以上是ChatGPT作弊成风引担忧,OpenAI:正在自研审核工具的详细内容。更多信息请关注PHP中文网其他相关文章!

微软工作趋势指数2025显示工作场所容量应变Apr 24, 2025 am 11:19 AM

微软工作趋势指数2025显示工作场所容量应变Apr 24, 2025 am 11:19 AM由于AI的快速整合而加剧了工作场所的迅速危机危机,要求战略转变以外的增量调整。 WTI的调查结果强调了这一点:68%的员工在工作量上挣扎,导致BUR

AI可以理解吗?中国房间的论点说不,但是对吗?Apr 24, 2025 am 11:18 AM

AI可以理解吗?中国房间的论点说不,但是对吗?Apr 24, 2025 am 11:18 AM约翰·塞尔(John Searle)的中国房间论点:对AI理解的挑战 Searle的思想实验直接质疑人工智能是否可以真正理解语言或具有真正意识。 想象一个人,对下巴一无所知

中国的'智能” AI助手回应微软召回的隐私缺陷Apr 24, 2025 am 11:17 AM

中国的'智能” AI助手回应微软召回的隐私缺陷Apr 24, 2025 am 11:17 AM与西方同行相比,中国的科技巨头在AI开发方面的课程不同。 他们不专注于技术基准和API集成,而是优先考虑“屏幕感知” AI助手 - AI T

Docker将熟悉的容器工作流程带到AI型号和MCP工具Apr 24, 2025 am 11:16 AM

Docker将熟悉的容器工作流程带到AI型号和MCP工具Apr 24, 2025 am 11:16 AMMCP:赋能AI系统访问外部工具 模型上下文协议(MCP)让AI应用能够通过标准化接口与外部工具和数据源交互。由Anthropic开发并得到主要AI提供商的支持,MCP允许语言模型和智能体发现可用工具并使用合适的参数调用它们。然而,实施MCP服务器存在一些挑战,包括环境冲突、安全漏洞以及跨平台行为不一致。 Forbes文章《Anthropic的模型上下文协议是AI智能体发展的一大步》作者:Janakiram MSVDocker通过容器化解决了这些问题。基于Docker Hub基础设施构建的Doc

使用6种AI街头智能策略来建立一家十亿美元的创业Apr 24, 2025 am 11:15 AM

使用6种AI街头智能策略来建立一家十亿美元的创业Apr 24, 2025 am 11:15 AM有远见的企业家采用的六种策略,他们利用尖端技术和精明的商业敏锐度来创造高利润的可扩展公司,同时保持控制权。本指南是针对有抱负的企业家的,旨在建立一个

Google照片更新解锁了您所有图片的惊人Ultra HDRApr 24, 2025 am 11:14 AM

Google照片更新解锁了您所有图片的惊人Ultra HDRApr 24, 2025 am 11:14 AMGoogle Photos的新型Ultra HDR工具:改变图像增强的游戏规则 Google Photos推出了一个功能强大的Ultra HDR转换工具,将标准照片转换为充满活力的高动态范围图像。这种增强功能受益于摄影师

Descope建立AI代理集成的身份验证框架Apr 24, 2025 am 11:13 AM

Descope建立AI代理集成的身份验证框架Apr 24, 2025 am 11:13 AM技术架构解决了新兴的身份验证挑战 代理身份集线器解决了许多组织仅在开始AI代理实施后发现的问题,即传统身份验证方法不是为机器设计的

Google Cloud Next 2025以及现代工作的未来Apr 24, 2025 am 11:12 AM

Google Cloud Next 2025以及现代工作的未来Apr 24, 2025 am 11:12 AM(注意:Google是我公司的咨询客户,Moor Insights&Strateging。) AI:从实验到企业基金会 Google Cloud Next 2025展示了AI从实验功能到企业技术的核心组成部分的演变,

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

Dreamweaver Mac版

视觉化网页开发工具

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

Dreamweaver CS6

视觉化网页开发工具