智能网联汽车,与自动驾驶有什么关系?

自动驾驶核心在于车,那智能网联系统又是什么呢?智能网联的载体也是车,但核心是需要连接的网络。一个是汽车内部的传感器和智能控制系统构成的一张网络,另一个是所有汽车连接、共享的网络。网联就是将一台车置身到一张大的网络之中,去交换重要的信息,比如位置、路线、速度等信息。智能网联系统的发展目标就是通过汽车内部传感器和控制系统的设计优化能够改善汽车的安全性和舒适性,使汽车更加人性化,当然终极目标是在实现无人驾驶。

自动驾驶汽车三大核心辅助系统:环境感知系统、决策与规划系统和控制与执行系统,这也是智能网联汽车车辆本身必须解决的三大关键技术问题。

环境感知系统在智能网联系统里面扮演什么角色?

什么是环境感知技术,主要包含哪些内容?

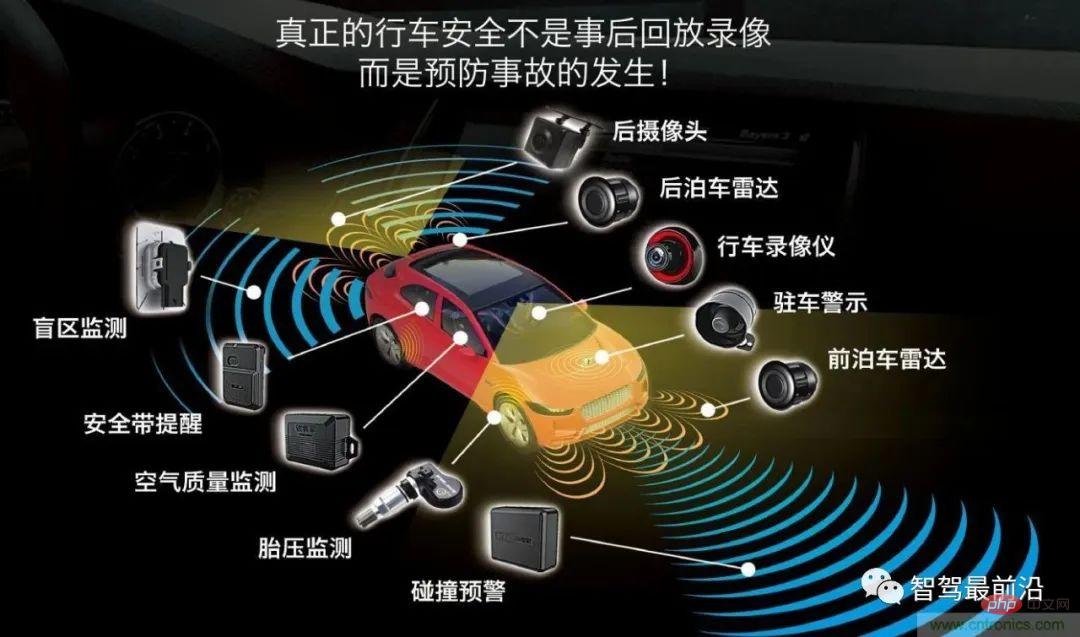

环境感知主要包括三个方面:传感器、感知和定位。传感器包括摄像头、毫米波雷达、激光雷达以及超声波,不同传感器被安置在车辆上,分别发挥着采集数据,识别颜色、测量距离等作用。

智能汽车要想采用传感器获得的数据去实现智能驾驶,通过传感器获得的数据必须经过(感知)算法处理,汇算成数据结果,实现车、路、人等信息交换,使车辆能够自动分析车辆行驶的安全还是危险状态,让车辆能够按照人的意愿实现智能驾驶,最终替代人来做出决策和无人驾驶目标。

那这里就会有个关键技术问题,不同传感器发挥的作用不同,多个传感器扫描到数据如何形成一个完整的物体图像数据呢?

多传感器融合技术

摄像头的作用主要是识别物体颜色,但会受阴雨天气的影响;毫米波雷达能够弥补摄像头受阴雨天影响的弊端,能够识别距离比较远的障碍物,比如行人、路障等,但是不能够识别障碍物的具体形状;激光雷达可以弥补毫米波雷达不能识别障碍物具体形状的缺点;超声波雷主要识别车身的近距离障碍物,应用在车辆泊车过程中比较多。要想融合不同传感器的收集到外界数据为控制器执行决策提供依据,就需要经过多传感器融合算法处理形成全景感知。

什么是多传感器融合(融合算法处理),主要有哪些融合算法?

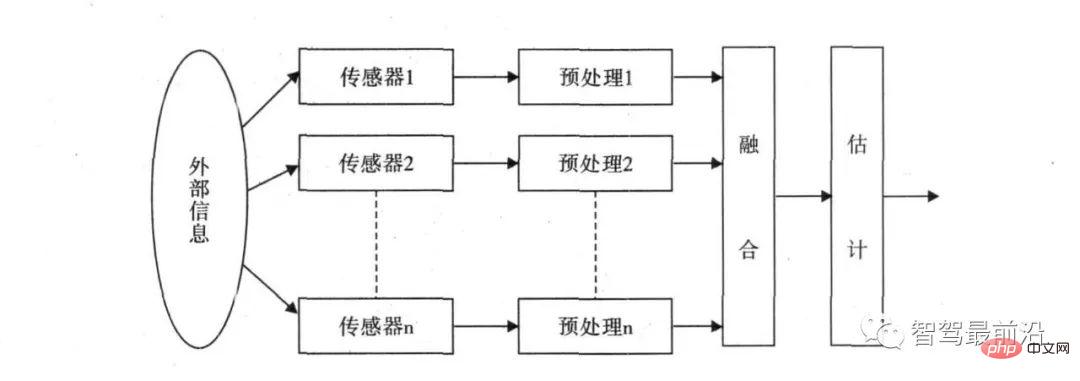

多传感器融合基本原理就像人脑综合处理信息的过程一样,将各种传感器进行多层次、多空间的信息互补和优化组合处理,最终产生对观测环境的一致性解释。在这个过程中要充分利用多源数据进行合理支配与使用,而信息融合的最终目标则是基于各传感器获得的分离观测信息,通过对信息多级别、多方面组合导出更多有用信息。这不仅是利用了多个传感器相互协同操作的优势,而且也综合处理了其它信息源的数据来提高整个传感器系统的智能化。

多传感器数据融合概念最早应用于军事领域,近年来随着自动驾驶的发展,各种雷达运用于车辆做目标的检测。因为不同的传感器都存在数据准确性的问题,那么最终融合的数据该如何判定?比如激光雷达报告前车距离是5m,毫米波雷达报告前车距离是5.5m,摄像头判定前车距离是4m,最终中央处理器该如何判断。那就需要一套多数据融合的算法来解决这个问题。

多传感器融合的常用方法分为两大类:随机和人工智能。AI类主要是模糊逻辑推理和人工神经网络方法;随机类方法主要有贝叶斯滤波、卡尔曼滤波等算法。目前汽车融合感知主要采用随机类融合算法。

自动驾驶汽车融合感知算法主要采用卡尔曼滤波算法,利用线性系统状态方程,通过系统输入输出观测数据,对系统状态进行最优估计的算法,它是目前解决绝大部分问题都是最优、效率最高的的方法。

多传感器需要进行融合算法处理,企业相应就会需要融合感知类的算法工程师去解决多传感器融合的问题,融合感知类的绝大多数的岗位要求都是需要能够掌握多种传感器的工作原理及信号的数据特征,能够掌握融合算法进行软件开发以及传感器标定算法能力以及点云数据处理、深度学习检测算法等等。

环境感知的的第三部分内容——定位(slam)

Slam叫做同步定位和制图,是假设场景是静态情况下通过摄像机的运动来获取图像序列并得到场景3-D结构的设计,这是计算机视觉的重要任务,摄像机获得的数据经过算法处理也就是视觉slam。

环境感知定位方法除了视觉slam,还有激光雷达slam、GPS/IMU和高精地图。这些传感器获得的数据都是需要经过算法的处理才能形成数据结果为自动驾驶决策提供位置信息依据。所以想要从事环境感知方向的工作,不仅可以选择融合感知算法岗位,还可以选择slam方向。

以上是一文浅析自动驾驶多传感器融合的详细内容。更多信息请关注PHP中文网其他相关文章!

学习Excel的十大YouTube频道 - 分析VidhyaApr 13, 2025 am 09:27 AM

学习Excel的十大YouTube频道 - 分析VidhyaApr 13, 2025 am 09:27 AM介绍 Excel对于提高所有领域的生产率和效率都是必不可少的。 YouTube上的广泛资源可以帮助各个级别的学习者找到针对他们需求的有用教程。这个AR

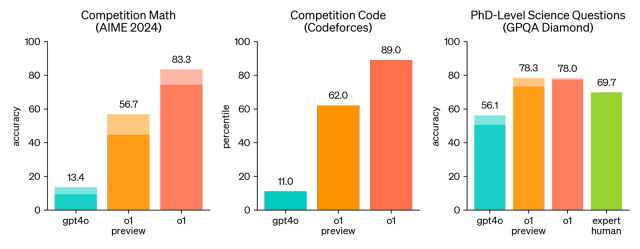

Openai O1:一种在回答问题之前'思考”的新模型Apr 13, 2025 am 09:26 AM

Openai O1:一种在回答问题之前'思考”的新模型Apr 13, 2025 am 09:26 AM你听到了大新闻吗? Openai刚刚推出了一系列新型AI模型的预览 - OpenAi O1(也称为草莓/Q*)。这些模型很特别,因为它们花费更多的时间“思考”

Claude vs Gemini:综合比较 - 分析VidhyaApr 13, 2025 am 09:20 AM

Claude vs Gemini:综合比较 - 分析VidhyaApr 13, 2025 am 09:20 AM介绍 在人工智能的快速变化领域中,两种语言模型Claude和Gemini已成为杰出的竞争者,每个语言都提供了不同的优势和技能。虽然这两种模型都可以法术

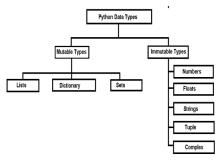

python中的可变与不变的物体 - 分析vidhyaApr 13, 2025 am 09:15 AM

python中的可变与不变的物体 - 分析vidhyaApr 13, 2025 am 09:15 AM介绍 Python是一种面向对象的编程语言(或OOPS)。在我的上一篇文章中,我们探索了它的多功能性质。因此,Python提供了多种数据类型,可以将其广泛分为M

11 YouTube频道免费学习Tableau -Analytics VidhyaApr 13, 2025 am 09:14 AM

11 YouTube频道免费学习Tableau -Analytics VidhyaApr 13, 2025 am 09:14 AM介绍 Tableau被认为是全球公司和个人目前正在使用的最强大的数据可视化工具之一,用于有效的数据分析和呈现。具有用户友好的界面并扩展

10个生成AI编码扩展,在VS代码中,您必须探索Apr 13, 2025 am 01:14 AM

10个生成AI编码扩展,在VS代码中,您必须探索Apr 13, 2025 am 01:14 AM嘿,编码忍者!您当天计划哪些与编码有关的任务?在您进一步研究此博客之前,我希望您考虑所有与编码相关的困境,这是将其列出的。 完毕? - 让&#8217

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PM

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PMAI增强食物准备 在新生的使用中,AI系统越来越多地用于食品制备中。 AI驱动的机器人在厨房中用于自动化食物准备任务,例如翻转汉堡,制作披萨或组装SA

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM介绍 了解Python功能中变量的名称空间,范围和行为对于有效编写和避免运行时错误或异常至关重要。在本文中,我们将研究各种ASP

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)