哈喽,大家好。

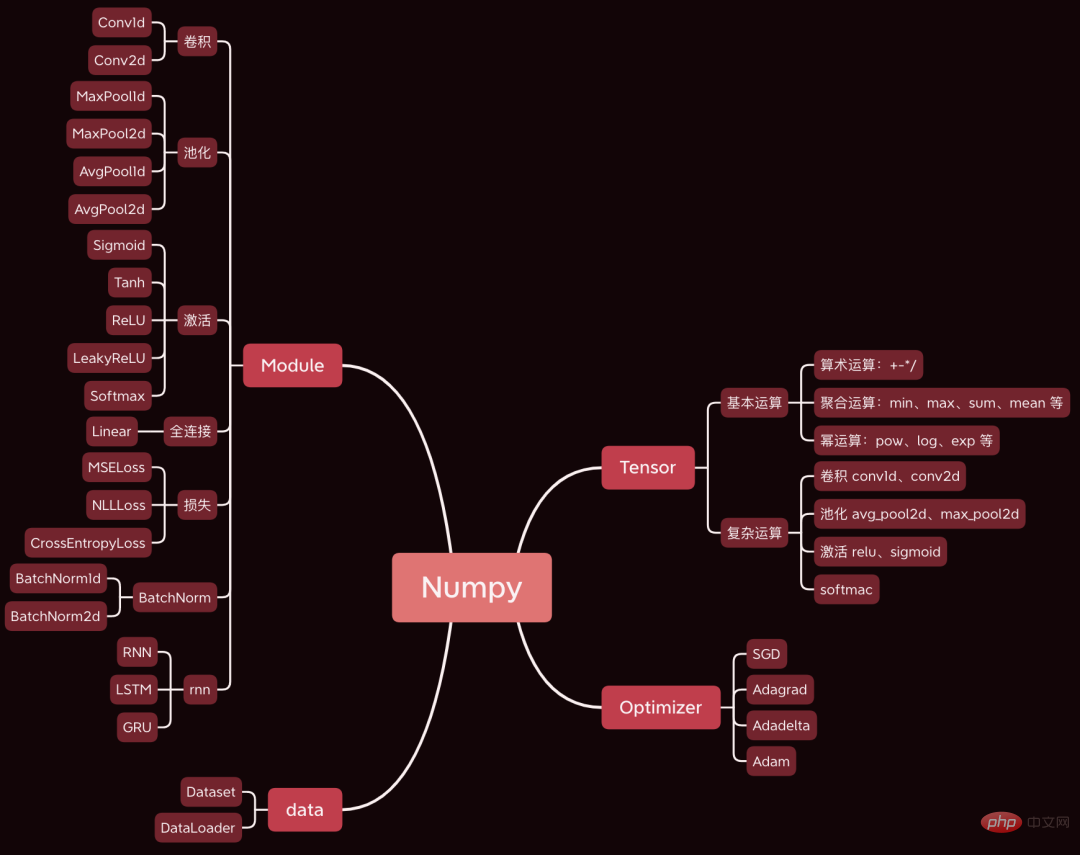

今天给大家分享一个非常牛逼的开源项目,用Numpy开发了一个深度学习框架,语法与 Pytorch 基本一致。

今天以一个简单的卷积神经网络为例,分析神经网络训练过程中,涉及的前向传播、反向传播、参数优化等核心步骤的源码。

使用的数据集和代码已经打包好,文末有获取方式。

1. 准备工作

先准备好数据和代码。

1.1 搭建网络

首先,下载框架源码,地址:https://github.com/duma-repo/PyDyNet

git clone https://github.com/duma-repo/PyDyNet.git

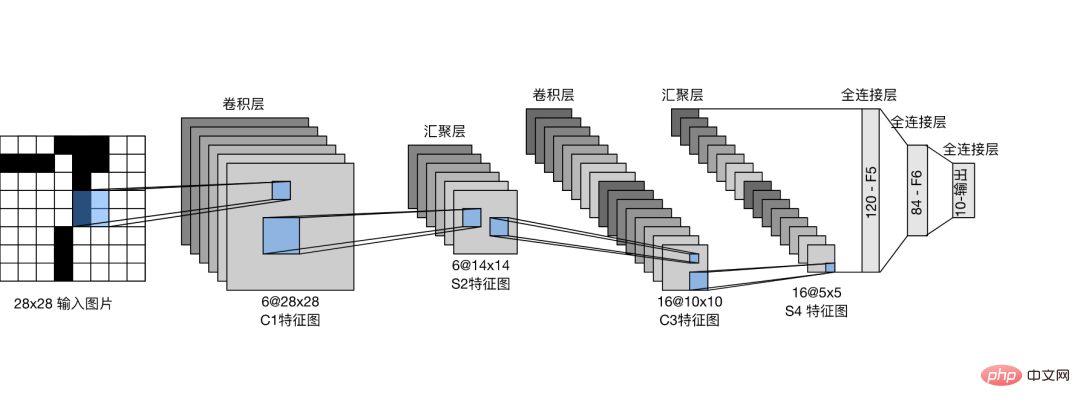

搭建LeNet卷积神经网络,训练三分类模型。

在PyDyNet目录直接创建代码文件即可。

from pydynet import nn class LeNet(nn.Module): def __init__(self): super().__init__() self.conv1 = nn.Conv2d(1, 6, kernel_size=5, padding=2) self.conv2 = nn.Conv2d(6, 16, kernel_size=5) self.avg_pool = nn.AvgPool2d(kernel_size=2, stride=2, padding=0) self.sigmoid = nn.Sigmoid() self.fc1 = nn.Linear(16 * 5 * 5, 120) self.fc2 = nn.Linear(120, 84) self.fc3 = nn.Linear(84, 3) def forward(self, x): x = self.conv1(x) x = self.sigmoid(x) x = self.avg_pool(x) x = self.conv2(x) x = self.sigmoid(x) x = self.avg_pool(x) x = x.reshape(x.shape[0], -1) x = self.fc1(x) x = self.sigmoid(x) x = self.fc2(x) x = self.sigmoid(x) x = self.fc3(x) return x

可以看到,网络的定义与Pytorch语法完全一样。

我提供的源代码里,提供了 summary 函数可以打印网络结构。

1.2 准备数据

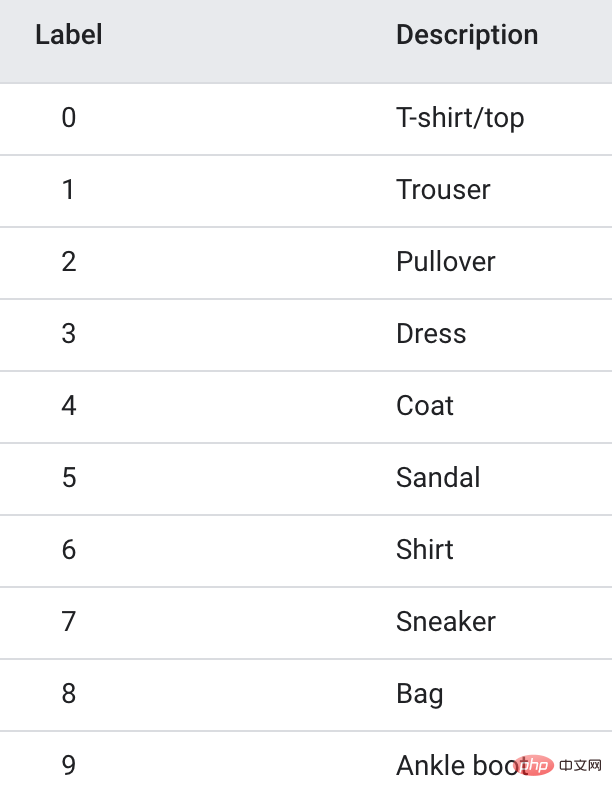

训练数据使用Fanshion-MNIST数据集,它包含10个类别的图片,每个类别 6k 张。

为了加快训练,我只抽取了前3个类别,共1.8w张训练图片,做一个三分类模型。

1.3 模型训练

import pydynet from pydynet import nn from pydynet import optim lr, num_epochs = 0.9, 10 optimizer = optim.SGD(net.parameters(), lr=lr) loss = nn.CrossEntropyLoss() for epoch in range(num_epochs): net.train() for i, (X, y) in enumerate(train_iter): optimizer.zero_grad() y_hat = net(X) l = loss(y_hat, y) l.backward() optimizer.step() with pydynet.no_grad(): metric.add(l.numpy() * X.shape[0], accuracy(y_hat, y), X.shape[0])

训练代码也跟Pytorch一样。

下面重点要做的就是深入模型训练的源码,来学习模型训练的原理。

2. train、no_grad和eval

模型开始训练前,会调用net.train。

def train(self, mode: bool = True): set_grad_enabled(mode) self.set_module_state(mode)

可以看到,它会将grad(梯度)设置成True,之后创建的Tensor是可以带梯度的。Tensor带上梯度后,便会将其放入计算图中,等待求导计算梯度。

而下面的with no_grad(): 代码

class no_grad: def __enter__(self) -> None: self.prev = is_grad_enable() set_grad_enabled(False)

会将grad(梯度)设置成False,这样之后创建的Tensor不会放到计算图中,自然也不需要计算梯度,可以加快推理。

我们经常在Pytorch中看到net.eval()的用法,我们也顺便看一下它的源码。

def eval(self): return self.train(False)

可以看到,它直接调用train(False)来关闭梯度,效果与no_grad()类似。

所以,一般在训练前调用train打开梯度。训练后,调用eval关闭梯度,方便快速推理。

3. 前向传播

前向传播除了计算类别概率外,最最重要的一件事是按照前传顺序,将网络中的 tensor 组织成计算图,目的是为了反向传播时计算每个tensor的梯度。

tensor在神经网络中,不止用来存储数据,还用计算梯度、存储梯度。

以第一层卷积操作为例,来查看如何生成计算图。

def conv2d(x: tensor.Tensor, kernel: tensor.Tensor, padding: int = 0, stride: int = 1): '''二维卷积函数 ''' N, _, _, _ = x.shape out_channels, _, kernel_size, _ = kernel.shape pad_x = __pad2d(x, padding) col = __im2col2d(pad_x, kernel_size, stride) out_h, out_w = col.shape[-2:] col = col.transpose(0, 4, 5, 1, 2, 3).reshape(N * out_h * out_w, -1) col_filter = kernel.reshape(out_channels, -1).T out = col @ col_filter return out.reshape(N, out_h, out_w, -1).transpose(0, 3, 1, 2)

x是输入的图片,不需要记录梯度。kernel是卷积核的权重,需要计算梯度。

所以,pad_x = __pad2d(x, padding) 生成的新的tensor也是不带梯度的,因此也不需要加入计算图中。

而kernel.reshape(out_channels, -1)产生的tensor则是需要计算梯度,也需要加入计算图中。

下面看看加入的过程:

def reshape(self, *new_shape): return reshape(self, new_shape) class reshape(UnaryOperator): ''' 张量形状变换算子,在Tensor中进行重载 Parameters ---------- new_shape : tuple 变换后的形状,用法同NumPy ''' def __init__(self, x: Tensor, new_shape: tuple) -> None: self.new_shape = new_shape super().__init__(x) def forward(self, x: Tensor) return x.data.reshape(self.new_shape) def grad_fn(self, x: Tensor, grad: np.ndarray) return grad.reshape(x.shape)

reshape函数会返回一个reshape类对象,reshape类继承了UnaryOperator类,并在__init__函数中,调用了父类初始化函数。

class UnaryOperator(Tensor): def __init__(self, x: Tensor) -> None: if not isinstance(x, Tensor): x = Tensor(x) self.device = x.device super().__init__( data=self.forward(x), device=x.device, # 这里 requires_grad 为 True requires_grad=is_grad_enable() and x.requires_grad, )

UnaryOperator类继承了Tensor类,所以reshape对象也是一个tensor。

在UnaryOperator的__init__函数中,调用Tensor的初始化函数,并且传入的requires_grad参数是True,代表需要计算梯度。

requires_grad的计算代码为is_grad_enable() and x.requires_grad,is_grad_enable()已经被train设置为True,而x是卷积核,它的requires_grad也是True。

class Tensor: def __init__( self, data: Any, dtype=None, device: Union[Device, int, str, None] = None, requires_grad: bool = False, ) -> None: if self.requires_grad: # 不需要求梯度的节点不出现在动态计算图中 Graph.add_node(self)

最终在Tensor类的初始化方法中,调用Graph.add_node(self)将当前tensor加入到计算图中。

同理,下面使用requires_grad=True的tensor常见出来的新tensor都会放到计算图中。

经过一次卷积操作,计算图中会增加 6 个节点。

4. 反向传播

一次前向传播完成后,从计算图中最后一个节点开始,从后往前进行反向传播。

l = loss(y_hat, y) l.backward()

经过前向网络一层层传播,最终传到了损失张量l。

以l为起点,从前向后传播,就可计算计算图中每个节点的梯度。

backward的核心代码如下:

def backward(self, retain_graph: bool = False): for node in Graph.node_list[y_id::-1]: grad = node.grad for last in [l for l in node.last if l.requires_grad]: add_grad = node.grad_fn(last, grad) last.grad += add_grad

Graph.node_list[y_id::-1]将计算图倒序排。

node是前向传播时放入计算图中的每个tensor。

node.last 是生成当前tensor的直接父节点。

调用node.grad_fn计算梯度,并反向传给它的父节点。

grad_fn其实就是Tensor的求导公式,如:

class pow(BinaryOperator): ''' 幂运算算子,在Tensor类中进行重载 See also -------- add : 加法算子 ''' def grad_fn(self, node: Tensor, grad: np.ndarray) if node is self.last[0]: return (self.data * self.last[1].data / node.data) * grad

return后的代码其实就是幂函数求导公式。

假设y=x^2,x的导数为2x。

5. 更新参数

反向传播计算梯度后,便可以调用优化器,更新模型参数。

l.backward() optimizer.step()

本次训练我们用梯度下降SGD算法优化参数,更新过程如下:

def step(self): for i in range(len(self.params)): grad = self.params[i].grad + self.weight_decay * self.params[i].data self.v[i] *= self.momentum self.v[i] += self.lr * grad self.params[i].data -= self.v[i] if self.nesterov: self.params[i].data -= self.lr * grad

self.params是整个网络的权重,初始化SGD时传进去的。

step函数最核心的两行代码,self.v[i] += self.lr * grad 和 self.params[i].data -= self.v[i],用当前参数 - 学习速率 * 梯度更新当前参数。

这是机器学习的基础内容了,我们应该很熟悉了。

一次模型训练的完整过程大致就串完了,大家可以设置打印语句,或者通过DEBUG的方式跟踪每一行代码的执行过程,这样可以更了解模型的训练过程。

以上是逆天了!用Numpy开发深度学习框架,透视神经网络训练过程的详细内容。更多信息请关注PHP中文网其他相关文章!

Gemma范围:Google'用于凝视AI的显微镜Apr 17, 2025 am 11:55 AM

Gemma范围:Google'用于凝视AI的显微镜Apr 17, 2025 am 11:55 AM使用Gemma范围探索语言模型的内部工作 了解AI语言模型的复杂性是一个重大挑战。 Google发布的Gemma Scope是一种综合工具包,为研究人员提供了一种强大的探索方式

谁是商业智能分析师以及如何成为一位?Apr 17, 2025 am 11:44 AM

谁是商业智能分析师以及如何成为一位?Apr 17, 2025 am 11:44 AM解锁业务成功:成为商业智能分析师的指南 想象一下,将原始数据转换为驱动组织增长的可行见解。 这是商业智能(BI)分析师的力量 - 在GU中的关键作用

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AMSQL的Alter表语句:动态地将列添加到数据库 在数据管理中,SQL的适应性至关重要。 需要即时调整数据库结构吗? Alter表语句是您的解决方案。本指南的详细信息添加了Colu

业务分析师与数据分析师Apr 17, 2025 am 11:38 AM

业务分析师与数据分析师Apr 17, 2025 am 11:38 AM介绍 想象一个繁华的办公室,两名专业人员在一个关键项目中合作。 业务分析师专注于公司的目标,确定改进领域,并确保与市场趋势保持战略一致。 simu

什么是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AM

什么是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AMExcel 数据计数与分析:COUNT 和 COUNTA 函数详解 精确的数据计数和分析在 Excel 中至关重要,尤其是在处理大型数据集时。Excel 提供了多种函数来实现此目的,其中 COUNT 和 COUNTA 函数是用于在不同条件下统计单元格数量的关键工具。虽然这两个函数都用于计数单元格,但它们的设计目标却针对不同的数据类型。让我们深入了解 COUNT 和 COUNTA 函数的具体细节,突出它们独特的特性和区别,并学习如何在数据分析中应用它们。 要点概述 理解 COUNT 和 COU

Chrome在这里与AI:每天都有新事物!Apr 17, 2025 am 11:29 AM

Chrome在这里与AI:每天都有新事物!Apr 17, 2025 am 11:29 AMGoogle Chrome的AI Revolution:个性化和高效的浏览体验 人工智能(AI)正在迅速改变我们的日常生活,而Google Chrome正在领导网络浏览领域的负责人。 本文探讨了兴奋

AI的人类方面:福祉和四人底线Apr 17, 2025 am 11:28 AM

AI的人类方面:福祉和四人底线Apr 17, 2025 am 11:28 AM重新构想影响:四倍的底线 长期以来,对话一直以狭义的AI影响来控制,主要集中在利润的最低点上。但是,更全面的方法认识到BU的相互联系

您应该知道的5个改变游戏规则的量子计算用例Apr 17, 2025 am 11:24 AM

您应该知道的5个改变游戏规则的量子计算用例Apr 17, 2025 am 11:24 AM事情正稳步发展。投资投入量子服务提供商和初创企业表明,行业了解其意义。而且,越来越多的现实用例正在出现以证明其价值超出

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

EditPlus 中文破解版

体积小,语法高亮,不支持代码提示功能

WebStorm Mac版

好用的JavaScript开发工具

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

禅工作室 13.0.1

功能强大的PHP集成开发环境