欧洲人工智能法案即将出台,或影响全球科技监管

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB转载

- 2023-04-11 22:40:141374浏览

人工智能法案旨在为人工智能的使用创建一个共同的监管和法律框架,包括它是如何开发的,公司可以使用它做什么,以及不遵守要求的法律后果。该法案可能会要求公司采用人工智能前,在某些情况下需要获得批准;并将某些被认为风险太大的人工智能用途定为非法,并创建一个其他高风险人工智能用途的公开清单。

欧盟委员会(European Commission)在一份有关该法律的官方报告中表示,在广泛的层面上,该法律寻求将欧盟值得信赖的人工智能范式法制化。这一范式“要求人工智能在法律、伦理和技术上强大,同时尊重民主价值观、人权和法治”。

拟议的人工智能监管框架具有以下目标:

1.确保在欧盟市场上部署和使用的人工智能系统是安全的,并尊重现有法律基本权利和欧盟价值观;

2.确保法律确定性,以促进人工智能的投资和创新;

3.加强治理和有效执行有关基本权利和安全的现行法律适用于AI系统;

4.促进合法、安全和值得信赖的人工智能应用的统一市场的发展,防止市场的分化。

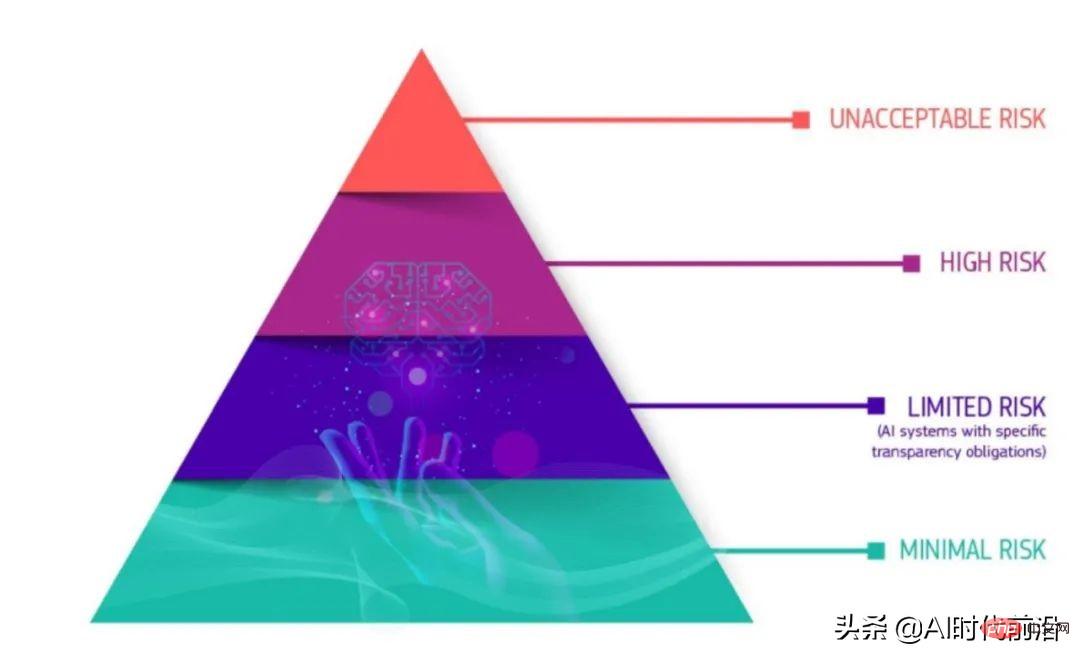

虽然新法律的许多细节仍悬而未决,关键是人工智能的定义,但核心因素似乎是它的“产品安全框架”,它将未来的人工智能产品分为四个安全水平类别,适用于所有行业。

根据斯坦福-维也纳跨大西洋技术法律论坛的Maruritz Kop汇编的2021年欧盟委员会关于新法律的报告,“临界金字塔”的底部是风险最小的系统。属于这一类的人工智能应用不需要遵守风险较高的系统必须通过的透明度要求。在“有限风险”类别中,则对人工智能系统有一些透明度要求,比如聊天机器人。

——欧盟新的AI法案将AI程序分为四类,自下而上分别为:低风险、有限风险、高风险和不可接受风险。

在对透明度有严格要求的高风险AI类别中,监管会更加严苛。根据介绍,高风险类别包括AI应用在:

- 关键基础设施,如交通,可能危及人的生命或健康(如自动驾驶汽车);

- 影响个人教育或职业成就的教育或职业培训(如考试成绩);

- 产品的安全组件(如机器人辅助手术);

- 就业、员工管理、自主创业(如简历、简历分类软件);

- 基本的私人和公共服务(如信用评分);

- 执法用例(如证据评估);

- 移民、边防管理(包括护照真实性评估);

- 公正和民主程序(如将法律适用于一组具体事实);

- 监控系统(如生物特征监测和面部识别)。

塔尖的第四类是“不可接受风险”的人工智能系统。这些应用基本上是非法的,因为它们带来了太多的风险。这类应用的例子包括操纵行为或人或“特定弱势群体”的系统,社会评分,以及实时和远程生物识别系统。

高风险类别可能是许多公司将努力确保透明度和合规的重点。欧盟的人工智能法案将建议企业在推出属于高风险类别的人工智能产品或服务之前采取四个步骤。

- 开发高风险人工智能系统,最好内部首先使用人工智能影响评估和由包容、多学科团队监督的行为准则。

- 高风险人工智能系统必须经过合格评定和批准,并持续进行在其生命周期内遵守欧盟AI法案规定要求。某些系统外机构将参与合格评定审核。这个动态的过程确保基准测试、监控和验证。此外,高危AI的动态系统,步骤2必须重复执行。

- 独立高风险人工智能系统的注册将在一个专用的欧盟数据库中进行。

- 必须签署合格声明,高风险AI系统必须带有CE标记。

以上是欧洲人工智能法案即将出台,或影响全球科技监管的详细内容。更多信息请关注PHP中文网其他相关文章!