马库斯发文炮轰LeCun:只靠深度学习无法实现类人智能

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB转载

- 2023-04-09 23:01:141089浏览

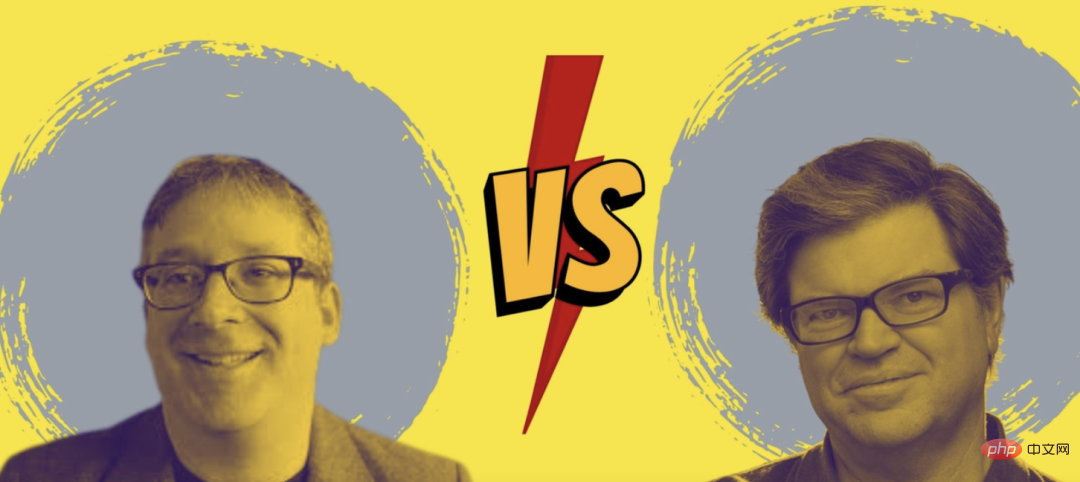

今年3月,Gary Marcus(加里·马库斯)提出「深度学习撞墙」这个观点后,在人工智能学界激起千层浪。

当时,就连深度学习三巨头都坐不住了,先是Geoffrey Hinton在一期播客中驳斥了这个观点。

紧接着6月,Yann LeCun撰写了一篇文章对此作出了回应,并指出别把一时困难当撞墙。

现在,马库斯在美国NOEMA杂志发表了一篇题为「Deep Learning Alone Isn’t Getting Us To Human-Like AI」的文章。

同样,他依旧没有改变自己的观点——仅靠深度学习并不能实现类人智能。

并提出,当前人工智能主要集中在深度学习上的研究,是时候该重新考虑一下了。

近70年来,人工智能领域中最根本的争论就是:人工智能系统是否应该建立在「符号操作」上 ,还是应该建立在类脑的「神经网络」系统之上。

其实,这里还有第三种可能性:混合模型 ——将神经网络的深度学习与符号操作的强大抽象能力相结合。

LeCun近期在NOEMA杂志发表的文章「What AI Can Tell Us About Intelligence」同样探讨了这个问题,但是马库斯指出他的文章看似清晰,但又有明显缺陷,即前后逻辑矛盾。

这篇文章开头,他们拒绝混合模型,但文章最后又承认混合模型的存在,并提到它是一种可能的前进方式。

神经网络和符号操作的混合模型

马库斯指出,LeCun和Browning的观点主要是「如果一个模型学会了符号操作,它就不是混合的」。

但机器学习的问题是一个发展的问题(系统是如何产生的?)

而系统一旦发展起来如何运作是一个计算问题(例如,它使用一种机制还是两种机制?),即「任何利用了符号和神经网络两者的系统都是混合模型」。

也许他们真正想说的是,人工智能很可能是一种学习的混合体,而不是天生的混合体。但学习的混合体仍然是混合体。

而马库斯的观点是,「符号操作本身就是与生俱来的,或者有另外一种东西是与生俱来的,这种东西间接促成了符号操作的产生」。

所以我们的研究重心应当放在如何发现这个间接促成符号操作的介质上。

即提出了假设,只要我们能弄清楚是什么介质让系统达到可以学习符号抽象的程度,我们就能构建利用世界上所有知识的系统。

接下来,马库斯引经据典,梳理了人工智能领域关于符号操作和神经网络辩论的历史。

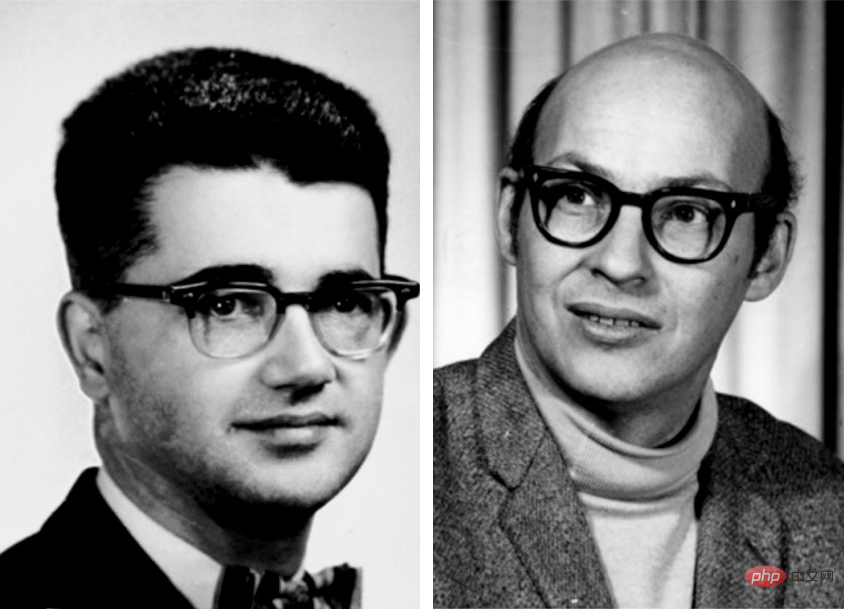

早期的人工智能先驱如Marvin Minsky、John McCarthy认为符号操作是唯一合理的前进方式。

而神经网络先驱Frank Rosenblatt则认为,AI建立在神经节点叠加并处理数字输入的结构上表现可能会更好。

事实上,这两种可能性并不相互排斥。

AI所使用的神经网络并不是字面上的生物神经元网络,相反,它是一个简化的数字模型,它具备一些人类大脑的特性,但复杂性很小。

原则上,这些抽象符号可以以许多不同的方式连接起来,其中一些可以直接实现逻辑和符号操作。

Warren S. McCulloch 和 Walter Pitts在1943年发表的A Logical Calculus of the Ideas Inmanent in Nervous Activity,明确承认了这种可能性。

其他人包括1950 年代的 Frank Rosenblatt 和 1980 年代的 David Rumelhart 和 Jay McClelland,提出了神经网络作为符号操作的替代方案。Geoffrey Hinton 也普遍支持这一立场。

然后马库斯又接连把LeCun、Hinton和Yoshua Bengio等图灵奖获得者cue了个遍。

意思是光我说了不算,其他大佬都这么说的!

时间来到2015年,LeCun、Bengio和Hinton在Nature上写了一篇关于深度学习的宣言式论文。

这篇文章以对符号的攻击结束,认为「需要新的范式来通过对大向量的操作来取代基于规则的符号表达式操作」。

事实上,Hinton 非常确信符号是一条死胡同,同年他在斯坦福大学发表了一个名为「以太符号」的演讲——将符号比作科学史上最大的错误之一。

上世纪80年代,他的两位前合作者 Rumelhart 和 McClelland 也提出了类似的论点,他们在 1986 年的一本著名著作中辩称,符号不是「人类计算的本质」,引发了大辩论。

马库斯称,2018年他写了一篇文章为符号操作辩护时,LeCun不加解释地否定了他关于混合AI的论点,在 Twitter上将其斥为「大部分错误的观点」。

然后又说,两位著名的深度学习领域的大牛也表示支持混合 AI。

Andrew Ng在3月表示支持此类系统。Sepp Hochreiter——LSTMs 的共同创造者,领先的学习序列深度学习架构之一,也做了同样的事情,他在四月公开表示,最有希望的广泛人工智能方法是神经符号人工智能。

而在LeCun和Browning的新观点里,符号操作实际上是至关重要的,正如马库斯和Steven Pinker从1988年开始提出的观点。

马库斯也就由此指责Lecun,「你的观点我几十年前就提出了,你的研究倒退了几十年」。

而且不只是我一个人说的,其他大佬也这么认为。

LeCun 和 Browning 的其余文章大致可以分为三个部分:

1、对我的立场的错误描述2、努力缩小混合模型的范围3、符号操作可能是通过学习而不是与生俱来的原因。

接下来马库斯又针对LeCun论文中的观点进行反驳:

LeCun和Browning说,「Marcus说,如果你一开始没有符号操作,你就永远不会拥有它」。

而事实上我在2001年的《代数思维》一书中明确承认,我们不确定符号操作是否是与生俱来的。

他们批评我「深度学习无法取得进一步进展」的言论,而我的实际观点并不是DL在任何问题上都不会再有进展,而是深度学习本身对于组合性、推理等某些工作来说是错误的工具。

同样,他们污蔑我说系统中符号推理要么有要么没有(1或者0)。

这根本就是瞎说。

的确DALL-E不使用符号进行推理,但这并不意味着任何包含符号推理的系统都必须是有或者没有。

至少早在上世纪70年代的系统MYCIN中,就有纯粹的符号系统可以进行各种定量推理。

符号操作先天性

符号操作能力是否可以通过学习而不是从一开始就建立?

答案是肯定的。

马库斯称,之前的实验虽然不能保证符号操作的能力是与生俱来的,但几乎与这一观点别无二致。它们确实对任何依赖大量经验的学习理论构成了挑战。

并提出了以下2个主要的论点:

1、可学习性

在2001年出版的The Algebraic Mind一书中,马库斯展示了某些系统都能够学习符号操作。

一个系统,如果有一些内置的起点,将比一块纯粹的白板更能有效地了解这个世界。

事实上,就连LeCun自己最著名的工作——On Convolutional Neural Networks ——就是一个很好的例证:对神经网络学习方式的内置约束,从而大大提高了效率。很好地集成符号操作后,可能会带来更大的收益。

2、人类婴儿表现出一些符号操作的能力

在一系列经常被引用的规则学习实验中,婴儿们将抽象模式推广到了他们所接受过训练的具体例子之外。随后对人类婴儿内隐逻辑推理能力的研究更加证明了这一点。

另外,研究表明,比如蜜蜂可以以将太阳方位角函数推广到它们从未见过的光照条件下。

在LeCun看来,学习符号等同于晚年获得的东西,是因为年轻时候需要更精确、更专业的技能。

而令人费解的是,在反对符号操作的先天性后,LeCun并没有给出强有力的证据,证明符号操作是后天习得的。

如果一只小山羊在出生后不久就可以爬下山坡,为什么新生的神经网络不能开箱即用地结合一点符号操作呢?

同时,LeCun和Browning没有具体说明,缺乏符号操作的内在机制,如何解决语言理解和推理中众所周知的特定问题?

他们只是给出一个微弱的归纳:由于深度学习已经克服了从1到N的问题,我们应该对它能克服N+1问题有信心。

人们应该怀疑深度学习是否已经达到了极限。鉴于最近在DALL-E 2、Gato和PaLM中看到的任务持续增量改进,不要将一时困难误认为是「墙」似乎是明智的。深度学习不可避免的失败之前已经被预言过,但押注它是不值得的。

乐观是一方面,但要看清现实。

深度学习原则上面临着一些特定的挑战,主要在组合性、系统性和语言理解方面,所有这些围绕着一般化和「分布迁移」。

现在,每个人都认识到分布迁移是当前神经网络的致命弱点。当然,深度学习已经取得了进展,但是在这些基础问题上,进展并不大。

在马库斯看来,符号操作可能具有先天性的情况与以往的情况大致相同:

1、当前的系统,在「代数思维」出现的20年后,即使面对海量的数据集和训练,仍然无法可靠地提取符号运算(例如乘法)。

2、人类婴儿的例子表明,在接受正规教育之前,他们有能力概括自然语言和推理的复杂方面。3、一点内在的象征意义可以大大提高学习效率。AlphaFold 2的强大功能部分来自于精心构建的分子生物学与生俱来的表征。

简言之,世界可能大致分为三个垃圾箱:

一是在工厂完全安装了符号操作设备的系统。

二是具有先天的学习装置系统缺乏符号操作,但是在正确的数据和训练环境下,有足够的能力获得它。

三是即使有足够的训练,也无法获得完整的符号操作机制的系统。

当前的深度学习系统似乎属于第三类:一开始没有符号操作机制,并且在此过程中没有可靠的符号操作机制。

当前,了解符号操作的来源是我们的首要任务。即便是神经网络最狂热的支持者现在也认识到符号操作对于实现AI的重要性。

而这正是神经符号学界一直关注的问题: :如何让数据驱动的学习和符号表示在一个单一的、更强大的智能中协调一致地工作?

以上是马库斯发文炮轰LeCun:只靠深度学习无法实现类人智能的详细内容。更多信息请关注PHP中文网其他相关文章!