arXiv论文“ST-P3: End-to-end Vision-based Autonomous Driving via Spatial-Temporal Feature Learning“,22年7月,作者来自上海交大、上海AI实验室、加州圣地亚哥分校和京东公司的北京研究院。

提出一种时空特征学习方案,可以同时为感知、预测和规划任务提供一组更具代表性的特征,称为ST-P3。具体而言,提出一种以自车为中心对齐(egocentric-aligned)的累积技术,在感知BEV转换之前保留3-D空间中的几何信息;作者设计一种双路(dual pathway )模型,将过去的运动变化考虑在内,用于未来的预测;引入一个基于时域的细化单元,补偿为规划的基于视觉元素识别。源代码、模型和协议详细信息开源https://github.com/OpenPerceptionX/ST-P3.

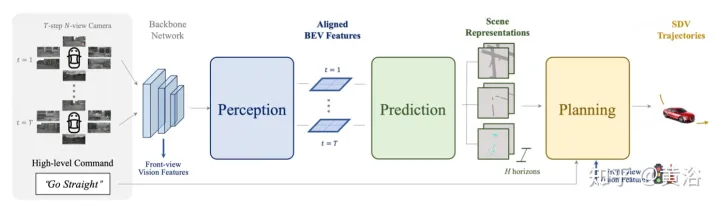

开创性的LSS方法从多视图摄像机中提取透视特征,通过深度估计将其提升到3D,并融合到BEV空间。两个视图之间的特征转换,其潜深度预测至关重要。

将二维平面信息提升到三维需要附加维度,即适合三维几何自主驾驶任务的深度。为了进一步改进特征表示,自然要将时域信息合并到框架中,因为大多数场景的任务是视频源。

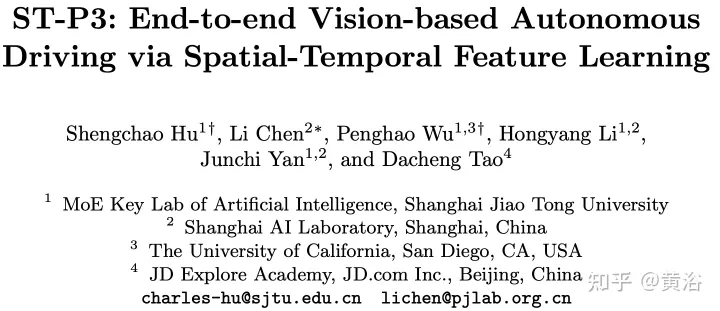

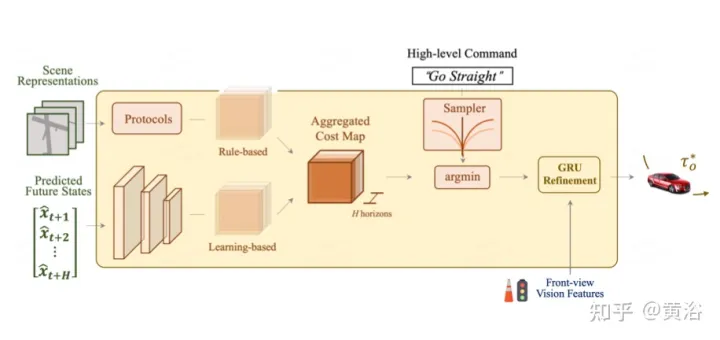

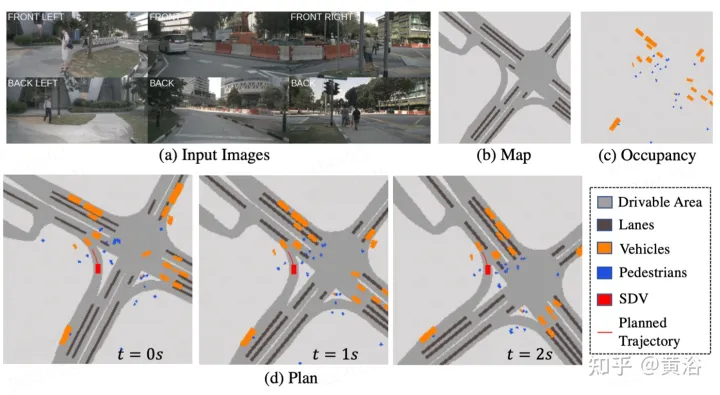

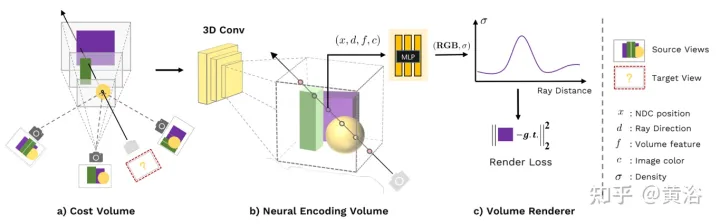

如图描述ST- P3总体框架:具体来说,给定一组周围的摄像机视频,将其输入主干生成初步的前视图特征。执行辅助深度估计将2D特征转换到3D空间。以自车为中心对齐累积方案,首先将过去的特征对齐到当前视图坐标系。然后在三维空间中聚合当前和过去的特征,在转换到BEV表示之前保留几何信息。除了常用的预测时域模型外,通过构建第二条路径来解释过去的运动变化,性能得到进一步提升。这种双路径建模确保了更强的特征表示,推断未来的语义结果。为了实现轨迹规划的最终目标,整合网络早期的特征先验知识。设计了一个细化模块,在不存在高清地图的情况下,借助高级命令生成最终轨迹。

如图是感知的以自我为中心对齐累计方法。(a) 利用深度估计将当前时间戳处的特征提升到3D,并在对齐后合并到BEV特征;(b-c)将先前帧的3D特征与当前帧视图对齐,并与所有过去和当前状态融合,从而增强特征表示。

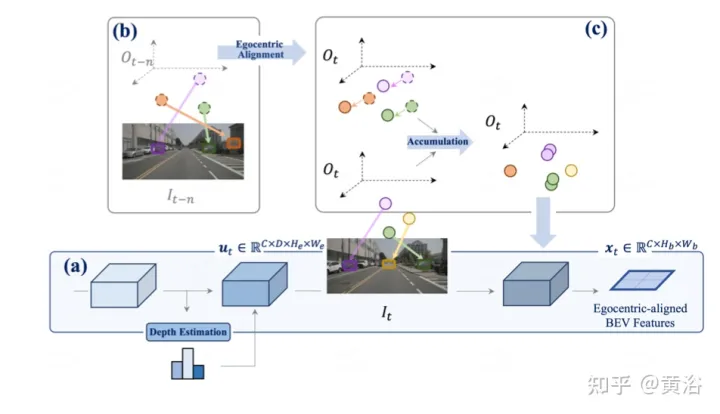

如图是用于预测的双路模型:(i) 潜码是来自特征图的分布;(ii iii)路a结合了不确定性分布,指示未来的多模态,而路b从过去的变化中学习,有助于路a的信息进行补偿。

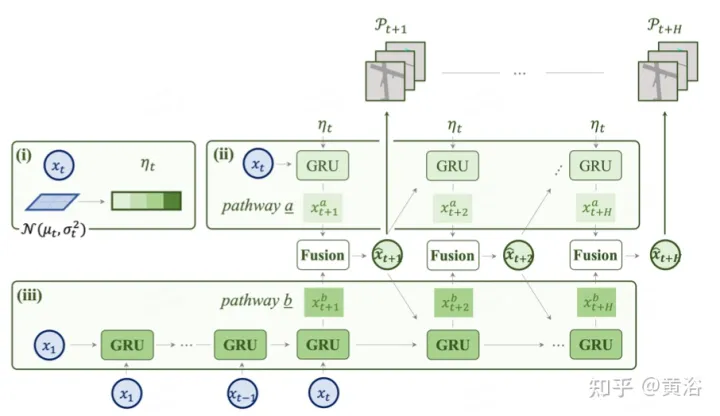

作为最终目标,需要规划一条安全舒适的轨迹,到达目标点。这个运动规划器对一组不同的轨迹进行采样,并选择一个最小化学习成本函数的轨迹。然而,通过一个时域模型来整合目标(target)点和交通灯的信息,加上额外的优化步骤。

如图是为规划的先验知识集成和细化:总体成本图包括两个子成本。使用前视特征进一步重新定义最小成本轨迹,从摄像机输入中聚合基于视觉的信息。

惩罚具有较大横向加速度、急动或曲率的轨迹。希望这条轨迹能够有效地到达目的地,因此向前推进的轨迹将奖励。然而,上述成本项不包含通常由路线地图提供的目标(target)信息。采用高级命令,包括前进、左转和右转,并且只根据相应的命令评估轨迹。

此外,交通信号灯对SDV至关重要,通过GRU网络优化轨迹。用编码器模块的前摄像头特征初始化隐藏状态,并用成本项的每个采样点作为输入。

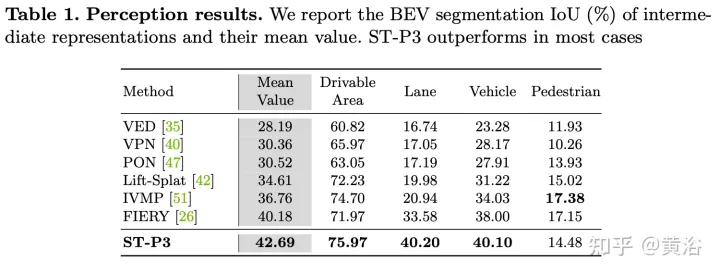

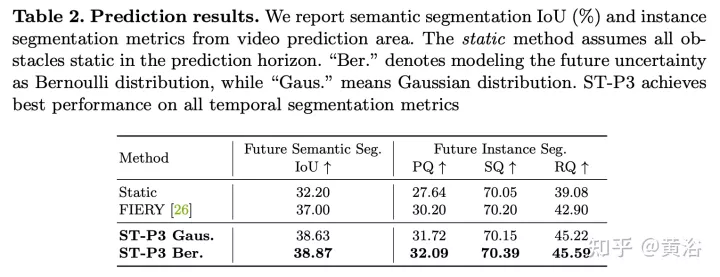

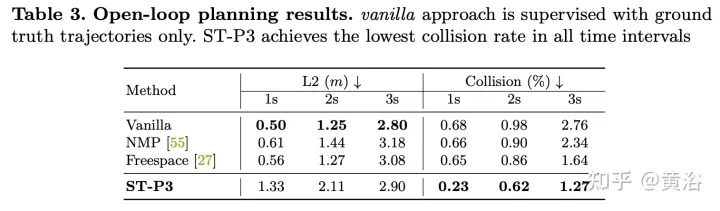

实验结果如下:

以上是ST-P3:端到端时空特征学习的自动驾驶视觉方法的详细内容。更多信息请关注PHP中文网其他相关文章!

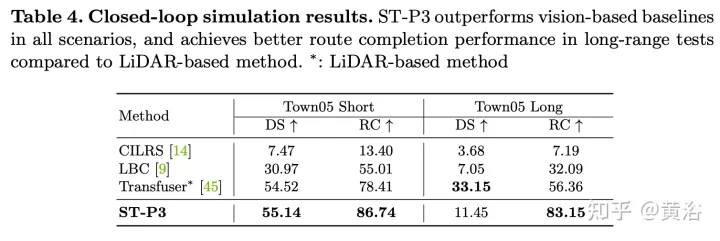

SOA中的软件架构设计及软硬件解耦方法论Apr 08, 2023 pm 11:21 PM

SOA中的软件架构设计及软硬件解耦方法论Apr 08, 2023 pm 11:21 PM对于下一代集中式电子电器架构而言,采用central+zonal 中央计算单元与区域控制器布局已经成为各主机厂或者tier1玩家的必争选项,关于中央计算单元的架构方式,有三种方式:分离SOC、硬件隔离、软件虚拟化。集中式中央计算单元将整合自动驾驶,智能座舱和车辆控制三大域的核心业务功能,标准化的区域控制器主要有三个职责:电力分配、数据服务、区域网关。因此,中央计算单元将会集成一个高吞吐量的以太网交换机。随着整车集成化的程度越来越高,越来越多ECU的功能将会慢慢的被吸收到区域控制器当中。而平台化

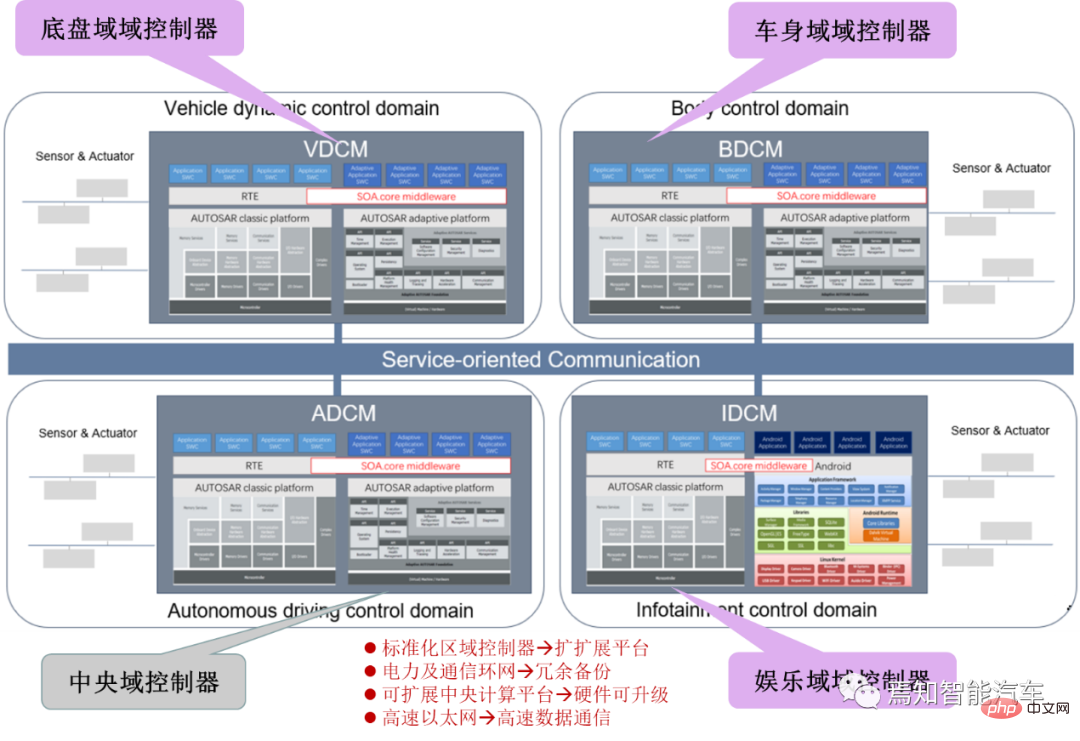

新视角图像生成:讨论基于NeRF的泛化方法Apr 09, 2023 pm 05:31 PM

新视角图像生成:讨论基于NeRF的泛化方法Apr 09, 2023 pm 05:31 PM新视角图像生成(NVS)是计算机视觉的一个应用领域,在1998年SuperBowl的比赛,CMU的RI曾展示过给定多摄像头立体视觉(MVS)的NVS,当时这个技术曾转让给美国一家体育电视台,但最终没有商业化;英国BBC广播公司为此做过研发投入,但是没有真正产品化。在基于图像渲染(IBR)领域,NVS应用有一个分支,即基于深度图像的渲染(DBIR)。另外,在2010年曾很火的3D TV,也是需要从单目视频中得到双目立体,但是由于技术的不成熟,最终没有流行起来。当时基于机器学习的方法已经开始研究,比

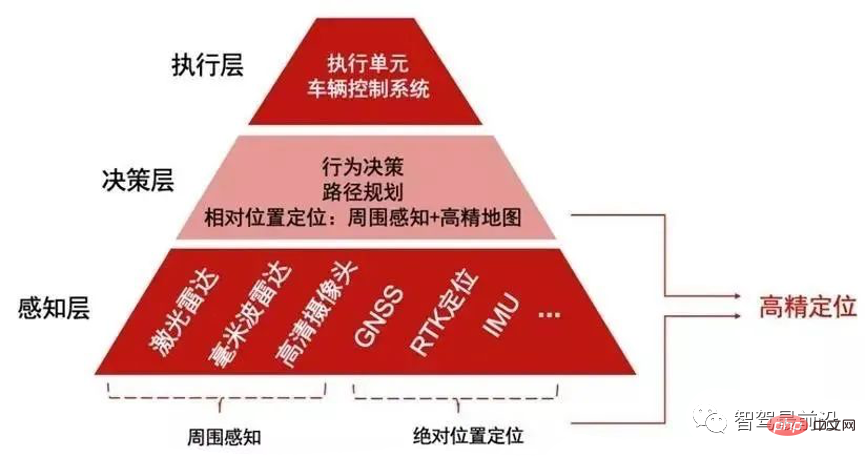

如何让自动驾驶汽车“认得路”Apr 09, 2023 pm 01:41 PM

如何让自动驾驶汽车“认得路”Apr 09, 2023 pm 01:41 PM与人类行走一样,自动驾驶汽车想要完成出行过程也需要有独立思考,可以对交通环境进行判断、决策的能力。随着高级辅助驾驶系统技术的提升,驾驶员驾驶汽车的安全性不断提高,驾驶员参与驾驶决策的程度也逐渐降低,自动驾驶离我们越来越近。自动驾驶汽车又称为无人驾驶车,其本质就是高智能机器人,可以仅需要驾驶员辅助或完全不需要驾驶员操作即可完成出行行为的高智能机器人。自动驾驶主要通过感知层、决策层及执行层来实现,作为自动化载具,自动驾驶汽车可以通过加装的雷达(毫米波雷达、激光雷达)、车载摄像头、全球导航卫星系统(G

多无人机协同3D打印盖房子,研究登上Nature封面Apr 09, 2023 am 11:51 AM

多无人机协同3D打印盖房子,研究登上Nature封面Apr 09, 2023 am 11:51 AM我们经常可以看到蜜蜂、蚂蚁等各种动物忙碌地筑巢。经过自然选择,它们的工作效率高到叹为观止这些动物的分工合作能力已经「传给」了无人机,来自英国帝国理工学院的一项研究向我们展示了未来的方向,就像这样:无人机 3D 打灰:本周三,这一研究成果登上了《自然》封面。论文地址:https://www.nature.com/articles/s41586-022-04988-4为了展示无人机的能力,研究人员使用泡沫和一种特殊的轻质水泥材料,建造了高度从 0.18 米到 2.05 米不等的结构。与预想的原始蓝图

超逼真渲染!虚幻引擎技术大牛解读全局光照系统LumenApr 08, 2023 pm 10:21 PM

超逼真渲染!虚幻引擎技术大牛解读全局光照系统LumenApr 08, 2023 pm 10:21 PM实时全局光照(Real-time GI)一直是计算机图形学的圣杯。多年来,业界也提出多种方法来解决这个问题。常用的方法包通过利用某些假设来约束问题域,比如静态几何,粗糙的场景表示或者追踪粗糙探针,以及在两者之间插值照明。在虚幻引擎中,全局光照和反射系统Lumen这一技术便是由Krzysztof Narkowicz和Daniel Wright一起创立的。目标是构建一个与前人不同的方案,能够实现统一照明,以及类似烘烤一样的照明质量。近期,在SIGGRAPH 2022上,Krzysztof Narko

internet的基本结构与技术起源于什么Dec 15, 2020 pm 04:48 PM

internet的基本结构与技术起源于什么Dec 15, 2020 pm 04:48 PMinternet的基本结构与技术起源于ARPANET。ARPANET是计算机网络技术发展中的一个里程碑,它的研究成果对促进网络技术的发展起到了重要的作用,并未internet的形成奠定了基础。arpanet(阿帕网)为美国国防部高级研究计划署开发的世界上第一个运营的封包交换网络,它是全球互联网的始祖。

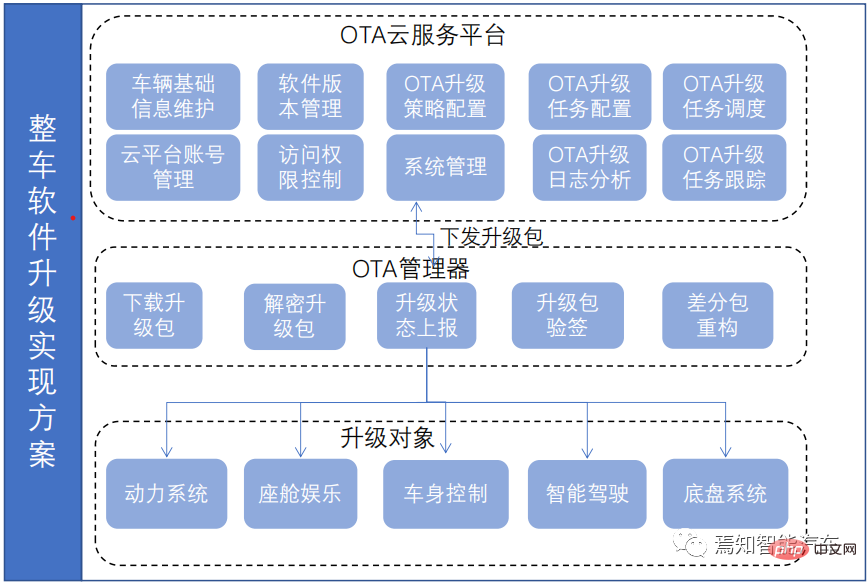

一文聊聊智能驾驶系统与软件升级的关联设计方案Apr 11, 2023 pm 07:49 PM

一文聊聊智能驾驶系统与软件升级的关联设计方案Apr 11, 2023 pm 07:49 PM由于智能汽车集中化趋势,导致在网络连接上已经由传统的低带宽Can网络升级转换到高带宽以太网网络为主的升级过程。为了提升车辆升级能力,基于为车主提供持续且优质的体验和服务,需要在现有系统基础(由原始只对车机上传统的 ECU 进行升级,转换到实现以太网增量升级的过程)之上开发一套可兼容现有 OTA 系统的全新 OTA 服务系统,实现对整车软件、固件、服务的 OTA 升级能力,从而最终提升用户的使用体验和服务体验。软件升级触及的两大领域-FOTA/SOTA整车软件升级是通过OTA技术,是对车载娱乐、导

综述:自动驾驶的协同感知技术Apr 08, 2023 pm 03:01 PM

综述:自动驾驶的协同感知技术Apr 08, 2023 pm 03:01 PMarXiv综述论文“Collaborative Perception for Autonomous Driving: Current Status and Future Trend“,2022年8月23日,上海交大。感知是自主驾驶系统的关键模块之一,然而单车的有限能力造成感知性能提高的瓶颈。为了突破单个感知的限制,提出协同感知,使车辆能够共享信息,感知视线之外和视野以外的环境。本文回顾了很有前途的协同感知技术相关工作,包括基本概念、协同模式以及关键要素和应用。最后,讨论该研究领域的开放挑战和问题

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Dreamweaver Mac版

视觉化网页开发工具

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

Dreamweaver CS6

视觉化网页开发工具

EditPlus 中文破解版

体积小,语法高亮,不支持代码提示功能

SublimeText3 Linux新版

SublimeText3 Linux最新版