今年英语高考,CMU用重构预训练交出134高分,大幅超越GPT3

- PHPz转载

- 2023-04-09 10:21:051779浏览

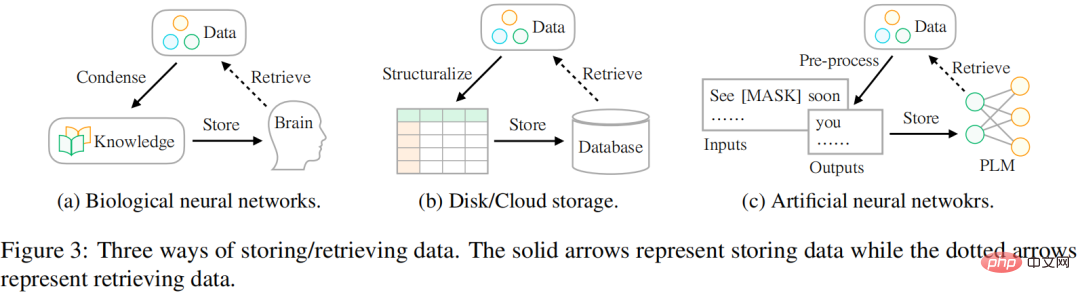

我们存储数据的方式正在发生变化,从生物神经网络到人工神经网络,其实最常见的情况是使用大脑来存储数据。随着当今可用数据的不断增长,人们寻求用不同的外部设备存储数据,如硬盘驱动器或云存储。随着深度学习技术的兴起,另一种有前景的存储技术已经出现,它使用人工神经网络来存储数据中的信息。

研究者认为,数据存储的最终目标是更好地服务于人类生活,数据的访问方式和存储方式同样重要。然而,存储和访问数据的方式存在差异。历史上,人们一直在努力弥补这一差距,以便更好地利用世界上存在的信息。如图 3 所示:

- 在生物神经网络(如人脑)方面,人类在很小的时候就接受了课程(即知识)教育,以便他们能够提取特定的数据来应对复杂多变的生活。

- 对于外部设备存储,人们通常按照某种模式(例如表格)对数据进行结构化,然后采用专门的语言(例如 SQL)从数据库中有效地检索所需的信息。

- 对于基于人工神经网络的存储,研究人员利用自监督学习存储来自大型语料库的数据(即预训练),然后将该网络用于各种下游任务(例如情绪分类)。

来自 CMU 的研究者提出了一种访问包含各种类型信息数据的新方法,这些信息可以作为指导模型进行参数优化的预训练信号。该研究以信号为单位结构化地表示数据。这类似于使用数据库对数据进行存储的场景:首先将它们构造成表或 JSON 格式,这样就可以通过专门的语言 (如 SQL) 准确地检索所需的信息。

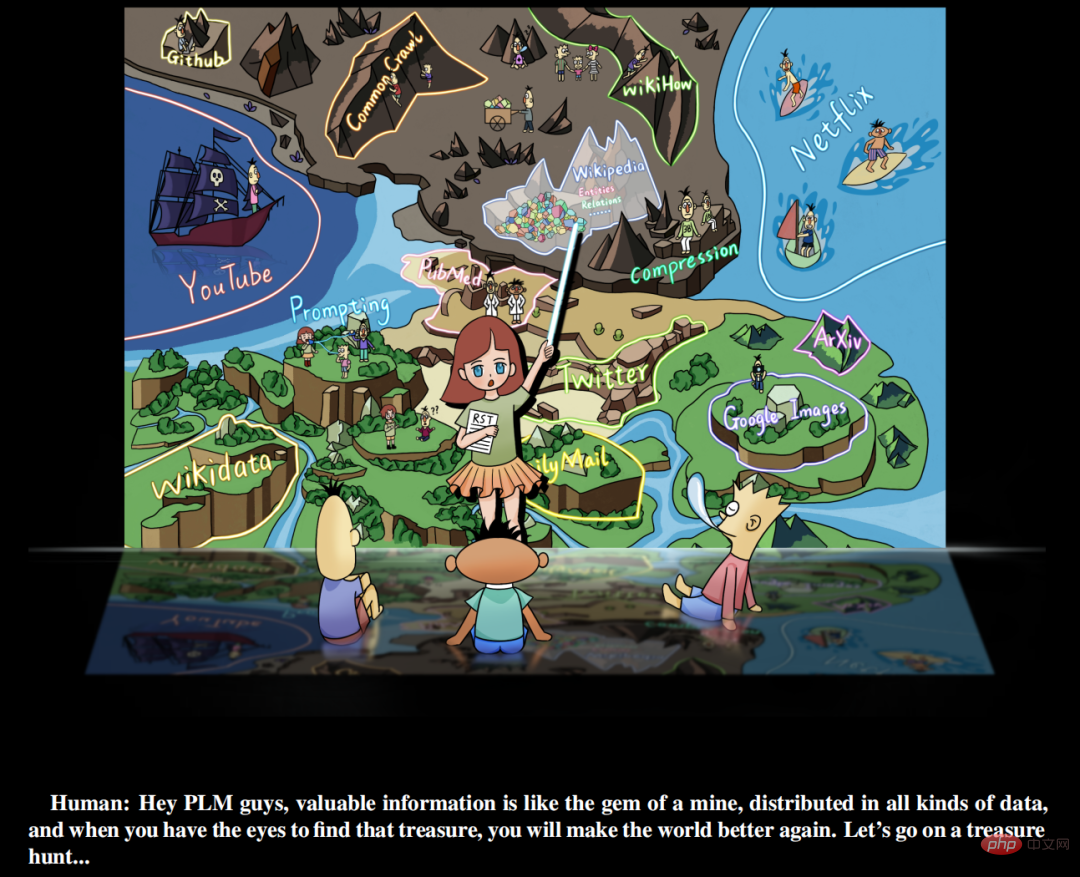

此外,该研究认为有价值的信号丰富地存在于世界各类的数据中,而不是简单地存在于人工管理的监督数据集中, 研究人员需要做的是 (a) 识别数据 (b) 用统一的语言重组数据(c)将它们集成并存储到预训练语言模型中。该研究称这种学习范式为重构预训练(reStructured Pre-training,RST)。研究者将这个过程比作「矿山寻宝」。不同的数据源如维基百科,相当于盛产宝石的矿山。它们包含丰富的信息,比如来自超链接的命名实体,可以为模型预训练提供信号。一个好的预训练模型 (PLM) 应该清楚地了解数据中各种信号的组成,以便根据下游任务的不同需求提供准确的信息。

论文地址:https://arxiv.org/pdf/2206.11147.pdf

预训练语言模型寻宝

该研究提出自然语言处理任务学习的新范式, 即 RST,该范式重新重视数据的作用,并将模型预训练和下游任务的微调视为数据的存储和访问过程。在此基础上,该研究实现了一个简单的原则,即良好的存储机制不仅应该具有缓存大量数据的能力,还应该考虑访问的方便性。

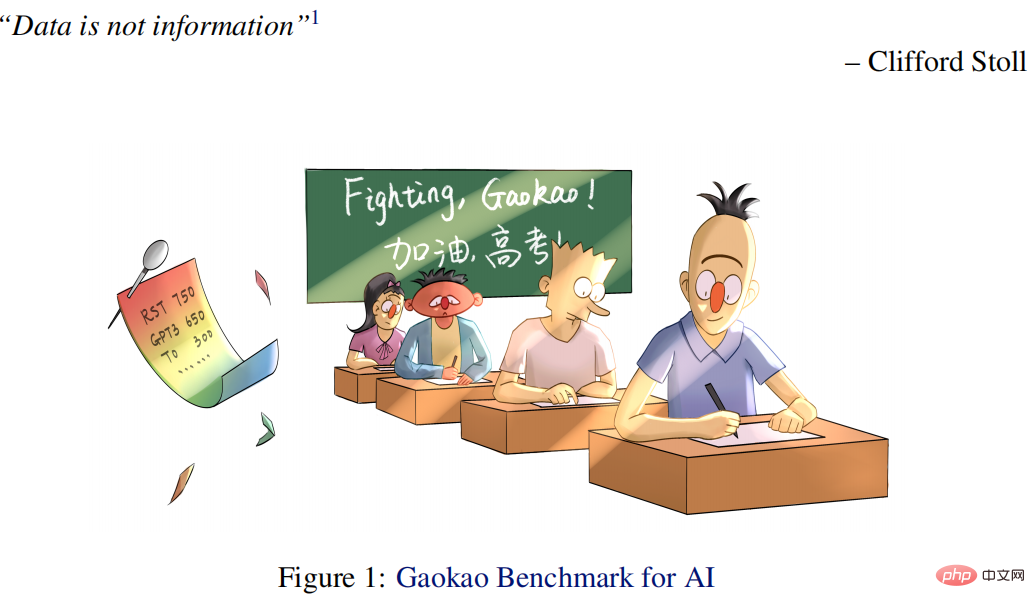

在克服了一些工程挑战后,该研究通过对重构数据(由各种有价值的信息而不是原始数据组成)进行预训练来实现这一点。实验证明,RST 模型不仅在来自各种 NLP 任务(例如分类、信息抽取、事实检索、文本生成等)的 52/55 流行数据集上表现大幅超过现有最好系统(例如,T0),而且无需对下游任务进行微调 。在每年有数百万学生参加的中国最权威的高考英语考试中也取得了优异的成绩。

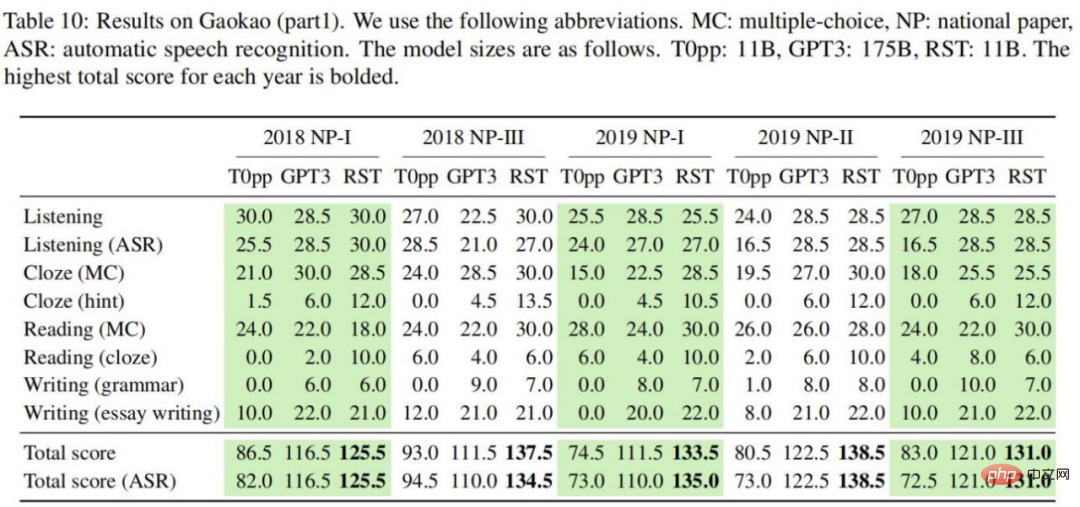

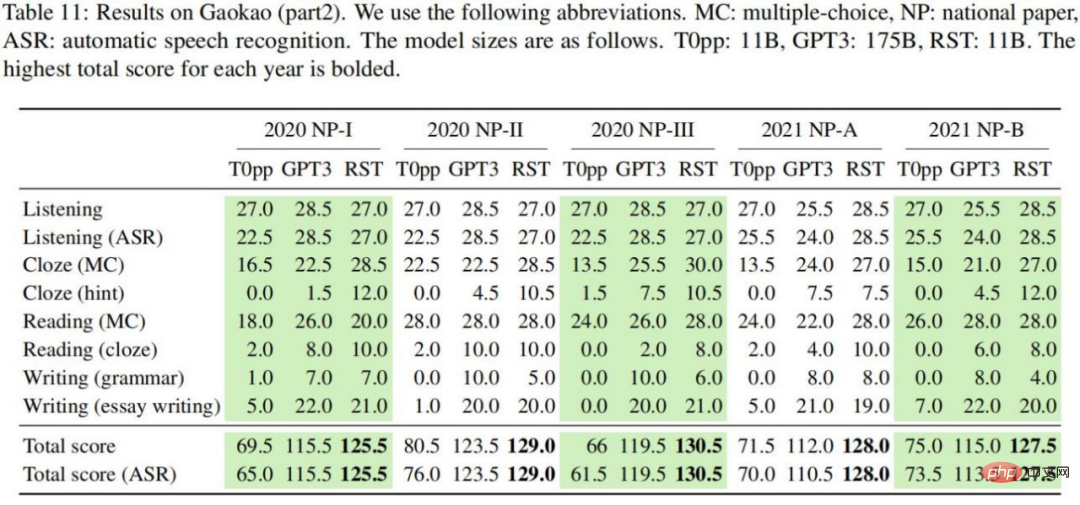

具体而言,本文所提出的高考 AI (Qin) 比学生的平均分数高出 40 分,比使用 1/16 参数的 GPT3 高出 15 分。特别的 Qin 在 2018 年英语考试中获得了 138.5 的高分(满分 150)。

此外,该研究还发布了高考基准(Gaokao Benchmark)在线提交平台,包含 2018-2021 年至今 10 篇带注释的英文试卷(并将每年进行扩展),让更多的 AI 模型参加高考,该研究还建立了一个相对公平的人类和 AI 竞争的测试平台,帮助我们更好地了解我们所处的位置。另外,在前几天(2022.06.08)的 2022 年高考英语测试中,该 AI 系统获得了 134 分的好成绩,而 GPT3 只获得了 108 分。

该研究的主要贡献包括:

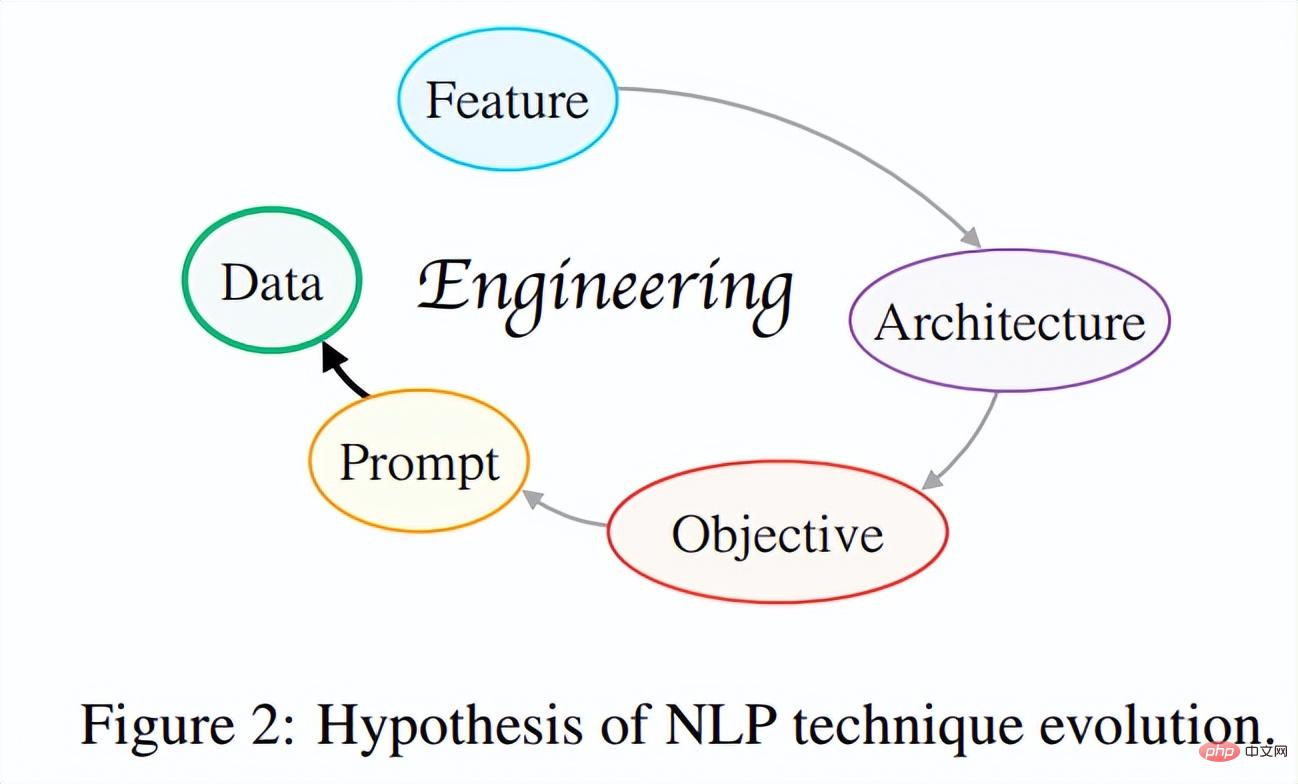

(1)提出 NLP 方法的演进假说。该研究试图通过探索现代 NLP 技术发展之间的内在联系,从全局的角度建立了「NLP 技术演进假说」。简而言之,该假说的核心思想是:技术的迭代总是沿着这样的方向发展:即开发者只需做更少的事情便可以来设计更好、更通用的系统。

到目前为止,NLP 技术演进已经经历了如图 2 所示的多次迭代:特征工程→架构工程→目标工程→prompt 工程,正在朝着更实际有效的以数据为中心的工程迈进。研究者希望未来能激发更多的科研人员批判性地思考这个问题,把握技术进步的核心驱动力,找到学术发展「梯度上升」路径,做更多有科学意义的工作。

(2)基于演进假说新范式:重构预训练(reStructured Pre-training)。该范式将模型预训练 / 微调视为数据存储 / 访问过程,并声称良好的存储机制应该使预期数据易于访问。有了这样一个新范式,该研究能够从 10 个数据源(例如 Wikipedia)中统一世界上 26 种不同类型的信号(例如句子的实体)。在此基础上训练的通用模型在各种任务上取得了很强的泛化能力,其中包括 55 个 NLP 的数据集。

(3)用于高考的 AI。基于上述范式,该研究开发了一个专门用于高考英语测试任务的 AI 系统——Qin。这是世界上第一个基于深度学习的高考英语人工智能系统。Qin 在多年的高考试题上都取得了卓越的成绩:比普通人高出 40 分,仅用 GPT-3 1/16 的参数量就获得了比 GPT-3 高 15 分的成绩。特别是在 2018 年英语试题上,QIN 获得了 138.5 分(满分 150 分)的高分,听力和阅读理解都满分。

(4) 丰富的资源。(1) 为了跟踪现有 AI 技术在实现人类智能方面的进展,该研究发布了一种新基准——Gaokao Benchmark。它不仅提供对现实世界场景中各种实际任务和领域的综合评估,还可以提供人类的表现成绩,以便人工智能系统可以直接与人类进行比较。(2)该研究使用 ExplainaBoard(Liu et al., 2021b)为 Gaokao Benchmark 设置了一个交互式排行榜,以便更多的 AI 系统可以轻松参加 Gaokao Benchmark 并自动获得分数。(3)所有资源都可以在 GitHub 上找到。

此外,AI 在高考英语测试任务上的成功为研究者提供了很多新的思考:AI 技术可以赋能教育,帮助解决教育和教学中的一系列问题。

例如,(a) 帮助教师自动评分,(b) 帮助学生回答有关作业的问题并详细解释,以及 (c) 更重要的是,促进教育公平,让大多数家庭都能获得同等质量的教育服务。这项工作首次以统一的方式整合了世界上 26 个不同的信号,而不是试图区分有监督和无监督的数据,而是关心我们可以多少使用大自然给我们的信息以及如何使用。来自各种 NLP 任务的 50 多个数据集的出色表现显示了以数据为中心的预训练的价值,并激发了更多的未来探索。

重构预训练

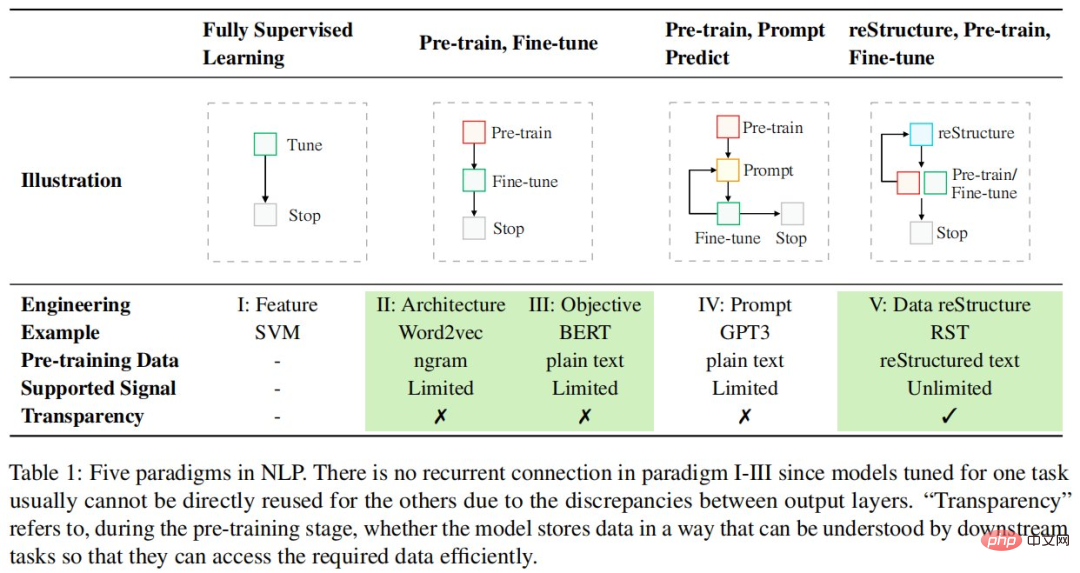

解决 NLP 任务的范式正在迅速变化,并且仍在持续,下表列出了 NLP 中的五种范式:

与现有的以模型为中心的设计范式不同,该研究更多地从数据的角度思考,以最大限度地利用已有数据。具体来说,该研究采用数据存储和访问视图,其中预训练阶段被视为数据存储过程,而基于预训练模型的下游任务(例如,情感分类)被视为来自预训练模型的数据访问过程,并声称良好的数据存储机制应该使存储的数据更易于访问。

为了实现这一目标,该研究将数据视为由不同信号组成的对象,并认为一个好的预训练模型应该(1)覆盖尽可能多的信号类型,(2)当下游任务需要时,为这些信号提供精确的访问机制。一般来说,这个新范式包含三个步骤:重构、预训练、微调。

重构、预训练、微调的新范式凸显了数据的重要性,研究人员需要在数据处理上投入更多的工程精力。

重构工程

信号定义

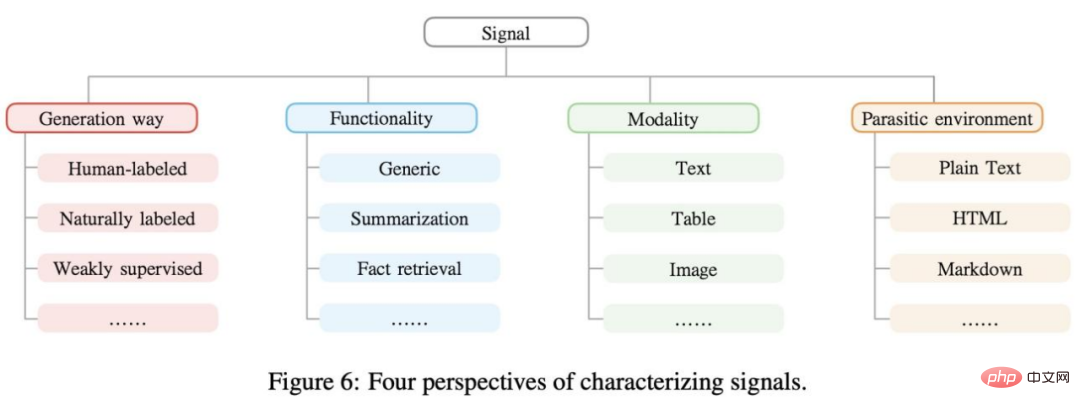

信号是数据中存在的有用信息,可以为机器学习模型提供监督,表示为 n 元组。例如「莫扎特出生在萨尔茨堡」,「莫扎特」、「萨尔茨堡」可以被认为是命名实体识别的信号。通常,可以从不同的角度对信号进行聚类,如下图 6 所示。

数据挖掘

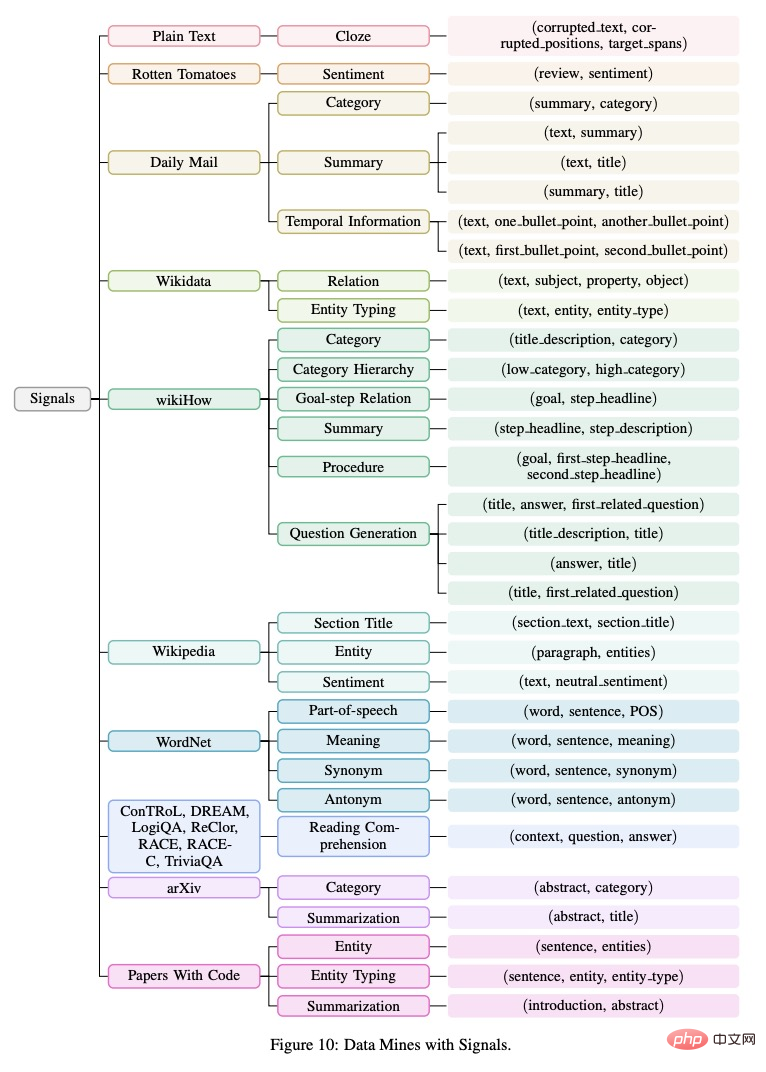

现实世界的数据中包含很多不同类型的信号。重构预训练使这些信号能够充分被利用。该研究将收集到的信号(n 元组)组织在树形图中,如下图 10 所示。

信号提取

下一步该研究进行了信号提取和处理,涉及从不同模态的数据挖掘中获取原始数据、数据清洗和数据规范化。现有的方法大致分为两种:(1)基于规则的,(2)基于机器学习的。在这项工作中,该研究主要关注基于规则的信号提取策略,并为未来的工作留下更多高覆盖率的方法。

信号重构

在从各种数据挖掘中提取出不同的信号之后,接下来重要的一步是将它们统一成一个固定的形式,以便在预训练期间将所有信息一致存储在模型中。prompt 方法(Brown et al., 2020; Liu et al., 2021d)可以实现这个目标,原则上,通过适当的 prompt 设计,它几乎可以将所有类型的信号统一为一种语言模型风格。

该研究将信号分为两大类:通用信号和任务相关信号。前者包含基本的语言知识,可以在一定程度上使所有下游任务受益,而后者则可以使某些特定的下游任务受益。

在 55 种常用的 NLP 数据集上的实验

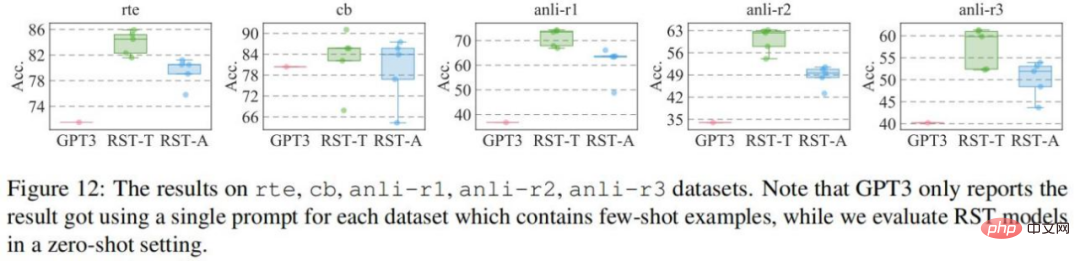

该研究在 55 个数据集上进行评估,然后将它们分别与 GPT3 和 T0pp 进行比较。与 GPT3 比较的结果如图所示:在除 cb 数据集之外的四个数据集上,RST-All 和 RST-Task 都具有比 GPT3 的小样本学习更好的零样本性能。此外,cb 数据集是这些数据集中最小的,验证集中只有 56 个样本,因此不同的 prompt 在该数据集上的性能会有较大的波动。

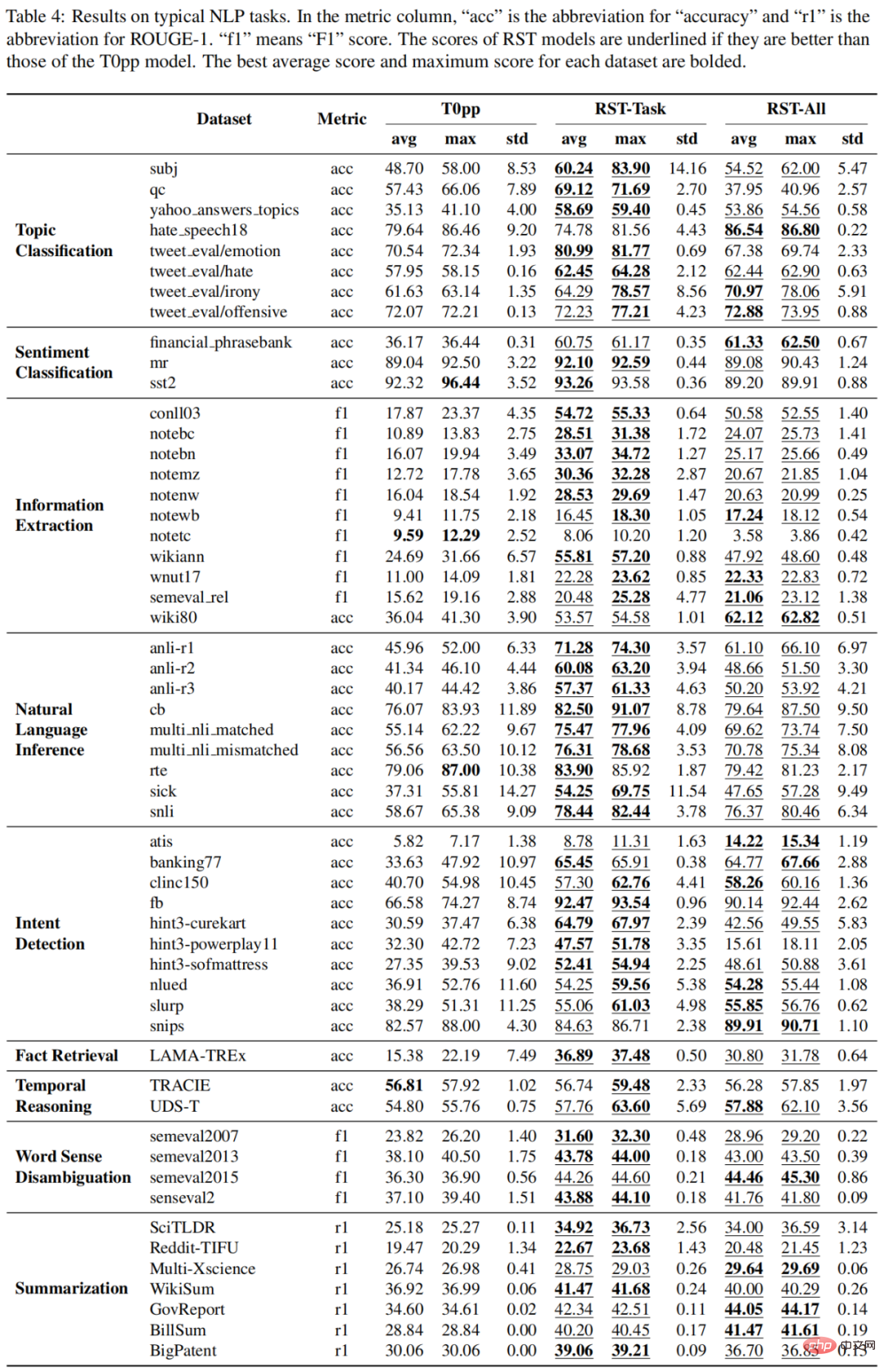

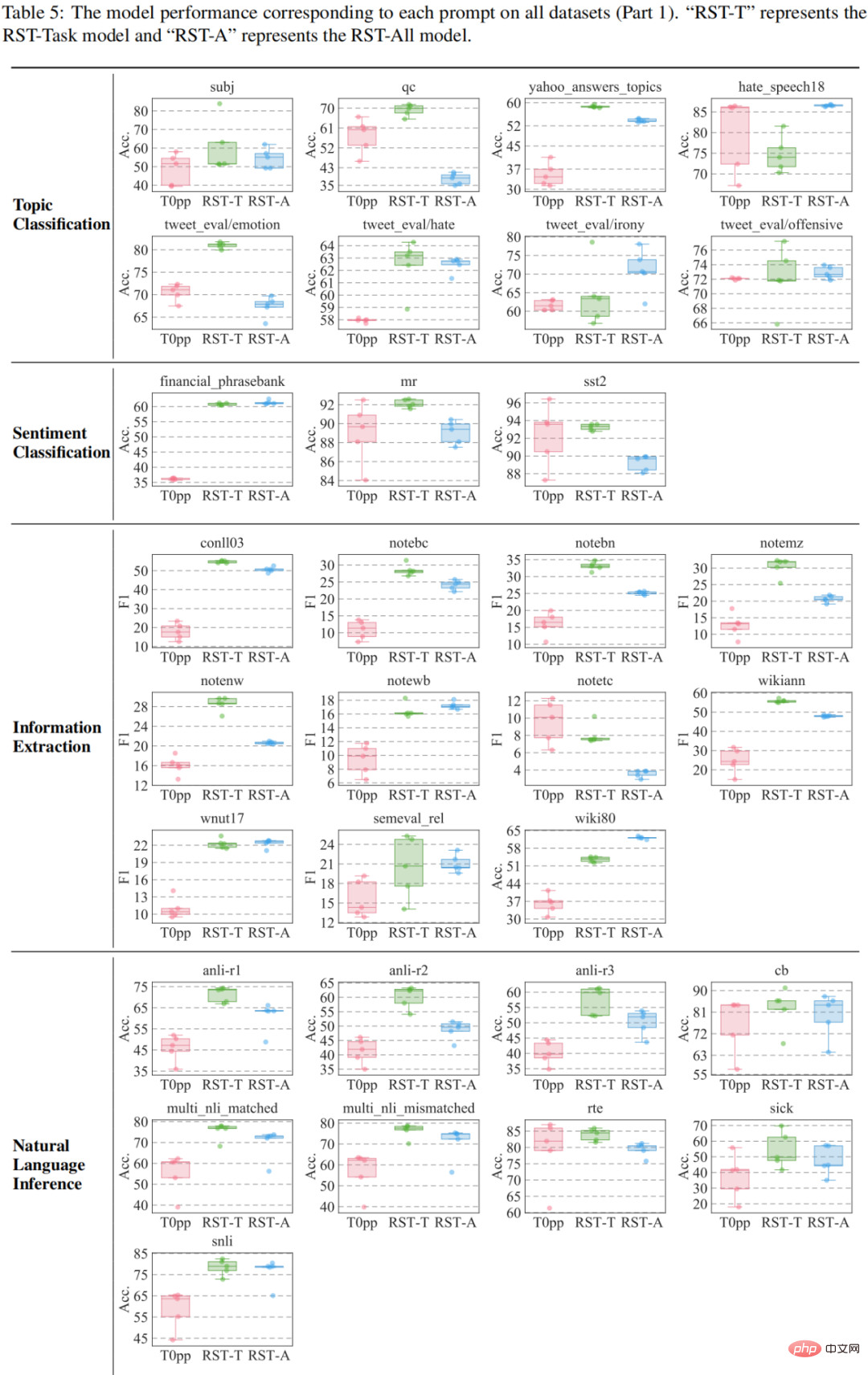

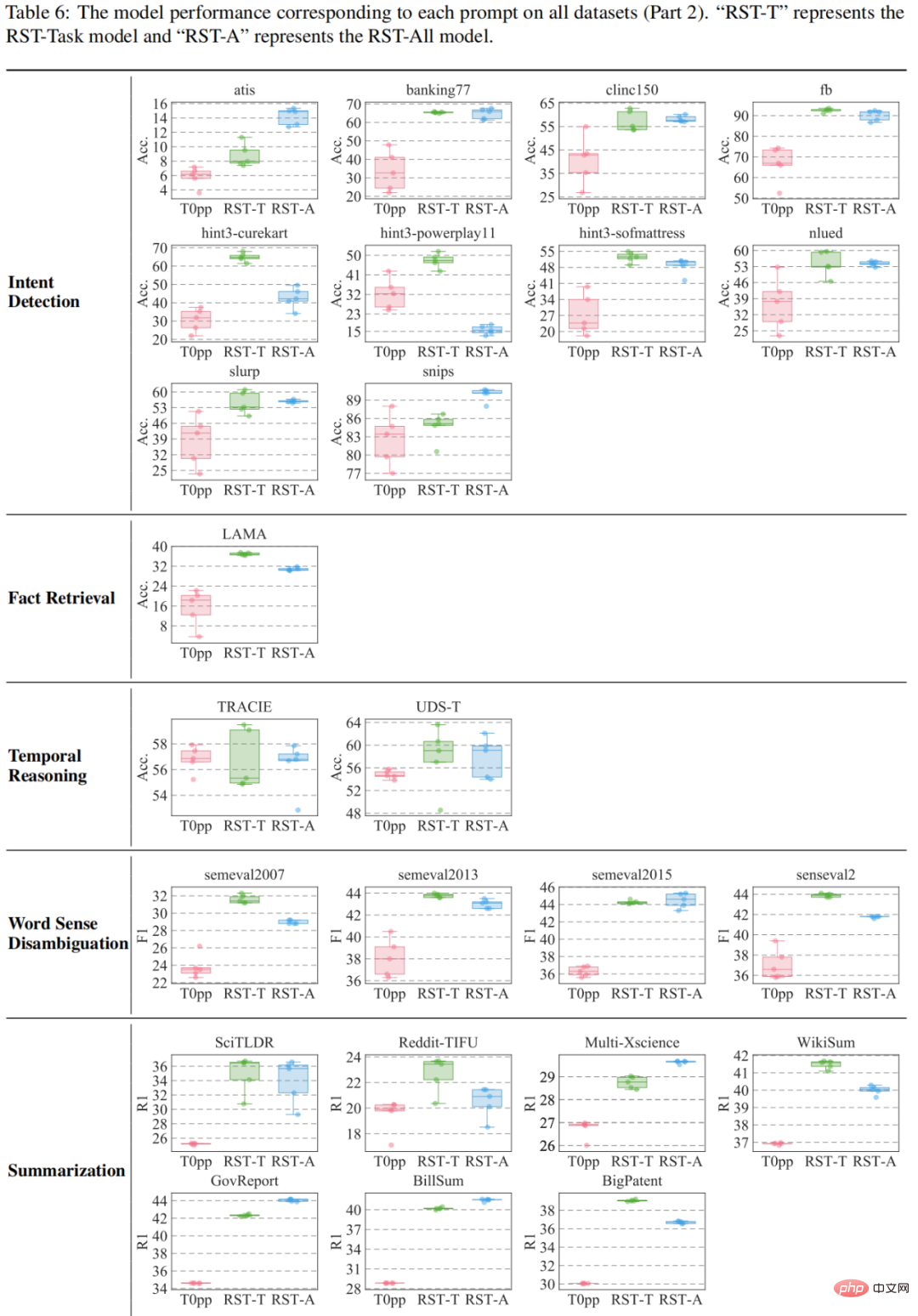

与 T0pp 比较结果如表 4-6 所示。例如在 55 个测量的平均性能中,RST-All 在 49 个数据集上击败了 T0pp,并在 47/55 示例上以最大性能胜出。此外,在 55 个数据集的平均性能测试中,RST-Task 在 52 个数据集上优于 T0pp,并在 50/55 个示例下超越 T0pp。这说明重构学习的优越性。

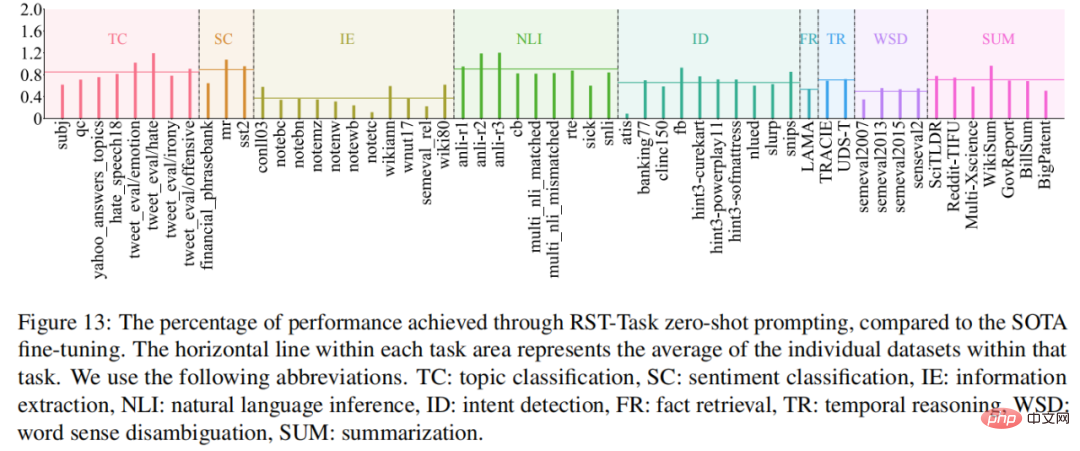

性能最佳的模型 RST-Task 擅长哪些任务?为了回答这个问题,该研究将 RST-Task 模型在零样本设置中的性能与当前 SOTA 模型进行比较,结果如图 13 所示。RST-Task 擅长主题分类、情感分类和自然语言推理任务,但在信息提取任务中表现较差。

高考实验:迈向人类水平的 AI

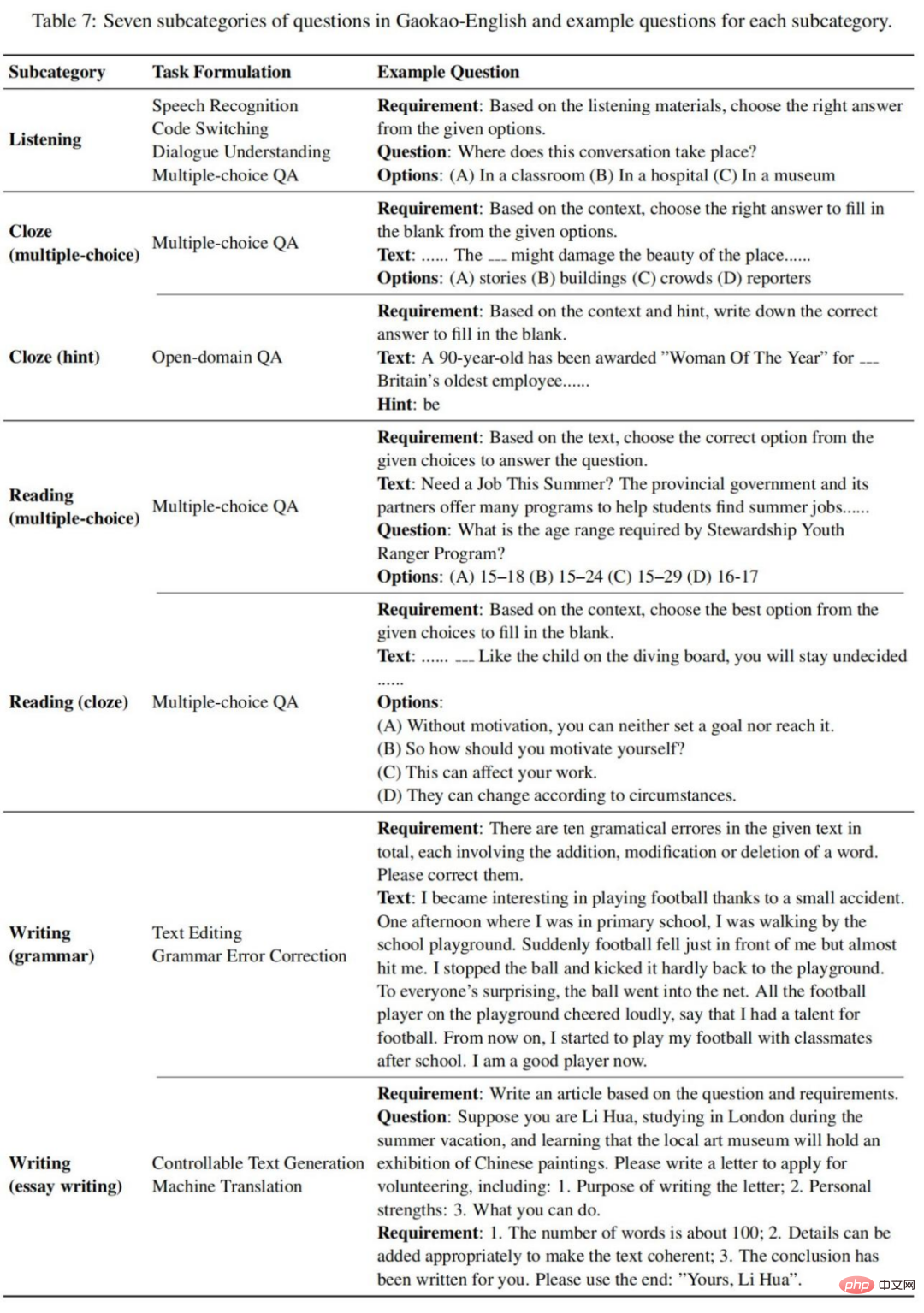

该研究收集了 10 份高考英语试卷,包括 2018 年国考 I/III、2019 年国考 I/II/III、2020 年国考 I/II/III、2021 年全国卷 A/B。这些试卷遵循相同的题型,他们将所有考试题型分为以下七个子类别,如表 7 所示:

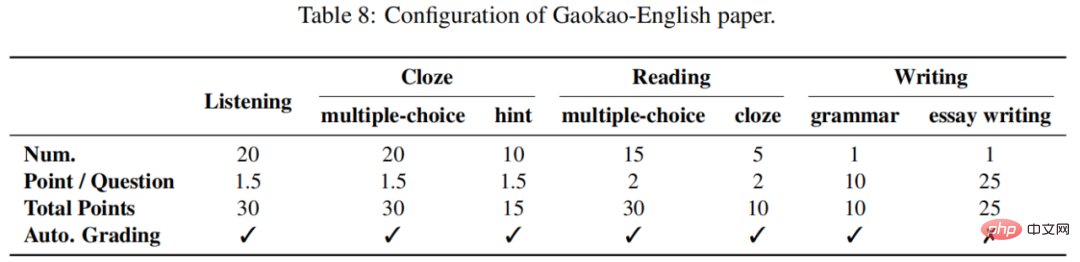

每篇高考英语试卷满分 150 分。听力、完形填空、阅读、写作分别占 30、45、40、35。通常,写作部分是主观的,需要人工评估,而其他部分是客观的,可以自动评分。如表 8 所示:

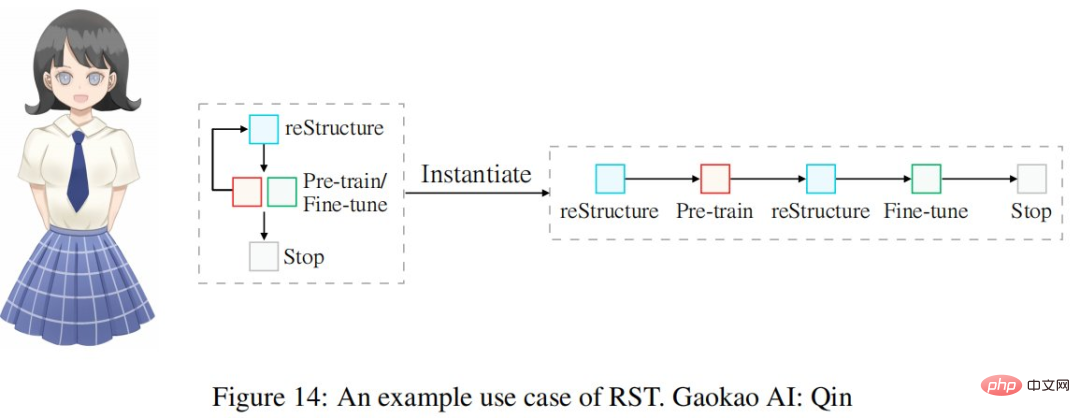

使用表 1 中所示的重构工程循环来构建高考英语 AI 系统,即 Qin。整个过程如图 14 所示:

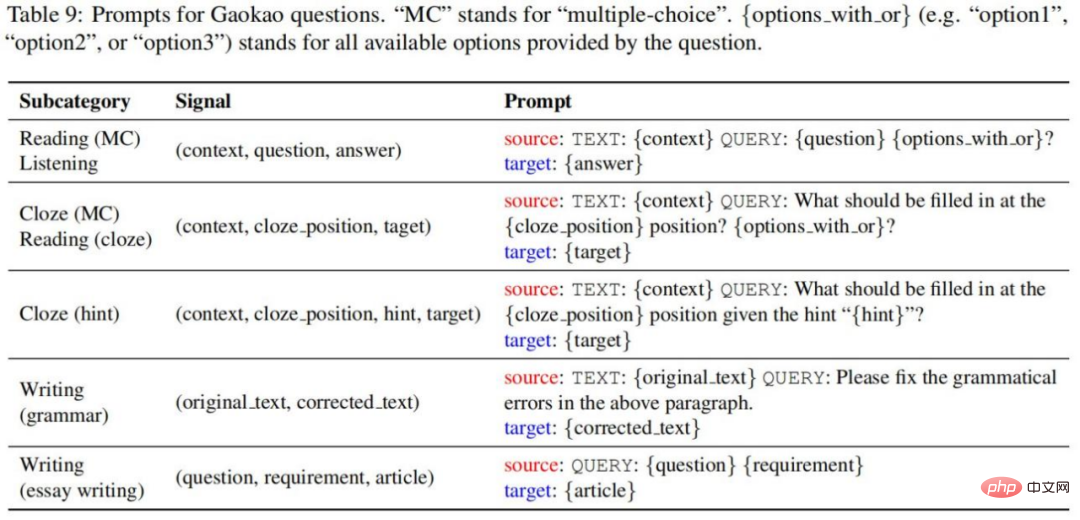

该研究使用以下 prompt 将原始信号元组转换为 prompt 样本,如表 9 所示:

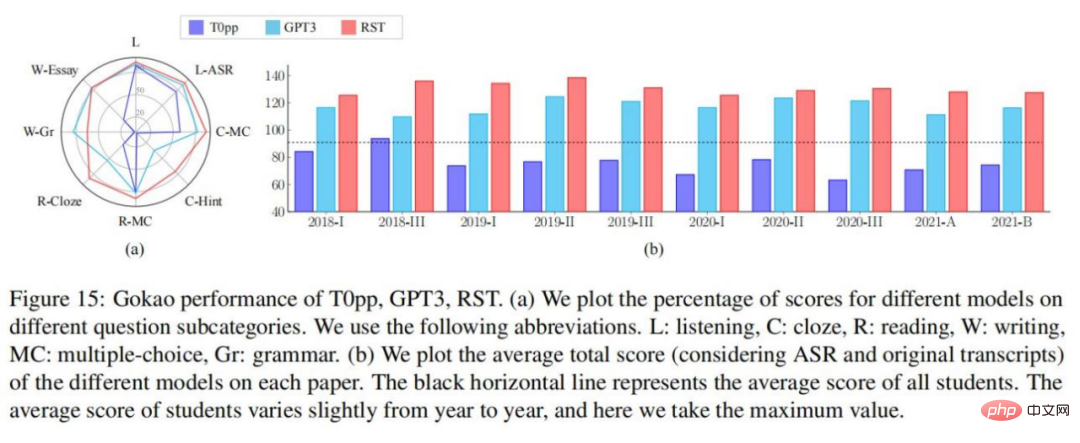

实验结果如表 10-11 所示,我们可以得出以下结论:在每一份英语试卷中,RST 在两套听力考试中取得了最高的总分,平均分数为 130.6 分;与 T0pp 相比,RST 的性能要远远优于相同模型大小下的 T0pp。在所有设置中,RST 获得的总分平均比 T0pp 高出 54.5 分,最高差距为 69 分(占总分的 46%);与 GPT3 相比,RST 可以在模型大小小 16 倍的情况下取得明显更好的结果。在所有考虑的设置中,RST 获得的总分平均比 T0pp 高 14.0 分,最高为 26 分(占总分的 17%);对于 T0pp,使用黄金和语音转文本成绩单获得的听力分数差异很大,平均为 4.2 分。相比之下,GPT3 和 RST 分别为 0.6 和 0.45,表明 T0pp 的性能对文本质量很敏感。

该研究进行了细粒度分析,以了解不同模型在不同问题子类别上的表现。在图 15-(a) 中,很明显 RST 和 GPT3 在每个问题子类别上都优于 T0pp。

图 15-(b)为近年来模型的表现和学生在全国试卷上的平均表现。很明显,T0pp 在 9/10 试卷上的总分低于学生的平均水平,而 RST 和 GPT3 的表现则超过了学生的平均水平。尤其是这十份试卷中有五份,RST 的总分超过了 130(通常被认为是学生争取的目标分数)。

2022 年高考 - 英语考试(2022.06.08)刚刚结束,了解到模型在最近一年的高考试卷中的表现。该研究用 GPT3 和 RST 进行实验。结果显示 RST 总分达到 134,远高于 GPT3 达到的 108 分。

以上是今年英语高考,CMU用重构预训练交出134高分,大幅超越GPT3的详细内容。更多信息请关注PHP中文网其他相关文章!