怎么用Node爬取网页的数据并写入Excel文件?下面本篇文章通过一个实例来讲解一下用Node.js爬取网页的数据并生成Excel文件的方法,希望对大家有所帮助!

相信宝可梦是很多90后的童年回忆,身为程序员不止一次的也想做一款宝可梦游戏,但是做之前应该先要整理一下有多少宝可梦,他们的编号,名字,属性等信息整理出来,本期将用 Node.js 简单的实现一个从宝可梦网页数据的爬取,到把这些数据生成Excel文件,直至做接口读取Excel访问到这些数据。

爬取数据

既然是爬取数据,那我们先找一个有宝可梦图鉴数据的网页,如下图:

这个网站是用PHP写的,前后没有做分离,所以我们不会读接口来捕获数据,我们使用 crawler 库,来捕获网页中的元素从而得到数据。提前说明一下,用 crawler 库,好处是你可以用 jQuery 的方式在Node环境中捕获元素。

安装:

yarn add crawler

实现:

const Crawler = require("crawler");

const fs = require("fs")

const { resolve } = require("path")

let crawler = new Crawler({

timeout: 10000,

jQuery: true,

});

let crawler = new Crawler({

timeout: 10000,

jQuery: true,

});

function getPokemon() {

let uri = "" // 宝可梦图鉴地址

let data = []

return new Promise((resolve, reject) => {

crawler.queue({

uri,

callback: (err, res, done) => {

if (err) reject(err);

let $ = res.$;

try {

let $tr = $(".roundy.eplist tr");

$tr.each((i, el) => {

let $td = $(el).find("td");

let _code = $td.eq(1).text().split("\n")[0]

let _name = $td.eq(3).text().split("\n")[0]

let _attr = $td.eq(4).text().split("\n")[0]

let _other = $td.eq(5).text().split("\n")[0]

_attr = _other.indexOf("属性") != -1 ? _attr : `${_attr}+${_other}`

if (_code) {

data.push([_code, _name, _attr])

}

})

done();

resolve(data)

} catch (err) {

done()

reject(err)

}

}

})

})

}

在生成实例的时候,还需要开启 jQuery 模式,然后,就可以使用 $ 符了。而以上代码的中间部分的业务就是在捕获元素爬取网页中所需要的数据,使用起来和 jQuery API 一样,这里就不再赘述了 。

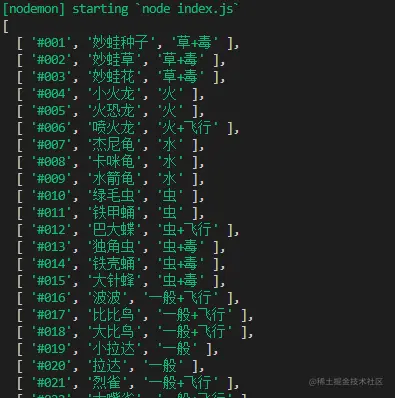

getPokemon().then(async data => {

console.log(data)

})

最后我们可以执行并打印一下传过来的 data 数据,来验证确实爬取到了格式也没有错误。

写入Excel

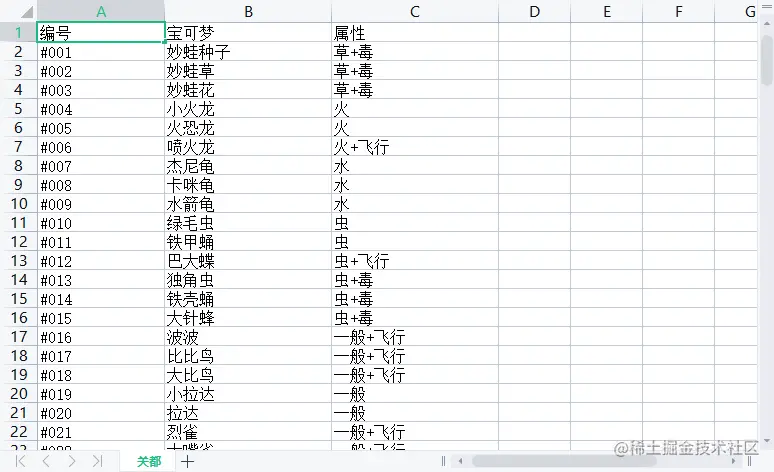

既然刚才已经爬取到数据了,接下来,我们就将使用 node-xlsx 库,来完成把数据写入并生成一个 Excel 文件中。

首先,我们先介绍一下,node-xlsx 是一个简单的 excel 文件解析器和生成器。由 TS 构建的一个依靠 SheetJS xlsx 模块来解析/构建 excel 工作表,所以,在一些参数配置上,两者可以通用。

安装:

yarn add node-xlsx

实现:

const xlsx = require("node-xlsx")

getPokemon().then(async data => {

let title = ["编号", "宝可梦", "属性"]

let list = [{

name: "关都",

data: [

title,

...data

]

}];

const sheetOptions = { '!cols': [{ wch: 15 }, { wch: 20 }, { wch: 20 }] };

const buffer = await xlsx.build(list, { sheetOptions })

try {

await fs.writeFileSync(resolve(__dirname, "data/pokemon.xlsx"), buffer, "utf8")

} catch (error) { }

})

其 name 则是Excel文件中的栏目名,而其中的 data 类型是数组其也要传入一个数组,构成二维数组,其表示从 ABCDE.... 列中开始排序传入文本。同时,可以通过!cols来设置列宽。第一个对象wch:10 则表示 第一列宽度为10 个字符,还有很多参数可以设置,可以参照 xlsx 库 来学习这些配置项。

最后,我们通过 xlsx.build 方法来生成 buffer 数据,最后用 fs.writeFileSync 写入或创建一个 Excel 文件中,为了方便查看,我这里存入了 名叫 data 的文件夹里,此时,我们在 data 文件夹 就会发现多出一个叫 pokemon.xlsx 的文件,打开它,数据还是那些,这样把数据写入到Excel的这步操作就完成了。

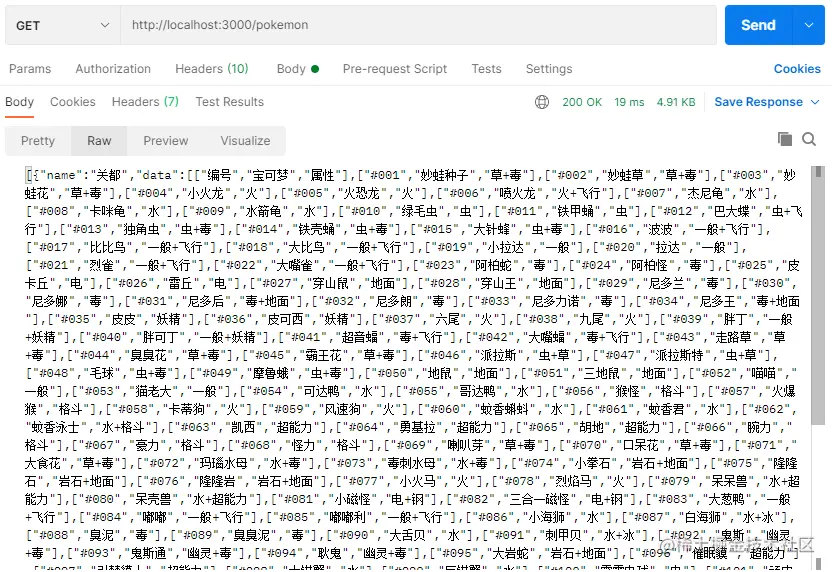

读取Excel

读取Excel其实非常容易甚至不用写 fs 的读取, 用xlsx.parse 方法传入文件地址就能直接读取到。

xlsx.parse(resolve(__dirname, "data/pokemon.xlsx"));

当然,我们为了验证准确无误,直接写一个接口,看看能不能访问到数据。为了方便我直接用 express 框架来完成这件事。

先来安装一下:

yarn add express

然后,再创建 express 服务,我这里端口号就用3000了,就写一个 GET 请求把读取Excel文件的数据发送出去就好。

const express = require("express")

const app = express();

const listenPort = 3000;

app.get("/pokemon",(req,res)=>{

let data = xlsx.parse(resolve(__dirname, "data/pokemon.xlsx"));

res.send(data)

})

app.listen(listenPort, () => {

console.log(`Server running at http://localhost:${listenPort}/`)

})

最后,我这里用 postman 访问接口,就可以清楚的看到,我们从爬取到存入表格所有的宝可梦数据都接收到了。

结语

如你所见,本文以宝可梦为例,来去学习怎么用Node.js爬取网页的数据,怎么把数据写入Excel文件,以及怎么读取到Excel文件的数据这三个问题,其实实现难度并不大,但有些时候蛮实用的,如果担心忘记可以收藏起来哟~

更多node相关知识,请访问:nodejs 教程!

以上是node爬取数据实例:抓取宝可梦图鉴并生成Excel文件的详细内容。更多信息请关注PHP中文网其他相关文章!

JavaScript是用C编写的吗?检查证据Apr 25, 2025 am 12:15 AM

JavaScript是用C编写的吗?检查证据Apr 25, 2025 am 12:15 AM是的,JavaScript的引擎核心是用C语言编写的。1)C语言提供了高效性能和底层控制,适合JavaScript引擎的开发。2)以V8引擎为例,其核心用C 编写,结合了C的效率和面向对象特性。3)JavaScript引擎的工作原理包括解析、编译和执行,C语言在这些过程中发挥关键作用。

JavaScript的角色:使网络交互和动态Apr 24, 2025 am 12:12 AM

JavaScript的角色:使网络交互和动态Apr 24, 2025 am 12:12 AMJavaScript是现代网站的核心,因为它增强了网页的交互性和动态性。1)它允许在不刷新页面的情况下改变内容,2)通过DOMAPI操作网页,3)支持复杂的交互效果如动画和拖放,4)优化性能和最佳实践提高用户体验。

C和JavaScript:连接解释Apr 23, 2025 am 12:07 AM

C和JavaScript:连接解释Apr 23, 2025 am 12:07 AMC 和JavaScript通过WebAssembly实现互操作性。1)C 代码编译成WebAssembly模块,引入到JavaScript环境中,增强计算能力。2)在游戏开发中,C 处理物理引擎和图形渲染,JavaScript负责游戏逻辑和用户界面。

从网站到应用程序:JavaScript的不同应用Apr 22, 2025 am 12:02 AM

从网站到应用程序:JavaScript的不同应用Apr 22, 2025 am 12:02 AMJavaScript在网站、移动应用、桌面应用和服务器端编程中均有广泛应用。1)在网站开发中,JavaScript与HTML、CSS一起操作DOM,实现动态效果,并支持如jQuery、React等框架。2)通过ReactNative和Ionic,JavaScript用于开发跨平台移动应用。3)Electron框架使JavaScript能构建桌面应用。4)Node.js让JavaScript在服务器端运行,支持高并发请求。

Python vs. JavaScript:比较用例和应用程序Apr 21, 2025 am 12:01 AM

Python vs. JavaScript:比较用例和应用程序Apr 21, 2025 am 12:01 AMPython更适合数据科学和自动化,JavaScript更适合前端和全栈开发。1.Python在数据科学和机器学习中表现出色,使用NumPy、Pandas等库进行数据处理和建模。2.Python在自动化和脚本编写方面简洁高效。3.JavaScript在前端开发中不可或缺,用于构建动态网页和单页面应用。4.JavaScript通过Node.js在后端开发中发挥作用,支持全栈开发。

C/C在JavaScript口译员和编译器中的作用Apr 20, 2025 am 12:01 AM

C/C在JavaScript口译员和编译器中的作用Apr 20, 2025 am 12:01 AMC和C 在JavaScript引擎中扮演了至关重要的角色,主要用于实现解释器和JIT编译器。 1)C 用于解析JavaScript源码并生成抽象语法树。 2)C 负责生成和执行字节码。 3)C 实现JIT编译器,在运行时优化和编译热点代码,显着提高JavaScript的执行效率。

JavaScript在行动中:现实世界中的示例和项目Apr 19, 2025 am 12:13 AM

JavaScript在行动中:现实世界中的示例和项目Apr 19, 2025 am 12:13 AMJavaScript在现实世界中的应用包括前端和后端开发。1)通过构建TODO列表应用展示前端应用,涉及DOM操作和事件处理。2)通过Node.js和Express构建RESTfulAPI展示后端应用。

JavaScript和Web:核心功能和用例Apr 18, 2025 am 12:19 AM

JavaScript和Web:核心功能和用例Apr 18, 2025 am 12:19 AMJavaScript在Web开发中的主要用途包括客户端交互、表单验证和异步通信。1)通过DOM操作实现动态内容更新和用户交互;2)在用户提交数据前进行客户端验证,提高用户体验;3)通过AJAX技术实现与服务器的无刷新通信。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

记事本++7.3.1

好用且免费的代码编辑器

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器