基于node如何实现http传输大文件?下面本篇文章给大家介绍一下基于nodejs的几种http文件传输实践方案,希望对大家有所帮助!

基于nodejs的http文件传输方案在现阶段的前后端全栈开发中有都很重要的作用,本文我将通过几种方案实现http传输大文件。在实现功能之前,我们先通过nodejs的fs模块写入一个大文件,并在项目中生成一个本地文件:

const fs = require('fs');

const writeStream = fs.createWriteStream(__dirname + "/file.txt");

for(let i = 0;i <= 100000; i++) {

writeStream.write(`${i} —— 我是${i}号文件\n`, "utf-8");

}

writeStream.end();

以上代码成功运行后,在当前的执行目录下将会生成一个大小为 3.2MB 大小的文本文件,该文件将作为以下方案的 “大文件素材”。在列出大文件传输方案之前,我们先封装后面即将用到的两个公共方法: 文件读取方法 和 文件压缩方法:

// 封装读取文件的方法

const readFile = async (paramsData) => {

return new Promise((resolve, reject) => {

fs.readFile(paramsData, (err, data) => {

if(err) {

reject('文件读取错误');

} else {

resolve(data);

}

})

})

}

// 封装文件压缩方法

const gzip = async (paramsData) => {

return new Promise((resolve, reject) => {

zlib.gzip(paramsData, (err, result) => {

if(err) {

reject('文件压缩错误');

} else {

resolve(result);

}

})

})

}1. 通过大文件在数据压缩后传输

浏览器在发送请求时,都会携带 accept 和 accept-* 请求头信息,用于告诉服务器当前浏览器所支持的文件类型、支持的压缩格式列表和支持的语言。请求头中的 Accept-Encoding 字段,用于将客户端能够理解的内容编码方式(通常是某种压缩算法)告诉给服务端。服务端会选择一个客户端所支持的方式,并通过响应头 Content-Encoding 来通知客户端该选择,响应头告诉浏览器返回的 JS 脚本,是经过 gzip 压缩算法处理过的

// 请求头 accept-encoding: gzip, deflate, br

// 响应头 cache-control: max-age=2592000 content-encoding: gzip content-type: application/x-javascript

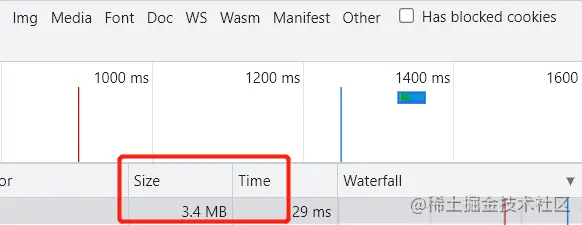

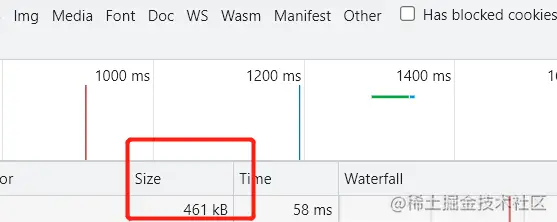

基于 Accept-Encoding 和 Content-Encoding 字段的了解,我们来验证一下未开启 gzip 和开启 gzip 的效果。

// 实现一个简单的文件读取服务器(没有开启gzip)

const server = http.createServer(async (req, res) => {

res.writeHead(200, {

"Content-Type": "text/plain;charset=utf-8",

});

const buffer = await readFile(__dirname + '/file.txt');

res.write(buffer);

res.end();

})

server.listen(3000, () => {

console.log(`server启动成功`)

})

// 实现一个简单的文件读取服务器(开启gzip)

const server = http.createServer(async(req, res) => {

res.writeHead(200, {

"Content-Type": "text/plain;charset=utf-8",

"Content-Encoding": "gzip"

});

const buffer = await readFile(__dirname + '/file.txt');

const gzipData = await gzip(buffer);

res.write(gzipData);

res.end();

})

server.listen(3000, () => {

console.log(`server启动成功`)

})

2. 通过数据分块传输

有场景需要用从数据库中查询获得的数据生成一个大的 HTML 表格的时候,或者需要传输大量的图片的时候,可以通过分块传输实现。

Transfer-Encoding: chunked Transfer-Encoding: gzip, chunked

响应头 Transfer-Encoding 字段的值为 chunked,表示数据以一系列分块的形式进行发送。需要注意的是 Transfer-Encoding 和 Content-Length 这两个字段是互斥的,也就是说响应报文中这两个字段不能同时出现。

// 数据分块传输

const spilitChunks = async () =>{

const buffer = await readFile(__dirname + '/file.txt');

const lines = buffer.toString('utf-8').split('\n');

let [chunks, i, n] = [[], 0, lines.length];

while(i < n) {

chunks.push(lines.slice(i, i+= 10));

};

return chunks;

}

const server = http.createServer(async(req, res) => {

res.writeHead(200, {

"Content-Type": "text/plain;charset=utf-8",

"Transfer-Encoding": "chunked",

"Access-Control-Allow-Origin": "*",

});

const chunks = await spilitChunks();

for(let i =0; i< chunks.length; i++) {

setTimeout(() => {

let content = chunks[i].join("&");

res.write(`${content.length.toString(16)}\r\n${content}\r\n`);

}, i * 1000);

}

setTimeout(() => {

res.end();

}, chunks.length * 1000);

})

server.listen(3000, () => {

console.log(`server启动成功`)

})3. 通过数据流的形式传输

当使用 Node.js 向客户端返回大文件时,使用流的形式来返回文件流能避免处理大文件时,占用过多的内存。具体实现方式如下所示。当使用流的形式来返回文件数据时,HTTP 响应头 Transfer-Encoding 字段的值为 chunked,表示数据以一系列分块的形式进行发送。

const server = http.createServer((req, res) => {

res.writeHead(200, {

"Content-Type": "text/plain;charset=utf-8",

"Content-Encoding": "gzip",

"Transfer-Encoding": "chunked"

});

fs.createReadStream(__dirname + "/file.txt")

.setEncoding("utf-8")

.pipe(zlib.createGzip())

.pipe(res);

})

server.listen(3000, () => {

console.log(`server启动成功`)

})更多node相关知识,请访问:nodejs 教程!!

以上是基于nodejs如何实现http传输大文件?(实践方法分享)的详细内容。更多信息请关注PHP中文网其他相关文章!

了解JavaScript引擎:实施详细信息Apr 17, 2025 am 12:05 AM

了解JavaScript引擎:实施详细信息Apr 17, 2025 am 12:05 AM理解JavaScript引擎内部工作原理对开发者重要,因为它能帮助编写更高效的代码并理解性能瓶颈和优化策略。1)引擎的工作流程包括解析、编译和执行三个阶段;2)执行过程中,引擎会进行动态优化,如内联缓存和隐藏类;3)最佳实践包括避免全局变量、优化循环、使用const和let,以及避免过度使用闭包。

Python vs. JavaScript:学习曲线和易用性Apr 16, 2025 am 12:12 AM

Python vs. JavaScript:学习曲线和易用性Apr 16, 2025 am 12:12 AMPython更适合初学者,学习曲线平缓,语法简洁;JavaScript适合前端开发,学习曲线较陡,语法灵活。1.Python语法直观,适用于数据科学和后端开发。2.JavaScript灵活,广泛用于前端和服务器端编程。

Python vs. JavaScript:社区,图书馆和资源Apr 15, 2025 am 12:16 AM

Python vs. JavaScript:社区,图书馆和资源Apr 15, 2025 am 12:16 AMPython和JavaScript在社区、库和资源方面的对比各有优劣。1)Python社区友好,适合初学者,但前端开发资源不如JavaScript丰富。2)Python在数据科学和机器学习库方面强大,JavaScript则在前端开发库和框架上更胜一筹。3)两者的学习资源都丰富,但Python适合从官方文档开始,JavaScript则以MDNWebDocs为佳。选择应基于项目需求和个人兴趣。

从C/C到JavaScript:所有工作方式Apr 14, 2025 am 12:05 AM

从C/C到JavaScript:所有工作方式Apr 14, 2025 am 12:05 AM从C/C 转向JavaScript需要适应动态类型、垃圾回收和异步编程等特点。1)C/C 是静态类型语言,需手动管理内存,而JavaScript是动态类型,垃圾回收自动处理。2)C/C 需编译成机器码,JavaScript则为解释型语言。3)JavaScript引入闭包、原型链和Promise等概念,增强了灵活性和异步编程能力。

JavaScript引擎:比较实施Apr 13, 2025 am 12:05 AM

JavaScript引擎:比较实施Apr 13, 2025 am 12:05 AM不同JavaScript引擎在解析和执行JavaScript代码时,效果会有所不同,因为每个引擎的实现原理和优化策略各有差异。1.词法分析:将源码转换为词法单元。2.语法分析:生成抽象语法树。3.优化和编译:通过JIT编译器生成机器码。4.执行:运行机器码。V8引擎通过即时编译和隐藏类优化,SpiderMonkey使用类型推断系统,导致在相同代码上的性能表现不同。

超越浏览器:现实世界中的JavaScriptApr 12, 2025 am 12:06 AM

超越浏览器:现实世界中的JavaScriptApr 12, 2025 am 12:06 AMJavaScript在现实世界中的应用包括服务器端编程、移动应用开发和物联网控制:1.通过Node.js实现服务器端编程,适用于高并发请求处理。2.通过ReactNative进行移动应用开发,支持跨平台部署。3.通过Johnny-Five库用于物联网设备控制,适用于硬件交互。

使用Next.js(后端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:23 AM

使用Next.js(后端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:23 AM我使用您的日常技术工具构建了功能性的多租户SaaS应用程序(一个Edtech应用程序),您可以做同样的事情。 首先,什么是多租户SaaS应用程序? 多租户SaaS应用程序可让您从唱歌中为多个客户提供服务

如何使用Next.js(前端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:22 AM

如何使用Next.js(前端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:22 AM本文展示了与许可证确保的后端的前端集成,并使用Next.js构建功能性Edtech SaaS应用程序。 前端获取用户权限以控制UI的可见性并确保API要求遵守角色库

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

SublimeText3 Linux新版

SublimeText3 Linux最新版

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。