linux安装hadoop的方法:1、安装ssh服务;2、使用ssh进行无密码验证登录;3、下载Hadoop安装包;4、解压缩Hadoop安装包;5、配置Hadoop中相应的文件即可。

本文操作环境:ubuntu 16.04系统、Hadoop2.7.1版、Dell G3电脑。

linux怎么安装hadoop?

【大数据】Linux下安装Hadoop(2.7.1)详解及WordCount运行

一、引言

在完成了Storm的环境配置之后,想着鼓捣一下Hadoop的安装,网上面的教程好多,但是没有一个特别切合的,所以在安装的过程中还是遇到了很多的麻烦,并且最后不断的查阅资料,终于解决了问题,感觉还是很好的,下面废话不多说,开始进入正题。

本机器的配置环境如下:

Hadoop(2.7.1)

Ubuntu Linux(64位系统)

下面分为几个步骤来详解配置过程。

二、安装ssh服务

进入shell命令,输入如下命令,查看是否已经安装好ssh服务,若没有,则使用如下命令进行安装:

sudo apt-get install ssh openssh-server

安装过程还是比较轻松加愉快的。

三、使用ssh进行无密码验证登录

1.创建ssh-key,这里我们采用rsa方式,使用如下命令:

ssh-keygen -t rsa -P ""

2.出现一个图形,出现的图形就是密码,不用管它

cat ~/.ssh/id_rsa.pub >> authorized_keys(好像是可以省略的)

3.然后即可无密码验证登录了,如下:

ssh localhost

成功截图如下:

四、下载Hadoop安装包

下载Hadoop安装也有两种方式

1.直接上官网进行下载,http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

2.使用shell进行下载,命令如下:

wget http://mirrors.hust.edu.cn/apache/hadoop/core/stable/hadoop-2.7.1.tar.gz

貌似第二种的方法要快点,经过漫长的等待,终于下载完成。

五、解压缩Hadoop安装包

使用如下命令解压缩Hadoop安装包

tar -zxvf hadoop-2.7.1.tar.gz

解压缩完成后出现hadoop2.7.1的文件夹

六、配置Hadoop中相应的文件

需要配置的文件如下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml,所有的文件均位于hadoop2.7.1/etc/hadoop下面,具体需要的配置如下:

1.core-site.xml 配置如下:

<configuration> <property> <name>hadoop.tmp.dir</name> <value>file:/home/leesf/program/hadoop/tmp</value> <description>Abase for other temporary directories.</description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

其中的hadoop.tmp.dir的路径可以根据自己的习惯进行设置。

2.mapred-site.xml.template配置如下:

<configuration> <property> <name>mapred.job.tracker</name> <value>localhost:9001</value> </property> </configuration>

3.hdfs-site.xml配置如下:

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/home/leesf/program/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/home/leesf/program/hadoop/tmp/dfs/data</value> </property> </configuration>

其中dfs.namenode.name.dir和dfs.datanode.data.dir的路径可以自由设置,最好在hadoop.tmp.dir的目录下面。

补充,如果运行Hadoop的时候发现找不到jdk,可以直接将jdk的路径放置在hadoop.env.sh里面,具体如下:

export JAVA_HOME="/home/leesf/program/java/jdk1.8.0_60"

七、运行Hadoop

在配置完成后,运行hadoop。

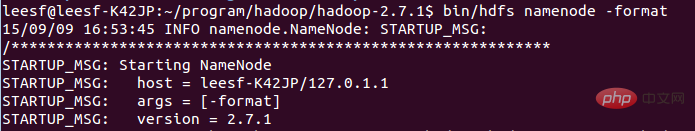

1.初始化HDFS系统

在hadop2.7.1目录下使用如下命令:

bin/hdfs namenode -format

截图如下:

过程需要进行ssh验证,之前已经登录了,所以初始化过程之间键入y即可。

成功的截图如下:

表示已经初始化完成。

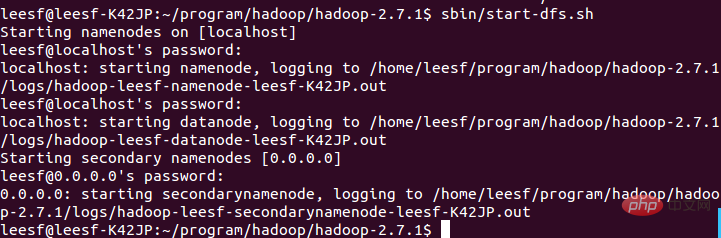

2.开启NameNode和DataNode守护进程

使用如下命令开启:

sbin/start-dfs.sh,成功的截图如下:

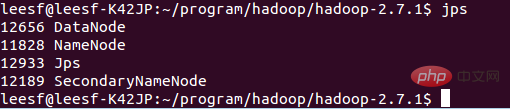

3.查看进程信息

使用如下命令查看进程信息

jps,截图如下:

表示数据DataNode和NameNode都已经开启

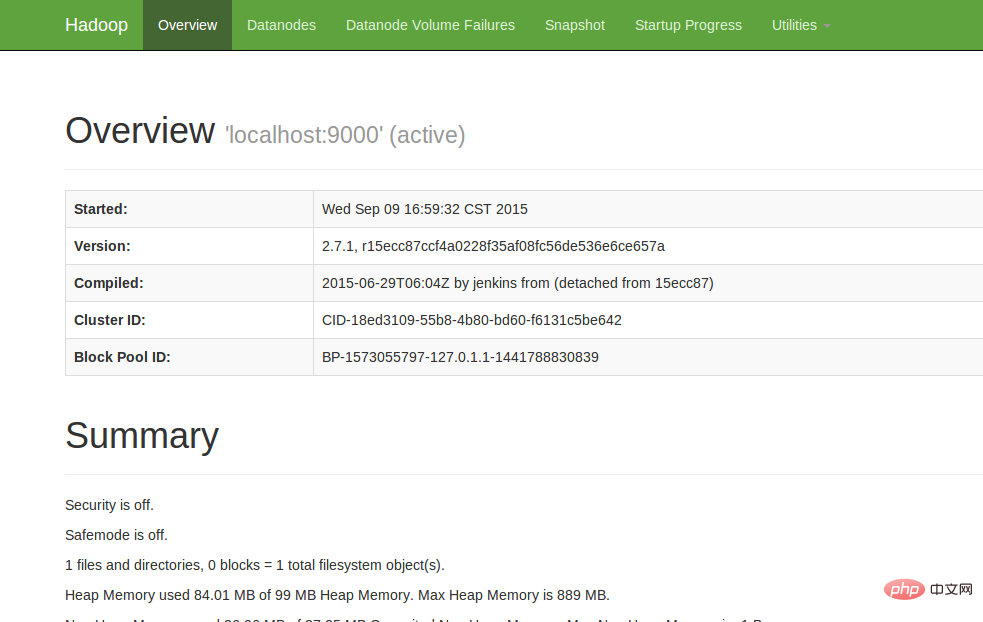

4.查看Web UI

在浏览器中输入http://localhost:50070,即可查看相关信息,截图如下:

至此,hadoop的环境就已经搭建好了。下面开始使用hadoop来运行一个WordCount例子。

八、运行WordCount Demo

1.在本地新建一个文件,笔者在home/leesf目录下新建了一个words文档,里面的内容可以随便填写。

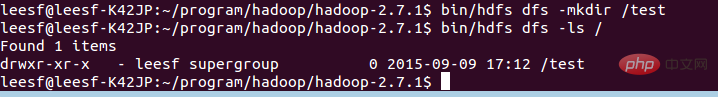

2.在HDFS中新建一个文件夹,用于上传本地的words文档,在hadoop2.7.1目录下输入如下命令:

bin/hdfs dfs -mkdir /test,表示在hdfs的根目录下建立了一个test目录

使用如下命令可以查看HDFS根目录下的目录结构

bin/hdfs dfs -ls /

具体截图如下:

表示在HDFS的根目录下已经建立了一个test目录

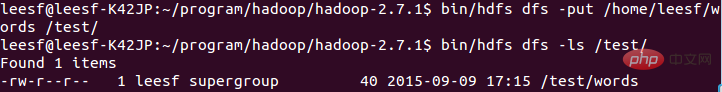

3.将本地words文档上传到test目录中

使用如下命令进行上传操作:

bin/hdfs dfs -put /home/leesf/words /test/

使用如下命令进行查看

bin/hdfs dfs -ls /test/

结果截图如下:

表示已经将本地的words文档上传到了test目录下了。

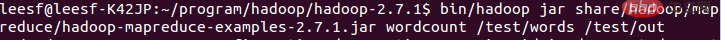

4.运行wordcount

使用如下命令运行wordcount:

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount /test/words /test/out

截图如下:

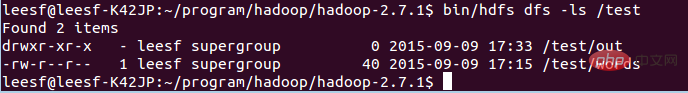

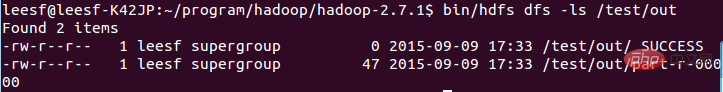

运行完成后,在/test目录下生成名为out的文件,使用如下命令查看/test目录下的文件

bin/hdfs dfs -ls /test

截图如下:

表示在test目录下已经有了一个名为Out的文件目录

输入如下命令查看out目录下的文件:

bin/hdfs dfs -ls /test/out,结果截图如下:

表示已经成功运行了,结果保存在part-r-00000中。

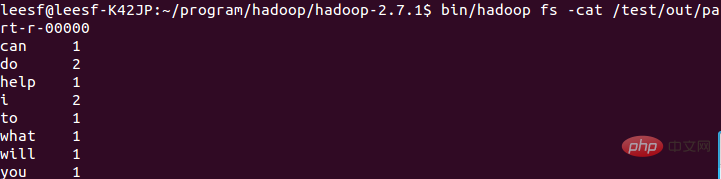

5.查看运行结果

使用如下命令查看运行结果:

bin/hadoop fs -cat /test/out/part-r-00000

结果截图如下:

至此,运行过程就已经完成了。

九、总结

在此次的hadoop配置过程遇到了很多问题,hadoop1.x和2.x的命令还是差别很大的,配置过程中还是一一的解决了问题,配置成功了,收获也很多,特此把这次配置的经验分享出来,也方便想要配置hadoop环境的各位园友,在配置的过程中有任何问题都欢迎讨论,谢谢各位园友的观看~

推荐学习:《linux视频教程》

以上是linux怎么安装hadoop的详细内容。更多信息请关注PHP中文网其他相关文章!

Linux操作:利用维护模式Apr 19, 2025 am 12:08 AM

Linux操作:利用维护模式Apr 19, 2025 am 12:08 AMLinux的维护模式可以通过GRUB菜单进入,具体步骤为:1)在GRUB菜单中选择内核并按'e'编辑,2)在'linux'行末添加'single'或'1',3)按Ctrl X启动。维护模式提供了一个安全环境,适用于系统修复、重置密码和系统升级等任务。

Linux:如何进入恢复模式(和维护)Apr 18, 2025 am 12:05 AM

Linux:如何进入恢复模式(和维护)Apr 18, 2025 am 12:05 AM进入Linux恢复模式的步骤是:1.重启系统并按特定键进入GRUB菜单;2.选择带有(recoverymode)的选项;3.在恢复模式菜单中选择操作,如fsck或root。恢复模式允许你以单用户模式启动系统,进行文件系统检查和修复、编辑配置文件等操作,帮助解决系统问题。

Linux的基本要素:为初学者解释Apr 17, 2025 am 12:08 AM

Linux的基本要素:为初学者解释Apr 17, 2025 am 12:08 AMLinux的核心组件包括内核、文件系统、Shell和常用工具。1.内核管理硬件资源并提供基本服务。2.文件系统组织和存储数据。3.Shell是用户与系统交互的接口。4.常用工具帮助完成日常任务。

Linux:看看其基本结构Apr 16, 2025 am 12:01 AM

Linux:看看其基本结构Apr 16, 2025 am 12:01 AMLinux的基本结构包括内核、文件系统和Shell。1)内核管理硬件资源,使用uname-r查看版本。2)EXT4文件系统支持大文件和日志,使用mkfs.ext4创建。3)Shell如Bash提供命令行交互,使用ls-l列出文件。

Linux操作:系统管理和维护Apr 15, 2025 am 12:10 AM

Linux操作:系统管理和维护Apr 15, 2025 am 12:10 AMLinux系统管理和维护的关键步骤包括:1)掌握基础知识,如文件系统结构和用户管理;2)进行系统监控与资源管理,使用top、htop等工具;3)利用系统日志进行故障排查,借助journalctl等工具;4)编写自动化脚本和任务调度,使用cron工具;5)实施安全管理与防护,通过iptables配置防火墙;6)进行性能优化与最佳实践,调整内核参数和养成良好习惯。

了解Linux的维护模式:必需品Apr 14, 2025 am 12:04 AM

了解Linux的维护模式:必需品Apr 14, 2025 am 12:04 AMLinux维护模式通过在启动时添加init=/bin/bash或single参数进入。1.进入维护模式:编辑GRUB菜单,添加启动参数。2.重新挂载文件系统为读写模式:mount-oremount,rw/。3.修复文件系统:使用fsck命令,如fsck/dev/sda1。4.备份数据并谨慎操作,避免数据丢失。

Debian如何提升Hadoop数据处理速度Apr 13, 2025 am 11:54 AM

Debian如何提升Hadoop数据处理速度Apr 13, 2025 am 11:54 AM本文探讨如何在Debian系统上提升Hadoop数据处理效率。优化策略涵盖硬件升级、操作系统参数调整、Hadoop配置修改以及高效算法和工具的运用。一、硬件资源强化确保所有节点硬件配置一致,尤其关注CPU、内存和网络设备性能。选择高性能硬件组件对于提升整体处理速度至关重要。二、操作系统调优文件描述符和网络连接数:修改/etc/security/limits.conf文件,增加系统允许同时打开的文件描述符和网络连接数上限。JVM参数调整:在hadoop-env.sh文件中调整

Debian syslog如何学习Apr 13, 2025 am 11:51 AM

Debian syslog如何学习Apr 13, 2025 am 11:51 AM本指南将指导您学习如何在Debian系统中使用Syslog。Syslog是Linux系统中用于记录系统和应用程序日志消息的关键服务,它帮助管理员监控和分析系统活动,从而快速识别并解决问题。一、Syslog基础知识Syslog的核心功能包括:集中收集和管理日志消息;支持多种日志输出格式和目标位置(例如文件或网络);提供实时日志查看和过滤功能。二、安装和配置Syslog(使用Rsyslog)Debian系统默认使用Rsyslog。您可以通过以下命令安装:sudoaptupdatesud

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

WebStorm Mac版

好用的JavaScript开发工具

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。