python爬虫能干什么

- silencement原创

- 2019-05-13 14:14:4814720浏览

首先,我们需要知道什么是爬虫!我第一次听到爬虫这个词的时候,就以为是那种爬行的昆虫,想想好可笑...后来才知道,是一种网络上的数据抓取工具!

网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

爬虫可以做什么?

1、模拟浏览器打开网页,获取网页中我们想要的那部分数据。

2、从技术层面来说就是, 通过程序模拟浏览器请求站点的行为,把站点返回的HTML代码/JSON数据/二进制数据(图片、视频) 爬到本地,进而提取自己需要的数据,存放起来使用。

3、如果你仔细观察,就不难发现,懂爬虫、学习爬虫的人越来越多,一方面,互联网可以获取的数据越来越多,另一方面,像 Python这样的编程语言提供越来越多的优秀工具,让爬虫变得简单、容易上手。

4、利用爬虫我们可以获取大量的价值数据,从而获得感性认识中不能得到的信息,比如:

知乎:爬取优质答案,为你筛选出各话题下最优质的内容。

淘宝、京东:抓取商品、评论及销量数据,对各种商品及用户的消费场景进行分析。

安居客、链家:抓取房产买卖及租售信息,分析房价变化趋势、做不同区域的房价分析。

拉勾网、智联:爬取各类职位信息,分析各行业人才需求情况及薪资水平。

雪球网:抓取雪球高回报用户的行为,对股票市场进行分析和预测等等

爬虫的原理是什么?

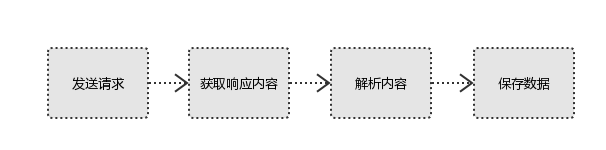

发送请求 > 获取响应内容 > 解析内容 > 保存数据

如上所示,爬取数据的时候就是这个流程,是不是很简单呢?所以用户看到的浏览器的结果就是由 HTML 代码构成的,我们爬虫就是为了获取这些内容,通过分析和过滤 html 代码,从中获取我们想要资源。

相关学习推荐:python教程

以上是python爬虫能干什么的详细内容。更多信息请关注PHP中文网其他相关文章!