从上一篇文章的评论中看出似乎很多童鞋都比较关注爬虫的源代码。所有本文就使用Python编写简单网络爬虫抓取视频下载资源做了很详细的记录,几乎每一步都介绍给大家,希望对大家能有所帮助

我第一次接触爬虫这东西是在今年的5月份,当时写了一个博客搜索引擎,所用到的爬虫也挺智能的,起码比电影来了这个站用到的爬虫水平高多了!

回到用Python写爬虫的话题。

Python一直是我主要使用的脚本语言,没有之一。Python的语言简洁灵活,标准库功能强大,平常可以用作计算器,文本编码转换,图片处理,批量下载,批量处理文本等。总之我很喜欢,也越用越上手,这么好用的一个工具,一般人我不告诉他。。。

因为其强大的字符串处理能力,以及urllib2,cookielib,re,threading这些模块的存在,用Python来写爬虫就简直易于反掌了。简单到什么程度呢。我当时跟某同学说,我写电影来了用到的几个爬虫以及数据整理的一堆零零散散的脚本代码行数总共不超过1000行,写电影来了这个网站也只有150来行代码。因为爬虫的代码在另外一台64位的黑苹果上,所以就不列出来,只列一下VPS上网站的代码,tornadoweb框架写的

[xiaoxia@307232 movie_site]$ wc -l *.py template/* 156 msite.py 92 template/base.html 79 template/category.html 94 template/id.html 47 template/index.html 77 template/search.html

下面直接show一下爬虫的编写流程。以下内容仅供交流学习使用,没有别的意思。

以某湾的最新视频下载资源为例,其网址是

http://某piratebay.se/browse/200

因为该网页里有大量广告,只贴一下正文部分内容:

对于一个python爬虫,下载这个页面的源代码,一行代码足以。这里用到urllib2库。

>>> import urllib2 >>> html = urllib2.urlopen('http://某piratebay.se/browse/200').read() >>> print 'size is', len(html) size is 52977

当然,也可以用os模块里的system函数调用wget命令来下载网页内容,对于掌握了wget或者curl工具的同学是很方便的。

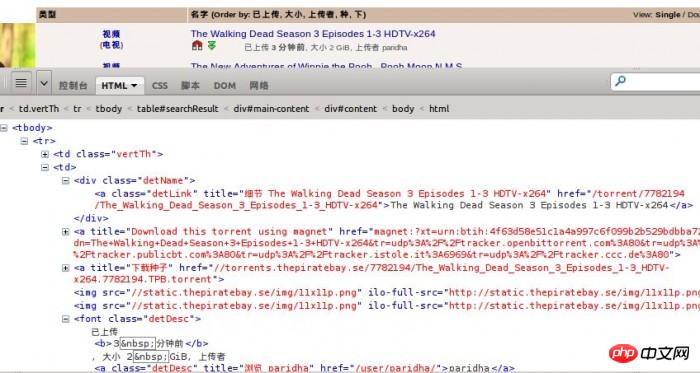

使用Firebug观察网页结构,可以知道正文部分html是一个table。每一个资源就是一个tr标签。

而对于每一个资源,需要提取的信息有:

1、视频分类

2、资源名称

3、资源链接

4、资源大小

5、上传时间

就这么多就够了,如果有需要,还可以增加。

首先提取一段tr标签里的代码来观察一下。

a34de1251f0d9fe1e645927f19a896e8 8e47440c89469104c8c3f33bb60145d0 bacbf9e1ad7f40415ce1670e31edfee3 3c974d76cd4fdd32583e865487b62136视频5db79b134e9f6b82c0b36e0489ee08edff9d32c555bb1d9133a29eb4371c1213 (2ccffcb009524aaa75b7ddf35c5db94d电视5db79b134e9f6b82c0b36e0489ee08ed) adca8a5fa06ffeafb062c2e3f274b930 b90dd5946f0946207856a8a37f441edf b6c5a531a458a2e790c1fd6421739d1c 052c7df367cc8974da2e82006bdcd730 d023f155140b57f58c96a09183955205The Walking Dead Season 3 Episodes 1-3 HDTV-x2645db79b134e9f6b82c0b36e0489ee08ed 94b3e26ee717c64999d7867364b1b4a3 2580b4cb1a9473add7b4ed06cb21ee05395053ae923453c87930d1a240a02c225db79b134e9f6b82c0b36e0489ee08ed 922adc921d802534cde6ece5a0310693e871c0d31f8c34df4f37c4d384bb5ace5db79b134e9f6b82c0b36e0489ee08ed9228a9e7a75ebd4efc8998a6a107060a9228a9e7a75ebd4efc8998a6a107060a a70950187c6783cfd36ab2de44859ec7已上传 a4b561c25d9afb9ac8dc4d70affff4193 分钟前0d36329ec37a2cc24d42c7229b69747a, 大小 2 GiB, 上传者 b1663e90d4b893f12c8366de944ef563paridha5db79b134e9f6b82c0b36e0489ee08ede6e38b3c62e8df885fe2e3986461aa63 b90dd5946f0946207856a8a37f441edf caf04d4128e3590177a696bddab4f33d0b90dd5946f0946207856a8a37f441edf caf04d4128e3590177a696bddab4f33d0b90dd5946f0946207856a8a37f441edf fd273fcf5bcad3dfdad3c41bd81ad3e5

下面用正则表达式来提取html代码中的内容。对正则表达式不了解的同学,可以去 http://docs.python.org/2/library/re.html 了解一下。

为何要用正则表达式而不用其他一些解析HTML或者DOM树的工具是有原因的。我之前试过用BeautifulSoup3来提取内容,后来发觉速度实在是慢死了啊,一秒钟能够处理100个内容,已经是我电脑的极限了。。。而换了正则表达式,编译后处理内容,速度上直接把它秒杀了!

提取这么多内容,我的正则表达式要如何写呢?

根据我以往的经验,“.*?”或者“.+?”这个东西是很好使的。不过也要注意一些小问题,实际用到的时候就会知道

对于上面的tr标签代码,我首先需要让我的表达式匹配到的符号是

a34de1251f0d9fe1e645927f19a896e8

表示内容的开始,当然也可以是别的,只要不要错过需要的内容即可。然后我要匹配的内容是下面这个,获取视频分类。

(989567cf0ff3c13d55bd276878621301电视5db79b134e9f6b82c0b36e0489ee08ed)

接着我要匹配资源链接了,

2be33ec5312054dc0c817731177484b0...5db79b134e9f6b82c0b36e0489ee08ed

再到其他资源信息,

font class="detDesc">已上传 a4b561c25d9afb9ac8dc4d70affff4193 分钟前0d36329ec37a2cc24d42c7229b69747a, 大小 2 GiB, 上传者

最后匹配

fd273fcf5bcad3dfdad3c41bd81ad3e5

大功告成!

当然,最后的匹配可以不需要在正则表达式里表示出来,只要开始位置定位正确了,后面获取信息的位置也就正确了。

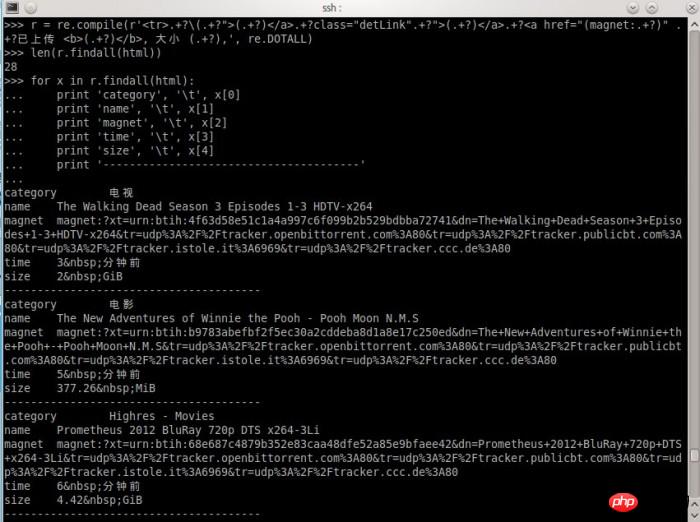

对正则表达式比较了解的朋友,可能知道怎么写了。我Show一下我写的表达式处理过程,

就这么简单,结果出来了,自我感觉挺欢喜的。

当然,这样设计的爬虫是有针对性的,定向爬取某一个站点的内容。也没有任何一个爬虫不会对收集到的链接进行筛选。通常可以使用BFS(宽度优先搜索算法)来爬取一个网站的所有页面链接。

完整的Python爬虫代码,爬取某湾最新的10页视频资源:

# coding: utf8

import urllib2

import re

import pymongo

db = pymongo.Connection().test

url = 'http://某piratebay.se/browse/200/%d/3'

find_re = re.compile(r'<tr>.+?\(.+?">(.+?)</a>.+?class="detLink".+?">(.+?)</a>.+?<a href="(magnet:.+?)" .+?已上传 <b>(.+?)</b>, 大小 (.+?),', re.DOTALL)

# 定向爬去10页最新的视频资源

for i in range(0, 10):

u = url % (i)

# 下载数据

html = urllib2.urlopen(u).read()

# 找到资源信息

for x in find_re.findall(html):

values = dict(

category = x[0],

name = x[1],

magnet = x[2],

time = x[3],

size = x[4]

)

# 保存到数据库

db.priate.save(values)

print 'Done!'以上代码仅供思路展示,实际运行使用到mongodb数据库,同时可能因为无法访问某湾网站而无法得到正常结果。

所以说,电影来了网站用到的爬虫不难写,难的是获得数据后如何整理获取有用信息。例如,如何匹配一个影片信息跟一个资源,如何在影片信息库和视频链接之间建立关联,这些都需要不断尝试各种方法,最后选出比较靠谱的。

曾有某同学发邮件想花钱也要得到我的爬虫的源代码。

要是我真的给了,我的爬虫就几百来行代码,一张A4纸,他不会说,坑爹啊!!!……

都说现在是信息爆炸的时代,所以比的还是谁的数据挖掘能力强

好吧,那么问题来了学习挖掘机(数据)技术到底哪家强?

相关推荐:

以上是Python编写简单网络爬虫抓取视频的详细内容。更多信息请关注PHP中文网其他相关文章!

python中两个列表的串联替代方案是什么?May 09, 2025 am 12:16 AM

python中两个列表的串联替代方案是什么?May 09, 2025 am 12:16 AM可以使用多种方法在Python中连接两个列表:1.使用 操作符,简单但在大列表中效率低;2.使用extend方法,效率高但会修改原列表;3.使用 =操作符,兼具效率和可读性;4.使用itertools.chain函数,内存效率高但需额外导入;5.使用列表解析,优雅但可能过于复杂。选择方法应根据代码上下文和需求。

Python:合并两个列表的有效方法May 09, 2025 am 12:15 AM

Python:合并两个列表的有效方法May 09, 2025 am 12:15 AM有多种方法可以合并Python列表:1.使用 操作符,简单但对大列表不内存高效;2.使用extend方法,内存高效但会修改原列表;3.使用itertools.chain,适用于大数据集;4.使用*操作符,一行代码合并小到中型列表;5.使用numpy.concatenate,适用于大数据集和性能要求高的场景;6.使用append方法,适用于小列表但效率低。选择方法时需考虑列表大小和应用场景。

编译的与解释的语言:优点和缺点May 09, 2025 am 12:06 AM

编译的与解释的语言:优点和缺点May 09, 2025 am 12:06 AMCompiledLanguagesOffersPeedAndSecurity,而interneterpretledlanguages provideeaseafuseanDoctability.1)commiledlanguageslikec arefasterandSecureButhOnderDevevelmendeclementCyclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesclesandentency.2)cransportedeplatectentysenty

Python:对于循环,最完整的指南May 09, 2025 am 12:05 AM

Python:对于循环,最完整的指南May 09, 2025 am 12:05 AMPython中,for循环用于遍历可迭代对象,while循环用于条件满足时重复执行操作。1)for循环示例:遍历列表并打印元素。2)while循环示例:猜数字游戏,直到猜对为止。掌握循环原理和优化技巧可提高代码效率和可靠性。

python concatenate列表到一个字符串中May 09, 2025 am 12:02 AM

python concatenate列表到一个字符串中May 09, 2025 am 12:02 AM要将列表连接成字符串,Python中使用join()方法是最佳选择。1)使用join()方法将列表元素连接成字符串,如''.join(my_list)。2)对于包含数字的列表,先用map(str,numbers)转换为字符串再连接。3)可以使用生成器表达式进行复杂格式化,如','.join(f'({fruit})'forfruitinfruits)。4)处理混合数据类型时,使用map(str,mixed_list)确保所有元素可转换为字符串。5)对于大型列表,使用''.join(large_li

Python的混合方法:编译和解释合并May 08, 2025 am 12:16 AM

Python的混合方法:编译和解释合并May 08, 2025 am 12:16 AMpythonuseshybridapprace,ComminingCompilationTobyTecoDeAndInterpretation.1)codeiscompiledtoplatform-Indepententbybytecode.2)bytecodeisisterpretedbybythepbybythepythonvirtualmachine,增强效率和通用性。

了解python的' for”和' then”循环之间的差异May 08, 2025 am 12:11 AM

了解python的' for”和' then”循环之间的差异May 08, 2025 am 12:11 AMtheKeyDifferencesBetnewpython's“ for”和“ for”和“ loopsare:1)” for“ loopsareIdealForiteringSequenceSquencesSorkNowniterations,而2)”,而“ loopsareBetterforConterContinuingUntilacTientInditionIntionismetismetistismetistwithOutpredefinedInedIterations.un

Python串联列表与重复May 08, 2025 am 12:09 AM

Python串联列表与重复May 08, 2025 am 12:09 AM在Python中,可以通过多种方法连接列表并管理重复元素:1)使用 运算符或extend()方法可以保留所有重复元素;2)转换为集合再转回列表可以去除所有重复元素,但会丢失原有顺序;3)使用循环或列表推导式结合集合可以去除重复元素并保持原有顺序。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

记事本++7.3.1

好用且免费的代码编辑器

螳螂BT

Mantis是一个易于部署的基于Web的缺陷跟踪工具,用于帮助产品缺陷跟踪。它需要PHP、MySQL和一个Web服务器。请查看我们的演示和托管服务。

禅工作室 13.0.1

功能强大的PHP集成开发环境