这篇文章主要介绍了使用 Node.js 对文本内容分词和关键词抽取,需要的朋友可以参考下

在讨论技术前先卖个萌,吃货的世界你不懂~~

众成翻译的文章有 tag,用户可以基于 tag 来快速筛选感兴趣的文章,文章也可以依照 tag 关联来进行相关推荐。但是现在众成翻译的 tag 是在推荐文章的时候设置的,都是英文的,而且人工设置难免不规范和不完全。虽然发布文章后也可以人工编辑,但是我们也不能指望用户或管理员能够时时刻刻编辑出恰当的 tag,所以我们需要用工具来自动生成 tag。

在现在开源的分词工具里面,jieba是一个功能强大性能优越的分词组件,更幸运地是,它有 node 版本。

nodejieba 的安装和使用十分简单:

npm install nodejieba

var nodejieba = require("nodejieba");

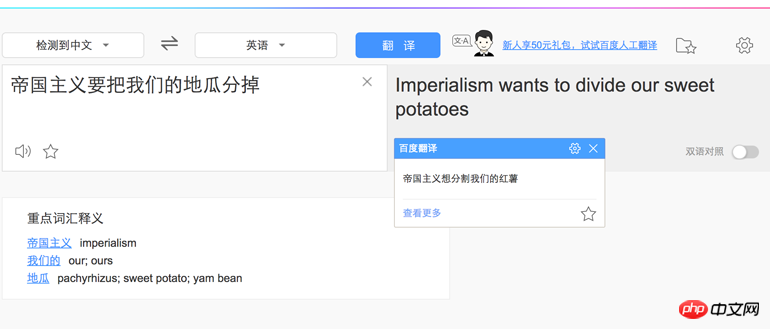

var result = nodejieba.cut("帝国主义要把我们的地瓜分掉");

console.log(result);

//[ '帝国主义', '要', '把', '我们', '的', '地', '瓜分', '掉' ]

result = nodejieba.cut('土地,俺老孙的金箍棒在哪里?');

console.log(result);

//[ '土地', ',', '俺', '老', '孙', '的', '金箍棒', '在', '哪里', '?' ]

result = nodejieba.cut('大圣,您的金箍棒就棒在特别配您的头型!');

console.log(result);

//[ '大圣',',','您','的','金箍棒','就','棒','在','特别','配','您','的','头型','!' ]我们可以载入自己的字典,在字典里给每个词分别设置权重和词性:

编辑 user.uft8

地瓜 9999 n

金箍 9999 n

棒就棒在 9999

然后通过 nodejieba.load 加载字典。

var nodejieba = require("nodejieba");

nodejieba.load({

userDict: './user.utf8',

});

var result = nodejieba.cut("帝国主义要把我们的地瓜分掉");

console.log(result);

//[ '帝国主义', '要', '把', '我们', '的', '地瓜', '分', '掉' ]

result = nodejieba.cut('土地,俺老孙的金箍棒在哪里?');

console.log(result);

//[ '土地', ',', '俺', '老', '孙', '的', '金箍棒', '在', '哪里', '?' ]

result = nodejieba.cut('大圣,您的金箍棒就棒在特别配您的头型!');

console.log(result);

//[ '大圣', ',', '您', '的', '金箍', '棒就棒在', '特别', '配', '您', '的', '头型', '!' ]除了分词以外,我们可以利用 nodejieba 提取关键词:

const content = `

HTTP、HTTP/2与性能优化

本文的目的是通过比较告诉大家,为什么应该从HTTP迁移到HTTPS,以及为什么应该添加到HTTP/2的支持。在比较HTTP和HTTP/2之前,先看看什么是HTTP。

什么是HTTP

HTTP是在万维网上通信的一组规则。HTTP属于应用层协议,跑在TCP/IP层之上。用户通过浏览器请求网页时,HTTP负责处理请求并在Web服务器与客户端之间建立连接。

有了HTTP/2,不使用雪碧图、压缩、拼接,也可以提升性能。然而,这不代表不应该使用这些技术。不过这已经清楚表明了我们从HTTP/1.1移动到HTTP/2的必要性。

`;

const nodejieba = require("nodejieba");

const result = nodejieba.extract(content, 20);

console.log(result);输出的结果类似下面这样:

[ { word: 'HTTP', weight: 140.8704516850025 },

{ word: '请求', weight: 14.23018001394 },

{ word: '应该', weight: 14.052171126120001 },

{ word: '万维网', weight: 12.2912397395 },

{ word: 'TCP', weight: 11.739204307083542 },

{ word: '1.1', weight: 11.739204307083542 },

{ word: 'Web', weight: 11.739204307083542 },

{ word: '雪碧图', weight: 11.739204307083542 },

{ word: 'HTTPS', weight: 11.739204307083542 },

{ word: 'IP', weight: 11.739204307083542 },

{ word: '应用层', weight: 11.2616203224 },

{ word: '客户端', weight: 11.1926274509 },

{ word: '浏览器', weight: 10.8561552143 },

{ word: '拼接', weight: 9.85762638414 },

{ word: '比较', weight: 9.5435285574 },

{ word: '网页', weight: 9.53122979951 },

{ word: '服务器', weight: 9.41204128224 },

{ word: '使用', weight: 9.03259988558 },

{ word: '必要性', weight: 8.81927328699 },

{ word: '添加', weight: 8.0484751722 } ]我们添加一些新的关键词到字典里:

性能

HTTP/2

输出结果如下:

[ { word: 'HTTP', weight: 105.65283876375187 },

{ word: 'HTTP/2', weight: 58.69602153541771 },

{ word: '请求', weight: 14.23018001394 },

{ word: '应该', weight: 14.052171126120001 },

{ word: '性能', weight: 12.61259281884 },

{ word: '万维网', weight: 12.2912397395 },

{ word: 'IP', weight: 11.739204307083542 },

{ word: 'HTTPS', weight: 11.739204307083542 },

{ word: '1.1', weight: 11.739204307083542 },

{ word: 'TCP', weight: 11.739204307083542 },

{ word: 'Web', weight: 11.739204307083542 },

{ word: '雪碧图', weight: 11.739204307083542 },

{ word: '应用层', weight: 11.2616203224 },

{ word: '客户端', weight: 11.1926274509 },

{ word: '浏览器', weight: 10.8561552143 },

{ word: '拼接', weight: 9.85762638414 },

{ word: '比较', weight: 9.5435285574 },

{ word: '网页', weight: 9.53122979951 },

{ word: '服务器', weight: 9.41204128224 },

{ word: '使用', weight: 9.03259988558 } ]在这个基础上,我们采用白名单的方式过滤出一些可以作为 tag 的词:

const content = `

HTTP、HTTP/2与性能优化

本文的目的是通过比较告诉大家,为什么应该从HTTP迁移到HTTPS,以及为什么应该添加到HTTP/2的支持。在比较HTTP和HTTP/2之前,先看看什么是HTTP。

什么是HTTP

HTTP是在万维网上通信的一组规则。HTTP属于应用层协议,跑在TCP/IP层之上。用户通过浏览器请求网页时,HTTP负责处理请求并在Web服务器与客户端之间建立连接。

有了HTTP/2,不使用雪碧图、压缩、拼接,也可以提升性能。然而,这不代表不应该使用这些技术。不过这已经清楚表明了我们从HTTP/1.1移动到HTTP/2的必要性。

`;

const nodejieba = require("nodejieba");

nodejieba.load({

userDict: './user.utf8',

});

const result = nodejieba.extract(content, 20);

const tagList = ['HTTPS', 'HTTP', 'HTTP/2', 'Web', '浏览器', '性能'];

console.log(result.filter(item => tagList.indexOf(item.word) >= 0));最后得到:

[ { word: 'HTTP', weight: 105.65283876375187 },

{ word: 'HTTP/2', weight: 58.69602153541771 },

{ word: '性能', weight: 12.61259281884 },

{ word: 'HTTPS', weight: 11.739204307083542 },

{ word: 'Web', weight: 11.739204307083542 },

{ word: '浏览器', weight: 10.8561552143 } ]这就是我们想要的结果。

以上就是分词库 nodejieba 基本的使用方法,在将来我们可以利用它对众成翻译发布的译文自动分析添加相应的 tag,以为各位译者和读者提供更好的用户体验。

以上是如何使用Node.js对文本内容分词以及关键词抽取的详解的详细内容。更多信息请关注PHP中文网其他相关文章!

超越浏览器:现实世界中的JavaScriptApr 12, 2025 am 12:06 AM

超越浏览器:现实世界中的JavaScriptApr 12, 2025 am 12:06 AMJavaScript在现实世界中的应用包括服务器端编程、移动应用开发和物联网控制:1.通过Node.js实现服务器端编程,适用于高并发请求处理。2.通过ReactNative进行移动应用开发,支持跨平台部署。3.通过Johnny-Five库用于物联网设备控制,适用于硬件交互。

使用Next.js(后端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:23 AM

使用Next.js(后端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:23 AM我使用您的日常技术工具构建了功能性的多租户SaaS应用程序(一个Edtech应用程序),您可以做同样的事情。 首先,什么是多租户SaaS应用程序? 多租户SaaS应用程序可让您从唱歌中为多个客户提供服务

如何使用Next.js(前端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:22 AM

如何使用Next.js(前端集成)构建多租户SaaS应用程序Apr 11, 2025 am 08:22 AM本文展示了与许可证确保的后端的前端集成,并使用Next.js构建功能性Edtech SaaS应用程序。 前端获取用户权限以控制UI的可见性并确保API要求遵守角色库

JavaScript:探索网络语言的多功能性Apr 11, 2025 am 12:01 AM

JavaScript:探索网络语言的多功能性Apr 11, 2025 am 12:01 AMJavaScript是现代Web开发的核心语言,因其多样性和灵活性而广泛应用。1)前端开发:通过DOM操作和现代框架(如React、Vue.js、Angular)构建动态网页和单页面应用。2)服务器端开发:Node.js利用非阻塞I/O模型处理高并发和实时应用。3)移动和桌面应用开发:通过ReactNative和Electron实现跨平台开发,提高开发效率。

JavaScript的演变:当前的趋势和未来前景Apr 10, 2025 am 09:33 AM

JavaScript的演变:当前的趋势和未来前景Apr 10, 2025 am 09:33 AMJavaScript的最新趋势包括TypeScript的崛起、现代框架和库的流行以及WebAssembly的应用。未来前景涵盖更强大的类型系统、服务器端JavaScript的发展、人工智能和机器学习的扩展以及物联网和边缘计算的潜力。

神秘的JavaScript:它的作用以及为什么重要Apr 09, 2025 am 12:07 AM

神秘的JavaScript:它的作用以及为什么重要Apr 09, 2025 am 12:07 AMJavaScript是现代Web开发的基石,它的主要功能包括事件驱动编程、动态内容生成和异步编程。1)事件驱动编程允许网页根据用户操作动态变化。2)动态内容生成使得页面内容可以根据条件调整。3)异步编程确保用户界面不被阻塞。JavaScript广泛应用于网页交互、单页面应用和服务器端开发,极大地提升了用户体验和跨平台开发的灵活性。

Python还是JavaScript更好?Apr 06, 2025 am 12:14 AM

Python还是JavaScript更好?Apr 06, 2025 am 12:14 AMPython更适合数据科学和机器学习,JavaScript更适合前端和全栈开发。 1.Python以简洁语法和丰富库生态着称,适用于数据分析和Web开发。 2.JavaScript是前端开发核心,Node.js支持服务器端编程,适用于全栈开发。

如何安装JavaScript?Apr 05, 2025 am 12:16 AM

如何安装JavaScript?Apr 05, 2025 am 12:16 AMJavaScript不需要安装,因为它已内置于现代浏览器中。你只需文本编辑器和浏览器即可开始使用。1)在浏览器环境中,通过标签嵌入HTML文件中运行。2)在Node.js环境中,下载并安装Node.js后,通过命令行运行JavaScript文件。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

Dreamweaver Mac版

视觉化网页开发工具

螳螂BT

Mantis是一个易于部署的基于Web的缺陷跟踪工具,用于帮助产品缺陷跟踪。它需要PHP、MySQL和一个Web服务器。请查看我们的演示和托管服务。

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具