摘要:数据的价值被挖掘出来之前,先要通过收集、存储、分析计算等过程,获得全面、准确的数据是数据价值挖掘的基础。本期CSDN云计算俱乐部“大数据故事”将从最为常见的数据搜集方式说起——RSS和搜索引擎爬虫。

12月30日,CSDN云计算俱乐部活动在3W咖啡举行,活动主题是“RSS与爬虫:大数据的故事——从如何搜集数据开始”。数据的价值被挖掘出来之前,先要通过收集、存储、分析计算等过程,获得全面、准确的数据是数据价值挖掘的基础。也许当下数据并不能为企业或组织带来实际价值,但作为有远见的决策者应该意识到,应尽早收集、保存重要数据,数据就是财富。本期“大数据故事”将从最为常见的数据搜集方式说起——RSS和搜索引擎爬虫。

活动现场座无虚席

首先,北京万方软件股份有限公司图书馆事业部总经理崔克俊分享的主题是“大规模进行RSS聚合和网站下载在科学研究中的初步应用”。崔克俊在图书馆、情报行业从业12年,有丰富的数据采集经验,他主要分享了信息聚合的一种重要方式RSS及其实现技术。

RSS(Really Simple Syndication)是一种消息来源格式规范,用以聚合经常发布更新数据的网站,例如博客文章、新闻、音频或视频的网摘。RSS文件包含了全文或是节录的文字,再加上发用者所订阅之网摘布数据和授权的元数据。

对某一行业密切相关的几百个甚至几千个RSS种子进行的聚合,将能快速、全面了解某一行的最新动态;对某一行业的的几十个甚至几百个网站进行完整的数据下载,并进行数据挖掘,将能了解某一主题在该行业发展的来龙去脉。

北京万方软件股份有限公司图书馆事业部总经理 崔克俊

崔克俊以高能物理研究所为例,介绍了RSS在科研院所的应用。 高能物理信息监测对象为全球高能物理同行机构:实验室、行业学会、国际协会、各国主管科研政府机构、重点综合性科学出版物、高能物理试验项目和实验设施。监控的信息类型为:新闻、论文、会议报告、分析评论、预印本、案例研究、多媒体、图书、招聘信息等。

高能物理文献信息所采用最先进的开源内容管理系统 Drupal,开源搜索技术 Apache Solr,以及Google员工开发的能实时订阅新闻的 PubSubHubbub技术和Amazon的 OpenSearch,建立了一套高能物理信息监测系统,有别于传统的RSS订阅和推送,实现了几乎实时的信息抓取和任意关键词、任意类别、复合条件新闻的主动推送。

接下来,崔克俊分享了Drupal、Apache Solr、PubSubHubbub和OpenSearch等技术的使用心得。

接下来,宜搜科技搜索部架构师爬虫组负责人叶顺平带来了题为“网页搜索爬虫时效性系统”的分享,包括时效性系统的主要目标、架构,以及各个子模块的设计方案。

宜搜科技搜索部架构师爬虫组负责人 叶顺平

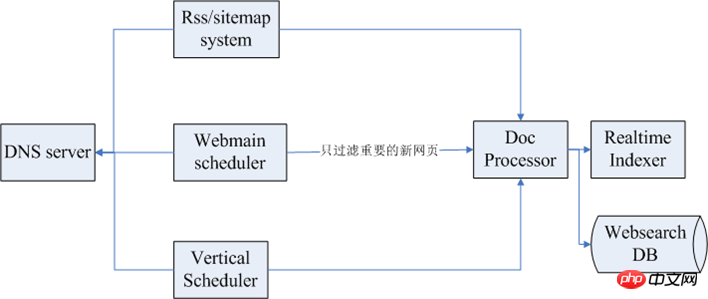

网页爬虫的几个目标是覆盖率高、死链率低和实效性好,爬虫实效性系统的目标也差不多,主要是实现新网页快速和全面的收录。下图为时效性系统的整体架构:

其中,上面第一个是RSS/sitemap一个子系统,接下来是网页泛爬的调度系统Webmain scheduler,然后是一个时效性模块Vertical Scheduler,最左侧是DNS服务,抓取的时候,一般是几十台甚至是几百台的抓取集群,如果每一台都有防御的话对DNS的压力比较大,所以一般有一个DNS的服务模块来做全局的服务。数据抓取完毕后,一般会做后续的数据处理。

涉及到实效性的模块包括以下几个:

RSS/sitemap系统:时效性系统利用RSS/sitemap的过程是挖掘种子,定时抓取,解析链接发布时间,将较新的网页优先抓取并索引。

泛爬系统:泛爬系统设计良好的话有助于提高时效性网页的高覆盖率,但泛爬需要尽可能缩短调度周期。

种子调度系统:主要是一个时效性的种子库,这个种子库里面有一些信息调度系统会不断地扫描这个数据库,然后发给抓取集群,这个集群抓取完会进行一些抽取链接的处理,接下来把这些按类别发出去,各个垂直频道会获取到时效性的数据。

种子的挖掘:涉及到页面解析或其它的一些挖掘手段,可以通过站点地图,还有导航条来构建,还要基于页面结构特征和页面变更规律。

种子的更新机制:记录每个种子的抓取历史,follow的链接信息,定期根据种子的外链更新特征,重新计算种子的更新周期。

抓取系统与JavaScript解析:使用浏览器进行抓取,搭建一个基于浏览器抓取的抓取集群。或采用开源项目,如Qtwebkit。

以上是RSS与爬虫,如何搜集数据详解的详细内容。更多信息请关注PHP中文网其他相关文章!

XML在RSS中的作用:联合内容的基础Apr 12, 2025 am 12:17 AM

XML在RSS中的作用:联合内容的基础Apr 12, 2025 am 12:17 AMXML在RSS中的核心作用是提供一种标准化和灵活的数据格式。1.XML的结构和标记语言特性使其适合数据交换和存储。2.RSS利用XML创建标准化格式,方便内容共享。3.XML在RSS中的应用包括定义feed内容的元素,如标题和发布日期。4.优势包括标准化和可扩展性,挑战包括文件冗长和严格语法要求。5.最佳实践包括验证XML有效性、保持简洁、使用CDATA和定期更新。

从XML到可读的内容:揭开RSS feed的神秘面纱Apr 11, 2025 am 12:03 AM

从XML到可读的内容:揭开RSS feed的神秘面纱Apr 11, 2025 am 12:03 AMrssfeedsarexmldocuments usedforcontentAggregation and distribution.totransformthemintoreadableContent:1)parsethethexmlusinglibrarieslibrariesliblarieslikeparserinparserinpython.2)andledifferentifferentrssssssssssssssssssssssssssssssssssssssssssssssersions andpotentionparsingrorS.3)

是否有基于JSON的RSS替代方案?Apr 10, 2025 am 09:31 AM

是否有基于JSON的RSS替代方案?Apr 10, 2025 am 09:31 AMJSONFeed是一种基于JSON的RSS替代方案,其优势在于简洁性和易用性。1)JSONFeed使用JSON格式,易于生成和解析。2)它支持动态生成,适用于现代Web开发。3)使用JSONFeed可以提升内容管理效率和用户体验。

RSS文档工具:构建,验证和发布提要Apr 09, 2025 am 12:10 AM

RSS文档工具:构建,验证和发布提要Apr 09, 2025 am 12:10 AM如何构建、验证和发布RSSfeeds?1.构建:使用Python脚本生成RSSfeed,包含标题、链接、描述和发布日期。2.验证:使用FeedValidator.org或Python脚本检查RSSfeed是否符合RSS2.0标准。3.发布:将RSS文件上传到服务器,或使用Flask动态生成并发布RSSfeed。通过这些步骤,你可以有效管理和分享内容。

确保您的XML/RSS提要:全面的安全清单Apr 08, 2025 am 12:06 AM

确保您的XML/RSS提要:全面的安全清单Apr 08, 2025 am 12:06 AM确保XML/RSSfeeds安全性的方法包括:1.数据验证,2.加密传输,3.访问控制,4.日志和监控。这些措施通过网络安全协议、数据加密算法和访问控制机制来保护数据的完整性和机密性。

XML/RSS面试问题和答案:提高您的专业知识Apr 07, 2025 am 12:19 AM

XML/RSS面试问题和答案:提高您的专业知识Apr 07, 2025 am 12:19 AMXML是一种标记语言,用于存储和传输数据,RSS是一种基于XML的格式,用于发布频繁更新的内容。1)XML通过标签和属性描述数据结构,2)RSS定义特定标签发布和订阅内容,3)使用Python的xml.etree.ElementTree模块可以创建和解析XML,4)XPath表达式可查询XML节点,5)feedparser库可解析RSSfeed,6)常见错误包括标签不匹配和编码问题,可用xmllint验证,7)使用SAX解析器处理大型XML文件可优化性能。

高级XML/RSS教程:ACE您的下一次技术采访Apr 06, 2025 am 12:12 AM

高级XML/RSS教程:ACE您的下一次技术采访Apr 06, 2025 am 12:12 AMXML是一种用于数据存储和交换的标记语言,RSS是基于XML的格式,用于发布更新内容。1.XML定义数据结构,适合数据交换和存储。2.RSS用于内容订阅,解析时使用专门库。3.解析XML可使用DOM或SAX,生成XML和RSS需正确设置元素和属性。

从XML/RSS到JSON:现代数据转换策略Apr 05, 2025 am 12:08 AM

从XML/RSS到JSON:现代数据转换策略Apr 05, 2025 am 12:08 AM使用Python可以从XML/RSS转换到JSON。1)解析源数据,2)提取字段,3)转换为JSON,4)输出JSON。使用xml.etree.ElementTree和feedparser库解析XML/RSS,使用json库生成JSON数据。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

记事本++7.3.1

好用且免费的代码编辑器

Dreamweaver Mac版

视觉化网页开发工具

SublimeText3 Linux新版

SublimeText3 Linux最新版