百度贴吧的爬虫制作和糗百的爬虫制作原理基本相同,都是通过查看源码扣出关键数据,然后将其存储到本地txt文件。

源码下载:

http://download.csdn.net/detail/wxg694175346/6925583

项目内容:

用Python写的百度贴吧的网络爬虫。

使用方法:

新建一个BugBaidu.py文件,然后将代码复制到里面后,双击运行。

程序功能:

将贴吧中楼主发布的内容打包txt存储到本地。

原理解释:

首先,先浏览一下某一条贴吧,点击只看楼主并点击第二页之后url发生了一点变化,变成了:

http://tieba.baidu.com/p/2296712428?see_lz=1&pn=1

可以看出来,see_lz=1是只看楼主,pn=1是对应的页码,记住这一点为以后的编写做准备。

这就是我们需要利用的url。

接下来就是查看页面源码。

首先把题目抠出来存储文件的时候会用到。

可以看到百度使用gbk编码,标题使用h1标记:

<h1 class="core_title_txt" title="【原创】时尚首席(关于时尚,名利,事业,爱情,励志)">【原创】时尚首席(关于时尚,名利,事业,爱情,励志)</h1>

同样,正文部分用div和class综合标记,接下来要做的只是用正则表达式来匹配即可。

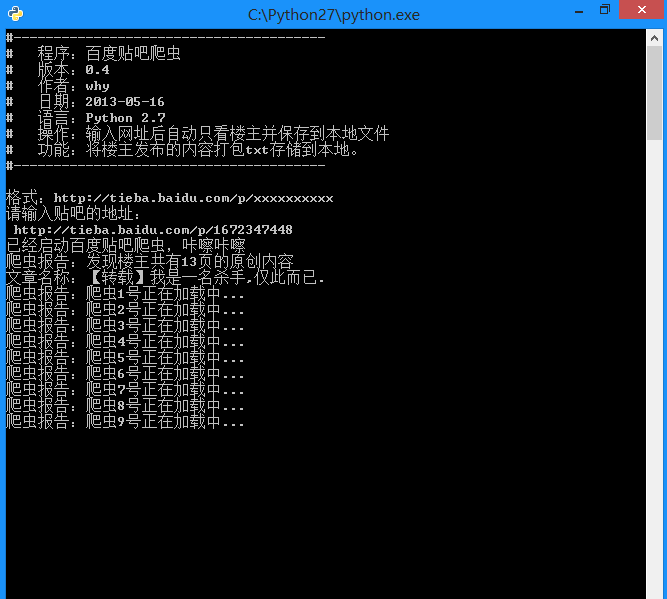

运行截图:

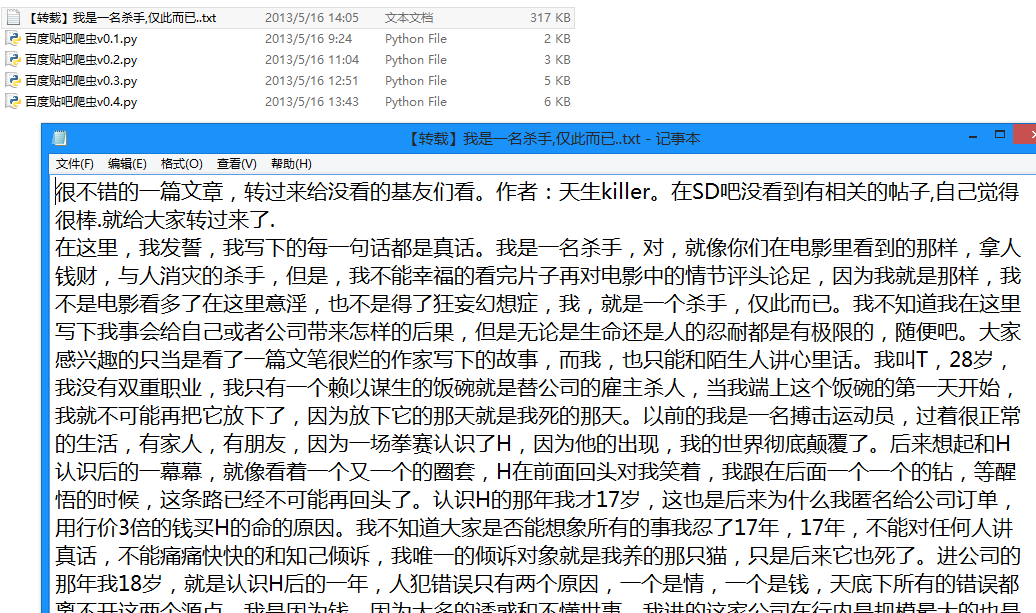

生成的txt文件:

# -*- coding: utf-8 -*-

#---------------------------------------

# 程序:百度贴吧爬虫

# 版本:0.5

# 作者:why

# 日期:2013-05-16

# 语言:Python 2.7

# 操作:输入网址后自动只看楼主并保存到本地文件

# 功能:将楼主发布的内容打包txt存储到本地。

#---------------------------------------

import string

import urllib2

import re

#----------- 处理页面上的各种标签 -----------

class HTML_Tool:

# 用非 贪婪模式 匹配 \t 或者 \n 或者 空格 或者 超链接 或者 图片

BgnCharToNoneRex = re.compile("(\t|\n| |<a.*?>|<img.*?>)")

# 用非 贪婪模式 匹配 任意<>标签

EndCharToNoneRex = re.compile("<.*?>")

# 用非 贪婪模式 匹配 任意<p>标签

BgnPartRex = re.compile("<p.*?>")

CharToNewLineRex = re.compile("(<br/>|</p>|<tr>|<div>|</div>)")

CharToNextTabRex = re.compile("<td>")

# 将一些html的符号实体转变为原始符号

replaceTab = [("<","<"),(">",">"),("&","&"),("&","\""),(" "," ")]

def Replace_Char(self,x):

x = self.BgnCharToNoneRex.sub("",x)

x = self.BgnPartRex.sub("\n ",x)

x = self.CharToNewLineRex.sub("\n",x)

x = self.CharToNextTabRex.sub("\t",x)

x = self.EndCharToNoneRex.sub("",x)

for t in self.replaceTab:

x = x.replace(t[0],t[1])

return x

class Baidu_Spider:

# 申明相关的属性

def __init__(self,url):

self.myUrl = url + '?see_lz=1'

self.datas = []

self.myTool = HTML_Tool()

print u'已经启动百度贴吧爬虫,咔嚓咔嚓'

# 初始化加载页面并将其转码储存

def baidu_tieba(self):

# 读取页面的原始信息并将其从gbk转码

myPage = urllib2.urlopen(self.myUrl).read().decode("gbk")

# 计算楼主发布内容一共有多少页

endPage = self.page_counter(myPage)

# 获取该帖的标题

title = self.find_title(myPage)

print u'文章名称:' + title

# 获取最终的数据

self.save_data(self.myUrl,title,endPage)

#用来计算一共有多少页

def page_counter(self,myPage):

# 匹配 "共有<span class="red">12</span>页" 来获取一共有多少页

myMatch = re.search(r'class="red">(\d+?)</span>', myPage, re.S)

if myMatch:

endPage = int(myMatch.group(1))

print u'爬虫报告:发现楼主共有%d页的原创内容' % endPage

else:

endPage = 0

print u'爬虫报告:无法计算楼主发布内容有多少页!'

return endPage

# 用来寻找该帖的标题

def find_title(self,myPage):

# 匹配 <h1 class="core_title_txt" title="">xxxxxxxxxx</h1> 找出标题

myMatch = re.search(r'<h1.*?>(.*?)</h1>', myPage, re.S)

title = u'暂无标题'

if myMatch:

title = myMatch.group(1)

else:

print u'爬虫报告:无法加载文章标题!'

# 文件名不能包含以下字符: \ / : * ? " < > |

title = title.replace('\\','').replace('/','').replace(':','').replace('*','').replace('?','').replace('"','').replace('>','').replace('<','').replace('|','')

return title

# 用来存储楼主发布的内容

def save_data(self,url,title,endPage):

# 加载页面数据到数组中

self.get_data(url,endPage)

# 打开本地文件

f = open(title+'.txt','w+')

f.writelines(self.datas)

f.close()

print u'爬虫报告:文件已下载到本地并打包成txt文件'

print u'请按任意键退出...'

raw_input();

# 获取页面源码并将其存储到数组中

def get_data(self,url,endPage):

url = url + '&pn='

for i in range(1,endPage+1):

print u'爬虫报告:爬虫%d号正在加载中...' % i

myPage = urllib2.urlopen(url + str(i)).read()

# 将myPage中的html代码处理并存储到datas里面

self.deal_data(myPage.decode('gbk'))

# 将内容从页面代码中抠出来

def deal_data(self,myPage):

myItems = re.findall('id="post_content.*?>(.*?)</div>',myPage,re.S)

for item in myItems:

data = self.myTool.Replace_Char(item.replace("\n","").encode('gbk'))

self.datas.append(data+'\n')

#-------- 程序入口处 ------------------

print u"""#---------------------------------------

# 程序:百度贴吧爬虫

# 版本:0.5

# 作者:why

# 日期:2013-05-16

# 语言:Python 2.7

# 操作:输入网址后自动只看楼主并保存到本地文件

# 功能:将楼主发布的内容打包txt存储到本地。

#---------------------------------------

"""

# 以某小说贴吧为例子

# bdurl = 'http://tieba.baidu.com/p/2296712428?see_lz=1&pn=1'

print u'请输入贴吧的地址最后的数字串:'

bdurl = 'http://tieba.baidu.com/p/' + str(raw_input(u'http://tieba.baidu.com/p/'))

#调用

mySpider = Baidu_Spider(bdurl)

mySpider.baidu_tieba()以上就是 [Python]网络爬虫(九):百度贴吧的网络爬虫(v0.4)源码及解析的内容,更多相关内容请关注PHP中文网(www.php.cn)!

Python vs. C:了解关键差异Apr 21, 2025 am 12:18 AM

Python vs. C:了解关键差异Apr 21, 2025 am 12:18 AMPython和C 各有优势,选择应基于项目需求。1)Python适合快速开发和数据处理,因其简洁语法和动态类型。2)C 适用于高性能和系统编程,因其静态类型和手动内存管理。

Python vs.C:您的项目选择哪种语言?Apr 21, 2025 am 12:17 AM

Python vs.C:您的项目选择哪种语言?Apr 21, 2025 am 12:17 AM选择Python还是C 取决于项目需求:1)如果需要快速开发、数据处理和原型设计,选择Python;2)如果需要高性能、低延迟和接近硬件的控制,选择C 。

达到python目标:每天2小时的力量Apr 20, 2025 am 12:21 AM

达到python目标:每天2小时的力量Apr 20, 2025 am 12:21 AM通过每天投入2小时的Python学习,可以有效提升编程技能。1.学习新知识:阅读文档或观看教程。2.实践:编写代码和完成练习。3.复习:巩固所学内容。4.项目实践:应用所学于实际项目中。这样的结构化学习计划能帮助你系统掌握Python并实现职业目标。

最大化2小时:有效的Python学习策略Apr 20, 2025 am 12:20 AM

最大化2小时:有效的Python学习策略Apr 20, 2025 am 12:20 AM在两小时内高效学习Python的方法包括:1.回顾基础知识,确保熟悉Python的安装和基本语法;2.理解Python的核心概念,如变量、列表、函数等;3.通过使用示例掌握基本和高级用法;4.学习常见错误与调试技巧;5.应用性能优化与最佳实践,如使用列表推导式和遵循PEP8风格指南。

在Python和C之间进行选择:适合您的语言Apr 20, 2025 am 12:20 AM

在Python和C之间进行选择:适合您的语言Apr 20, 2025 am 12:20 AMPython适合初学者和数据科学,C 适用于系统编程和游戏开发。1.Python简洁易用,适用于数据科学和Web开发。2.C 提供高性能和控制力,适用于游戏开发和系统编程。选择应基于项目需求和个人兴趣。

Python与C:编程语言的比较分析Apr 20, 2025 am 12:14 AM

Python与C:编程语言的比较分析Apr 20, 2025 am 12:14 AMPython更适合数据科学和快速开发,C 更适合高性能和系统编程。1.Python语法简洁,易于学习,适用于数据处理和科学计算。2.C 语法复杂,但性能优越,常用于游戏开发和系统编程。

每天2小时:Python学习的潜力Apr 20, 2025 am 12:14 AM

每天2小时:Python学习的潜力Apr 20, 2025 am 12:14 AM每天投入两小时学习Python是可行的。1.学习新知识:用一小时学习新概念,如列表和字典。2.实践和练习:用一小时进行编程练习,如编写小程序。通过合理规划和坚持不懈,你可以在短时间内掌握Python的核心概念。

Python与C:学习曲线和易用性Apr 19, 2025 am 12:20 AM

Python与C:学习曲线和易用性Apr 19, 2025 am 12:20 AMPython更易学且易用,C 则更强大但复杂。1.Python语法简洁,适合初学者,动态类型和自动内存管理使其易用,但可能导致运行时错误。2.C 提供低级控制和高级特性,适合高性能应用,但学习门槛高,需手动管理内存和类型安全。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

Dreamweaver Mac版

视觉化网页开发工具

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中