我们把这两个函数封装到一个FileReaderWriter.java文件中以便后续使用。

接着我们回到知乎爬虫中。

我们需要给知乎的Zhihu封装类加个函数,用来格式化写入到本地时的排版。

代码如下:

public String writeString() {

String result = "";

result += "问题:" + question + "\r\n";

result += "描述:" + questionDescription + "\r\n";

result += "链接:" + zhihuUrl + "\r\n";

for (int i = 0; i < answers.size(); i++) {

result += "回答" + i + ":" + answers.get(i) + "\r\n";

}

result += "\r\n\r\n";

return result;

}OK,这样就差不多了,接下来吧mian方法中的System.out.println改成

代码如下:

// 写入本地

for (Zhihu zhihu : myZhihu) {

FileReaderWriter.writeIntoFile(zhihu.writeString(),

"D:/知乎_编辑推荐.txt", true);

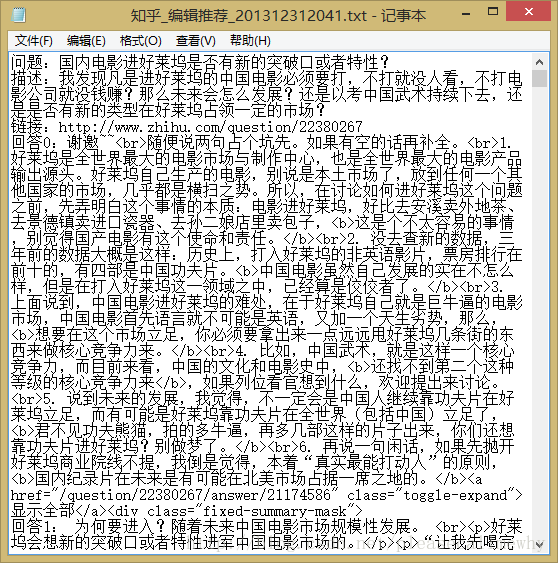

}运行,便可以看到本来在控制台看到的内容已经被写到了本地的txt文件里:

大体一看没什么问题,仔细看看发现问题:存在太多的html标签,主要是a4b561c25d9afb9ac8dc4d70affff419和0c6dc11e160d3b678d68754cc175188a。

我们可以在输出的时候对这些标记进行处理。

先把0c6dc11e160d3b678d68754cc175188a换成io流里面的\r\n,再把所有的html标签都删除,这样看起来便会清晰很多。

代码如下:

public String writeString() {

// 拼接写入本地的字符串

String result = "";

result += "问题:" + question + "\r\n";

result += "描述:" + questionDescription + "\r\n";

result += "链接:" + zhihuUrl + "\r\n";

for (int i = 0; i < answers.size(); i++) {

result += "回答" + i + ":" + answers.get(i) + "\r\n\r\n";

}

result += "\r\n\r\n\r\n\r\n";

// 将其中的html标签进行筛选

result = result.replaceAll("<br>", "\r\n");

result = result.replaceAll("<.*?>", "");

return result;

}这里的replaceAll函数可以使用正则,于是所有的a8093152e673feb7aba1828c43532094标签在最后就都被删除了。

以上就是零基础写Java知乎爬虫之将抓取的内容存储到本地(2)的内容,更多相关内容请关注PHP中文网(www.php.cn)!

在Java应用程序中缓解平台特定问题的策略是什么?May 01, 2025 am 12:20 AM

在Java应用程序中缓解平台特定问题的策略是什么?May 01, 2025 am 12:20 AMJava如何缓解平台特定的问题?Java通过JVM和标准库来实现平台无关性。1)使用字节码和JVM抽象操作系统差异;2)标准库提供跨平台API,如Paths类处理文件路径,Charset类处理字符编码;3)实际项目中使用配置文件和多平台测试来优化和调试。

Java的平台独立性与微服务体系结构之间有什么关系?May 01, 2025 am 12:16 AM

Java的平台独立性与微服务体系结构之间有什么关系?May 01, 2025 am 12:16 AMjava'splatformentenceenhancesenhancesmicroservicesharchitecture byferingDeploymentFlexible,一致性,可伸缩性和便携性。1)DeploymentFlexibilityAllowsibilityAllowsOllowsOllowSorlowsOllowsOllowsOllowSeStorunonAnyPlatformwithajvM.2)penterencyCrossServAccAcrossServAcrossServiCessImplifififiesDeevelopmentandeDe

GRAALVM与Java的平台独立目标有何关系?May 01, 2025 am 12:14 AM

GRAALVM与Java的平台独立目标有何关系?May 01, 2025 am 12:14 AMGraalVM通过三种方式增强了Java的平台独立性:1.跨语言互操作,允许Java与其他语言无缝互操作;2.独立的运行时环境,通过GraalVMNativeImage将Java程序编译成本地可执行文件;3.性能优化,Graal编译器生成高效的机器码,提升Java程序的性能和一致性。

您如何测试Java应用程序的平台兼容性?May 01, 2025 am 12:09 AM

您如何测试Java应用程序的平台兼容性?May 01, 2025 am 12:09 AM效率testjavaapplicationsforplatformcompatibility oftheSesteps:1)setUpautomatedTestingTestingActingAcrossMultPlatFormSusingCitoolSlikeSlikeJenkinSorgithUbactions.2)contuctualtemualtemalualTesteTESTENRETESTINGINREALHARTWARETOLEALHARDOELHARDOLEATOCATCHISSUSESUSEUSENINCIENVIRENTMENTS.3)schictcross.3)schoscross.3)

Java编译器(Javac)在实现平台独立性中的作用是什么?May 01, 2025 am 12:06 AM

Java编译器(Javac)在实现平台独立性中的作用是什么?May 01, 2025 am 12:06 AMJava编译器通过将源代码转换为平台无关的字节码,实现了Java的平台独立性,使得Java程序可以在任何安装了JVM的操作系统上运行。

在平台独立性的平台独立性上使用字节码优于本机代码的优点是什么?Apr 30, 2025 am 12:24 AM

在平台独立性的平台独立性上使用字节码优于本机代码的优点是什么?Apr 30, 2025 am 12:24 AMByteCodeachievesPlatFormIndenceByByByByByByExecutedBoviratualMachine(VM),允许CodetorunonanyplatformwithTheApprepreprepvm.Forexample,Javabytecodecodecodecodecanrunonanydevicewithajvm

Java真的100%独立于平台吗?为什么或为什么不呢?Apr 30, 2025 am 12:18 AM

Java真的100%独立于平台吗?为什么或为什么不呢?Apr 30, 2025 am 12:18 AMJava不能做到100%的平台独立性,但其平台独立性通过JVM和字节码实现,确保代码在不同平台上运行。具体实现包括:1.编译成字节码;2.JVM的解释执行;3.标准库的一致性。然而,JVM实现差异、操作系统和硬件差异以及第三方库的兼容性可能影响其平台独立性。

Java的平台独立性如何支持代码可维护性?Apr 30, 2025 am 12:15 AM

Java的平台独立性如何支持代码可维护性?Apr 30, 2025 am 12:15 AMJava通过“一次编写,到处运行”实现平台独立性,提升代码可维护性:1.代码重用性高,减少重复开发;2.维护成本低,只需一处修改;3.团队协作效率高,方便知识共享。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

Dreamweaver CS6

视觉化网页开发工具

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。