LLM模型尺寸的规模超出了技术性。这是一个内在的属性,它决定了这些AIS可以做什么,它们的行为方式,以及最终它们对我们有用。 LLM模型的规模与公司或团队的大小如何影响其功能一样,创造了我们每天与之互动的不同个性和能力,通常没有意识到这一点。

目录

- 了解模型大小:超出数字

- 小型,中等范围

- 跨模型大小的GPU和计算基础架构

- 跨模型大小的上下文窗口注意事项

- 参数大小和资源要求

- 尺寸选择的实际含义

- 模型大小的隐藏尺寸

- 选择合适的尺寸:问这些问题

- 模型尺寸的未来

- 结论

- 常见问题

了解模型大小:超出数字

LLMS中的模型大小通常以参数进行测量,即模型在训练过程中所学的可调节值。但是,仅考虑参数就像仅根据其身高或体重来判断一个人一样,它仅讲述了故事的一部分。

理解模型大小的更好方法是将其视为AI的“神经能力”。就像人类大脑具有数十亿个神经元形成复杂网络的神经元一样,LLM也具有形成能够理解和产生语言的参数。

小型,中等范围

在选择大型语言模型时,大小在确定性能,效率和成本方面起着至关重要的作用。 LLM通常属于小型,中和大类别,每个类别都针对不同的用例进行了优化,从轻巧的应用到复杂的推理任务。

小型型号(1-10b参数)

将小型模型视为具有重点功能的熟练专家:

- 速度冠军:在消耗最低资源的同时,提供非常快速的响应。

- 设备友好:可以在消费者硬件(笔记本电脑,高端手机)上本地运行。

- 值得注意的例子:PHI-2(2.7b),Mistral 7b,Gemma 2b。

- 最佳点:简单的任务,草稿,分类,专业领域。

- 局限性:与复杂的推理,细微的理解和深厚的专业知识斗争。

现实世界中的示例:在笔记本电脑上运行的7B参数模型可以保持您的音调直接电子邮件,但仅提供对量子计算等复杂主题的基本说明。

中型型号(10-70b参数)

中型模型达到了多种应用的多功能性最佳点:

- 平衡表演者:在各种任务中提供良好的深度和广度

- 资源效率:可部署在合理访问的计算环境中

- 著名的例子:骆驼2(70b),克劳德瞬间,米斯特拉尔大

- 最佳点:一般业务应用程序,全面的客户服务,内容创建

- 优点:处理复杂的说明,维持上下文更长的对话

现实世界中的示例:使用13B模型用于客户服务的小型企业将其描述为“有一个新的团队成员,从未睡过” - 在知道何时升级复杂问题的同时,完美地掌握了80%的查询。

大型型号(70b参数)

最大的模型充当具有显着功能的AI多肌。

- 推理强大:通过适当的推理来展示复杂的问题解决和分析思维。

- 细微的理解:掌握微妙的背景,含义和复杂的指示。

- 值得注意的例子:GPT-4,Claude 3.5十四行诗,双子座Ultra(100b参数)

- 最佳点:研究帮助,复杂的创意工作,复杂的分析

- 基础设施要求:需要大量的计算资源和专业的硬件

现实世界中的示例:在一个复杂的研究项目中,虽然较小的模型提供了事实响应,但最大的模型将跨学科的不同思想,建议的新方法和基本假设中的缺陷联系在一起。

另请阅读:哪个O3-MINI推理水平最聪明?

跨模型大小的GPU和计算基础架构

不同的模型大小需要不同水平的GPU功率和计算基础架构。尽管小型型号可以在消费级GPU上运行,但较大的型号需要具有大量并行处理功能的高性能群集。

小型型号(1-10b参数)

- 消费者硬件可行:可以在具有专用GPU(8-16GB VRAM)的高端笔记本电脑上运行

- 内存足迹:通常需要4-20GB的VRAM,具体取决于精度

-

部署选项:

- 单一消费者GPU(RTX 3080)的本地部署

- 具有优化的边缘设备(量化,修剪)

- 可以通过4位量化移动部署

- 成本效率:$ 0.05-0.15/小时的云服务

中型型号(10-70b参数)

- 需要专用硬件:游戏或工作站级GPU必需

- 内存要求:20-80GB的VRAM可完全精确

-

部署选项:

- 带量化的单个高端GPU(A10,RTX 4090)

- 多精度的多GPU设置(2-4个消费者GPU)

- 基于云的部署与中层实例

- 成本效率:$ 0.20-1.00/小时的云服务

大型型号(70b参数)

- 企业级硬件:数据中心GPU或专业AI加速器

- 内存需求:80GB VRAM可用于最佳性能

-

部署选项:

- 并联多个高端GPU(A100,H100)

- 跨多个计算机分布式计算

- 具有优化基础架构的专业AI云服务

- 成本效率:$ 1.50-10.00 /小时的云服务

模型大小对性能的影响

尽管具有数十亿甚至万亿个参数的较大型号可以捕获更复杂的语言关系并处理细微的提示,但它们也需要大量的计算资源。但是,更大并不总是更好。针对特定任务进行微调的较小模型有时可以胜过更大,更广泛的模型。因此,选择适当的模型大小取决于特定的应用程序,可用资源和所需的性能结果。

跨模型大小的上下文窗口注意事项

模型大小和上下文窗口功能之间的关系代表了在简单比较中经常忽略的另一个关键维度:

| 型号大小 | 4K上下文 | 16K上下文 | 32K上下文 | 128K上下文 |

| 小(7b) | 14GB | 28GB | 48GB | 172GB |

| 培养基(40b) | 80GB | 160GB | 280GB | N/A。 |

| 大(175b) | 350GB | 700GB | N/A。 | N/A。 |

该表说明了为什么较小的模型对于需要广泛背景的应用通常更实用。使用长上下文进行合同分析的法律文档系统发现,使用32K上下文窗口运行其7B模型比使用由于内存限制而限于8K上下文的40B模型更可行。

参数大小和资源要求

参数计数与资源需求之间的关系通过提高参数效率的创新继续发展:

- 稀疏的MOE模型:Mixtral 8x7b之类的模型演示了47B有效参数如何提供与密集的70B模型相当的性能,同时需要在推理过程中更接近13B模型的资源。

- 参数有效的微调(PEFT) :诸如Lora和Qlora之类的技术可以自定义大型模型,同时仅更新0.1-1%的参数,从而大大降低了适应性的硬件要求。

- 检索增强的生成(RAG) :通过将知识卸载到外部数据存储中,较小的模型可以在知识密集型任务上与较大的模型相当地执行,从而将资源负担从计算转移到存储。

| 方面 | 小LLM(1-10b) | 中LLM(10-70B) | 大LLM(70b) |

| 示例模型 | PHI-2(2.7b),Mistral 7b,Tinyllama(1.1b) | Llama 2(70b),Claude Instant,Mistral大 | GPT-4,Claude 3.7十四行诗,Palm 2,双子座Ultra |

| 内存要求 | 2-20GB | 20-140GB | 140GB |

| 硬件 | 消费者GPU,高端笔记本电脑 | 多重消费者GPU或服务器级GPU | 多个高端GPU,专门的硬件 |

| 推理成本(每个1M令牌) | $ 0.01- $ 0.20 | $ 0.20- $ 1.00 | $ 1.00- $ 30.00 |

| 本地部署 | 轻松在消费者硬件上 | 通过优化可能 | 通常仅云 |

| 响应延迟 | 非常低(10-50ms) | 中等(50-200ms) | 更高(200ms-1s) |

减少模型尺寸的技术

为了使LLMS更加高效和易于使用,已经开发了几种技术来降低其尺寸而不会显着损害性能:

为了使LLMS更加高效和易于使用,已经开发了几种技术来降低其尺寸而不会显着损害性能:

- 模型蒸馏:此过程涉及培训较小的“学生”模型以复制较大的“老师”模型的行为,从而有效地以更少的参数捕获其功能。

- 参数共享:实现方法,其中使用相同的参数在模型的多个部分中使用,从而减少了唯一参数的总数。

- 量化:将模型的权重从浮点数(例如32位)降低到低位表示(例如8位),从而减少了内存使用情况。

| 技术 | 小LLM(1-10b) | 中LLM(10-70B) | 大LLM(70b) |

| 量化(4位) | 5-15%的质量损失 | 3-10%的质量损失 | 1-5%质量损失 |

| 知识蒸馏 | 中等收益 | 良好的收益 | 出色的收益 |

| 微调 | 高影响力 | 中等影响 | 有限的影响 |

| RLHF | 中等影响 | 高影响力 | 高影响力 |

| 检索增强 | 影响很高 | 高影响力 | 中等影响 |

| 及时的工程 | 有限的影响 | 中等影响 | 高影响力 |

| 上下文窗口扩展 | 有限的好处 | 适度的好处 | 高收益 |

尺寸选择的实际含义

LLM的大小直接影响计算成本,延迟和部署可行性等因素。选择合适的型号大小可确保性能,资源效率和现实世界中的适用性之间保持平衡。

计算要求:隐藏成本

模型大小直接影响计算需求,这是经常被忽略的实际考虑。运行较大的模型就像从自行车升级到跑车一样;您会走得更快,但是燃油消耗会大大增加。

对于上下文,虽然7B参数模型可能会在游戏笔记本电脑上运行,但70B型号通常需要专用的GPU硬件,花费数千美元。最大的100B型号通常需要多个高端GPU或专门的云基础架构。

我与之交谈的开发人员描述了她的经验:“我们从一个完美地满足我们需求的70B型号开始,但是基础设施成本正在消耗我们的利润率。切换到精心调整的13B型号将我们的成本降低了80%,而只会影响性能。”

响应能力折衷

模型大小和响应能力之间存在固有的权衡。较小的模型通常会更快地生成文本,使其更适合需要实时互动的应用。

在最近的AI Hackathon中,一个建立客户服务聊天机器人的团队发现,尽管其出色的答案,但用户却在等待大型型号的响应感到沮丧。他们的解决方案?一种分层的方法 - 使用一个小型模型以立即响应,并无缝地升级为更大的模型以进行复杂查询。

模型大小的隐藏尺寸

除了参数计数之外,模型大小还会影响内存使用情况,推理速度和现实世界中的适用性。了解这些隐藏的维度有助于选择效率和能力之间的正确平衡。

培训数据质量与数量

尽管参数计数引起了人们的关注,但培训数据的质量和多样性通常在模型性能中起着同样重要的作用。经过高质量,特定领域的数据训练的较小模型可以在专业任务中胜过较大的模型。

我在一家法律技术创业公司亲眼目睹了这一第一手,他们的自定义培训的7B型号优于其在合同分析上的大小的三倍。他们的秘密?专门培训彻底审查的法律文件,而不是一般的网络文本。

建筑创新:质量超过数量

现代建筑创新越来越多地证明聪明的设计可以补偿较小的尺寸。诸如Experts(MOE)架构混合物之类的技术允许模型仅激活特定任务的相关参数,从而实现具有较小的计算足迹的大型模型性能。

MOE方法反映了人类如何依靠专门的大脑区域来完成不同的任务。例如,在解决数学问题时,我们不会激活整个大脑,而只是专门用于数值推理的区域。

特定于任务规模要求的出现

随着场的成熟,我们发现不同的认知任务具有不同的参数阈值。研究表明,诸如基本语法和事实回忆之类的能力以相对较小的大小(1-10b参数)出现,而复杂的推理,对上下文的细微理解和创造性产生可能需要大量具有大量参数的模型。

这种能力的逐步出现类似于人类的认知发展,在大脑发育的不同阶段出现了不同的能力。

选择合适的尺寸:问这些问题

在为您的应用程序选择LLM大小时,请考虑:

- 您的用例的复杂性是什么?简单的分类或内容产生可能与较小的型号效果很好。

- 响应时间有多重要?如果您需要实时互动,则可能是较小的型号。

- 有哪些计算资源可用?对您的基础设施约束保持现实。

- 您对错误的容忍度是什么?较大的模型通常会造成更少的事实错误和逻辑错误。

- 您的预算是多少?较大的型号通常成本更高,尤其是在规模上。

模型尺寸的未来

模型尺寸的景观在动态发展。我们目睹了两个看似矛盾的趋势:模型的增长越来越大(关于开发中有数万亿参数模型的谣言),同时通过诸如稀疏,蒸馏和量化等技术变得更加有效。

这反映了我们在整个计算历史记录中都看到的模式 - 功能在硬件需求缩小时增长。今天的智能手机优于过去几十年来的超级计算机,我们很可能会在LLMS中看到类似的演变。

结论

模型大小很重要,但更大并不总是更好。相反,选择适合您特定需求的合适的LLM型号大小是关键。随着这些系统继续升级和集成到我们的日常生活中,了解LLM模型大小的人类含义变得越来越重要。

最成功的实现通常使用多种模型大小共同努力,例如一个结构良好的组织,具有有效的专家和通才。通过将模型大小与适当用例匹配,我们可以创建强大且实用的AI系统,而不会浪费资源。

关键要点

- LLM模型大小会影响准确性,效率和成本,因此为特定用例选择合适的模型至关重要。

- 较小的LLM模型尺寸更快,资源效率高,而较大的型号具有更大的深度和推理能力。

- 选择正确的型号大小取决于用例,预算和硬件约束。

- 量化和蒸馏等优化技术可以提高模型效率。

- 使用多种模型尺寸的混合方法可以有效地平衡性能并有效地平衡。

常见问题

Q1。 LLM大小对性能有什么影响?答:大语言模型(LLM)的大小直接影响其准确性,推理能力和计算要求。较大的模型通常在复杂的推理和细微差别的语言任务中表现更好,但需要更多的资源。较小的型号虽然功能较低,但却以速度和效率优化,使其非常适合实时应用。

Q2。大小的LLM在用例方面有何不同?答:小型LLM非常适合需要快速响应的应用程序,例如聊天机器人,实时助理和具有有限处理能力的移动应用程序。另一方面,大型LLM在复杂的解决问题,创意写作和研究应用程序中表现出色,这些应用需要更深入的背景理解和高度准确性。

Q3。选择LLM尺寸时应考虑哪些因素?答:LLM大小的选择取决于多种因素,包括任务的复杂性,延迟要求,可用的计算资源和成本限制。对于企业应用程序,性能和效率之间的平衡至关重要,而研究驱动的应用程序可以优先考虑准确性而不是速度。

Q4。大型LLM可以优化以提高效率吗?答:是的,可以通过量化(将精度降低到较低的位格式),修剪(去除冗余参数)和知识蒸馏(训练较小的模型以模仿较大的模型)等技术来优化大型LLM。这些优化有助于减少记忆消耗和推理时间,而不会显着损害性能。

以上是LLM模型大小的人体方面的详细内容。更多信息请关注PHP中文网其他相关文章!

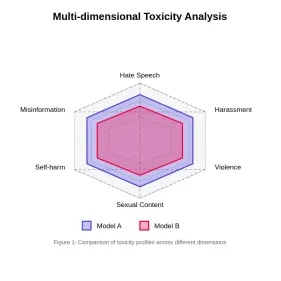

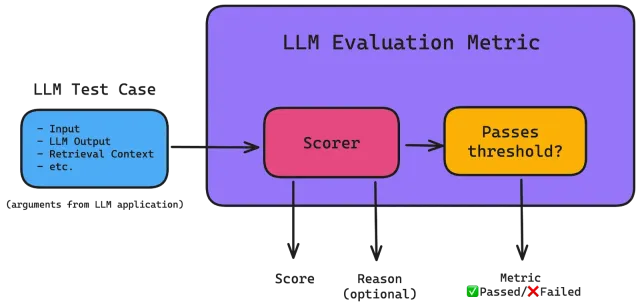

评估大语模型中的毒性Apr 24, 2025 am 10:14 AM

评估大语模型中的毒性Apr 24, 2025 am 10:14 AM本文探讨了大语言模型(LLM)中的毒性至关重要问题以及用于评估和减轻它的方法。 LLM,为从聊天机器人到内容生成的各种应用程序提供动力,需要强大的评估指标,机智

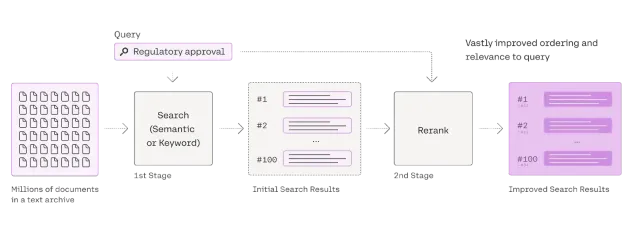

Rag Reranker的综合指南Apr 24, 2025 am 10:10 AM

Rag Reranker的综合指南Apr 24, 2025 am 10:10 AM检索增强发电(RAG)系统正在改变信息访问,但其有效性取决于检索到的数据的质量。 这是重读者变得至关重要的地方 - 充当搜索结果的质量过滤器,以确保仅确保

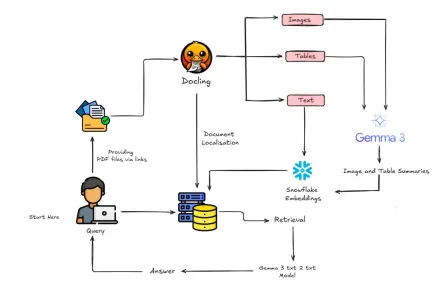

如何使用Gemma 3&Docling构建多模式抹布?Apr 24, 2025 am 10:04 AM

如何使用Gemma 3&Docling构建多模式抹布?Apr 24, 2025 am 10:04 AM该教程通过在Google Colab中构建精致的多式联运检索一代(RAG)管道来指导您。 我们将使用Gemma 3(用于语言和视觉),文档(文档转换),Langchain等尖端工具

可扩展AI和机器学习应用的射线指南Apr 24, 2025 am 10:01 AM

可扩展AI和机器学习应用的射线指南Apr 24, 2025 am 10:01 AM雷:扩展AI和Python应用程序的有力框架 Ray是一个革命性的开源框架,旨在轻松扩展AI和Python应用程序。 它的直观API使研究人员和开发人员可以通过其代码过渡

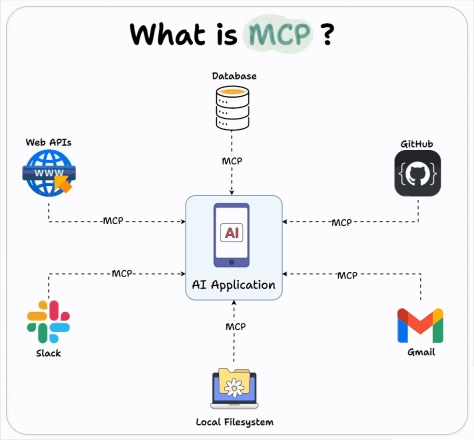

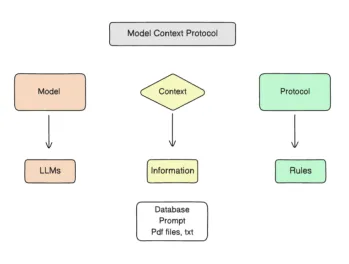

如何将OpenAI MCP集成用于建筑代理?Apr 24, 2025 am 09:58 AM

如何将OpenAI MCP集成用于建筑代理?Apr 24, 2025 am 09:58 AMOpenAI通过支持人类的模型上下文协议(MCP)来涵盖互操作性,这是一种开源标准,简化了与不同数据系统的AI助手集成。这项合作为AI应用程序奠定了一个统一的框架

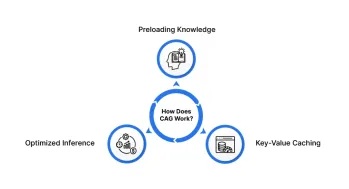

cache aigned Generation(CAG):它比抹布好吗?Apr 24, 2025 am 09:54 AM

cache aigned Generation(CAG):它比抹布好吗?Apr 24, 2025 am 09:54 AM缓存增强生成(CAG):一种更快,更有效的替代品 检索演出的一代(RAG)通过动态融合外部知识彻底改变了AI。但是,它对外部资源的依赖引入了潜伏期和

胭脂:解码机器生成的文本的质量Apr 24, 2025 am 09:49 AM

胭脂:解码机器生成的文本的质量Apr 24, 2025 am 09:49 AM评估大型语言模型:深入研究胭脂指标 想象一个能够撰写诗歌,起草法律文件或总结复杂研究的AI。 我们如何客观地评估其表现? 作为大型语言模型(LLMS)Inc

如何使用MCP:模型上下文协议-Analytics VidhyaApr 24, 2025 am 09:48 AM

如何使用MCP:模型上下文协议-Analytics VidhyaApr 24, 2025 am 09:48 AM使用模型上下文协议(MCP)为您的AI助手解锁现实世界数据的功能! 您可能已经使用LLM构建了应用程序,对代理进行了实验,甚至使用Langchain,Autogen或OpenAI的助手API。 令人印象深刻的a

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3汉化版

中文版,非常好用

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

SublimeText3 Linux新版

SublimeText3 Linux最新版

WebStorm Mac版

好用的JavaScript开发工具

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),