4M令牌? Minimax-Text-01优于DeepSeek V3

- Lisa Kudrow原创

- 2025-03-10 10:00:17923浏览

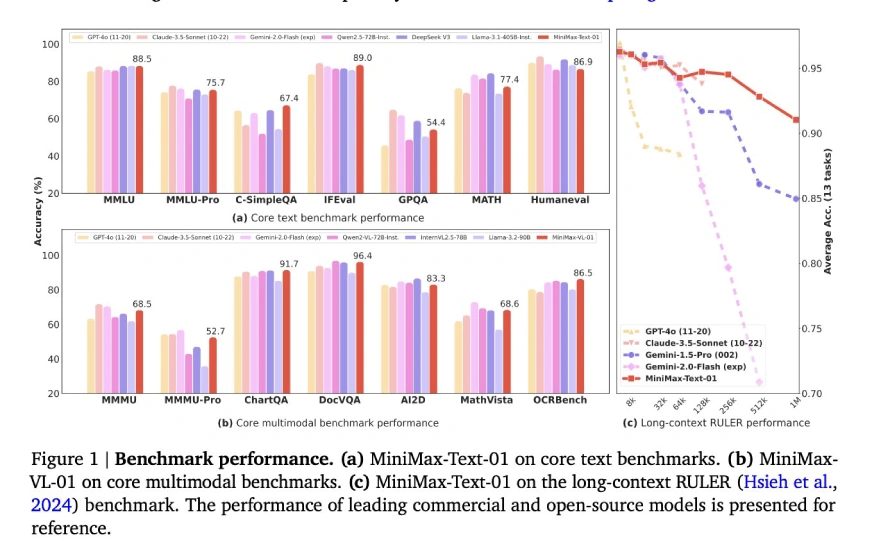

中国人工智能正在取得很大的进步,具有挑战性的领先模型,例如GPT-4,Claude和Grok,具有具有成本效益的开源替代方案,例如DeepSeek-V3和Qwen 2.5。 这些模型由于其效率,可及性和强大的性能而出色。 许多人在允许的商业许可下运营,扩大对开发商和企业的吸引力。 该组的最新成员Minimax-Text-01以其前所未有的400万令牌上下文长度设置了一个新标准,该标准的长度超过了典型的128K-256K令牌限制。这种扩展的上下文能力,结合了效率的混合注意体系结构和开源,商业允许的许可,促进了创新而无需高昂的成本。

>

>让我们深入研究minimax-text-01的功能:>

>混合体系结构

Experts(MOE)策略的混合物训练和缩放策略

- >训练后优化

- 关键创新

- 核心学术基准

- 一般任务基准

- 推理任务基准

- 数学和编码任务基准

- >开始使用minimax-text-01

- 重要链接

- >混合体系结构

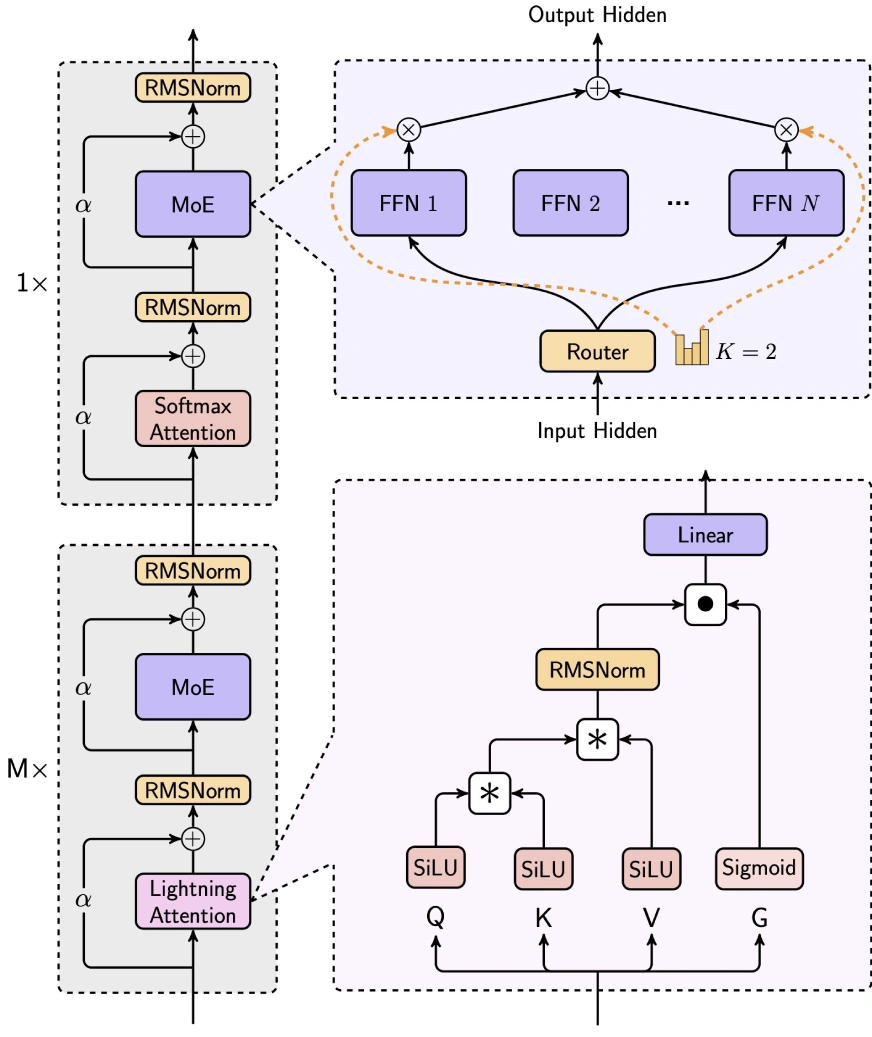

- > minimax-text-01通过整合闪电的注意力,软效果的注意力和杂物(MOE)来巧妙地平衡效率和性能。

- >

7/8线性注意力(Lightning Coative-2):

1/8 softmax的注意:

1/8 softmax的注意:

- > minimax-text-01的独特MOE架构将其与诸如DeepSeek-V3:之类的模型区分开

-

-

与DeepSeek的无滴方法不同,

- 使用辅助损失来维持跨专家的平衡令牌分配。

- >全局路由器:优化令牌分配,以在专家组之间进行工作负载分配。

- top-k路由:>选择每个令牌的top-2专家(与DeepSeek的Top-8 1共享专家相比)。 专家配置:

- 使用32位专家(与DeepSeek的256 1共享),专家隐藏的维度为9216(vs. DeepSeek的2048)。 每层的总激活参数与DeepSeek(18,432)相同。 训练和缩放策略

培训基础设施:- 使用了大约2000 h100 gpus,采用了高级并行性技术,例如专家张量并行性(ETP)和线性注意序列序列并行性和平行性(LASP)。 针对8位量化进行了优化,以在8x80GB H100节点上有效推断。

- 培训数据:使用WSD样学习率计划进行了大约12万亿代币培训。 该数据包括高质量和低质量来源的混合物,以及全局重复数据删除和4倍重复的高质量数据。

- >长篇下说训练:一种三个基础的方法:阶段1(128K上下文),第2阶段(512k上下文)和第3阶段(1M上下文),使用线性插值来管理上下文长度缩放期间的分布变化。 >

- > >训练后优化

使用脱机DPO和在线grpo进行对齐的监督微调(SFT)和强化学习(RL)的周期。 - >

- 长篇小说微调: 一个分阶段的方法:短篇小写SFT→长篇小写SFT→短篇小写→短上下文rl→长上下文RL,对于上下文的长篇小说性能至关重要。

- 关键创新

deepnorm:

>- 一种后构体结构增强了剩余连接缩放和训练稳定性。

- 批次尺寸热身: 逐渐将批次尺寸从16m增加到128m令牌,以进行最佳训练动力学。

- 有效的并行性: 利用环的注意来最大程度地减少长序列和填充优化的内存开销,以减少浪费的计算。

- 核心学术基准

(此处包括用于一般任务,推理任务和数学和编码任务的基准结果的表,此处包括原始输入表。)

(其他评估参数链接保留)

>开始使用minimax-text-01

(用于使用拥抱脸部变压器的minimax-text-01的代码示例保持不变。) 重要链接

聊天机器人- 在线API

- 文档

- 结论

> minimax-Text-01表现出令人印象深刻的功能,在长期和通用任务中实现了最先进的表现。尽管存在改进领域,但其开源性质,成本效益和创新的建筑使其成为AI领域的重要参与者。 它特别适用于记忆密集型和复杂的推理应用,尽管编码任务的进一步完善可能是有益的。

以上是4M令牌? Minimax-Text-01优于DeepSeek V3的详细内容。更多信息请关注PHP中文网其他相关文章!

声明:

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系admin@php.cn